責任あるAIにむけて、ワークショップの取り組み

著者:Eva Le Ray, Responsible AI researcher at Corpy&Co., Inc.(翻訳:斎藤明日美, AI Fairness Lead at Corpy&Co., Inc.)

はじめに

技術革新の時代において、AI企業の責任は単なる技術革新や効率化にとどまりません。Corpy&Co.では、AIが社会に与える影響を認識し、前向きな未来を確実にするために、倫理的な配慮のもとAIを利用していくことを目指しています。

先日のブログ(日本語・英語)では、XAI4Fairnessチームは、プロジェクト全体で責任あるAIの実践を実施するための倫理的なコンパスの役割を果たすことを紹介しました。

エンジニアのAI倫理に関する包括的な理解なしに、私たちがリーチを広げ、仕事の効果を出すことはできません。Anacondaの「2020 State of Data Science Survey」によると、データサイエンス専攻の学生のうち、AI倫理について学んでいるのはわずか18%でした。アカデミックなカリキュラムにこのトピックが含まれていないことが多いため、倫理的な課題は置き去りとなります。加えて、エンジニアは自分たちの仕事に関連する倫理的な課題に適切に対処する能力を備えていないことが多いのです。

この倫理的な認識を補い、プロジェクト・メンバーの意識を高めるべく、私たちは責任あるAIに関するワークショップを開催しました。

ワークショップについて

弊社のエンジニアメンバーに対しての目的は、責任あるAIとはなにか、なにが含まれるのかをしっかりと理解してもらうことでした。プロジェクトライフサイクルを通じて意思決定に倫理的配慮が伴うよう、チームメンバーの思考プロセスに使える知識を与えることに焦点をあてました。

フェアネスチーム側では、このワークショップは、エンジニアリングチームと関わるだけでなく、責任あるAIの実践に関する社内の具体的なニーズや要件を評価する貴重な機会となりました。

ワークショップはふたつのセッションに分かれ、二週にわたって開催されました。各セッションでは、責任あるAIの基本原則について詳しく解説し、理解してもらうこと、そしてチームメンバーが自分たちのプロジェクトの幅広い影響について批判的に分析するよう議論を設計しました。セッションは、Figure 1に示すように、倫理的な議論、業界のケーススタディの批判的分析、現在のプロジェクトニーズの評価、架空のシナリオのリスク評価など、講義と実践的なアクティビティを組み合わせました。

責任あるAIの最先端

ここで、私たちの方法論を明確にし、同分野の他企業の方が同様のアプローチをとれるよう、責任あるAIの現状を振り返りましょう。

先のブログ記事でも触れたように、IT業界はAIの倫理的側面に関心を持ち始めています。2023年3月、MITの研究者らによって設立されたFuture of Life Instituteが発表した公開書簡では、すべてのAI研究所に対し、GPT-4よりも強力なAIシステムの訓練を少なくとも6ヶ月間は一時的に停止し、代わりにAIガバナンスと責任あるAIの研究開発に注力するよう促しています。また、倫理的なAIに関する言説が重要性を増すにつれ、良心的で持続可能なAIの研究を積極的に取り入れる企業も増えています。

業界の辿ってきた道を考えると、効果的なワークショップの開催には、急速に進化する「責任あるAI」を把握する必要がありました。最新の進歩や洞察に後れを取らないために、私たちはハーバード大学バークマン・クライン・センター・フォー・インターネット&ソサエティの論文「Principled Artificial Intelligence: Mapping Consensus in Ethical and Rights-based Approaches to Principles for AI」(2020)からインスピレーションを得ました。この論文は、2016年から2019年の間に発表された36の著名なAI原則文書を調査したもので、学術界と産業界の両方からの貢献を含む、多様な世界的分野から発信されたものです。この論文では、以下のように重要な要素を8つの原則に分類しています:

プライバシー:個人データとプライバシーの権利の保護を優先する。

説明責任: AIシステムの成果に対する透明性と責任の確保。

安全性とセキュリティ:AI技術の安全・安心な開発・展開のための基準を支持する。

透明性と説明可能性:明確で理解しやすいAIの意思決定を目指す。

公平性と無差別性:偏見を緩和し、多様なユーザーグループ間での公平な扱いを確保する。

人間によるテクノロジーのコントロール:「ヒューマン・イン・ザ・ループ」の維持を保証する。

専門家としての責任: AI開発における倫理的行動の育成。

人間的価値の促進: 基本的人権や価値観とAIの整合性の確保。

ワークショップのセッションでは、それぞれの原則を注意深く分析、定義、そして説明し、業界の失敗例と成功例の実例を紹介しました。また、最後に下記に示すようなオープンエンドのディスカッションを行いました。

自律型兵器の開発についてどう考えるか?

特定のプロジェクトの文脈において、どの原則が最も重要か?

リスクを軽減するための最も効果的な戦略は?

結果として、チームメンバーは、倫理的配慮には微妙なニュアンスがあり、一筋縄ではいかないものであることに気づいたようでした。例えば、私たちがディスカッションで得た回答の中には、会社の価値観や誠実さを優先するメンバーもいれば、個人的なモラルに沿うことを選ぶメンバーもいました。そのような議論を見届け、私たちフェアネスチームは、このような倫理的考慮事項をさらに深く掘り下げていこうという熱意を高めることとなりました。

成功と成果

セッションは成功したように感じます。

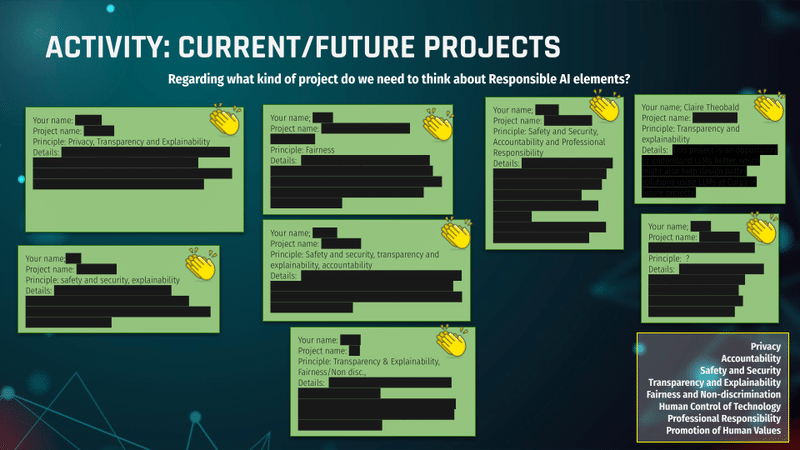

エンジニアチームのメンバーからは、講義やディスカッションに対してポジティブな反応がありました。2回目のセッションでは1回目のセッションから彼らの自信が増していったのがわかりました。メンバーからは、今後のプロジェクトで倫理的な側面をより考慮して取り組みたいという熱意が感じられました。(Figrure 2)

フェアネスチームの側では、エンジニアリングメンバーとの関わりは、知識のギャップや誤解を的確に指摘する上で非常に有益でした。科学者と社会科学者がチームを組み、互いの視点がどれだけ一致するかを探るのは、日常的なことではありません。エンジニアがより実践的な視点を持つのに対し、私たちのチームはより抽象的な視点を持っていることがわかりました。これは、責任あるAIの開発のためにより実践的な施策を模索することを後押しする発見でした。同様に、社内のニーズに関する貴重なデータを収集したことにより、責任あるAIの実践のための改善戦略を実施するための土台を得ることができました。

今回の成果を踏まえ、今後も定期的にワークショップ開催していく予定です。この初回セッションで集めた貴重なご意見を参考にしながら、将来、チームをまとめるエンジニアを育成するためのトレーニングに磨きをかけていきたいと考えています。

**カバーイラストはAIによって生成され、弊社により編集したものです。

この記事が気に入ったらサポートをしてみませんか?