「SIGGRAPH 2019 in ラスベガス」の出展ブースレポート

本記事は2019年8月4日に投稿されたものです

こんにちは、株式会社アタリのR&D部門の河内です。

今回、2019年7月28日〜8月1日にロサンゼルスで開催されたSIGGRAPH 2019に参加してきました。今回の記事の中ではExperience Hallや企業展示の中で気になった製品/技術/展示について、私の個人的観点で紹介していきたいと思います。

VR空間内で手を自由自在に動かせる「capskin glove」

Experience Hall内で、Device型のHand Tracking Deviceの「Capskin Glove」が展示されていました。

また、Technical Paperとしても発表されているものです。Device型のHand Tracking DeviceとしてはManusVR(https://manus-vr.com/)がすでに製品として存在していますが、このcapeskin gloveは特殊なBend SensorとDeep Learning技術によって、より手のより細かい動きを再現可能にしています。

要するにややこしい手の動きとかも全部再現しちゃいますよってデバイスです。Calibration自体も手を閉じる、大きく開くという行為を実施するだけで容易に可能。また柔らかく、制作費用が$15という低価格であるということを売りにしています。まだResearchの段階であり、製品化に時間は掛かりそうとのことでした。

実際に体験してみたところ、自由自在にVR空間内で動かしている感覚には残念ながらなれませんでした。開発者曰く「Oh! 手が小さいから、上手く動くか分からない。」と言われました。

日本人としては特別手が小さいわけではないのですが・・・(涙)。精度やLatency(遅延)もまだ向上させていくとのことです。VR空間内で簡単な手の動きだけでなく、細かい精度の高い体験をできる日もそう遠くないのかもしれません。

AR(拡張現実)をStyle Transfer(Deep Learning)でスタイル拡張!

Experience Hall内で展示されていたNeural ARです。Deep LearningのStyle Transferは既に古典になってきていますが、実際に応用として利用するとなるとハードルが高いことも事実です。

このNeural ARでは、リアルタイムでAR内にStyle Transferをさせた映像を表示することを実現しています。日本企業の株式会社アカツキの社員さんが作成したそうです。Googleのスマホ端末Pixelのカメラ画像を、背負えるPCに送信し、Style Transferで画像処理した上で、Pixel端末に戻しAR表示するということを実現しているそうです。

この技術を利用したゾンビシューティングゲームを体験させてもらいましたが、面白かったところはCGのゾンビとリアルな人間がStyle Transferをかけることで見分けが付きにくくなり、よりARというかMixed Realityが実現されているという体験ができたことです。

RealとVirtualの中間空間の表現としても、新しさを作り出していると感じました。

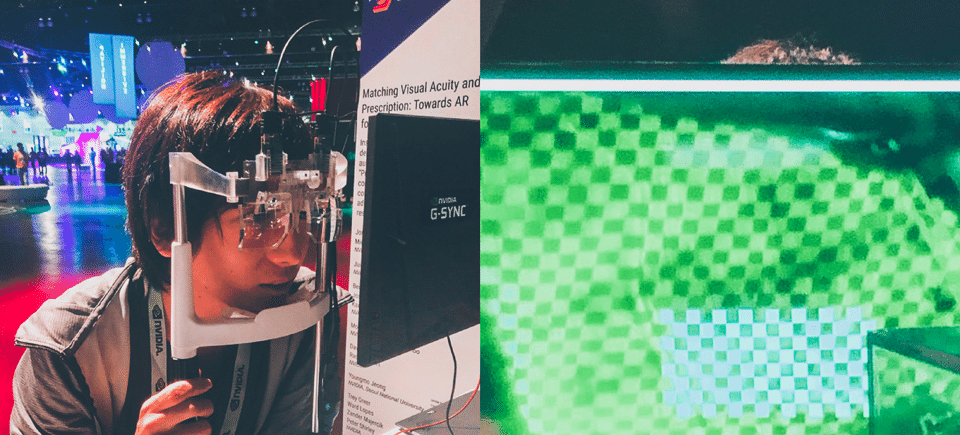

NVIDIA AR Glass

Experience Hall内でNVIDAのAR Glassのプロトタイプが展示されていたため、体験してきました。VRの分野では盛んに研究がされているフォービエイテッド・レンダリング(Foveated Rendering:目の中心視野ほど解像度が高くなる技術)のAR Glassでの応用を実現しています。

画像内のくっきり見える中心の緑が中心視野の高解像度画像、周りのボヤけた緑の画像が低解像度画像です。

実際に目を動かすと中心の緑の部分が追従して動いていくこと体験をすることができました。今はまだ遅延などが気になりました。気軽なAR端末は現在Smart Phoneのみなので、今後開発が進めばより気軽にARを実現体験できる端末の一つとして期待できるのではないでしょうか。

https://research.nvidia.com/publication/2019-07_Foveated-AR%3A-Dynamically-Foveated

SIGGRAPHのセッションを一括して閲覧可能なGEEK BAR

展示ではないのですが、SIGGRAPHのセッションを一括して視聴可能なGEEK BARをご紹介したいと思います。

SIGGRAPHでは一応学会ということもあり、非常に重要な多数のセッションが同時多発的に開催されています。

聞きたいセッションはあるが、部屋を移動している間に重要な部分を聞き逃す場合や全てのセッションの重要な部分をリアルタイムに切り替えて観たい場合があると思います。

そこでこのGEEK BAR。非常に大きなDISPLAYにその時々に実施されているセッションを最大8個リアルタイムで視聴ができるシステム、音声はヘッドホンが配られ、チャンネルを変えることで切り替えることが可能になっています。とても便利な仕組みだなと。さらに椅子もふかふかのクッションが用意されており、だんだん眠くなる人もいたりいなかったり。

日本のカンファレンスなどでも積極的に採用してほしいシステムですね。

Magic Leapで体験するMICA(Realistic 3D Human)

Experience HallでMRデバイス「Magic Leap」を利用したコンテンツが数点展示されており、その中の一つであるVirtual 3D Human Model – MICAとコミュニケーションするコンテンツを体験してきました。

ジェスチャーでコミュニケーションを行い、物を掴み壁に設置して絵を完成させるというコンテンツです。ジェスチャーでのコミュニケーション自体は、うん、そうですねっていう感じなのですが、投影する人物はデフォルメアバターやアニメが多い中、MICAちゃんはフォトリアルな3D Modelという点が非常にユニークです。画像はMRデバイスの映像ではなく、別カメラ視点をモニターに映しているものですが、この画像とほとんど遜色がない状態でMRデバイス越でも見えています。

よりデバイスの性能が上がりRendering品質を向上させることができれば、現実世界に理想の架空の人物を作り出す・・・なんてことも夢じゃないかもしれませんね。

NVIDIA RTX リアルタイムレンダリングでムーンウォーク

NVIDIAの企業ブース。RTXシリーズをリリースしたこともあり、その性能を披露するためにリアルタイムレンダリング、ディープラーニングの展示が多くありました。その中で一際大きく気合いを入れて展示されていた(と私が感じた)のがムーンウォーク。

実物大のロケットの模型を用意し、その中に人が入るとDeep LearningによるBody(Bone)検知を行い、宇宙飛行士の3D Modelに動きを反映させてリアルタイムレンダリングを行うというもの。動きがたまに不自然なこともありますが、楽しそうで何よりです(^^)

他にも様々なCG Toolをリアルタイムで表示する展示。NVIDIA Researchの研究成果であるGauGANというペイントからリアルタイムにフォトリアルな写真を生成するツールも展示されていました。これはWebからでも実際に体験できるようにサイトも用意されていますね。

Force Feedback Glove – Dexmo

企業ブースで展示されていたDexta Robotics社のForce Feedback Glove “Dexmo”を体験してきました。Dexmoはユーザーが仮想世界において、手を使いインタラクションした物体から手に返ってくる反動、いわゆる触覚感覚(ハプティクス)をフィードバックするグローブ型デバイスです。

なかなか強い力で反動が返ってくるため、実際に物を掴む触れる体験をすることができます。温度、質感や重量などは再現することはできないため、実際の銃や剣型デバイスに比べるとリアリティは劣ります。

ただし、仮想世界の中で様々なオブジェクトを持つことや、ドアを開けるスイッチを押すなどの様々な行為を行う場合には、こういったグローブ型デバイスで強い反動が返ってくるものは汎用的に利用する価値が高いかもと思えます。

https://www.dextarobotics.com/en-us

以上で今回の紹介は終わりとなります。

総括として、面白い製品や技術がでてきているので、単純に色々組み合わせて面白いものがつくれますね。

Hand Tracking型デバイスを付けながら、Magic Leapでムーンウォークしている光景をGeekなBarで8スクリーン生中継、さらにStyle Stransferそれぞれの画面のReal Time変換をするだけで世界一面白い光景がつくれるかもしれません。