まなざし拡張企業のCEOからみたApple Vision Proの3つの革新

こんにちは!空間コンピューティング技術で人々のまなざしを拡張するMESONの小林です。

今年の6月にアメリカでAppleが開催したWWDC2023にて、新しい空間コンピューター「Apple Vision Pro」が発表されました。

当日、WWDC2023の現地ではTim Cook氏が「One More Thing…」と口にした瞬間にオーディエンスから大きな歓声が上がったことをいまでも覚えています。

その後、自分はWWDCの現地にてApple Vision Proの実機を体験する機会に恵まれ、この新たな空間コンピューターから、人類の次のコンピューティングパラダイムシフトが起こると確信しました。

今回は約7年前にMESONというスタートアップを創業し、空間コンピューティング技術を使い、様々な体験をチームでつくってきた自分の視点からApple Vision Proのどういう点が革新的であり、なぜ自分がVision Proによってここから新たなコンピューティングパラダイムシフトが起こると確信したか紹介します。

なぜこのタイミングでこのnoteを出したのか?

6月にWWDC2023が開催され、Vision Proが発表されたので、2ヶ月ほど時間が経っていることになります。

本題に入る前に、今回なぜこのタイミングでこのnoteを公開したのか触れたいと思います。

1つは2ヶ月の間、Vision Proをテーマにした様々なイベントに登壇させていただき、その中で話したことの総集編としてこのnoteを公開したいと考えたからです。

そしてもう1つはVision Proの実機を日本でも体験できる「Developer Lab」の開催が近づいているからです。

このDeveloper LabはAppleのオフィスに赴き、実機のVision Proに自身が開発したアプリやプロトタイプをインストールして、アプリのテストを行うことができるプログラムです。

世界で6箇所で開設されることがで決定しており、東京が今回その1つに選ばれているのです。

Developer Lab参加の応募はすでに開始されており、8月の決められた日付で申し込みをすることができます。

ここから日本でもDeveloper LabでVision Proの実機を体験できる機会がどんどん増えてきます。

Vision Proを実機で体験できる方々が、Vision Proのどういう点に着目するとよりVision Proの魅力や凄さを体感できるのかをご紹介するために今回このnoteを執筆することにしました。

ぜひ8月のDeveloper LabでVision Proを体験する予定の方も、まだ予定はないけどこれからVision Proを体験してみたいと思っている方も、このnoteを参考にしてもらえればと思います。

1. バーチャルコンテンツの違和感のない存在感

まず1つ目の革新は空間コンピューティング技術によって表示されるバーチャルコンテンツが現実空間に違和感のなく存在していることです。

Vision Proはこれまで培ってきた様々なAppleの技術を集積させ、違和感なく現実空間にバーチャルコンテンツに表示することを実現しています。以下ではどのようにしてリアルとバーチャルを融合しているか、視覚的なアプローチと聴覚的なアプローチの双方から詳しく説明します。

視覚的なアプローチ

Vision Proのような頭に被って現実空間にバーチャルコンテンツを重ねて表示する方式として、現在は「光学シースルー」と「ビデオシースルー」の2つの方式があります。

ここではこの2つの方式の違いなどの細かい説明は省きますが、詳しく知りたい方は以下のスライドなどをご覧ください。(スライド中では光学シースルーは「光学式ARグラス」として紹介されています)

スライドにも掲載の通り、Vision Proはビデオシースルー方式を使っていますが、このビデオシースルー方式を採用してきたこれまでのデバイスでは、現実空間が歪んでみえてしまうという問題がありました。

ビデオシースルーを採用したデバイスとして、Meta社が出しているMeta Quest Proというデバイスがあります。このデバイスを通して見たときの映像が以下のYoutubeからみることができます。

動画を見ていただくと視界の端が歪んでいたり、撮影者が手を動かすとその付近が歪んでいたり、少し手のトラッキングが遅延している様子が見えると思います。

このように現状PCなどに接続せずに端末単体で動くビデオシースルーデバイスは現実世界を見ることはできても、歪んでいたり遅延があって「現実世界を見ている」感じがしないという課題がありました。

しかし、Vision Proを通した景色は、歪みのほぼない現実世界でした。

こういった頭に装着するデバイスをあまり体験したことがない方々には少し変な話に聞こえるかもしれませんが、「みえている風景に違和感がない」ことにVision Proの凄さがあります。

自分がVision Proを実機で体験した際、初期設定を終えて一番最初に現実世界を見たときに、机の上に「hello」の文字が浮かぶ上がるシーンがありました。自分はその時に現実世界が本当にそのまま見える、その事実がいまでも一番印象に残っています。

ビデオシースルー方式でこの歪みのなさを実現することで、現実空間を見ていてもユーザーにストレスがかかることがなく、Vision Proを日常的にかけることができるようになります。

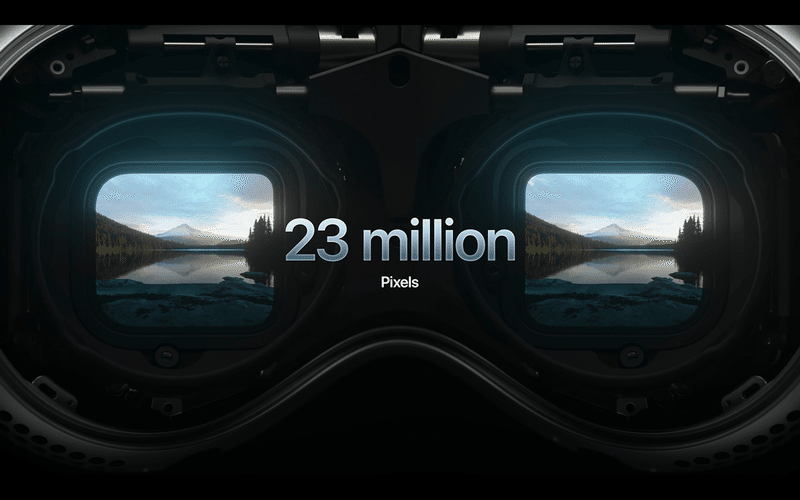

そして、そんな歪みの無い現実空間の中に、Vision Pro はとても解像度の高いバーチャルコンテンツを表示させることができます。

この高解像度は、Vision Pro のディスプレイに採用されたMicro OLEDによって実現されています。

このMicro OLEDはSony製のものと言われており、片目4K、両目8Kの解像度を実現しています。Vision Pro 上でSafariなどを開くとWebページの文字などもしっかり読むことができます。

更に解像度だけではなく、バーチャルコンテンツと現実空間との接点にも様々な工夫を施すことで違和感をなくす工夫をしています。

その一つがバーチャルコンテンツが空間に表示された際に現実空間に落ちる影です。

とても細かい仕掛けに感じるかも知れないですが、この影があるのとないのとでは「そこに "ある"」と感じるかどうかに大きな差が生まれます。

この仕掛けがAppleが実現可能なのは、これまでAppleがARKitというスマホ向けのAR開発ツールをリリースし、技術を蓄積してきたからです。

このようにVision Pro では視覚的なアプローチで違和感のないバーチャルとリアルの融合を実現しており、そのレベルは日常使いするに値するクオリティに達しています。

聴覚的なアプローチ

Vision ProにはSpatial Audio機能が搭載されており、バーチャルコンテンツから発せられる音声が空間的に聞こえてきます。

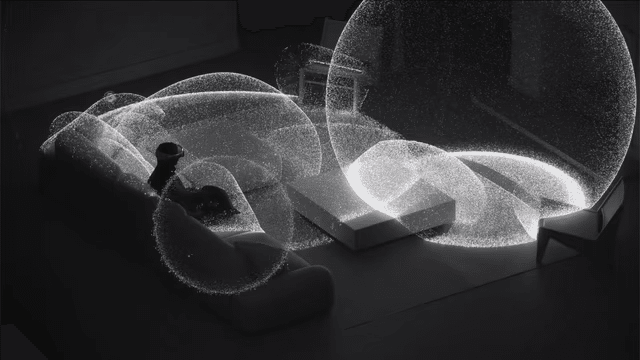

このSpatial Audioは方向だけではなく、Vision Proが空間の形状などを認識し、反響などをシミュレーションすることでより没入体験のある音環境をつくっています。

この機能により、Vision Proを装着したユーザーは聴覚的にも「そこに "ある" 」という感覚を持つことができます。

実際に自分がVision Proを実機で体験した際に、とある有名なアーティストのライブ映像を見る体験でメインボーカルとサブボーカルが目の前にいたのですが、それぞれの方向からしっかりとそれぞれの歌声が聞こえてきていることを感じました。

このSpatial Audio技術は精度をできるだけ高めるために、専用の設定アプリで自身の耳の形を写真で撮り、個別でSpatial Audioの設定をカスタマイズしており、更にその精度を高めています。

このSpatial Audioは実は今回いきなり採用されたものではなく、元々AppleのAirpods Proでも採用されている技術で、ここでもAppleのこれまで培った技術がVision Proに活かされています。

このようにAppleは視覚と聴覚のアプローチの両方からリアルとバーチャルの違和感のない融合を突き詰めており、そのレベルはこれまでのどのデバイスとも一線を画していると感じます。

2. 没入体験を阻害しない体験フロー

次に自分が挙げたいのが、AppleがVision Pro内にデザインした没入体験を阻害しない体験フローです。

これまで世の中に出ていたデバイスは、ユーザーがデバイスを装着してから、体験したい没入体験に到達するまでのプロセスがとても長いものがほとんどでした。

「目と目の距離を設定しましょう」「移動できる範囲を決めましょう」「アプリとの連携をしましょう」 etc…

しかしVision Pro ではこの没入体験にたどり着くまでのプロセスができるだけ短くなっており、かつプロセスそのものもストレスが少ないようにデザインされています。

Vision Pro のような頭に被って使うデバイスは目と目の距離(IPDと呼びます)を個人ごとに調整することによって没入体験をより質の高いものにすることができます。

通常はIPDがいくつかのレベルに分かれていてそこから最適なものを選択したり、自身でIPDを測定して手動で調整するものが多いですが、Vision Pro は「デジタルクラウン」と呼ばれるつまみを長押しすると自動、かつ一瞬でIPDが調整されます。

またVision Pro は目の動きを使って操作をするため、個々人の目の形状をきちんと測定することが重要になります。

通常であればチュートリアルのような動画が表示され、目をスキャンするようなフローになることが多いです。

しかし、Vision Pro では、眼の前に6つの黒点が表示され、その黒点の上を色の付いた点が動くのを目で追いかけます。点の動きがとてもなめらかで、かつ気持ちの良い効果音であるため、まるで瞑想アプリを体験しているかのような気持ちのよい体験になっています。

以下にその様子をKeynoteのアニメーションで再現してみました。

このようにユーザーがVision Pro を購入してから実際に使い始めるまでのプロセスもかなりデザインされています。

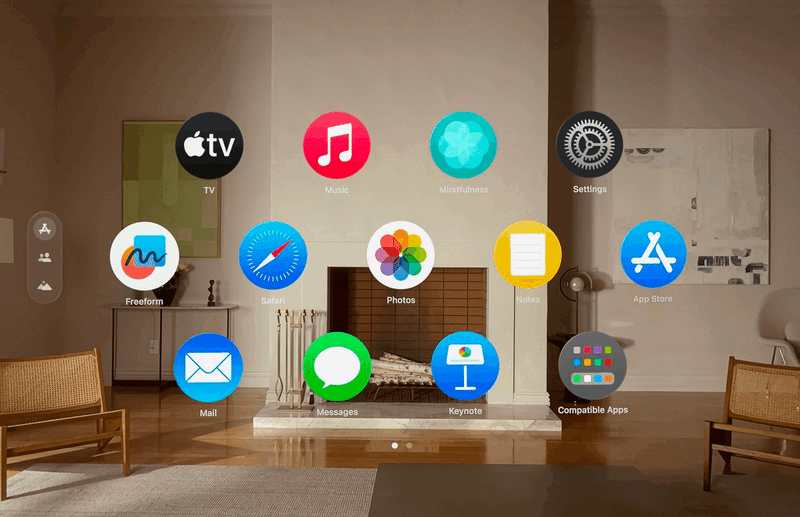

そして日常使いする上でも装着してから没入体験に到達するまでの距離がかなり短くなるように設計されています。

装着してからデジタルクラウンをポチッと押すだけでアプリ一覧を開くことができます。

またVision Pro にログインする方法は人の目の虹彩を使ったOptical ID技術を採用しています。

そのため数字でパスワードを入れ込むなどをしなくても装着するだけで自分のVision Pro を起動させることができます。

このようにユーザーがVision Pro を装着してから没入体験にたどり着くまでのプロセスを最短、かつユーザー負荷が少ない形にデザインされています。

日常使いを想定したデバイスが起動の度にセットアップが大変ではユーザーが離れてしまいます。

没入体験までのプロセスが日常生活を想定してデザインされているからこそ、何気ない毎日の中で当たり前のように使うことをイメージすることができました。

3. ユーザーの負荷が圧倒的に少ない操作性

そして最後に挙げるのが、ユーザーの負荷が圧倒的に少ない操作性です。

Vision Pro はユーザー自身の目と手の動きを組み合わせて操作する「Look & Pinch」をメインの操作方法にしています。

ユーザーが操作したい対象に視線を向け、操作を指をつまんだり離したりして行います。

このLook & Pinch、いままで他のデバイスでは採用されてこなかった手法ですが、体験してみるとこの操作方法が如何に快適かが実感できます。

これまで他のデバイスでは「目だけの操作」、もしくは「手だけの操作」のどちらかが採用されたことは多々ありました。しかしそれぞれには長所もあると同時に短所もありました。

目だけの操作は操作対象を選択するのはとても早く簡単な一方で、決定することが難しい。瞬きなどで決定を行うデバイスもありますが、瞬きは人が頻繁に行う生理現象なので自分が決定をしたくないタイミングでも行ってしまうことがあります。「瞬きしないようにしよう」と意識してしまうと更にユーザーがストレスを感じてしまいます。

一方で手だけの操作は決定などは実行しやすい一方で、操作を長時間続けると疲労感が溜まりやすくなります。手でなにかを選択しようとするとその方向まで手を動かさなくてはならない。更にデバイスに自身の手を認識してもらうために腕を顔の前まで上げて操作をし続ける必要があります。業界的には「ゴリラ腕」と言われる状態になり、ユーザーが腕に疲労を感じてしまう状態になります。

そこでVision Pro では「Look & Pinch」を採用することで、目と手の操作の良いところ取りを実現しています。

自分が操作したい対象は視線を向けるだけですぐに選択でき、決定などは手を動かすことによって実行することができます。

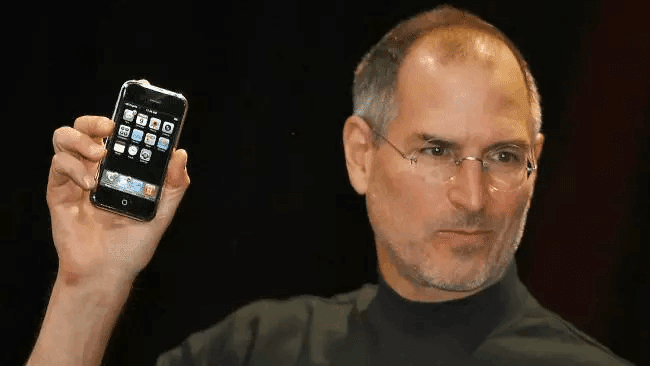

自分はこのLook & Pinchの操作を体験した際に、Appleが「ユーザー自身の指でスクリーンをタッチして操作する」というスマートフォン操作のデファクトスタンダードを作ったことを思い出しました。

今回のLook & Pinchは今後空間コンピューター操作のデファクトスタンダードになっていくと考えています。

またAppleは自前のハードウェア技術を駆使して、更にユーザー負荷軽減を実現しています。

それがVision Proの下部分についている「Downward Cameras」というものです。

このカメラはデバイスの真下を向いているため、ユーザーが手を持ち上げなくても、自然体のまま手を使った操作を行うことが可能です。

Vision ProにはこのDownward Camerasを含めた12台のカメラが接続されています。市場に出ているチップではこの台数のカメラを接続することが難しかったのですが、Appleは自前で「R1チップ」を開発し、この台数のカメラ接続を可能にしています。

このカメラ台数を実現しているからこそ、現実空間の認識精度を犠牲にすることなく、同時にDownward Camerasも接続して手の操作によるユーザー負荷も軽減することができています。

このようにVision Pro では操作によるユーザー負荷もかなり配慮されたものになっています。このポイントがVision Pro が日常的に使われる最初の空間コンピューターとなり、Vision Pro から空間コンピューティングシフトが起こる可能性を感じている理由の一つです。

Vision Pro から垣間見る空間コンピューティングの未来

以上、自分がVision Pro から空間コンピューティングシフトが起こると確信した、Vision Pro の革新的な3つのポイントについて紹介しました。

1. バーチャルコンテンツの違和感のない存在感

2. 没入体験を阻害しない体験フロー

3. ユーザーの負荷が圧倒的に少ない操作性

その他にもVision Pro にはたくさんの魅力があると思いますし、見る人によってその魅力も違ってくると思います。

自分はこれまで数年にわたり様々なXRデバイスを体験し、空間コンピューティングシフトを実現したいという思いでこの領域に携わってきました。そういった背景も含めて自分が紹介した3つの点を参考にしてもらえたら嬉しいです。

そしてぜひ皆さんもVision Pro を実機で体験して、空間コンピューティングの未来を垣間見てみてください。

VIsion Proを実機で体験してみたい人はぜひ以下のURLからDeveloper Labにも申し込んでみてください。

MESONではともに空間コンピューティングシフトを起こす仲間を募集しています

私たちMESONは様々な企業様とともに空間コンピューティング技術を活用し、人々のまなざしを拡張する共創プロダクト開発を主力事業として取り組んでいます。

また来年Vision Proが米国でリリースされることを見据えて、Vision Pro のローンチタイトルアプリ開発にも積極的に取り組んでいます。今年はオーディエンスとして参加したWWDCに、来年はVision Proのローンチタイトルアプリを開発した会社としてMESONで登壇したいと考えています。

空間コンピューティングシフトの挑戦に取り組むためにも、MESONではいま全職種積極採用中です!

このnoteを読んで、Vision Pro や空間コンピューティングに興味をもった方、MESONで空間コンピューティングシフトをともに起こしたいと思った方は以下のページからぜひご連絡ください!

私たちMESONが思い描く空間コンピューティングの未来、そして我々が取り組んでいるまなざしの拡張について知りたい方は以下の記事を御覧ください。

またこのnoteが少しでも役に立ったと思った方は、是非このnoteへの「いいね」や、SNS上でシェアをしてもらえると嬉しいです!

この記事が気に入ったらサポートをしてみませんか?