Appleの新型デバイス「Vision Pro」 Q&A集

先日、Appleが主催するWWDC2023にて、ついにAppleから新型HMD「Vision Pro」が発表されました!我々MESONにとっても待望のリリースです。

自分はそんな歴史的なWWDCに現地のApple本社でリアル参加することができました!

そして更に光栄なことに、実際にデベロッパーとしては初にして唯一実機を体験できる日本人に選んでいただくことができました!

今回のnoteでは、そんなWWDC現地にてVision Proの開発に携わるAppleのSpatial Computingチームのデベロッパーやエバンジェリストの方々から直接質問した内容をまとめました。

なお、この内容は元々現地にいる際にツイートした内容をもとに、自分の実機体験の内容やWWDC後に公開された他の方々の記事の内容を反映してアップデートしています。

Twitter上でも様々なVision Proに関するツイートを投稿していますので、もしよろしければそちらもフォローしてください!

Q&A集

Q: Vision Proを通して見える現実世界はどんなふうにみえる?

実際に体験したデベロッパーの方からはほぼずれ無くみえると言われました。目の端に映る線もQuestProみたいに歪んで見えたりしない。 自分の腕も実際のサイズ通りに見える。

スマホの画面や本の文字も読むことはできるけど、小さい字を読むのは疲れるので、やめた方がいいとのことでした。

実際に自分も体験してみるまでかなりこの点は懐疑的だったんですが、実際に体験したところ、本当に歪みがなく、リアル世界の距離感もそこまで違和感なく感じ取れる視界になっていました。

実際にVision Proを体験されたジャーナリストの松村さんもこの点がめちゃくちゃ印象に残っていらっしゃり、とても衝撃を受けていました。

実は装着してまず感動したのがこの部分でした。普段の距離感、自分の手のサイズ感などをそのまま、パススルーされている映像に適用できる感覚です。テーブルがある場所にちゃんとテーブルがある、コップを掴もうとしてもズレない、という実際の視覚で当たり前のことがキチンと再現されていました。

— 松村太郎 🎍 (@taromatsumura) June 6, 2023

ちなみに自分がデモした際には手元に映し出せるものがなかったのですが、何名かの他体験者の方から聞いた感じですと、実際にスマホや自身の手帳の文字も読めたそうです。(ただ少し粗い)

Q: どのくらいの時間かけ続けていられる?

HMD自体はとても軽いが、どのくらいかけられるかは人それぞれというのが結論でした。

AppleのSpatial Computingチームの様々な人に聞いてみても結構意見はマチマチでした。いつまでもかけ続けていられるという人もいれば、1時間くらいが限界という人もいました。

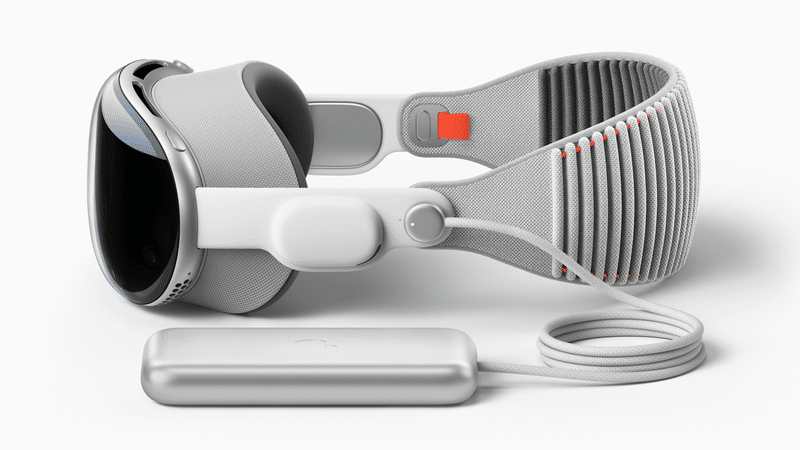

ただバッテリー外付けなので軽く、他デバイスより負荷が少ないのは確かです。

実際に自分が装着した感想としても1時間くらいかな、と思ったのが正直な所感でした。Quest Proなどと異なり、目の周り全体にカバーが接地するので、どうしても少し目の周りに圧を感じてしまいます。

目の周りの圧については、自分のツイートにもコメントくれている方が何名かいらっしゃったので、気にされる方は一定いそうだなと感じました。

目の周りの圧痛すぎてquest2は5分もつけてられなかったから心配#VisionPro https://t.co/lJc0u1evkW

— ⛩️zk.u_gii⛩️ (@moon_cryptol) June 8, 2023

ちなみにVision Proは本体とバッテリーが有線で繋がっていますが、バッテリーはソファーの上においたり、ポケットに入れておいてOKなのと、HMDからコードが後ろ向きに出ているため、このコードはそこまで気になりませんでした。

Q: ある場所にコンテンツを配置した時、どのくらい正確に復元できる?

Meet the teamセッションで質問した際にデベロッパーの方が教えてくれた話では、ある時、Apple Parkの屋外の道にARオブジェクト置いた後に、忘れ物に気づいて屋内オフィスに戻った。そのあと、もう一度その道に戻ったら、ほぼズレなくオブジェクトがそこに残っていたとのことで結構精度が高そうです。

ARコンテンツの位置合わせ含めて、AR関連の機能はすべてARKitをベースにしてるそうなので、ARKitと同程度の性能を期待してOKとのことでした。(でもARKit、そんなに位置合わせの精度高かったかかな?)

ちなみに実機デモの際には残念ながら、空間のスキャンはすでにされたあとになっており、一度配置したコンテンツを再度復元するなどのデモは体験できませんでした。

Q: Vision Proは外でも使えるの?

使えなくはないけど、あんまりお勧めはしないとのことでした。 まずは屋内ユースケースを考えており、デベロッパーとしても屋内ユースケースから作るのがベターだそうです。

WWDCのKeynoteセッションでも自宅や職場でのユースケースが紹介されており、あまり屋外はイメージされていないみたいです。

自分も実機体験してみて、「屋外ができない」というよりも、「このVision Proは屋内で使ってこそ最高の体験を作れる」と感じたので、屋内ユースケースにフォーカスしたほうがいいなと感じました。

これからVision Proでアプリ開発を考えている方々はぜひ屋内ユースケースにフォーカスして検討してみることをおすすめします!

Q: アプリのコンバートは簡単にできるの?

デベロッパーの方いわく、とても簡単にできるとのことでした。

keynoteでも発表があったように、Swiftだけではなく、Unityで作ったアプリもコンバートできるそうな。 スマホのタップインタラクションは、VisionProではGaze+Pinchで代用するそうです。

AppleとしてはVision Pro単体のハードだけではなく、Vision Proユーザーが使えるアプリをたくさん用意したいと考えているので、いますでに抱えているデベロッパーたちにコンテンツをつくってもらいたいのでしょう。

このタイミングからAppleがVision Proを発表した背景もこのあたりにあるのではないかと自分は考えています。iOS向けにアプリを開発しているデベロッパーにも、今のうちからVision Proを意識した機能やアプリを作ってもらえることを期待して、iPhone/iPad向けのアプリをVision Pro向けにコンバートできる機能を実装したんだと思います。

ちなみにAppleは「Apple Vision Pro compatibility evaluations」という機会も用意してくれており、すでにiPhoneやiPad向けのアプリをVision Proにコンバートできるかどうかの評価を7月ごろから実施してくれるそうです。ご興味ある方はこちらのページもチェックしてみてください!

Q: KeynoteセッションでVRという言葉を使わなかったけど、VRは視野に入れてないの?

視野全体を覆うImmersiveな体験ももちろん作れるし、VRを視野に入れてないわけではないが、 AR/VRというワードよりもSpatial Computingという言葉を我々は使っているとのことでした。

このあたり言葉の使い方はAppleの全社員がすごい徹底していると感じましたし、WWDC参加中にいろんなAppleのデベロッパーやエバンジェリストと話したときにも、AR/VRという言葉を極力使わないようにしていたのも印象的でした。 社内での意識統制もかなりしっかり力入れられているし、ブランディング的にも「ARやVRとは違う」ということをしっかり打ち出している意思を感じました。

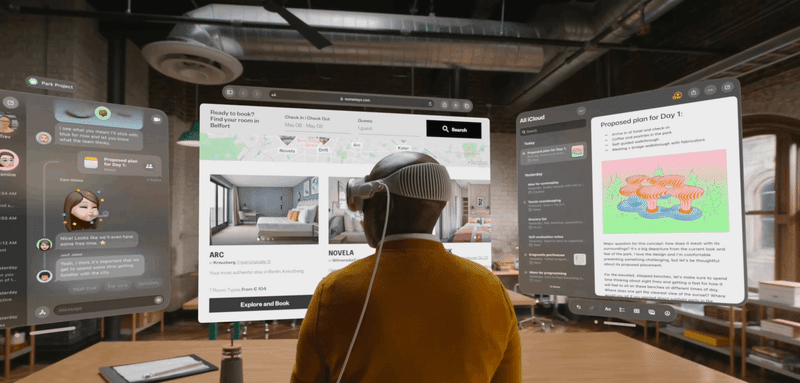

Q: Keynoteセッションでは3Dコンテンツが少ない印象だったけど、しばらくは2Dアプリを空間に出すことにフォーカスするの?

いまは2Dのものが多いけど、これから3Dも増えていくはずだし増やしていきたいと思っているとのことでした。 ユーザーがすぐにVision Proを使えるように、慣れ親しんでいる2Dコンテンツを用意しているそうです。

Q: Vision Proを起動したら、どういうフローになるの?

A: 基本的にはiPhoneのようにアプリ一覧がサッと出て、すぐアプリを起動できるとのこと。 他HMDのようにアプリ立ち上げまで時間を要さず、シームレスに没入できます。

これは自分も実機で実際に体験しましたが、素晴らしい体験でした。初めてHMDをかぶる際には初期設定が必要ですが、一度設定を完了させたらそのあとはかぶればすぐにアプリ一覧がさっとでてきます。

以前アメリカの若い世代のQuest2の所有率が高いが、一方で使用頻度はとても低いという記事を読んだことがありますが、HMDの使用頻度が低い理由の一つは「ワクワクする体験にたどり着くまでの道のりが長すぎる」ことにあると考えています。

Vision Proはその点、被ってデジタルクラウンをぽちっと押せばアプリ一覧がさっと出てくるので、ワクワクするまでの道のりがとても短く、HMDの使用ハードルをかなり下げているのではないかと思います。

Q: VisionOSのUX/UIは素晴らしいと思ったんだけど、チームで検討する上で大事にしたことやキーワードはある?

A: UIに関しては基本的にSwift UIの思想がベースにあるそうです。Swift UIはとても素晴らしいので、それをどうSpatialに拡張していくかを考えたそうです。

Vision OSのUIには多分にSwift UIの思想が入っていそうなので、これまでUnityでAR/VRのコンテンツ開発をされてきた方も一度Swift UIを学んでみるとより理解が深まるかもしれません。

またVision OSのデザイン原理について、WWDCの動画セッションでも紹介されているので、こちらも合わせてご覧ください。

Q: keynoteセッションの動画ではオクルージョンの様子がなかったけど、オクルージョンはできるの?

A: リアルの物体はもちろんのこと、人のオクルージョンも可能だそうです。 ARKitをベースにしてオクルージョンを実現しているので、ARKitでできるならVisionProでもできると思って良いそうです。

実機体験でも実際に自分の手を前に出すと、割ときれいにバーチャルコンテンツが隠れることを確認できました。

実機体験した際の部屋にあまりものがなかったため、ものの後ろに隠れるかどうかを実験できませんでしたが、人の後ろに入った際にはオクルージョンができることは確認しました。

Q: インドア向けのユースケースを考えていると思うけど、どんなアプリをAppleは期待してる?

これはエバンジェリストの方に質問した際に、個人的な見解として聞いてほしいという前置きがあった上で、 以下のような領域をおすすめしてもらいました。

教育

コマース

エンタメ

ゲーム

それから既に3Dモデルを保有している領域があるなら、そのアセットを活用してアプリを作るのもベターなのではないかと提案されました。

Appleとしても初期ユースケースとしては2D UIのものを中心に紹介していますが、ゆくゆくは3D UIのアプリを増やしていきたいそうです。

Q: アプリ開発者はユーザーの行動データをどこまで取れる?

基本的にユーザーのプライバシーに関するスタンスはVisionProも変わらないそうで、取得できるデータはかなり限定的だそうです。

ユーザーの視線情報などは開発者は収集したりすることはできないと思ってもらってよいとのことで、取れてもユーザーのタップ情報くらいだそうです。

実際に、Keynoteセッションでもしきりに「Appleはユーザーのプライバシーを保護する」ということを強調していました。

常にカメラを通して周りの環境を取得するグラス型やHMDデバイスが今後一般に普及していく際にはプライバシーの問題は避けては通れません。

Appleもその点はかなり気をつけながらVision Proの発売を進めるようです。

Q: バッテリーコードが途中で抜けたらどうなるの?ホットスワップは対応してる?

Vision Proはホットスワップは対応しておらず、抜けたり、バッテリーがなくなったら画面が落ちて、真っ暗になってしまうそうです。

ただコードの差込口はMacbookのMagSafeのように引っ張ればすぐ取れる形ではなく、「カチッ」と回して固定するようなつくりになっているため、Vision Proを装着しているユーザーが腕を動かした際などに簡単に外れることはないらしいです。

Appleのラボ制度のご紹介

以上、自分がWWDC期間中に現地で聞ける限りのAppleのSpatial Computingチームの方々に質問して得られた情報や実機体験して自分が感じたことなどを再整理してみました!

ちなみにWWDCではラボという制度があり、リモートからAppleのデベロッパーの方々と30分のミーティングをして、技術的な質問などもできます。

もし実際にAppleで働くSpatial Computingチームのデベロッパーに直接質問してみたいということであれば、以下のページからミーティングを予約してみてください。

最後に

今回のWWDC参加、そして実機のVision Proのデモ体験を通して、Vision Pro はXRスタートアップとしてベットすべき機会だと確信しました。

世界中で使われるVision Pro のアプリをいち早くリリースするスタートアップになるために、MESONは更に事業を加速していきます!

MESONはいま全職種積極採用中ですので、もし今回の記事をみて Spatial Computingの未来に共に挑戦したいと思われた方、少しでも興味を持っていただいた方はぜひTwitterのDM、もしくは以下の会社HPからご連絡ください!

この記事が気に入ったらサポートをしてみませんか?