技術トレンド解説〜XAI:説明可能なAI編

こんにちは、ANRI 鮫島です。

前回のnoteでは、「Modernaの誕生から読み解く研究開発型スタートアップ投資の進化」という記事を書きました。

今後複数回にわたって、情報セキュリティー分野のリサーチインターン生による最先端の技術の解説記事を掲載したいと思います。

技術に馴染みのない方や技術トレンドをさらっとおさらいしたいという方は、章ごとのタイトルとその下の太字のストーリーラインを追っていただければ、大筋の内容を理解していただけるように書きました。

1. XAIの技術リサーチ中に巡り合った投資案件

先日、AIの品質保守の自動化ツールを提供するCitadel AI社への投資を発表しました。

AIが実装された後の社会を予想してAfter AIの時代にどんなサービスが必要かを検討し、「Explainable AI:説明可能なAI (XAI)」のテーマを追っていた中で、Citadel AIと出会い、投資実行となりました。

今回の記事では、After AI時代に益々重要性が増すであろうAI倫理、特に説明可能なAI(XAI)をご紹介します。

2. はじめに:リサーチインターン生の自己紹介

初めまして!ANRIでリサーチインターンをしている、太極拳(仮名)と言います。簡単に自己紹介をさせていただくと、元々日本の大学で経済学を専攻していたのですが、理転してアメリカの大学院に進学し、情報セキュリティ分野の修士号を取得しました。元々ANRIでは留学前に技術調査のインターンをしましたが、大学院を修了して新卒就職まで少し時間があるため、インターンを再開しました。在学中にAI分野の研究に取り組んでいたため、初投稿となる今回の記事では、AI倫理に関連した技術分野について書いていきたいと思います。

3. AI倫理とは?:AIの利活用において守るべき9つの性質

AIを利活用するときの倫理的側面から、透明性、追跡可能性、プライバシー、説明可能性、公平性、頑強性、安全性、説明責任、尊厳性の9つを守る必要がある。

AI倫理とは具体的に何を指しているかと言いますと、ここでは以下の9つの要素から構成される、AIの利活用において守るべき性質とします。(表1参照)ここでは、工学的視点や(AIシステムを侵害しようとする)攻撃者者の視点とのつながりを考えて、このように分類しましたが、別の分類方法も存在します。

本記事と続く連載では、特に工学的視点からの説明を重視して、3つの技術分野について紹介していきたいと思います。

1. 透明性・公平性・説明可能性に関連する「説明可能なAI(XAI)」

2. 頑強性・安全性に関連する「AIの品質保証」「AIのセキュリティ」

3. プライバシーに関連する「プライバシー保護機械学習」

図1:AI倫理の9つの構成要素(出典[1]を参考に、筆者作成)

4. AI倫理に対する社会的ニーズの高まり

AIの社会実装に伴って信頼されるAIが求められており、世界各国でAI倫理に関する法制度整備や研究開発が進展している。

昨今AI倫理が注目されている背景には、様々な分野でAIが社会実装され、AIと社会との関わりが拡大してきたことがあります。それにより、AI倫理リスクに対応した「信頼されるAI(Trustworthy AI)」が産業界でも求められてきました。例えば、デロイトトーマツが実施した調査(出典[2])によると、約30%の国内企業がAI倫理リスクに対処できておらず、約50%の国内企業が倫理リスクを懸念しAIを導入していないと回答しています。もしAI倫理リスクに適切に対処することができれば、高い安全性が求められる交通・金融・インフラといった産業にも、信頼されるAIとして活用範囲を広げられる可能性があります。(図1参照)

図1:AI産業の拡大余地(出典[3])

(出典:人工知能研究の新潮流)

このような社会的背景から、日本を含めた世界各国でAI倫理に関する法制度整備や研究開発が進展してきました。例えば中国では、中国科学院(最高国家行政機関の直属研究機関)が中心となって自動運転等の商用利用に直結する「頑強性」の研究を取り組んでいます。一方、米国ではDARPA(国防高等研究計画局)等が中心となってAI倫理に関する技術開発を幅広く推進しています。(例えばDARPA主催のExplainable AI(XAI)プロジェクトやAI Next Campaignプロジェクト、NSF(アメリカ国立科学財団)主催のFairness in Artificial Intelligenceプロジェクトなど)(表2参照)「XAI」は、米国のDARPAが主導する研究プロジェクトが発端で、社会的に広く使われるようになった用語です。

表2:米国政府主導のAI倫理研究(出典[1]を参考に、筆者作成)

5. 米国でのAI倫理プロジェクト:DARPAのXAIプロジェクトの例

DARPAは軍用途の意思決定を支援するXAI開発をしており、AIモデルの特徴を意味的な情報と連携させるために、Deep Explanation、Interpretable Models、Model Inductionの3つの説明アプローチを挙げている。

今回の記事のテーマである「説明可能なAI(XAI)」に直結するDARPAのXAIプロジェクトの詳細について解説します。このプロジェクトの目的は軍用途の意思決定を支援するXAI開発です。

DARPAのミッション(機密情報分析と自律システム)と代表的な機械学習アプローチ(分類問題と強化学習)が対応した下記の2つのタスクが存在します。

1. Data Analytics(分類問題&機密情報分析)

説明の目的は分析官がどのターゲットを選ぶかを決めるための材料提供です。

例えば、敵と判断した一理由としては銃の輪郭を強調表示するなどの使われ方があります。

2. Autonomy(強化学習&自律システム)

ドローン、ロボットなどの自動パイロットを対象として、操縦者が自律システムをどういう状況でどう使うかを判断し、次のタスクを決定するための、根拠の提供を目的としています。

(出典:機械学習の説明可能性への取り組み)

これらのタスクに対するXAI研究による説明方法として、DARPAは次の3つを例示しています。

1. Deep Explanation(深層学習の状態解析や重要特徴量の可視化)

どの特徴が判別に効いているのかを示すだけでも分析官の判断を助ける意味では説明足り得る

2. Interpretable Models(元々解釈性の高い、ホワイトボックス型の機械学習の精度向上)

一般的にDNNより表現力,精度は下がるが,ネットワーク内のノードの意味を捉えやすく、モデルの構造や入出力間の相関関係を理解しやすい

3. Model Induction(モデル非依存(モデルをブラックボックスとした)手法)

ブラックボックス型の機械学習の入出力をより簡単に解析可能なモデルで近似するか、別のモデルで説明を生成する。

これらの技術的な詳細については、後ほど説明します。

図2:DARPAによる説明アプローチ(出典[4])

(出典:機械学習の説明可能性への取り組み)

このような説明可能モデルの研究だけでなく、XAIプロジェクトでは「説明インターフェース」や「説明の心理学」も研究対象に含まれます。具体的には、前者は最新のHCI技術と認知科学の融合によって理解可能な説明をどのように提示するかという研究です。後者は、心理学的な定理を拡張し、説明の効果を予測するための計算可能なモデルを開発するモデルになります。

6. XAIの技術概要

XAIとは「ユーザーが欲しい追加情報をAIモデルから抽出する技術の総称」である。

ここまでDARPA XAIプロジェクトについて解説してきましたが、そもそもXAIとは具体的に何をする技術なのでしょうか。

XAIとは「予測以外の追加情報を、モデルから抽出する技術の総称」のことです。例えば、AIを用いた医療診断の根拠を説明したいというXAI活用シーンの場合、「血糖値が高いから」等の重要項目や「過去の事例Xと類似しているから」等の追加情報を入手することができます。XAIは何でも説明してくれるすごいAIのように聞こえてしまうかもしれませんが、XAIが出力する追加情報はユーザーが明確に定義する必要があります。

XAIによって抽出したい追加情報は、学術的には「AIが学習によってどういう処理を獲得したか」という大局説明(Global Explanations)と、「学習済みのAIが各入力に対して、どういう根拠に基づいて出力を決定したか」という局所説明(Local Explanations)の2つに分けることができます。大局説明の活用シーンとしては、「AIモデルの改善運用」や「敵対的攻撃の検証」(次回ブログで詳細解説)等が考えられます。一方、局所説明の活用シーンとしては、「AIの予測根拠の説明」(空港の機内持ち込み荷物検査をAIで行う際に、どの荷物が原因で入場拒否になったかを利用客に説明する場面など)と「意図とは異なる学習の見直し」(AIによる融資審査において、拒絶理由が性別であった場合に、AIの予測過程が公平性を欠かないように再学習するという場面など)が考えられます。

7. XAIの研究動向

XAIの説明可能性とAIの精度を両立させることは困難であるが、近年爆発的に増加しているXAIの論文がこれに取り組んでいる。

前述のDARPA XAIプロジェクトの3つの説明アプローチは「AIアルゴリズムの解釈可能性と、AIモデルの精度との間にトレードオフがある」ことを前提に作られています。(図3参照)そのため研究の方向性としては、元々精度の良いAIアルゴリズムの説明可能性の向上(説明アプローチ①③、図3の横方向矢印)と、元々解釈可能性の高いAIアルゴリズムの精度の向上(説明アプローチ②、図3の縦方向矢印)の、2つの方向性が考えられます。

図3:AIアルゴリズムの解釈可能性と精度のトレードオフ(出典[5])

(出典:Peeking Inside the Black-Box: A Survey on Explainable Artificial Intelligence (XAI))

図4は2004年から2018年のXAI関連研究の盛り上がりを示しています。特に2014年から2015年の「黎明期」を経て、2016年から2018年に論文数が爆発的に増加していることが分かります。図5は、近年のXAI研究テーマを示していますが、2019年から2020年の直近では、「説明の攻撃・悪用」の研究や「説明法の評価」の研究が盛んであることが分かります。

図4:XAI関連論文数の推移(出典[5])

(出典:Peeking Inside the Black-Box: A Survey on Explainable Artificial Intelligence (XAI))

図5:XAI研究の進展(出典[6])

(出典:機械学習の説明の可能性)

8. 代表的なXAI技術:LIMEの紹介

LIMEは判断ルールを用いた説明方法で、AIモデルに対して非依存であるため、広く使われるモデル。個々の予測結果に影響する、重要な情報の可視化が可能である。

ここでXAI技術の動作原理をイメージしてもらうために、代表的なXAI技術であるLIMEのコンセプトを説明します。XAI技術は様々な観点から分類することができます。例えば「提供する追加情報」という観点からは、「判断ルールを用いた説明」「特徴量を用いた説明」「データの例示を用いた説明」の大きく3つに分けることができます。LIMEは「判断ルールを用いた説明方法」に分類されます。また、「AIモデルに対する依存性」という観点からは、特定のモデルに「依存」と「非依存」の2つに分けられます。LIMEは、モデルに「非依存」であるため、画像やテキストを含む様々なデータに対して利用することができ、モジュール性の観点からも便利であるため、よく使われる手法の一つです。

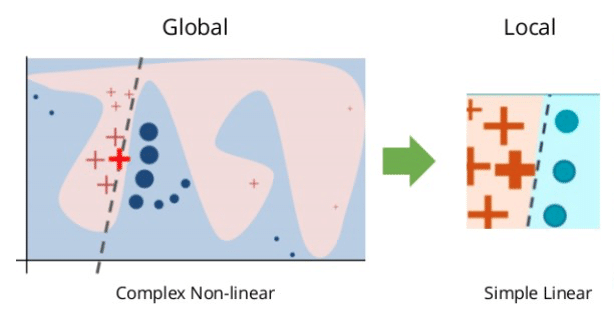

では、LIMEは具体的にどのような手法なのでしょうか。LIMEでは、対象データの近傍に限れば、複雑なAIモデルであっても単純な線形モデルで近似できると仮定しています。線形モデルを用いることで、係数の大小比較から各特徴の重要度を測ることができます。(図6参照)LIMEの動作原理は、大きく3ステップに分かれます。

①説明対象のデータをランダムに摂動させて、近傍データを生成します。

②近傍データに対する説明対象AIモデルの予測結果を取得します。

③近傍データと②の結果を組み合わせたデータを用いて、解釈可能な線形モデルを獲得します。

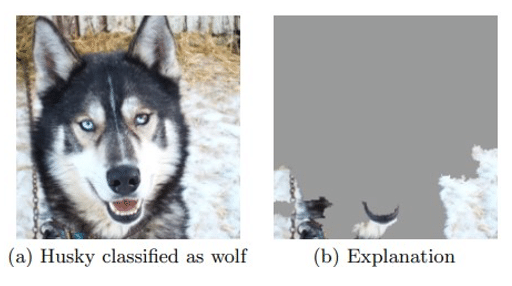

例えば図7ではAIが「ハスキー犬」を「狼」と誤って判断していますが、LIMEを用いることで、AIの判断理由として背景に雪が含まれていたからだと説明できるようになります。このように現状のXAI技術で実現可能なことの一つは、個々の予測結果に影響する、重要な特徴量や重要領域(画像の場合)の可視化が挙げられます。この他にも、Tree Surrogate等の手法を用いることで、予測に至る判断過程を(より解釈性の高い)代理モデルによって説明することも可能です。

図6:LIMEのコンセプト(出典[8])

(出典:What is Local Interpretable Model-Agnostic Explanations (LIME)?)

図7:LIMEによるハスキー犬の誤分類理由の説明(出典[9])

(出典:Why Should I Trust You?: Explaining the Predictions of Any Classifier)

9. XAI技術の限界:そもそも複雑なAIモデルを人間が理解できるレベルの解釈を与えること自体がナンセンスかも?

AIモデルは根本的に複雑であり簡単な構造しか認識できない人間が理解することは不可能であるため、それを説明しようとするXAI技術は実現困難であると主張する研究者もいる。

最後にXAI技術の限界について説明します。一般的に複雑な事象を説明しようとすると複雑になるように、複雑なAIモデルを説明するXAIモデルも複雑となります。そのため現在の一部のXAIモデル(Tree Surrogateなどの代理モデルやAttentionやGrad-CAMなどのXAI技術)は対象のAIモデルそのものを説明していなかったり、一部を説明するに留まっています。

深層学習ブームの火付け役である著名なAI研究者のジェフリー・ヒントン博士はXAI技術に懐疑的な意見をもっており、「深層学習は膨大なデータから抽出した重みからできており、そこに人間が判断できる簡単なルールはない」と主張しています。むしろ、無理やり説明可能にしてしまうことで、受け手の既存の知識の組み合わせで記述することとなり、誤った判断根拠となることを危惧しています。同様に、米デューク大学で機械学習を研究しているシンシア・ルディン博士も、人間が理解可能な説明モデルのほとんどは線形かつスパース(疎)であり、深層学習のような本来非線形なモデルを線形モデルで近似してそれを説明と呼ぶことは、重大な誤認識やトラブルを招く可能性があることを指摘しています。人間の解釈が必要な場合は、XAI技術ではなく、そもそも人間が解釈可能なシンプルなパラメータを用いてモデルを作成すべきであると主張しています。

10. おわりに

最後までお読みいただきありがとうございます!本記事を要約すると、説明可能なAIはその高い社会的ニーズを受けて、これまで色々な方向からの研究がされてきたものの、未だAIモデルそのものの動作原理を解明するには至っていないというまとめになるかと思います。次回は、「AI倫理に関する技術調査の第二回(AIの品質保証・AIのセキュリティ)」と題しまして、引き続きnoteを執筆していきたいと思います。よろしくお願いします!

ベンチャーキャピタルANRIは、「未来を創ろう、圧倒的な未来を」というビジョンのもと、インターネット領域をはじめ、ディープテックやライフサイエンスなど幅広いテクノロジー領域の大学発スタートアップにシード期から投資を行っております。

資金調達や起業などのご相談は、下記お問い合わせよりご連絡ください!

【参考文献】

[1]AIのガバナンスに関する動向調査

https://www.meti.go.jp/meti_lib/report/2019FY/000199.pdf

[2]AIガバナンス サーベイ

https://www2.deloitte.com/jp/ja/pages/deloitte-analytics/articles/ai-governance-survey-2020.html

[3]人工知能研究の新潮流

https://www.jst.go.jp/crds/pdf/2021/RR/CRDS-FY2021-RR-01.pdf

[4]機械学習の説明可能性への取り組み(DARPA XAIプロジェクトを中心に)

https://www.jst.go.jp/crds/sympo/201906_JSAI/pdf/02.pdf

[5]Peeking Inside the Black-Box: A Survey on Explainable Artificial Intelligence (XAI): https://ieeexplore.ieee.org/document/8466590

[6]機械学習の説明の信頼性

https://www.slideshare.net/SatoshiHara3/ss-238926593

[7]XAI(説明可能なAI)

https://www.amazon.co.jp/dp/B098W4L6DL

[8]What is Local Interpretable Model-Agnostic Explanations (LIME)?

https://c3.ai/glossary/data-science/lime-local-interpretable-model-agnostic-explanations/

[9]Why Should I Trust You?: Explaining the Predictions of Any Classifier

https://www.kdd.org/kdd2016/papers/files/rfp0573-ribeiroA.pdf

[10]説明可能AIは幻想か

https://xtech.nikkei.com/atcl/nxt/column/18/00138/040300518/

この記事が気に入ったらサポートをしてみませんか?