Akira's ML news #Week 5, 2021

2021年第5週(1/24~)に私が読んだ論文や記事で特に面白かったものを紹介します。なるべく新しいものを紹介していますが、論文投稿日はこの週のものとは限りません。※有料設定してますが、投げ銭用なので全部無料でみれます。

【お知らせ】お試しで、今週分からRevueを使ったニュースレターを配信し始めました!内容はこの記事と同じですが、ご興味ある方は是非ご登録お願いします!

内容 :

1. 論文, 2.技術的な記事, 3.実社会における機械学習適用例, 4.その他話題

今週の注目記事/論文

- 1つのGPUで130億パラメータの学習をする

- 強化学習は画面のどこを見ているか

- 知識蒸留とアンサンブルの関係性をニューロンが取得する「視点」から解釈する

---------------------------------------------------------------------

1.論文

----------

1クラス分類のサーベイ

One-Class Classification: A Survey

https://arxiv.org/abs/2101.03064

異常検知などで使われる画像系タスクの1クラス分類に関するサーベイ。わりとGANベースのアルゴリズムが多く紹介されている。また、使用されるアルゴリズムだけでなく、異常検知のデータセットや評価指標に関しても言及している。

データセットを数枚に圧縮する

DATASET CONDENSATION WITH GRADIENT MATCHING

https://openreview.net/forum?id=mSAKhLYLSsl

データセットを学習精度の劣化を可能な限り防ぎつつ1クラス数枚に圧縮する研究。データから得られる勾配が一致するようにデータセットを学習していく。MNIST(CIFAR)を10枚に圧縮して92%(45%)の精度が出る。Neural Architecture Searchでも有効性を確認

コンセプトに関連する情報を潜在空間で白色化することで解釈性をもたせる

Concept Whitening for Interpretable Image Recognition

https://arxiv.org/abs/2002.01650

潜在空間の中で指定のコンセプト(ラベル等)を白色化しつつ分離できるように学習することで、モデルが何をみているかを可視化する研究。浅い部分だと色合いなどネットワークが分類の根拠にしている低レベルの特徴を見ており、逆に深い部分だとより抽象度の高い特徴を見ていることがわかる。BatchNormの代わりにConcept Whitening moduleを挿入することで動作する。

マスク領域全体の総和を1つの物体の表現と解釈する

Object-Contextual Representations for Semantic Segmentation

https://arxiv.org/abs/1909.11065

意味的領域区分では各画素にラベルが紐づけられるが、その意味領域ラベル内での画素の表現の集合がその意味領域ラベルを良く表現すると考え、それを体現したObject-Contextual Representation(OCR)モジュールを考案。ECCV2020コンペで一位獲得。

事前学習と微調整学習両方で敵対的学習を用いる

Large-Scale Adversarial Training for Vision-and-Language Representation Learning

https://arxiv.org/abs/2006.06195

モデルを誤分類させるノイズを乗せて学習する敵対的学習は精度向上施策として有効。VILLAは、画像言語タスクにおいて、敵対的学習を事前学習と微調整学習両方に用いていることで精度を向上させ、様々なvision languageタスクで最高精度を達成した。

生徒モデルだけでなく教師モデルも更新しながら学習を行う

Meta Pseudo Labels

https://arxiv.org/abs/2003.10580

教師モデルによる疑似ラベルで生徒モデルを学習させる手法では一般に教師モデルは固定であるが、最終的な生徒モデルの精度は教師モデルに依存する。そこで教師モデルも生徒モデルの更新情報を使って更新することで精度を向上させる戦略をとる。ImageNetにおいてラベルの10%を使うだけで90%以上の精度を出せる。

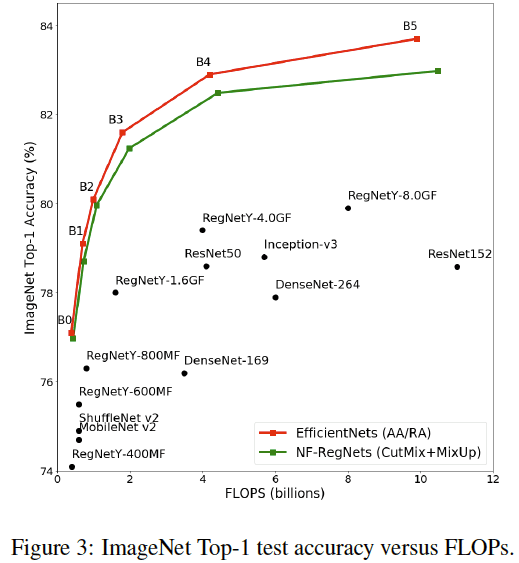

BatchNormの挙動をまねることでBatchnormを除いたネットワークを学習する

CHARACTERIZING SIGNAL PROPAGATION TO CLOSE THE PERFORMANCE GAP IN UNNORMALIZED RESNETS

https://arxiv.org/abs/2101.08692

BatchNormを含んだResNetの特徴量マップの挙動を解析し、BatchNorm無しでもその挙動を再現できるような係数をかけることによって正規化層なしでも深いネットワークで学習できるNF(Normalization Free)-ResNetを提案。不安定な部分があるのでCutMix等と併用が必要だが、AutoAugmentを使ったEfficientNet程度の性能が出せる。

1つのGPUで130億パラメータの学習をする

ZeRO-Offload: Democratizing Billion-Scale Model Training

https://arxiv.org/abs/2101.06840

1つのGPUで最大130億パラメータの学習が可能なZeRO-Offloadを提案。順方向と逆方向の計算とパラメータはGPUで維持しつつオプティマイザーの計算をCPUに任せる。高速に処理が可能、かつ、複数GPUにも拡張可能。さらにDeepSpeedライブラリを使って簡単に使える。

---------------------------------------------------------------------

2.技術的な記事

----------

TransformerはGNNである

TransformerモデルとGraph Neural Networksの類似性を指摘した記事。文書のtokenをノードと見て、それらが互いに全て接続しているグラフだと見れば、文書がグラフと見做せる。それにGNNを適用すると考えれば、GNNを使ったTransformer(Graph Attention Networks + norm + Feed Forward Networks )が構築できる。

衛星画像からの建物検出コンペの解法

建物をセマンティックセグメンテーションで検出するSpaceNetチャレンジにおける差別化ポイントとなった上位入賞者の解法解説。

建物が小さいため解像度を上げること、建物が密集いているため、建物の境界のマスクを追加すること、などが述べられている。

強化学習は画面のどこを見ているか

強化学習において、ゲーム画面がどのように解釈されているかを可視化した記事。エージェントが失敗したときにどのような観測が成されていたかを観測している。他にもある特定の層でしか解釈可能な可視化ができなかったこと、モデルを手動で編集してある障害物を不可視状態にしても常に失敗するわけではない(他の層がその可視化役割を担っていると解釈)、解釈可能な層を作るには環境ランダム化が必要だったこと、などが述べられている。

知識蒸留とアンサンブルの関係性をニューロンが取得する「視点」から解釈する

Kaggle等でよく使われるアンサンブルはモデルの分散を小さくするから性能が良くなると考えられてきたが、各ニューロンが取得する「視点」がより多くなるので性能が向上するのではないかと提唱。この観点で考えると知識蒸留は、「視点」情報を移行する枠組みと解釈でき、自己蒸留は知識蒸留による暗黙的なアンサンブルであるとしている。

機械学習のライフサイクル

「データ収集→モデル開発→評価」という本番環境におけるモデル開発のライフサイクルを解説した記事。データのアノテーションをする際の注意事項や方針をキチンときめておかないとモデルの精度が上がらないこと、予測がうまくいってないサンプルを見ることで更なる精度向上が期待できること、などが述べられている。

---------------------------------------------------------------------

3.実社会における機械学習適用例

----------

鉛中毒にAIで対抗する

ミシガン州フリント市では老朽化する水道管による鉛中毒が発生していたが、機械学習を使い、高リスクのエリアを特定するモデルを作る取り組みとそれに伴う裁判の経緯が述べられた記事。住民から情報を取得しないといけないため、情報を収集する期間(この場合は政府機関)とアルゴリズムへの信頼が不可欠であると語っている。

火星のクレーターを機械学習で探す

火星研究において、新しいクレーターの特性を調査することで古いクレーターの年齢を推定することができる。NASAでは深層学習を使って火星のクレーターを探す取り組みを行なっており、45分かかっていた作業が5分に短縮することができた。

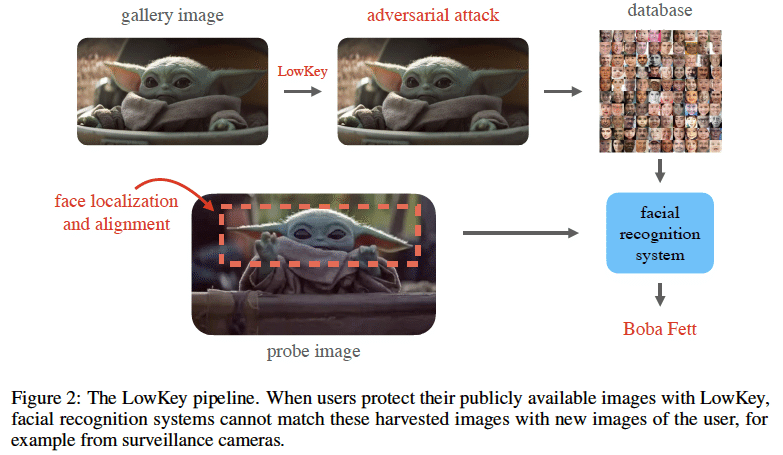

商用の顔認証システムからプライバシーを守る

LOWKEY: LEVERAGING ADVERSARIAL ATTACKS TO PROTECT SOCIAL MEDIA USERS FROM FACIALRECOGNITION

https://arxiv.org/abs/2101.07922

商用の顔認証システムで正確な照合を困難にするツールLOWKEYをリリース。写真をアップロードすると敵対的ノイズを乗せた画像を送ってくれる。AWSとAzureの顔認証システムで効果を確認。

---------------------------------------------------------------------

4.その他話題

----------

注目のAIスタートアップ

Crunchbase(民間企業および公開企業に関するビジネス情報を検索するためのプラットフォーム)による注目のAIスタートアップの動向と注目の25社の紹介。2020年は資金調達の中央値は440万ドルで、AIスタートアップ全体だと276億ドルの資金提供をうけたとのこと。アメリカの企業も多いが、イスラエルも多い。

ホワイトハウスが人工知能の開発を主導する機関を立ち上げる

人工知能分野におけるアメリカのリーダーシップを今後数年間確保するためにのオフィスをホワイトハウスが立ち上げた。米国の国家AI戦略の監督と実施や、政府全体、民間、学界などとのAI研究と政策立案における中心的なハブ機能としての役割を担うとのこと

中国・欧州よりも米国がAI研究をリードしている。

人の能力、研究活動、商業開発、ハードウェアとソフトウェアへの投資など、30の個別の指標を使用してAIの研究開発を評価した結果、米国が100点満点中44.6ポイントの総合スコアでリードしており、中国が32ポイント、欧州連合が23.3ポイントと続く。米国の研究の平均的な質は中国・欧州よりも高いとのこと。しかし、中国政府はAIを国家の最優先事項としており、特にスーパーコンピュータの数では昨年の保有数は一番多く、注視することは必要。

---------------------------------------------------------------------

過去の記事

2021 Week 4の記事⇦2021 Week 5の記事(コレ)⇨2021 Week 6の記事

2020年10月のまとめ

2020年11月のまとめ

2020年12月のまとめ

2020年の総まとめ

---------------------------------------------------------------------

記事は以上です。ここから下は有料設定になっていますが、特に何もありません。この記事が気に入って投げ銭しても良いという方がいましたら、投げ銭をして頂けると嬉しいです。

TwitterでMLの論文や記事の紹介しております。

https://t.co/diJ4zdqKSz

— akira (@AkiraTOSEI) January 25, 2021

1つのGPUで最大130億パラメータの学習が可能なZeRO-Offloadを提案。順方向と逆方向の計算とパラメータはGPUで維持しつつオプティマイザーの計算をCPUに任せる。複数GPUにも拡張可能で、DeepSpeedライブラリを使って簡単に使える。 pic.twitter.com/zVHBO50ciO

ここから先は

Akira's ML news & 論文解説

※有料設定してますが投げ銭用です。無料で全て読めます。 機械学習系の情報を週刊で投稿するAkira's ML newsの他に、その中で特に…

記事を書くために、多くの調査や論文の読み込みを行っております。情報発信を継続していくためにも、サポートをいただけると非常に嬉しいです。