Akira's ML news #Week 2, 2021

今週の注目記事/論文

- コードブックとTransformerで高解像度画像を生成する

- 自然言語と画像を合わせて学習することでゼロショット推論を可能する

- OpenAIによるText-to-imageの大幅な改善

---------------------------------------------------------------------

2021年第2週(1/3~)に私が読んだ論文や記事で特に面白かったものを紹介します。なるべく新しいものを紹介していますが、論文投稿日はこの週のものとは限りません。※有料設定してますが、投げ銭用なので全部無料でみれます。

内容 :

1. 論文, 2.技術的な記事, 3.実社会における機械学習適用例

---------------------------------------------------------------------

1.論文

----------

コードブックとTransformerで高解像度画像を生成する

Taming Transformers for High-Resolution Image Synthesis

https://arxiv.org/abs/2012.09841

コードブックとTransformerを用いて画像を生成するVQGANを提案。VQ-VAEのように潜在空間を量子化するが、GANを用いて画像を生成させること、コードの出現確率PixelCNNでなくTransformerで自己回帰学習していることが異なる。深度やkey pointからの画像生成も可能

自然言語と画像を合わせて学習することでゼロショット推論を可能する

Learning Transferable Visual Models From Natural Language Supervision

https://cdn.openai.com/papers/Learning_Transferable_Visual_Models_From_Natural_Language_Supervision.pdf

画像とテキストそれぞれを符号化するネットワークを使い、画像分類などのタスクをGPT-3のようなzero-shotでこなすCLIPを提案。画像側はViT、テキスト側はTransformerを用いて、画像とテキストペアを正しく当てる事前学習を400万の画像とテキストのペアデータセットを使って学習する。CLIPは自然言語を用いているため、ImageNet等で事前学習したモデルより様々なタスクより柔軟に対応可能でき、例えばイラストでカテゴリを当てられる。画像分類のほかに、行動検知、OCR, オブジェクト詳細分類などもタスクもこなせる。しかし、物体を数えたり、距離を表現するなどのタスクは苦手としている(GPT-3でもチーズが溶けるなど物理的関係が理解できないという同様の問題があった)

OpenAIによるText-to-imageの大幅な改善

DALL·E: Creating Images from Text

https://openai.com/blog/dall-e/#fn1

OpenAIが開発したTransformerベースのtext-to-image(文書から画像を生成)モデル。論文は未発表だが120億のパラメータ(GPT-3の1/10程度)をもつ。単一の物体だけでなく複数の物体も描写可能で、存在しない概念(アボカド椅子)も上手く描写できる。画像を途中から生成させることでIQテストっぽいのも解ける。

アノテーターによる不確実性を考慮する

Disentangling Human Error from the Ground Truth in Segmentation of Medical Images

https://arxiv.org/abs/2007.15963

医療データでは各人の習熟度によって作成した「正解」Segmentationマスクの精度/傾向が異なるが、それらの不確実性を考慮できる学習手法を提案。マスク予測ネットワークと各人の予測マスクの画素毎混同行列を算出させるネットワークにわかれる。

100データで学習できるGAN

Differentiable Augmentation for Data-Efficient GAN Training

https://arxiv.org/abs/2006.10738

少数データで画像を生成できるGAN。微分可能なデータ拡張を使って、G/Dの学習両方でデータ拡張をかける。微分不可能だとDの学習のみでしかデータ拡張をかけれず、G/Dの学習のバランスが崩れ、性能劣化する。

ラベルのミスに対してラベル平滑化で対処する

Does label smoothing mitigate label noise?

https://arxiv.org/abs/2003.02819

ラベル平滑化がラベルノイズに対して効果があることを実験的に示した研究。

ノイズがある状態では通常のCEロスよりも一貫してラベル平滑化を使用した方が精度が良化し、ノイズデータを上手く分離できる。ノイズがある状態での蒸留では、ラベル平滑化を使う方が上手くいくことを発見。

画像系タスクに使われるTransformerのサーベイ

A Survey on Visual Transformer

https://arxiv.org/abs/2012.12556

画像系タスクに使われるTransformerのサーベイ。Transformer自体の解説から始まり、タスク毎に解説している。まだ数が少ないせいか解説はわりと丁寧めで、特にViT, DETRは詳しく述べている。

周波数空間の情報をとりいれる

FcaNet: Frequency Channel Attention Networks

https://arxiv.org/abs/2012.11879

SENetのようなチャネルAttentionを一般化し、周波数成分の処理を取りいれたFcaNetを提案。特徴量マップに離散フーリエ変換をかけると、SENetの処理はk=0に相当するが、k>1の情報も扱える。大きく精度が向上。

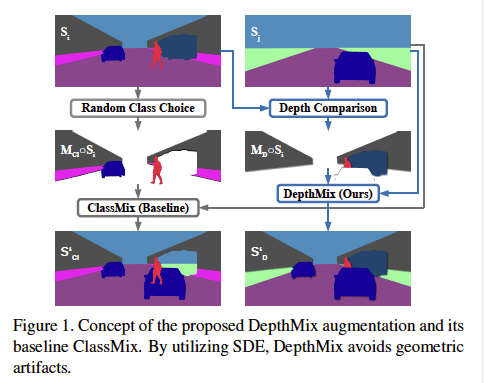

深さ情報も利用して使ってセグメンテーションを行う

Three Ways to Improve Semantic Segmentation with Self-Supervised Depth Estimation

https://arxiv.org/abs/2012.10782

深度情報を領域区分タスクに応用する研究。深さに応じて不自然にならないようにデータを混ぜ合わせるDepthMix、アノテーションすべきサンプルを多様性と不確実性の観点から深度推定モデルを使って選ぶ戦略を提案している。

---------------------------------------------------------------------

2.技術的な記事

----------

Python Library 2020

2020年に発売、もしくは普及したpythonのライブラリを紹介している。エラーを見やすくする PrettyErrors、pytorch版のkerasと呼ばれるpytorch lightning, トラッキングが数行で実行できるnorfairなどを紹介している。

GNNとNLPの研究動向への苦言

GNNとNLPの関係性を行列の因数分解という観点(Graphの埋め込みは行列による圧縮であり、NLPも同じように行列による圧縮をしている)で指摘したあと、GNN/NLP研究動向に対する苦言をしている。Graphの評価データセットが小さすぎることや、アーキテクチャの改善に注力する(層を重ねれば代替できると主張)研究動向を批判している。

---------------------------------------------------------------------

3.実社会における機械学習適用例

----------

2021年のAIヘルスケアの予想

AIが2021年にどのようにヘルスケア分野に使われるかを予想した記事。品質管理の高速化や、診断患者の優先度づけ、遠隔地における医療、特定の検査に送るかどうかのスクリーニングなどに活用できる可能性を述べている。

リアルタイムAIと活用例その実現方法

リアルタイムに予測するAI(オンライン予測)とリアルタイムにモデルを更新するAI(オンライン学習)2つの観点から、利活用のされ方と、それを実現するための技術、課題を議論している。前者では、実現するための技術としてはモデル圧縮などを上げている。後者では利用例としてTikTokの推薦システムを挙げているが、まだ限られた企業しか導入していないとしている。多くの企業では、これらの導入に対して議論している段階だが、一部の企業でこのようなリアルタイム機械学習が行われており、競合に優位性をつける鍵になるかもしれない。

---------------------------------------------------------------------

4.その他話題

----------

JupyterLab 3.0がリリース

JupyterLab 3.0がリリースされた。ビジュアルデバッカー、中国語等の複数言語への対応、インターフェースのシンプル化などが目玉のようだ。

AI/MLスタートアップの失敗

AI/MLで成功/失敗したスタートアップとその原因の議論の記事。失敗の原因として、経営や取り組んだ問題の難易度が上げられているが、MLが必要ないところにMLを適用しようとして失敗した、という指摘もあり興味深い。スタートアップの成功の定義に対する議論もある(買収されること?IPO?)。

---------------------------------------------------------------------

過去の記事

2020 Week 52の記事⇦2021 Week 2の記事(コレ)⇨2021 Week 3の記事

2020年10月のまとめ

2020年11月のまとめ

2020年12月のまとめ

2020年の総まとめ

---------------------------------------------------------------------

記事は以上です。ここから下は有料設定になっていますが、特に何もありません。この記事が気に入って投げ銭しても良いという方がいましたら、投げ銭をして頂けると嬉しいです。

TwitterでMLの論文や記事の紹介しております。

https://twitter.com/AkiraTOSEI

ここから先は

Akira's ML news & 論文解説

※有料設定してますが投げ銭用です。無料で全て読めます。 機械学習系の情報を週刊で投稿するAkira's ML newsの他に、その中で特に…

記事を書くために、多くの調査や論文の読み込みを行っております。情報発信を継続していくためにも、サポートをいただけると非常に嬉しいです。