記事一覧

デジタルコミュニケーションにようこそ

はじめまして。

デジタルコミュニケーションの技術解説をしていきます。

どうぞ、よろしくお願いします。

第19回 通信路符号化定理

阿坂先生

前回は信号の誤り率が0.1の場合の通信路容量Cは0.531であることを説明した。これは1000個の1と0を伝送したら531ビット分の情報をほぼ誤りなしで伝送できるという意味じゃった。

桂香助教

伝送信号の長さnと伝送ビットの数kとの比Rを符号化率と呼ぶわ。R=k/nよ。上記ではR=531/1000=0.531。ここでは通信路容量Cと同じに設定したのよ。つまり、R=Cよ。

阿坂先生

シ

第18回 通信路容量

阿坂先生

通信路符号化定理を導き出すために雑音がある通信路では伝送した情報の量が受信側でどのくらい減ってしまうのか求めてみよう。

麦わら君

それって、通信路で発生する誤りの発生確率で計算できるんじゃないですか?誤る確率が0.1だったら、1000ビット送ったら100ビット間違うので伝送できる情報の量は900ビットじゃないですか?

桂香助教

ぶー。違うのよ。なぜ違うのかは後で説明するけれど、伝送で

第17回 通信路と通信路符号化の基礎

阿坂先生

これまで勉強してきた情報源符号化による情報の圧縮は「雑音のない通信路」を想定しておった。

麦わら君

雑音のない通信路ってなんですか?通信路とは?

桂香助教

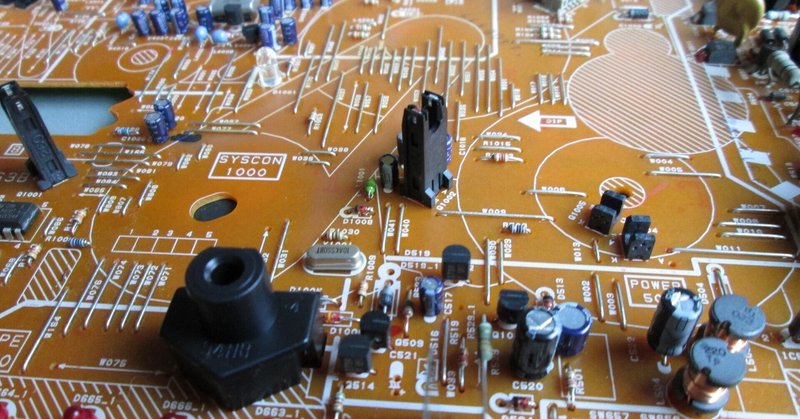

下図のようにあるパソコンから違うパソコンへ信号を送るときLANケーブルが通信路になるわよ。無線LANだったら空気が伝搬路に相当するわ。

でも、この途中の通信経路に流れる電流や電波に加わる雑音は基本的には避けれれないものなのよ。雑

第12回 情報源符号化 その1

阿坂先生

今回は情報源符号化の第1回目じゃ。情報源符号化の勉強では、より多くの記号をできるだけ少ない0と1のビット列で(送る)保存する!という課題を取り扱うぞい。

桂香助教

たとえばね、「AAAAAAAAAAAAA・・・・AAAAAAA」といった記号Aが1000個続く情報をハードディスクに保存したり、インターネットで誰かに送ったりするときに「Aを保存し(送り)続ける」よりも、例えば「Aが1000

情報理論(第8回 条件付きエントロピー、結合エントロピー)

阿坂先生

前回は確率の勉強として条件付き確率や結合確率を勉強した。これで準備が揃ったので条件付きエントロピー及び結合エントロピーを求めてみよう。

桂香助教

まず、復習として情報の量はどう求めるか覚えている?忘れた人は第3回を見てね。

麦わら君

はい。何か起こる確率をPとしたときの情報の量は-log(P)となります。

阿坂先生

そうじゃったな。ではエントロピーHのほうはどうじゃ?

麦わら君