iOSの機械学習の公式サンプルアプリを試す(Core ML/Vision)

iOSで画像認識や機械学習のアプリ開発に興味はあるものの「やってみたいけど難しそう」「何からやればいいか分からない」と思っている人いますよね、僕もそうでした。

Appleの公式サイトには機械学習に関する各種ドキュメントの他に、画像認識や物体検出のサンプルアプリのソースコードが用意されています。これから機械学習を始めようと思っている人はまずはサンプルコードを動かしてみることで基本的なアプリの動きやAPIの使い方、ロジックの雰囲気を掴んでみることをお勧めします。

Core MLモデルのダウンロード

Xcodeが既にインストール済みであればソースコードのダウンロードから実行まで3分もかからないので早速、試してみましょう。まず下記のリンクからCoreMLモデルの公式サイトにアクセスします。

ページ中央にスクロールすると機械学習のモデルとサンプルが並んでいます。今回は左下赤枠で囲った MobileNetV2 を試してみます、カメラで撮影した画像に写っている物体(オブジェクト)を機械学習を使って分類するアプリケーションです。

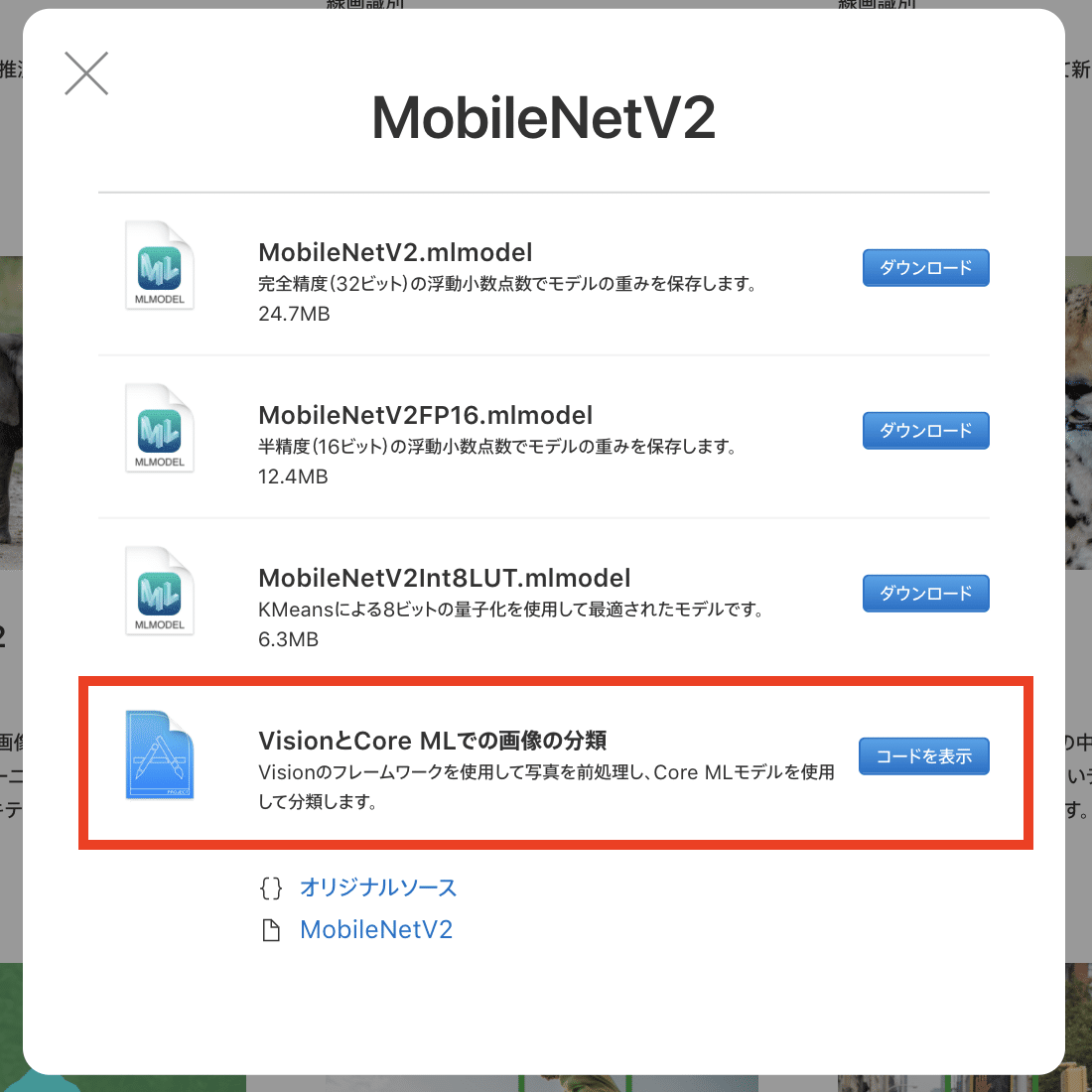

青いボタンの モデルを見る をクリックすると下の画面が表示されます。

赤枠で囲ったところにXcodeのサンプルコードへのリンクがあります。「コードを表示」をクリックすると次のページが表示されます。

赤枠で囲ったDownloadボタンをクリックしましょう。ClassifyingImagesWithVisionAndCoreML.zip のダウンロードが始まります、これが今回使用するサンプルコードです。

ダウンロードしたzipファイルを展開すると Vision+ML Example.xcodeproj(種類が Xcode Project のファイル)があります、そちらが今回使用するサンプルアプリのプロジェクトファイルです。

Vision+ML Exampleのビルド

プロジェクトファイルをダブルクリックで開きます、その際に以下のようなダイアログが表示されることがあります。これは 開こうとしているプロジェクトファイルはインターネットからダウンロードしたファイルだけど本当に開いても問題ないか? という確認のようです。問題ないことを確認したらOpenをクリックします。

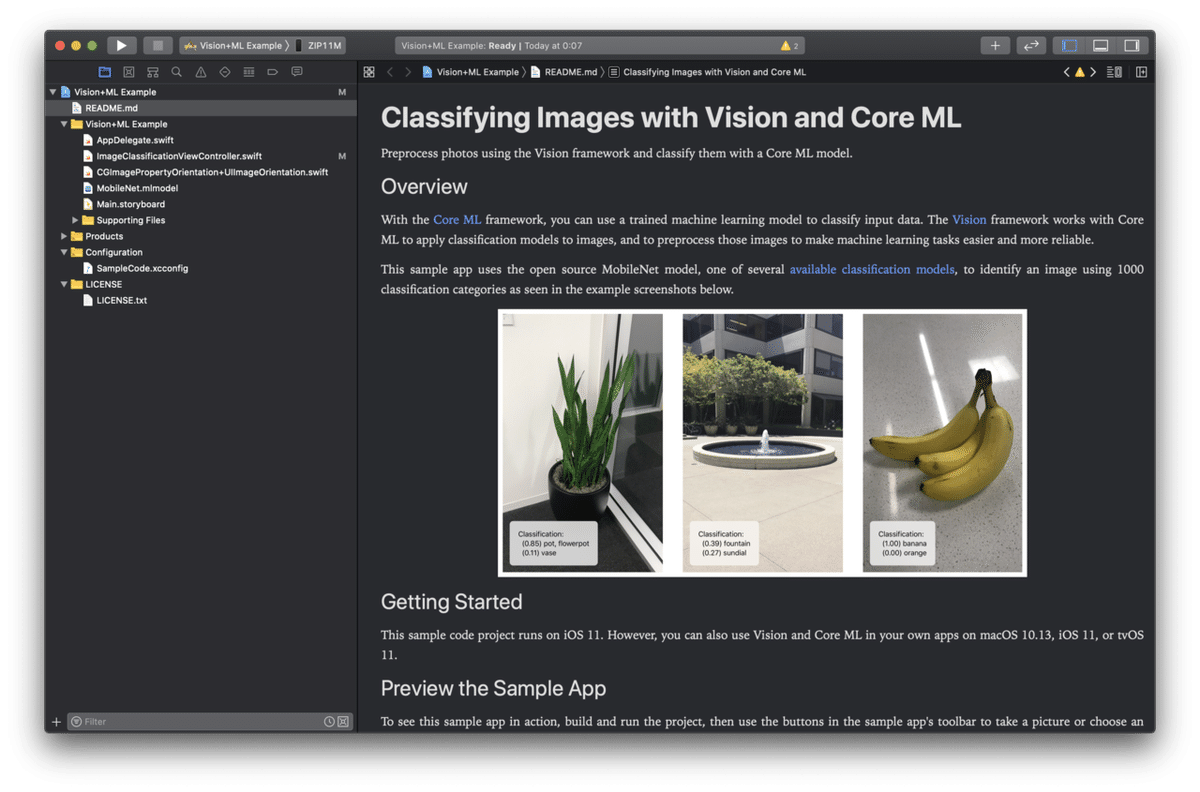

Xcodeが立ち上がりプロジェクトが表示されます。

このまま実行と行きたいところですが実機で実行する為に証明書の設定が必要なので下記の1から4の順番で開いて証明書のTeamをNoneから自分のTeamIDに変更します。

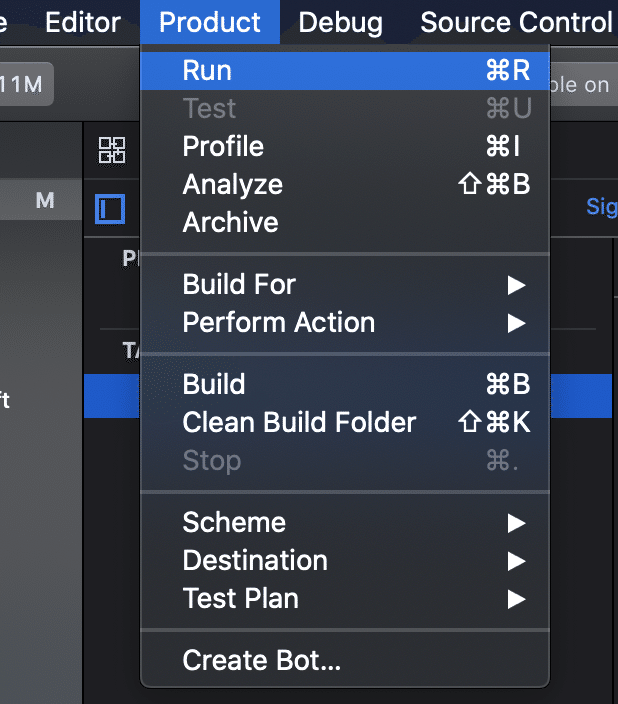

準備が整ったのでデバイスを接続して実行します(カメラを使うので実機が必要です)。

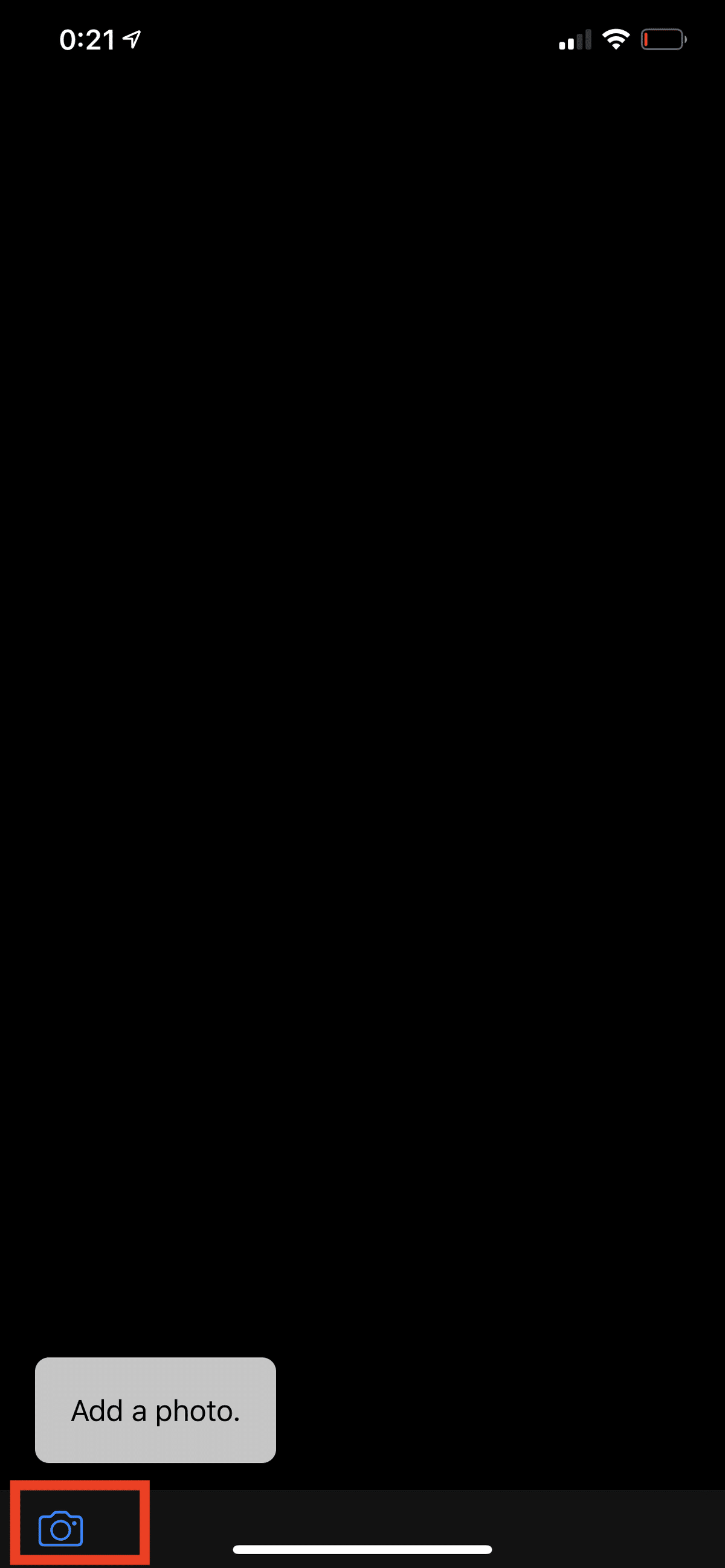

ビルドが成功すると端末でアプリが起動します。画面左下に写真のボタンを押すとカメラでの撮影かライブラリの選択ができます。

実際にMacBookProを撮影して認識させた結果がこちらです、notebook, notebook computer として認識されていることがわかります。

以上が公式サンプルアプリを使った機械学習の初めの一歩でした、思ったよりも簡単だったのではないでしょうか。最初に開いたページには他にもサンプルアプリへのリンクがあるので時間があれば試してみると良いと思います。

この記事が気に入ったらサポートをしてみませんか?