未来のVRセッション

たまたまVRでセッションした音源を触る機会があったので、

将来的にこういうのがリアルタイムで行えるような

通信技術・処理能力がある前提での仮定のもと

リミックスしてみた。

#VRアンサンブル研究会

— litalita (@litalita9764629) September 17, 2023

「タイスの瞑想曲(マスネ)」

vn: まぁちゃん

pf: litalita#あ茶会 夏コンで弾いた曲です。#booth_pm で無料配付します。

tatmosさんによる特別音源調整あります!

photo: たろーさん

world: yukiさんhttps://t.co/W6G6giNreE pic.twitter.com/kk3zLp1Tew

弦にのってしまったノイズ

弦楽器とピアノの演奏音源で、

いくらかノイズのようなものが入ってしまっていた。

ピアノ側の通信ごしでの収録音のため、ピアノの音は普通に収録したような品質だが、

弦の演奏には通信時特有のじゃらっとした(ギターのディストーションに近いような かっかっか と速い針飛びのような鶏とか蛙の鳴き声みたいな)消せない特殊なノイズがのっていた。

非常にもったいないのが、弦の響きがかなり高い倍音がのるところにかぎって、通信量不足なのかノイズが載ってしまっている感じ。

なんとなく予想すると、時間方向の情報量が削られて、圧縮時の高い方の音がデジタルなノイズになっていた。 これはRXとかでもとれない系のノイズだったので、以下のアプローチでごまかすことにした。

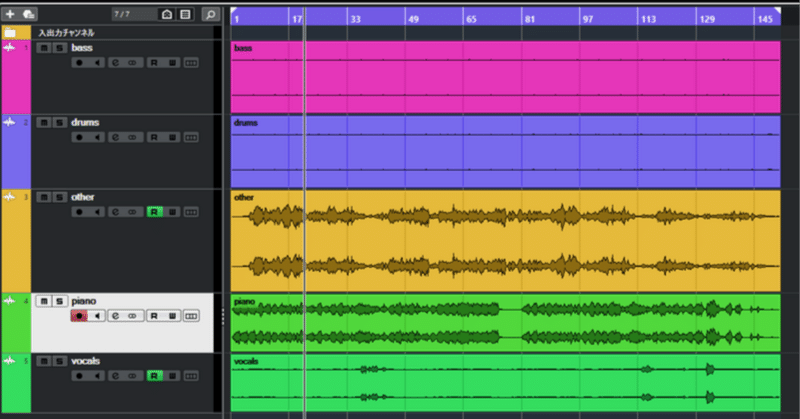

弦とピアノ音を分離

ピアノの音は劣化していないので、弦のノイズのあるトラックだけ処理できるのが理想的。

ので、まず、spleeterで音源分離で、ピアノとその他に分ける

pythonで呼び出すとできる。

分けた音源を見ているとピアノの音の低音のノイズ(ペダルの踏む音、低音の打鍵アタック音など)がOther側にももれているが、おおむね弦の音がとりだせている。

ピアノの方は綺麗に取り出せている。ピアノの音源分離の技術はかなり良い感じ。

弦の音は分離が苦手で、

一部ボーカルと認識されてしまっている。

もしかするとピアノの音もまざっているかもしれない。

弦と歌声は似ているし、ピアノの余韻部分のサイン波形に近い音と似る部分もあるし、なかなか分離が難しいのだろうか。

圧縮劣化を目立たなくする

圧縮劣化のごまかしは後からの処理ではかなり難しいので、脳内補完に頼る

弦のEQで

上下の帯域はカット。

ノイズ部分を削ってしまうことで、音は劣化するのだが、代わりにノイズが消える。

音の情報としてのノイズが消せることで、不要な情報がなくなりすっきりする。

人は聞こえている部分から、おそらくこういう音がもともと鳴っていただろうと予測して、さらには良い音がしていただろうとバイアスがかかることで

脳内で良い音に変換してくれる。

脳内で良い音に聞かせるためには余計な情報は省いた方が、負担が少なくて済む。

圧縮の目立つ高域ノイズ

圧縮劣化のデジタルで目立つのは、主に高い部分の帯域の再現度の劣化が原因

人間は高い音が聞こえにくい。

それにあわせて、圧縮アルゴリズムも高い方の情報量を削ろうとする。

高い部分の情報が削れても気が付きにくいという理由なのだが、

これが時々発生するみたいな、安定しない状態だと、

削ったり・削らなかったり という差分の方が目立ってしまう。

なので、高い方を削ることで、そのざらざら感を消せるのだが、

やすりをかけてしまうような感じで、表面のディティールも削ってしまうことになる。

これは、本来の伸びやかな響きを減衰させて、ちょっともったいない。

時間軸的に圧縮が動的に変化しているので、変化のかかったところだけかけるとかでもよいのだが、そうすると、途中で音質が変化している方が目立ってしまったので、てっとりばやく全体にかけてしまうことにした。

ディティールを後付けする

可聴域ぎりぎりの高い音の要素は空間の響き(部屋の響き)の要素が大きい。

実際の生の演奏であれば、演奏家との角度、弦楽器であれば、共鳴体とリスナーの位置関係などの情報も含まれるが、ネットワークごしの音のそれはマイクや部屋の環境などに依存する。

弦の音は高い音を削ってしまったので、

テープで録音したみたいに少し籠った音になってしまっている。

これを補うためにIRリバーブを追加。

これで情報を後付けだけど付与することができた。

今回は脳内補完優先のためやっていないが、

高い成分が存在しない音に高い成分が生成されることはないので、エキサイターなどをかけてあげても良かったりする場合がある。

ピアノを広げる

ピアノに関しては既に響きが多めなので、これ以上残響とか余計なことはせず、音を左右に広げて ステレオ感を広げた。

おそらく元はモノラルの音源(若干パンしているかも)くらいなので、

広がりを加えることで、情報量が増えて 良い音に感じる率があがる。

ピアノと弦という二人だけの演奏なので、対照的なミックスにすることで、脳の情報整理をしやすくしてあげる効果もある。

雰囲気としては、ピアノ演奏者視点の音になる感じ。

弦の音は中央よりに

逆に弦の方は音像はIRで広がっているので、若干中央に寄せてから

コンプなどはNeurtronまかせで若干Makeupとかいじるくらいでとどめた。

全体を聞いてちょっとだけ補正

曲の終わりの音はだいぶ小さい音なので、若干オートメーションで調整

Ozone10で全体の調整

ここまでやっても、よく聞いてしまうとノイズは残ってしまっている。

音源分離にありがちな音やせも発生してしまっている部分もある。

時間をかければもう少し調整はできる部分かもだが、ここら辺は将来のAI補正とかでボタン一つでできるような未来を望みます。

なんだか劣化したテープで録音したものを聞いているみたいな感じになってしまったかもしれない。

・・・

もし、ハイレゾ(素材の情報劣化を目立たせない)とする方向でなら、あえて、ノイズを追加するとかでごまかすとかもあるかもかな。(風の音とか空調的な音をまぜるとか)そういうアプローチもあるかもしれない。

(定常的に自然なノイズ音が混ざっていると人間の脳内側でノイズ除去してくれる) クラシックなので一部の世代の耳ではそういうのもありかも。

・・・

未来のVRセッション

演奏情報からリアルタイムに今回のような補正をしてくれるAI処理、

間にサウンドエンジニアがはさまって音を聞きやすくしてくれるような、且つ遅延が少ない みたいな未来像がありそうだなぁと思いつつ。

(マイクも特性違いとか複数立てたりとかいろいろ工夫しつつ)

この記事が気に入ったらサポートをしてみませんか?