Chat GPTはオカンの忘れたものを言い当てられるか (ミルクボーイのネタでその実力を検証してみた)

2023年最初のテクノロジー界隈の大ヒットトレンドといえば、Chat GPTで決まりであろう。OpneAIの作った賢すぎると話題のAIチャットボットだ。あまりにも賢いので、「人間の仕事をいよいよ奪うのではないか。」というような反応も各所で聞こえる。

果たしてそうなのだろうか。

「Chat GPTはどこまで人間の代わりができるのか」

この問いをミルクボーイのネタで検証してみたい。

ミルクボーイをご存知でない方に軽くご説明すると、

吉本興業大阪本部に所属する、

ボケ担当の駒場孝さんとツッコミ担当の内海崇さんからなるお笑いコンビである。結成は2007年で長い雌伏の時を経て、2019年のM-1グランプリで見事、王者に輝いた。

そしてここが重要なのだが、彼らのネタには下記のような基本フォーマットが存在する。

まずボケの駒場さんが「オカンが好きな朝ごはんの名前を忘れたらしい。」とネタフリ

↓

ツッコミの内海さん「どうなってんのよ。何か特徴を言うてみて。」

↓

駒場さん「甘くてカリカリしてて、牛乳とかかけて食べるやつやねんけどな。」

↓

内海さん「その特徴はコーンフレークやないかい!」

↓

駒場さん「いや、俺もコーンフレークと思っててんけどな…」

というような導入で、話が展開していき、

「コーンフレーク」部分が「最中」、「サイゼ」などに置き換わることでネタのバリエーションが作られているのだ。

(ミルクボーイのネタに興味のある方は下記リンクを後ほどご参照ください。)

この一連の流れは、さながらチャットによるQ&Aのようである。

であれば、ミルクボーイのネタにおける駒場さんのフリに対して、

Chat GPTが内海さんの代わりにきちんと「その特徴は○○やないかい。」

と回答できるかを検証することが、

「Chat GPTはどこまで人間の代わりができるのか」

の一つの基準になるのではあるまいか。

早速やってみよう。

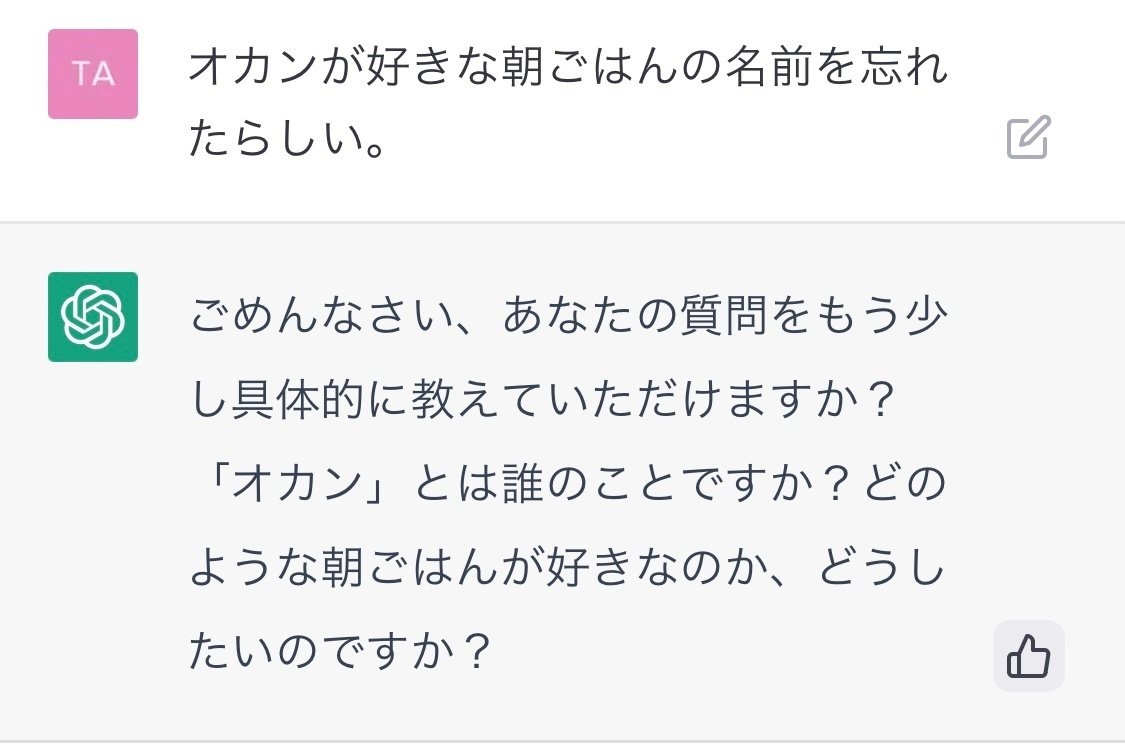

まずは冒頭でご紹介したM-1グランプリで爆笑をさらったネタ『コーンフレーク』から、最初の駒場さんのフリにできるだけ忠実な形でChat GPTに質問を投げてみる。

いきなり激詰めされた。

さすがに入りが乱暴すぎたので、言葉遣いを丁寧にしてみる。

おぉ、ちゃんとした会話が成立してきた…!

丁寧かつ原典(?)に忠実にコーンフレークの特徴を説明してみよう。

おぉぉ!これは正解と言ってよいであろう。凄いなChat GPT…!

続いて、同じくM1グランプリのネタ「最中」でやってみよう。

ネタ冒頭の流れは「コーンフレーク」同様で、

駒場さん「薄茶色のパリパリの皮で餡子を挟んだ和菓子やねんけどな」

↓

内海さん「その特徴は完全に最中やろ!」

という流れである。

果たしてChat GPTは今回も言い当てられるのか。

謎の深海魚をリコメンドされた。

しかも正解した前回より断言調なところを見ると、

Chat GPT的には自信があるらしい。

他に考えられる候補はないか訊いてみよう。

全く「あんこう」を離れてくれない。

ChatGPT的にはこれしかないと確信しているのであろう。

「ん?ボクの言う事訊いてなかったかな?」的なテンションを感じる。

ちなみに、

(これ、もしかすると「あんこう」っていう最中そっくりな別の和菓子があるのかもしれない…)

と思って調べた結果、唯一ヒットしたのがこちら。

おもいっきり深海魚フィーチャーの限定和菓子だった。

見た目も最中とぜんぜん違うな…。

そもそも表面はパリパリの皮どころか、

深海魚同様、粘液(みたらし)でコーティングされている。

このままでは埒があかないので、

知人ということにしてツッコミの内海さんにご登場を願う。

めっちゃ上からだなChat GPT…。

アメリカンな(しらんけど)切り替え力を感じる。

さすが、マイクロソフトも大金をぶっこんでいる話題のAI。

性能だけでなくプライドも高そうだ。

最後にミルクボーイの数ある漫才の中でも、

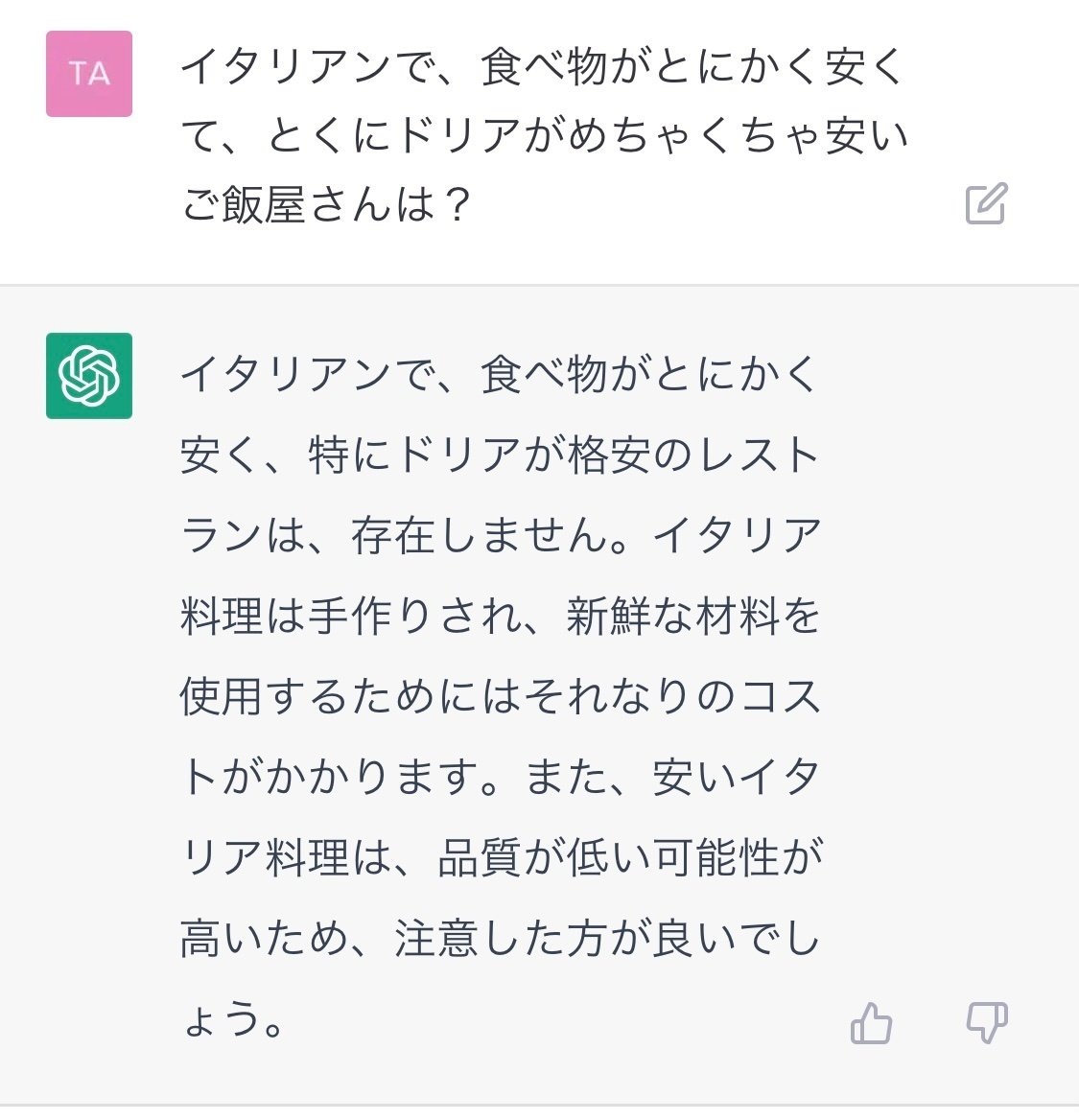

私が個人的に好きなネタ、「サイゼ」を検証してみよう。

念の為、ご説明するとサイゼは皆さんご存知、イタリアンチェーン店のサイゼリアである。

今回の検証では初めての固有名詞となるが、果たして。

ちょっと待てChat GPT。俺たちのサイゼをディスるんじゃない!

日本の食品冷凍技術なめんなよ。

そうか、お前ミラノ風ドリア食ったことないんだな。

来日したら真っ先に連れてってやる。

結構ウマいんだぞーーー!!!!!(東京03角田さん風に絶叫。)

================================

================================

================================

色々と引っかかる部分はあるものの、彼(Chat GPT)が非常に優れたチャットボットであることは疑いの余地がない。

他ブログでも言及されているが、文章の~~っぽさ、

を変更するも彼の得意技だ。

試しに「最中」をリコメンドする文章を

岸田総理大事、田中真紀子さん、トランプ前大統領、バイデン大統領

っぽくしてくれ、というオーダーをしてみたら、見事にやってのけた。

(後半二人はどこまで似てるかよく分からないけど、発言の出だしなどにそれぞれがよく使う表現が混ぜ込まれているっぽい。どっちもIt's a winner. / Trust me.って言ってるのが面白い。)

一方で、過信しすぎるのは良くなさそうだ。例えば「東京の赤坂駅周辺のお勧めの居酒屋」を訊いて出てきたのは、全て架空の店名とURLだった。

これも各所で言われていることだが、このようなチャットボットを使うには、その回答が正しいかどうか分かる、あるいは検証できるリテラシーが常に使い手に求められる、ということだ。(少なくとも現状は。AIが出した回答をファクトチェックするAI、みたいなものも今後出てくるだろう。)

また、もう一つ重要なのは、

彼らに向けてどんな問いを発するかは人間に委ねられている、ということだ。

実際に使ってみて分かったが、聞き方の微妙な差でChat GPTの回答は大きく変わってくる。

冒頭のコーンフレークも、実は一発で当てられたわけではなく、ほとんど同じような聞き方をしたにも関わらず、最初の質問で出てきた回答は「牛乳かけた米粥」だった。

問いを発し、回答を検証し、選択肢から選び取る。

この3つは当分、人間の領分だ。そしてこれは、それなりにスキルが求められる領分でもある。AIに任せるためには、ディレクター的な指示・判断のスキルを人間は全員高めなくてはいけない、ということでもあるだろう。

この記事が気に入ったらサポートをしてみませんか?