「AIイラストって絵の勉強になる…?」取材を受けて考えたあれこれ

こんにちは、AI絵をやってたらいつのまにか人並みに絵が描けるようになってたおじさんです。前回の記事が微妙にバズったところ、美術関係の教育者の方から「AIで絵を学ぶのってどういう感じですか?うちの学生にもできますか?」というお問い合わせを相次いで頂きまして、今日は質問にお答えする中で考えたことをAI技術の進歩の振り返りとともに記事にしてみようと思います。

前回の記事( ▲ )を書いたのが今年3月のこと。その後、美術系の大学と専門学校、予備校の方から別々にDMを頂きまして、それぞれウェブインタビューのような形で1~2時間ほどお話ししました。インタビューの内容は、おおむねどの方も「これからの世代に美術を教える上で、画像生成AIについて触れないわけにはいかない。どのような距離感で扱えばよいのか決めかねており、実際に体験しているユーザーに話を聞いてみたい」という趣旨だったかと思います。

インタビューでいろいろ質問していただく中で、「画像生成をやっていて、自分の中で起きた変化はいったいどのようなものだったか?」ということを改めて考えてみたのですが、前に比べて優れた線が引けるようになったわけでもないし、デッサン力がついたわけでもない。変わったのはどうやら、「画像を目で見て言語化する感覚」や「なぜ自分の絵がダメなのか理解して修正する力」の方だということに気づきました。

振り返ってみて特に面白かったのが、AI絵の技術発展をリアルタイムで味わう中で、「前景と背景」についての考え方が段階的に大きく変化していたこと。そこで、今回はAI絵と背景の関係について着目しながら、AIイラストで遊んでいたおじさんに起きた変化について、ありのままに掘り下げてみようと思います。

※いつもの注意

「絵が描けるようになる」と書きましたが、これは「人並みに」が前につきます。別に私は「上手に」絵が描けるようになったわけでは全くなく、前回の記事でも冒頭で注意書きしたように、今回も「絵を学ぶなら画像生成AIを触ろう!」みたいな趣旨ではありません。イラストレーターになりたい方、真剣に絵を学びたい方は、最初からAIなんか触らないで普通に絵を学びましょう。

こちらのタイムラプスは、最近の技術で私のラフをオート線画化し、それを自力でグリザイユ塗りしたもの。動画の最初の部分を見ていただくと、おおむね私のリアルな実力が出ているかなと思います。

🐺✨ #漫画メダリスト pic.twitter.com/Ob0d9Xv2CX

— 賢木イオ🍀AIイラスト (@studiomasakaki) May 31, 2024

で、去年の9月がこれです。はい。

画像生成AI登場「絵が出せてスゲェ!」期

振り返ってみると、日本でNovelAIが登場した2022年10月~23年2月ごろ、「背景と前景を分けて考える」ということは全くしていませんでした。

そもそもそれ以前に、建物のパースや指の増殖など、細部に妙なところがあっても「AI絵ってそういうもの」としか考えていなかったように思います。とにかくリッチであればよい、リッチな絵が出せるAIスゴイ!という時期ですね。

このころは「AI絵は描き込みが多く、リアルで高精細なほど良い」と普通に思っていたので、背景も当然リアルであるほどスゴイと思っていました(ぱっと見リアルっぽければよいだけで、正確性はほとんど気になっていなかった)。「キャラクターと背景を別々に生成して組み合わせてみよう」という発想すらありませんでしたし、おそらく実行しても全く馴染まず失敗したでしょう。

ついでに言うなら当然、自分でお絵描きをしようという発想なんて全くありませんでした。

Controlnet登場「写真を背景にできる!」期

2023年2月に、革新的技術である「Controlnet」が登場しました。それまでは「呪文を練る」か「既存絵を改変する」しか選択肢がなかったところに、突如

・線画で指示する

・写真を読み込ませて同じポーズのイラストを生成する

・ある絵のカラーだけを変更する

・背景だけを描いてもらう

・絵の一部を読み込ませて存在しない『続き』を描いてもらう」

…といったオプションが無数に生まれ、おじさんは驚愕しました。

とはいえ、操作する自分がまだ「絵というものは描き込みが多くてリアルで高精細だとすごい」「キャラが似ていればすごい」くらいにしか考えていないので、絵作りの方向は基本的にそちらを向いていました。いまこの絵を見るとまあ…無数に文句が出てくるんですけども…当時は「これができるようになった!」というところにわくわくして、大喜びしていたように思います。

当時、こんな実験もやってみました。

画像生成AIができるようになったこと🤖📷

— 賢木イオ🍀AIイラスト (@studiomasakaki) May 5, 2023

New capabilities of image generation AI#AIart pic.twitter.com/3QUobEW1Es

自分で撮影した写真を線画化して、AI絵にして、そこにキャラクターを配置してなじませるわけですが、これが多分初めて「背景をキャラと別に作る」という体験だったように思います。当時は「何がどう描かれているかより、この絵で何を伝えたいのかが重要」という当たり前のことが全く頭にないので、「キャラクターが写真の中にいたらすごいじゃん?」のレベルでした。

ちなみに全くバズらなかった

Lama Cleaner登場「いらないモノを消せたら最強じゃね?」期

2023年春ごろ、「Lama Cleaner」が界隈で流行しました。AI絵に必ず映り込む訳の分からないオブジェクト(空中に浮かぶリンゴとか)をなぞるだけでぱっぱと消せるので、おじさんは「これで意図に満ちた絵が作れる!」と喜んでいました。お前絵の意図なんて考えたこともなかっただろ

いまこの絵を見返してみると、本当に問題なのは空飛ぶリンゴや7本指だけではないわけですが、このころはまだ破綻の有無くらいしか絵の欠点を見つけられる状態ではないので、「AI絵にありがちな破綻を全部消したら完璧になっちゃうのでは…?」くらいに受け止めていました。いっちょまえに粗密や視線誘導の概念をネットで調べて「勉強になるなあ」などと考えていたように思います。

マネタイズ勢激減「あれ?白背景の方がバズってるな」期

さて、おじさんが歌舞伎座の写真をAI絵にして喜んでいた次の週、低劣なAI絵の大量投稿に業を煮やした国内プラットフォーム(ファンティアやPixivFANBOX、Ci-en等)が、AI絵の禁止を言い渡しました。この影響で、主にお金稼ぎ目的で美少女AI絵を連投していたユーザーがどっと減り、TLの趣味ユーザーの純度が上がったように思います。

このころ、どうもはっきりしてきたのが「画面全体が豪華でなんとなくエモいAI絵より、白背景のAI絵の方が明らかに伸びてない?」ということ。自分の絵でも他の投稿者の絵でも、「ぱっと見でなんかスゴイ絵」より「メッセージ性がシンプルな絵」の方がはっきりと反応が良いのです。おや?

背景がないとAI絵独特の破綻も目立ちにくいので、「手描き絵と誤認されてバズっているだけでしょ?」という考え方もあるのですが、正直ぱっと見た感じの感想として、豪華な背景に埋没している描き込み豊かな半リアル美少女より、キャラクターだけがドンと置かれているシンプルな構図のほうが見やすくてかわいさが伝わってくるわけです。

PC内に残っているデータから具体的に例を出しますと…

TLで死ぬほどいっぱい見たこういう絵が全く伸びなくなり、もっとフラットなアニメ塗りの絵に流行がシフトしたのですね。いわゆるマスピ顔(※)ではもう興味を持ってもらえないということもはっきりしてきました。

【マスピ顔(-がお)】ある学習済みモデルで普通に生成すると出てくる、そのモデル固有の顔立ちのこと。学習内容やモデル学習者のチューニングによって自然に生じる。(上の画像は典型的なマスピ顔)

生成されるキャラクターの容姿に一貫性を持たせるのに便利ではあるものの、人気モデルのマスピ顔はTLに氾濫するので、意識して外せるようにならないと、いかにも無個性の「AIっぽい絵」になる。

このあたりでようやく「高精細×リアル=素晴らしい」という発想が頭から抜け、多少低劣化しようとも、自分由来の成分をしっかり込めないと面白い絵にはならないという発想になったように思います。AI絵を自分でがんばって模写して、Controlnetで着色してもらい、マスピ顔ではない絵作りを目指すようになりました。

NovelAIv3登場「キャンバス全体で意図を表現しよう」期

ハウツー本をたくさん読むようになったのはこのころです。「キャラクターを見せたいなら主張の激しい背景はむしろ邪魔で、自分できちんとディレクションして前景と背景が相互に高め合う背景が作れないなら、白背景の方が1000倍マシ」ということが体感的に理解できるようになってきました。

AIに背景を描かせてもよいのですが、破綻のない背景を出してキャラクターと溶け合わせるのはものすごく難しい。AIが出してくる「ぱっと見高精細だが、よく見ると意味の分からない間違い探しみたいな絵」を加筆でなんとか修正していたのがこの時期です。

このころ、国内ではDALL-E3やNovelAI v3といった新世代の画像生成サービスが相次いで登場していました。DALL-E3は学習データが美少女イラストに偏っておらず、Hな絵や版権絵がブロックされる上、無料で使えるとあって、23年5月のマネタイズ禁止で激減したユーザー数が、このころまたぐっと増えた体感があります。美少女絵に特化していないかわりに、自然物や無生物、小物などをより正確に、自然言語で指示できるのもDALL-E3の強みでありました。

DALL-E3にももちろんマスピ顔はあるが、さほど偏りにくい

NovelAIv3(バージョン3)は対照的に、日本風のアニメ調イラストを再現することに特化したモデルで、H絵も版権絵も出すことができました。本当に凄かったのはそこではなく、異次元のインペイント能力のほう。Controlnetの複雑な知識が全くなくても、なんとなく塗りつぶしてなんとなく指示するだけで、誰でも思った通りの変更を加えることができるようになりました。

ざっくり変更したい部分を塗りつぶすと自然にポーズ変更できた

DALL-E3の背景描写力と、NovelAIv3の破綻修正力が合わさったことで、「破綻の少ない背景を描かせる」「AI絵の破綻を人間が指摘し、AIに正しく描き直させる」ということがようやく実用レベルでできるようになってきたわけですね。

余談ですが、NovelAIv3の登場以前からPhotoshopには「生成塗りつぶし」機能が搭載されていましたので、AdobeFireflyを使った画像の一部の修正は可能ではありました。ただ、学習内容からして日本のアニメ調イラストが超不得意だったため、AIイラストの修正用としては実用レベルではなかった…というのが正直なところでした。

これはこれで味があるが

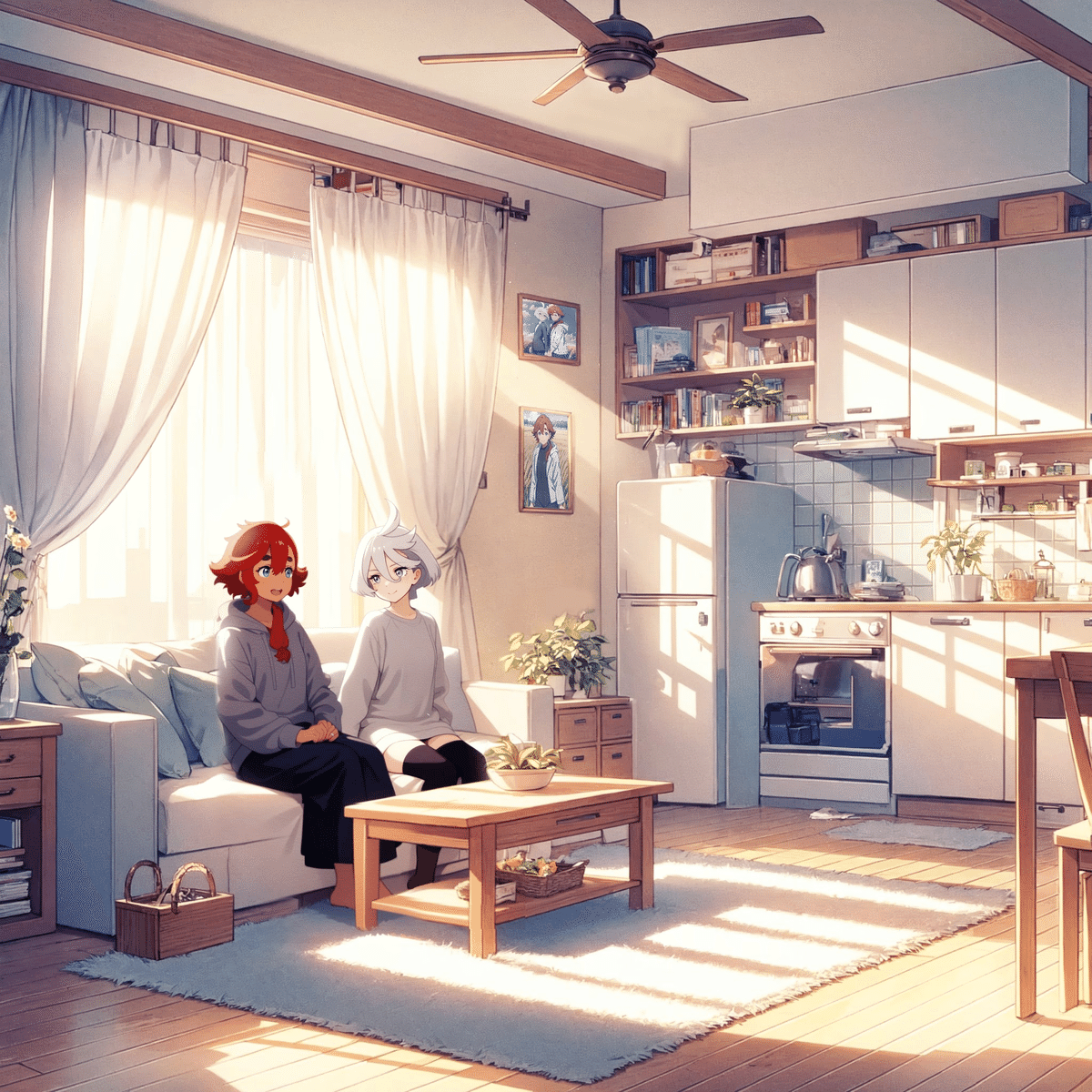

「背景が先・キャラクターが後」

v3インペイントに感動したおじさんは、これを使ってどんな表現ができるようになったか毎日明け方まで研究していたわけですが、このころ「破綻のない背景絵を先に作り込んで、そこにキャラクターをインペイントする」という手法を考え付きました。キャラクターと矛盾しない背景をあとから生成するのは難しいので、先にDALL-E3で背景を作ってしまって、そこにNovelAIにキャラを描き込んでもらおう…という発想です。

壁の写真を合成したり、ちょっとした遊びを入れると楽しい

通常のAI絵の作り方とは逆順の発想だったので、新鮮に見えたらしく、このシリーズはすごくSNSでも受けました。自分の中でも、背景のちゃんとあるイラストでキャンバス全体を意図通りに作ることができたのは初めての体験で、このAI絵を作れたときのことはすごく印象に残っています。

AI絵において「キャンバスのすみずみまで、自分の意図しない描写がない状態」にすることは相当大変なことです。単純に「意図しないオブジェクト」にAI消しゴムをかけていけば「意図のある絵」になると私は思い込んでいたわけですが、最初にしっかり頭の中でイメージしたものをAIをうまく使って再現しないと、初めてそのイラストを見る人に私の思った通りの感想を持ってもらうことは難しい。そういう当たり前のことがくっきりしてきた時期だと思います。

AI漫画期

さて、2023年の暮れから今年の春に掛けては、前回の記事でも書いたように、AI絵の瞳の加筆修正にずーっとハマっていました。

ここ一年の瞳のレタッチ変遷

— 賢木イオ🍀AIイラスト (@studiomasakaki) December 24, 2023

来年は3と4の間くらいで、自分らしい瞳を描けるようになるぞ! pic.twitter.com/C38o2FaIMh

これは「AIが描く瞳の意図のなさをまず消さないと始まらない」ということが分かってきたからでもありますが、単純に推しの目を塗るのがめちゃくちゃ楽しかったんですね。ほとんど目しか塗っていなかったはずなんですが、いつのまにか手描きイラストが少しできるようになっていたので、今度は漫画に挑戦してみることにしました。

AI漫画にはNovelAI登場時に挑戦していたのですが、当時は意図通りの絵作りをすることができず、マスピ顔AI絵がコマのかたちで続くだけの紙芝居みたいな作品になってしまったので、どれくらい進歩したのかもう一度挑戦してみたわけです。当時はフリーレン人気が大爆発している時期で、断頭台のアウラが現代日本に転生するAI絵を投稿したらすごくRTされていましたから、ちゃんとコマ割りをして漫画にしてみよう、と思って作ったのがこちら。

⚖第1話「ありえない」#葬送のフリーレン #異世界転生アウラちゃん pic.twitter.com/bpu41STYN8

— 賢木イオ🍀AIイラスト (@studiomasakaki) April 17, 2024

#異世界転生アウラちゃん 第2話「この私が」(1/3) pic.twitter.com/zyRLSrBzD6

— 賢木イオ🍀AIイラスト (@studiomasakaki) April 27, 2024

この漫画は、基本的にはさきほどのリビングのイラストと同じで、DALL-E3とV3インペイントの複合でできています。ネームを描く力や書き文字などのスキルがド素人なので、見苦しいところも多かったと思いますが、それでも反響が予想外に大きく、フリーレンとアウラ人気のものすごさを感じました。(多分過去一番バズりましたが、私の手柄では全くないです)

漫画をやってみると、「意図のある背景」というのがいかに大事か、イラストをやっていたときよりも理解できました。キャラクターのいる場所や状況を俯瞰で示したり、逆に風景ではなく心象を描いてあげたり、あえて省略したりしなければ、読者には状況がうまく伝わらないわけです。一コマ一コマがそのコマに求められる用途を満たしていないといけないので、まず「普通に読める漫画」にするハードルがめちゃくちゃ高いことが分かりました。

第二次写真×イラスト期

もうここまでくると先月の話。漫画がすごく大変だったので、いったんイラストに戻ってくることにして、V3インペイント技術と漫画で得た知見を掛け合わせてみようと考えました。

最初は現在の技術で、写真をAIイラスト化することを試していたのですが、意図を満たすことを改めて考えてみると、「なじんでさえいれば、背景はあえて写真のままで良いのではないか」ということに思い至り、日常風景にスレミオ(私の大好きな"機動戦士ガンダム 水星の魔女"の主人公2人)を現出させる幻覚シリーズにしばらくハマっていました。

🚃 #水星の魔女 pic.twitter.com/GQ1h7v7lJu

— 賢木イオ🍀AIイラスト (@studiomasakaki) May 23, 2024

NovelAIのインペイント力はものすごく、全く画風が違ってもこのようにキャラクターを溶け込ませることができます。スマホでぱっと作ったポン出し(いっさい手修正を加えない生成物そのまま)でも、これくらいの精度が出せました。

スレミオ幻覚シリーズ pic.twitter.com/9JRCXMEpcA

— 賢木イオ🍀AIイラスト (@studiomasakaki) May 25, 2024

一方で、ちゃんとAI絵に自分で手を入れて、意図通りのイラストに仕上げることも頑張ってやっていました。こちらは、左のAI絵を基に、サイゼに来たスレッタちゃんのイラストに仕上げたもの。

最初はサイゼリヤで撮影した写真の中に溶け込ませることを考えたのですが、意図に沿わない無駄なディティールが悪目立ちしてしまったので、写真を使わずに自分で「サイゼリヤ風のあれこれ」を作ることにしました。背景は緻密だったり、正確だったりすればよいわけではなく、その絵で伝えたいことを邪魔しない、「用途」を満たす背景かどうかが重要なのだということが改めて分かったように思います。

キャラクターより背景に目が行って散漫な絵になることが分かり、ボツに

AI-Assistant期(現在)

24年5月は、とりにくさんのお絵描き補助アプリ「AI-Assistant」が登場した月でもあります。

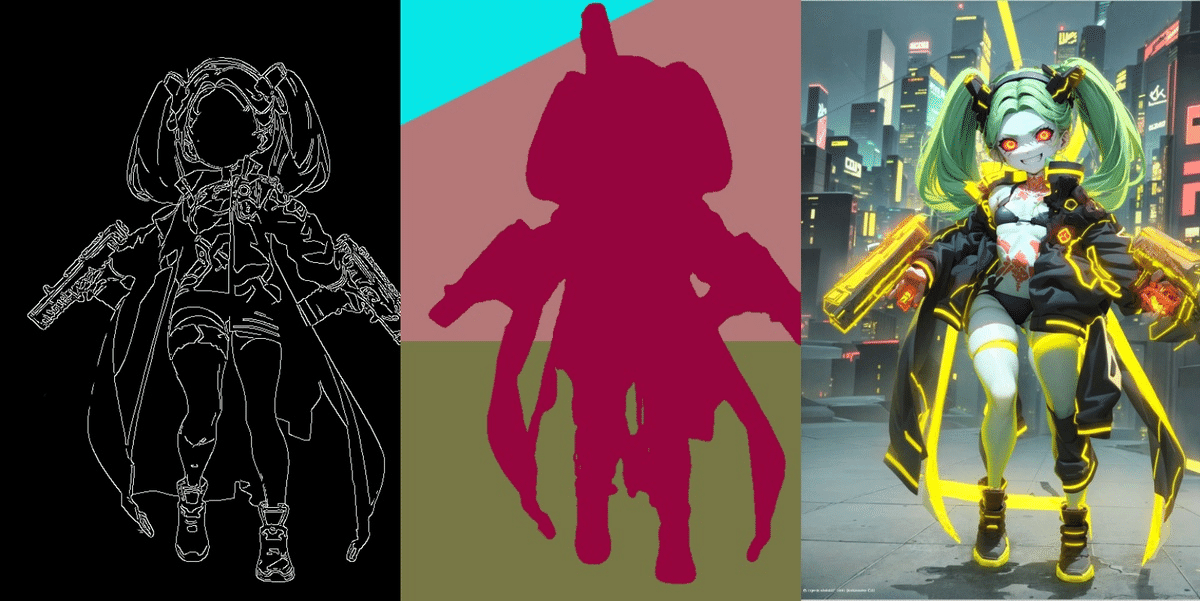

これはStableDiffusionXLや各種Controlnet、LoRAを内包した単体で動くツールで、手描きした落書きを放り込むと「オート線画化」と「オート影付け」が簡単にできるという革命的な機能を備えていました。インストール方法もユーザーインターフェイスも非常にシンプルで、操作できるパラメータはあえて必要範囲に限定しているため、私のアレな画力でもこのようなことが簡単にできるようになりました。

ラフのオート線画化、オート影付けができるAI assistantを使ったグリザイユ画法

— 賢木イオ🍀AIイラスト (@studiomasakaki) May 26, 2024

たぶん1時間掛からなかったです pic.twitter.com/XoIhMFqa7h

AI-Assistantを使ったAIお絵描きは、初心者に絵をあきらめさせる「あんなに時間を掛けたのにすごくヘタな絵ができあがった…」というガッカリ体験の心配がなく、お絵描きの楽しいところだけ味わえるのが素晴らしいところ。きちんと絵を学んで画力を鍛えたい人、将来クリエイターを目指している人には不適かもしれませんが、余暇にお絵描きっぽい体験をして楽しみたいだけのエンジョイ勢にとっては、ペン入れなどの技術的なカベをパスできるのは本当にありがたいです。

背景の話に戻ると、私の画力ではAI絵の模写でキャラクターのラフはなんとかできても、自分で意図のある正確な背景を描く力は全くない(せいぜいサイゼリヤっぽい背景やテーブル上の小物をコラージュするくらい)ので、なんとなくエモそうなグラデーションやカラーを置くことから始めることにしました。

虹#水星の魔女 pic.twitter.com/EVXPnNTxxD

— 賢木イオ🍀AIイラスト (@studiomasakaki) May 27, 2024

「背景が描けないから、なんかエモい色を塗ってそれらしくする」というのは、たぶんお絵描きの初心者が必ず通る道なのではないかなと思います。私は非常に迂遠なルートを通って、1年半以上かけてお絵描きのスタート地点にようやくたどり着いたと言えるのかも。とはいえ、それらしい色が塗れるのはひとえにClipStudioとアセットのおかげなので、塗りは全然下手くそのままです。

SDXL用Controlnetの進化

ところで、AI-Assistant登場の背景には、今年5月以降、国内の個人ユーザーから優秀なStableDiffusionXL用Controlnetが相次いで発表されたことがあります。特に、追加学習の天才・月須和さんの革新的Controlnet「Anytest v3」の力はすさまじかった。ラフの線画化・着色・インペイント・質感変更といったことがなんでも簡単にできてしまうので、界隈に衝撃が走りました。

これをフルに使うと、このようなことができるようになりました。

Anytest v3を使ったオート線画化・オート着色です

— 賢木イオ🍀AIイラスト (@studiomasakaki) June 8, 2024

AI部分の苦労がタイムラプスに映らないw pic.twitter.com/ds3KOj0PTN

これは、ポーズマニアックスを使って姿勢のアタリを取り、ラフを描いてからAnytestで線画化、クリスタでゴミ取りをして、間違っているところをインペイントで直して、Anytestでオート着色、さらにおかしいところを自分で塗り直して仕上げたものです。アスカの絵をControlnetでいじいじしていた頃に比べると、各段にできることが増えた感覚があります。

これからできるようになると良いなと思っているのは、自分で背景ラフを描いて、それを漫画に使えるレベルで線画化すること。そのためには、まず自分の画力やパース知識をつけることも必要なのですが、背景に強いモデルとCNの合わせ方を検証するなど、AI操作面の研究が必要かなと思っています。

月須和さんのCN-anytest_v4-marged、背景もいけます。 数値適当にやってもこのマウス線画ラフ絵からこれができてしまう。 ScribbleとしてもLineartとしてもinpaintとしても使えそう pic.twitter.com/ANU0VmFlcD

— 野火 城@AI漫画 (@nobisiro_2023) June 4, 2024

今度はこうした技術も活かして、異世界転生アウラちゃんの続きを作れるとよいですね。アウラちゃんのアパートの大家が出てくる予定なのですが、キャラデザがなかなか決まらず往生しています。

まとめ(2024.06.10追記)

冒頭のインタビューの話に戻りますが、ここまでのような話をお伝えしたところ、皆さまの反応としておおむね共通していたのは、「賢木さんは画像生成AIのおかげで絵がうまくなったというより、もともと物書きで言語化能力と外部知識の習得に長けていたことが大きいと思う」というものでした。(最初はこの話を恥ずかしくて省いていたのですが、やはり書いておかないと記事の趣旨として欠格だなと考え直し、追記します)

美術系の進路に進む学生さんには、高い言語化能力を背景に才能を発揮している方もいれば、言語化できないからこそ美術で表現する方向に特化した方もいるそうで、教育者側としては後者の指導が難しいのだとか。お声がけ頂いた方々は「そうした学生の指導に画像生成AIが役立つのではないか?」と期待されていたようですが、ウェブインタビューは毎回「結局本人の言語化能力を伸ばさないとダメですよね…はぁ…」という感じの結論で終わっていました。(すいません…)

全く絵の知識のない限界中年がAI絵を触って気付いたあれこれを美術教育の観点から見ると、

なんでもかんでも描写や書き込みを盛ればいいわけではない

かといって、悪いところを剪定していけば「良い絵」になるわけでもない

高品質になるからといって全てAI任せにしてもつまらない

自分由来の面白さをきちんとディレクションして明快に伝えることが重要

それさえできていれば、見た目のクォリティはそこまで重要ではない

自分の「好き」を、鑑賞者にも「好き」と思ってもらう文脈作りが「絵」

…ということを、段階を踏んで座学と体験で理解していったということになるようです。確かに、昔投稿していた絵を今見ると「なぜつまらないか」を当時よりずっと言葉で説明できるようになっていると思います。

ただ、AI絵が全く意味がなかったかというとそうでもないようで、「集合知ではこう描くのね」というお手本をずっと見ていくことで、そこから外れた表現を見つけやすくなる効果があるそう。最初私はそれを「低劣」だと思っていたわけですが、それこそ「個性」だったわけで。「鑑賞を邪魔しない程度の品質を担保しつつ、自分由来の個性をしっかりと出して、どんな鑑賞者にも意図を太く明快に伝えられるようになること」がイラストや漫画の上達においてとても重要なことなのかなと思ったのが、今回インタビューを受けて思った結論でした。(まとまった!)

終わりに

毎度おじさんの怪文書を読んでくださって、ありがとうございました。ここ最近はPCを全く使わない手描き(アナログお絵描き?)も楽しくなってきていて、子供が飛行機でもらってほっぽらかしていた小さいスケッチブックをもらって、鉛筆でラーメンハゲの絵を描いてみたりしています。

結構描けるぞ https://t.co/B6BZWSLTwv pic.twitter.com/XVQ18ZU1sT

— 賢木イオ🍀AIイラスト (@studiomasakaki) June 4, 2024

下手っぴではありますが、パソコンを使わなくても意外に描けるようになっていて楽しい!おじさんになってからこれまで全くやっていなかったことを勉強すると、スタート地点が幼稚園生レベルだっただけに、すごい速さで学習できていいですね。お世辞にもうまいとは思いませんが、もう「自分は絵が描けない」と言いにくいレベルにはなれたなと嬉しく思っています。

とりにくさんにご協力していただいて、私の画風を1枚絵から抽出してLoRAにし、AI絵を「賢木絵」にする実験などもしてみました。学習元が1枚しかないのでふんわりしか似ないのですが(笑)、ゆくゆくはこういう手法でも自分らしい絵作りができるようになっていくと面白いなと思っています。

←いつものミナちゃん / 賢木イオ画風LoRA適用→

— 賢木イオ🍀AIイラスト (@studiomasakaki) May 30, 2024

プレーンなAI絵(マスピ顔)と、それを賢木が自由に模写した手描き絵を用意して、その2枚の差から抽出された「賢木イオ成分」をLoRAとして適用してます https://t.co/nB8galvOMJ pic.twitter.com/XJQwedjdir

相変わらずAI絵で遊んでいると毎日誹謗中傷がすごくてしんどいのですが、こうして自分のやってきたことをときどき振り返ってみると、おじさんの余暇の楽しみとしてはなかなか面白いことをやってきたなあという感じがします。特に「AI-Assistant」はその後「V3」に進化し、StableDiffusionの知識がなくても直感的に使えますので、ぜひ触ってみてくださいね。

さらに、高価なグラフィックボードがなくても無料でラフを線画に整えてもらえる無料アプリも提供されています。

私は線画化も影付けも着色も、こうしたAI補助アプリにお願いしていたんですが、このところAIにやってもらっていた作業をちょっとずつ自分でやってみるようになりました。素人がやる分クオリティは下がるし時間がかかるけど、AI独特のミスや変形、溶けがない分、人間がやったほうが手っ取り早いように感じます。所要時間だけでポン出しと比べると、当然ポン出しの方がくらべものにならないほど早い(しかも大量生産できる)んですが、自分の思った1枚を作っていくことにこだわるなら、できるだけ人間が作業したほうが近道なようなのです。

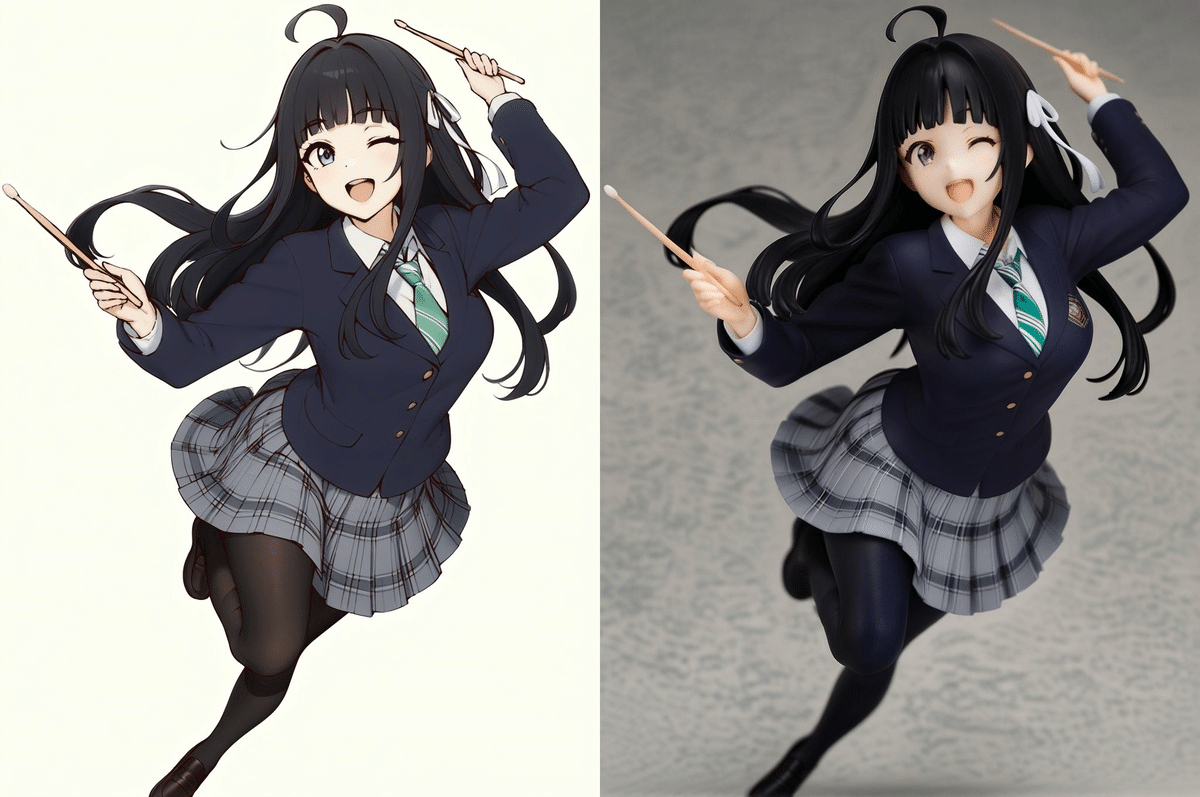

例えばこのイラストは、ラフからのペン入れ(線画化)のみにAIを使っていて、他は塗りも含めて自分でやっています。タイムラプスを見ているとものすごく迷いながら何度も描き直しているんですが、いろいろ試行錯誤する中で考えがまとまったりアイデアを思いついたりするので、これはこれですごく楽しい作業でした。

最後までめちゃくちゃ悩んで迷走するタイムラプス

— 賢木イオ🍀AIイラスト (@studiomasakaki) June 22, 2024

線画化のみAI使用です pic.twitter.com/fDUBqb345o

まだまだ稚拙ですし、いろんなことをごまかしている絵なんですが、もとの実力と見比べるとできることが大幅に拡張しているので、一人で大喜びしています。ガルクラはいいぞ…