【網羅】Stable Diffusionの基本をマスターし自慢できるAIイラストを作ろう【SDXL対応】

初めてStable Diffusionを使う方が、自慢できるAIイラストを作れるようになります。

・基本操作から主要機能の全解説

・プロンプトの基本知識と頻出の30個紹介

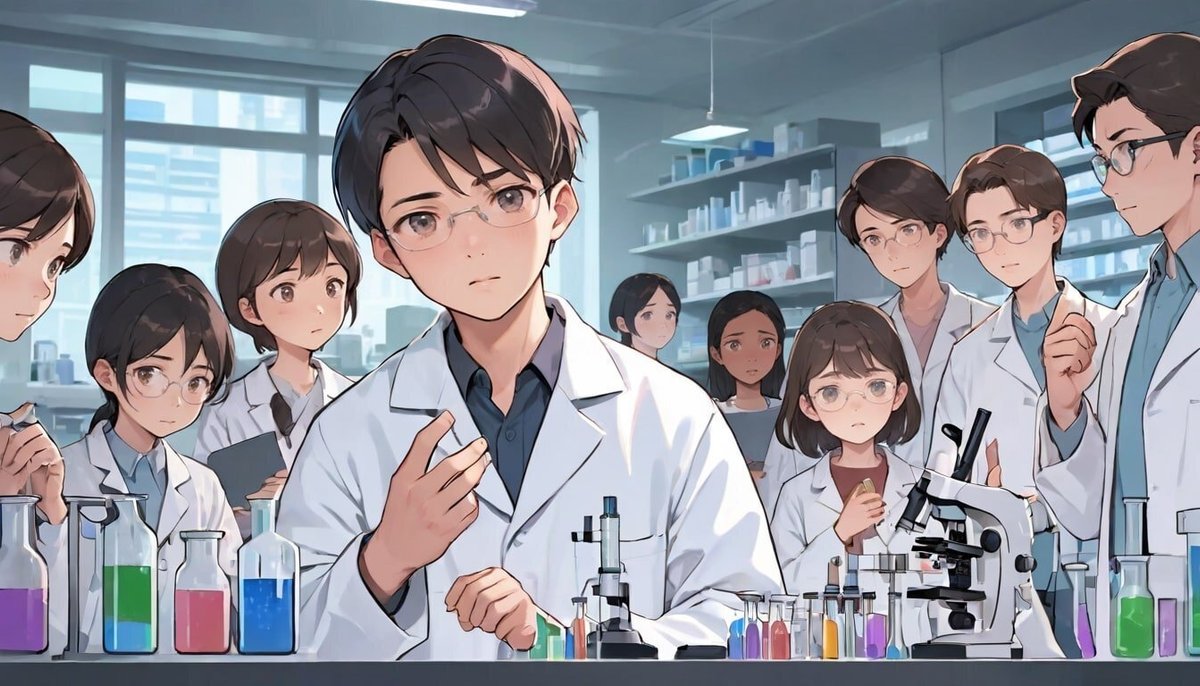

・崩れた顔の自動修正

・ChatGPTの活用

・LoRAで描く特殊な絵

・上手い人を真似る方法

・コピペOK プロンプトのテンプレ90個以上(別記事)

・クオリティの上げ方

など、まとめて解説しています。現在5.5万文字。始め方編はこちら。

より分かりやすい動画版はこちら。時間を節約したい方にオススメです。note版では、無料で視聴できます。

■この記事の使い方 ■

この記事は、

・最新版で高品質なStable Diffusion(SDXL)

・まだ現役で有名なStable Diffusion(SD1.5)

を比較しながら、基本を体系的に習得できるという内容です。

内容は、以下のとおり。

✓0.復習(スキップOK)

はじめに復習として、以下の解説をします。

・Stable Diffusionの特徴

・メリット・デメリット

・他の画像生成AIサービスとの比較

・AIマンガの現状

・SDXLの特徴

・SDXLとSD1.5の比較

✓1.Stable Diffusion画面の見方・使い方

・プロンプトの基本知識

・画像サイズの変更方法

・絵を微調整する方法

・絵に変化を加える方法

・クオリティの上げ方

・より高度な使い方

・絵の修正方法

などを学びつつ、テキストから画像生成の基本を習得します。

画像から画像を生成する方法、いわゆるimage to imageも解説するので、絵の修正も可能です。ここまで見たら、画像生成AIの基本が分かり、脱初心者できています。

✓2.クオリティを上げる方法 ①

次に、クオリティを上げる方法として、以下の解説をします。

・顔を自動修正する方法

・4つの参考になるオススメサイトの紹介

・ChatGPTの活用方法2つ

✓3.よく使うプロンプトをまとめて紹介

ここでは、

・光や照明

・カメラ

・色合い

・品質

などのプロンプトが、どのように絵に反映されるかを、30個以上の具体例で解説します。同時に、SDXLとSD1.5の比較もします。

また、動画講義の方では、90個以上のAIイラスト作品のプロンプトを公開しています。ここに記載されているプロンプトは、自由に使ってもらって大丈夫です。

✓4.LoRAの使い方

次に、LoRAの始め方・使い方を解説します。特殊な絵を表現したい場合に有効です。

✓5.クオリティを上げる方法 ②

クオリティを上げるには、まずは真似ることが重要だと思っています。ここでは、画像からプロンプト推測方法を使った、上手い人を真似る方法を解説します。

以上が、この記事の概要です。さらにAIイラストをコントロールする方法として、ControlNetの記事も用意してあります。近いうちにアップデートもする予定です。

始め方の記事と合わせて、実際に画像生成を試しながら学んでください。以下、本題です。

■ 復習(スキップOK) ■

■ Stable Diffusionで、何ができる?特徴とメリット

Stable Diffusionを使えば、以下のことができます。

・テキストから画像の生成:イラスト風やリアル風など、あらゆる画風や絵柄の再現が可能。

・画像から画像の生成:オリジナル画像をもとに別の画像を生成したり、オリジナル画像の微調整ができます。

・最も絵の微調整ができる:画像生成AIサービスの中で最も多機能なので、画像を調整できる機能が豊富です。

さらにControlNetという拡張機能を使えば

・元画像の絵を保ったまま、色や絵柄だけ変更

・落書きから画像の生成

・特定のポーズの再現

・キャラクターの顔を維持したまま、新たな画像の生成

・画像の内容を保ったまま、画像の拡大・高品質化

など。

Stable Diffusionは、オープンソースであり、世界中の開発者が開発に取り組んでいるので、たくさんある画像生成AIサービスの中で、最も多機能です。例えば、

・再現できる画風/絵柄の種類

・機能や微調整できることの数

は、Stable Diffusionが1番多いです。他にも

・無料で画像生成が可能(ただし高性能なPCがある場合 ※後述)

・暴力やアダルト系の内容でも、自由に画像生成可能

など、オープンソースという強みがあるため、ユーザー数が多く、応用の幅がとても広いです。

□ デメリット

・実質有料

・始め方が難しい

・使い方が難しい

・DALL-EやMidjourneyよりは、手軽に高品質な画像を作れない

Stable Diffusionは、オープンソースであり、無料で使えるのですが、高性能なPCが必要です。15万円くらいの費用がかかります。

PCスペックについては、後ほど説明しますが、GPUが重要です。具体的には、Nvidia製のRTX 3060 VRAM12GBくらいのスペックが必要になります。こんな性能のPCを持っている方は、あまり居ないはずです。結局、ほとんどの方がPCを購入することになるので、お金がかかります。

高性能なPCを持っていなくても、クラウド環境(Google Colab、生成AI GO)などで、GPUを借りながらStable Diffusionを使うこともできます。こちらは、自分のPCの性能が低くても、大丈夫です。ただし、少なくとも月1000円かかるので、他の画像生成AIサービスと同じくらいの費用がかかります。

SeaArtやPixAIなどWebサービス上で、Stable Diffusionが簡単に使えるものもあります。こちらは、無料で使えるサービスもありますが

・Stable Diffusionの機能が限られている

・アダルト系の画像生成に制限がある(規約変更あり)

・たくさん使うには課金が必要

・ユーザーが増えたら有料化することもある

など、Stable Diffusionの良さが激減します。そのため、オススメはしませんが、無料で使えるので、Stable Diffusionのお試しには丁度よいです。

① ローカル環境(高性能なPC)

② クラウド環境(Colab、生成AI GOなど)

③ Web版

いずれも、一長一短です。私は、Stable Diffusionで漫画を作るのが最近の目標なので、①と②を使っています。

①と②では、使い方に少しだけ違いがあります。後ほど解説しますが、①の方がユーザー数が多く、情報の多いので、できれば①を使ってください。

Stable Diffusionでは、できることが最も多いので、その分だけ始め方や使い方が難しいです。ただ、基本的な内容に関しては、私が丁寧に解説するので、Stable Diffusionを1度は使ってみてください。

Stable Diffusionのクオリティは高いですが、DALL-EやMidjourneyほど手軽に高品質な画像は作れません。ただし、画像生成AIサービスごとに、得意不得意があります。例えば、日本人女性に特化した画像を生成するとなると、Stable Diffusionが1番クオリティが高いです。暴力系・エロ系の画像は、Stable Diffusionでしか作れません。

目的ごとに画像生成AIサービスを使い分けるのがオススメです。

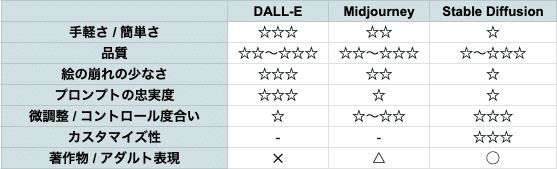

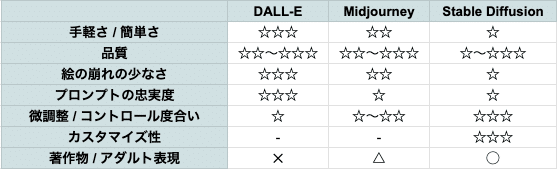

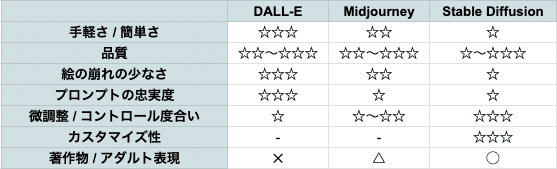

■ 他の画像生成AIサービスとの違いは?

他の画像生成では

・Stable Diffusion

・Midjourney(にじジャーニー)

・DALL-E

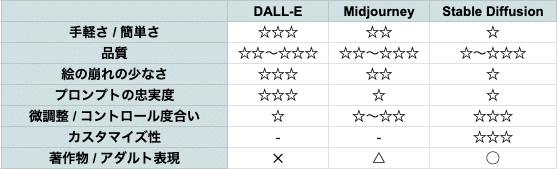

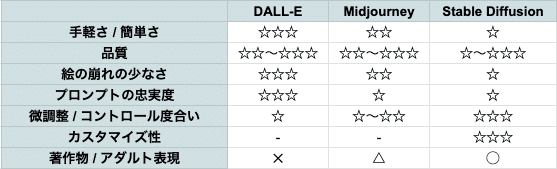

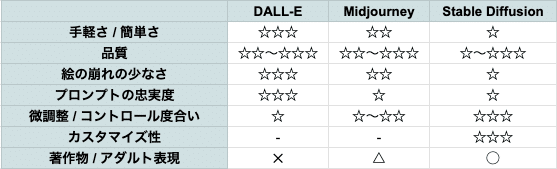

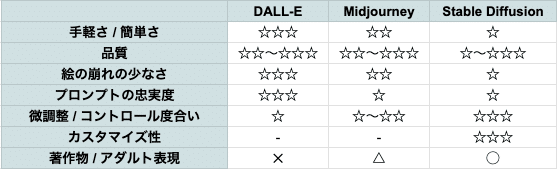

が有名です。特徴と違いは、画像のとおりです。

この画像は、私が感じたことをまとめたものです。ご自身で使ってみて、確かめてみてください。

✓ 手軽さ / 簡単さ

DALL-Eは、ChatGPTやBing AIに搭載されているので、日本語で会話をするように画像生成ができます。この点で、最も簡単に使えるのがDALL-Eです。

Midjourneyは、主にDiscordを使うので少し面倒ですが、慣れてしまえばとても簡単に使えます。

Stable Diffusionは、始めるのも使うのも少し難しいです。習得に最も時間がかかります。

✓ 品質

どれも品質は、十分に高いです。画像生成サービスごとに得意不得意があり、比較するのが難しいです。

強いて言うなら、DALL-EかMidjourneyが最も高品質です。

・手軽に高品質な画像を作るならDALL-E

・オシャレで高品質な画像を作るならMidjourney

です。

Stable Diffusionは、自分で画風や絵柄を選んで画像生成ができるので、再現できないものは無いといっても過言ではありません。例えば、日本人を描きたい場合、Stable Diffusionが1番クオリティが高いです。とはいえ、てきとうに画像生成すると、Stable Diffusionではあまり高品質な絵は作れません。

✓ 絵の崩れの少なさ

品質と被りますが、最も絵の崩れが少ないのがDALL-Eです。画像生成AIでは、手指がおかしいことが多いです。しかしDALL-Eで生成される画像は、そのような絵の崩れがほとんどありません。

✓ プロンプトの忠実度

最も要望どおりの画像が出てきやすいのが、DALL-Eです。DALL-EのAIは優秀で、ユーザーの意図を最も汲み取ってくれます。

MidjourneyとStable Diffusionは、DALL-Eよりは思ったとおりの画像は出てきません。MidjourneyとStable Diffusionの場合は、色々な機能を使い、修正や調整して絵の完成度を上げる必要があります。

✓ 微調整 / コントロール度合い

Stable Diffusionが最もコントロールできます。オープンソースなので機能がとても多く、細かい調整が可能です。特にControlNetを使うと、ある程度ではありますが、特定のポーズを取らせたり、人物を保ったまま色々な画像を作れます。そのため、ビジネスで使うとしたら、Stable Diffusionがオススメです。

Midjourneyは、Stable Diffusionほどではないですが、微調整できる機能があります。

DALL-Eは、現在は微調整できる機能がほとんどありません。

✓ カスタマイズ性

Stable Diffusionはオープンソースなので、多くの機能が実装されていて、自分でも追加することができます。開発のスピードも速くて、最先端のテクノロジーをすぐに試せるのがStable Diffusionです。

他は、企業がAIツールを管理しているため、カスタマイズすることはできません。

✓ 著作物 / アダルト表現

Stable Diffusionは、NGなしで自由に画像生成ができます。何でもアリの世界です。

Midjourneyは、著作物や有名人はある程度は生成できますが、エロ系は生成できません。

DALL-Eは、エロ系だけではなく、著作物や有名人すら生成できないことが多いです。

それぞれのAIツールに、得意・不得意があるので、用途に合わせて使い分けるのがオススメです。例えば、

・手軽に簡単に画像生成したいならDALL-E

・オシャレな1枚絵を作りたいならMidjourney

・絵をコントロールし、目的通りの絵を作りたいならStable Diffusion

という風に使っています。

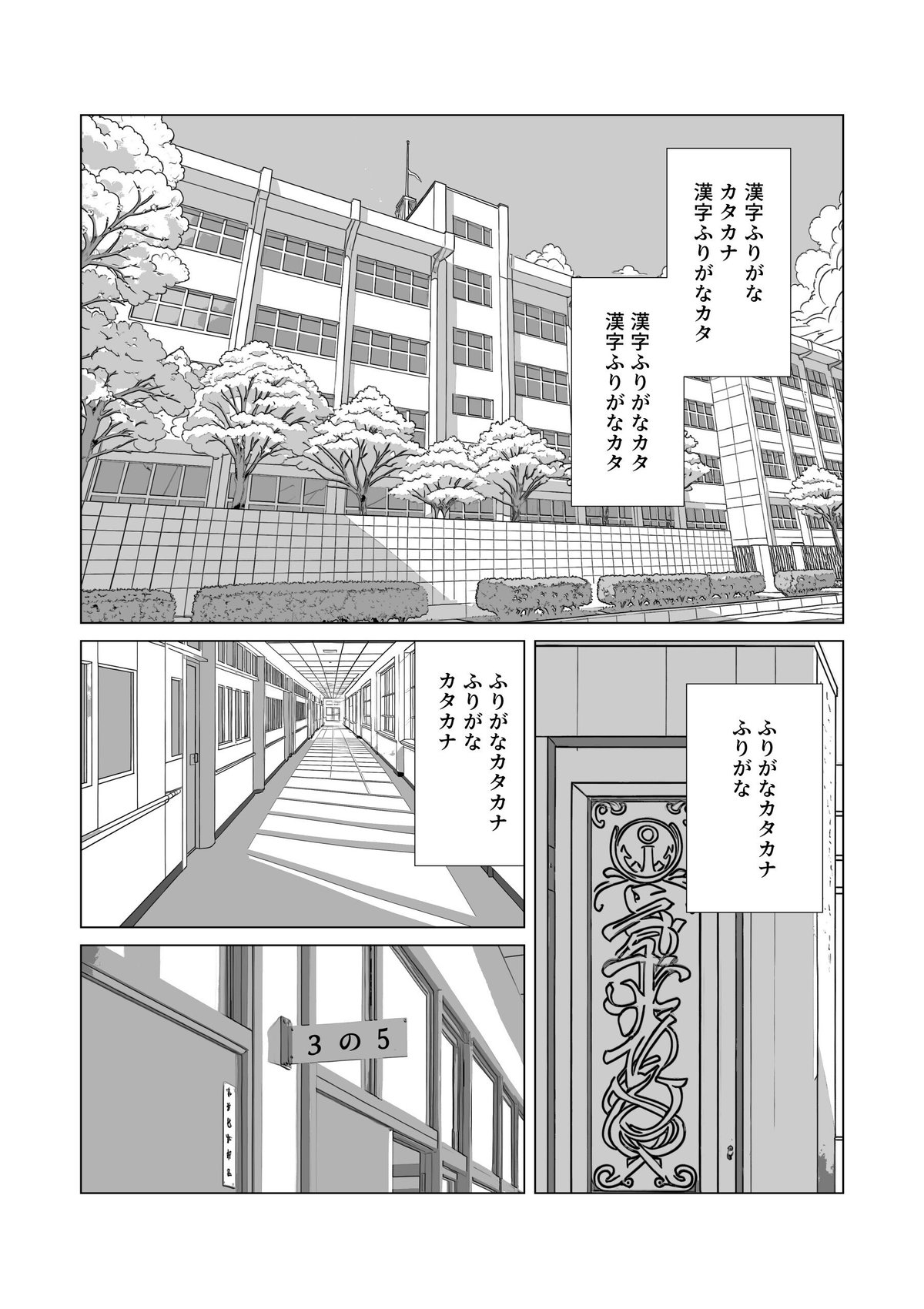

■ 画像生成AIで漫画は作れる?現状を解説

1年前はAI漫画を作るのは無理に近くて、この記事でも、そのように記載していました。しかし最近になり、ある程度は作れるようになってきました。

まだ難しい表現はできませんが、Stable DiffusionやControlNetの性能が上がったことで、かなり漫画の形に近づけられます。

実際に私もAI漫画を作り、販売しています。すみませんがアダルト向けなので、内容と規約的に、ここでは公開できません。

その代わり、培ってきたAI漫画の作り方を、こちらで公開します。動画版もあります。

以前ここに記載していた内容は、古くなったので消去しました。代わりとして、AI漫画制作の流れを以下に記載します。できそうな方は、私の漫画講義は不要です。自信がない方は、ぜひ上記の漫画講義も見てみてください。

AI漫画制作の手順

・物語のセリフを、クリスタに配置する

・ControlNetを使うため、シーンに合う画像を探す(自撮りや3DCGでもOK)

・Cannyを使い画像を生成する(簡単なシーンであれば、普通の生成でもOK)

・プロンプトやWeightを調整しても上手くいかない場合は、別の画像を探すか、ポーズを変えてみる

・Batch countを増やしたり、XYZ plotで画像を一気に生成し、修正の手間が少なそうなイラストを選ぶ

・インペイント、ADetailerなどで、イラストの修正をする

・img2imgとControlNetで画像を拡大する

・AIイラストをクリスタに配置し、トーン化する

・コマ枠を作成し、AIイラストやフキダシなどを配置する

・LT変換し、手描きでAIイラストを修正する

・効果線を追加する

・グレー化して書き出す

■ SDXLとSD1.5 ■

■ SDXLって何?SD1.5との違い

Stable Diffusion XL(SDXL)というのは、Stable Diffusionの最新バージョンのことです。開発元であるStability AIという会社が、2023年の7月頃にSDXL1.0を公開しました。

Stable Diffusionの他のバージョンとしては、Stable Diffusion 1.5(SD1.5)がよく使われています。

Stable Diffusionはよく「SD」と略されるので、SDXLやSD1.5といったらStable Diffusionのことだと思ってください。

紛らわしいですが、「Stable Diffusion WebUI」のバージョンではなく、WebUIの中身のStable Diffusionのバージョンの事を言っています。

既にStable Diffusionを使ったことがある方は、自分がどっちのStable Diffusionを使っているか、分からない方もいるかもしれませんが、ほとんどの方はSD1.5を使っていると思って大丈夫です。

「Stable Diffusion WebUI」は、SDXLにもSD1.5にも対応しているので、実際は同じStable Diffusion画面で、どちらのバージョンも使えます。つまり、これから始めるStable Diffusionを使えば、特別なことは何もせずに

・有名な方のSD1.5

・最新の方のSDXL

を使うことができます。

□ SDXLの特徴

SDXLの特徴は、以下のとおりです。

・あらゆるジャンルにおいて高品質。特にリアル風の画像が得意

・1024×1024サイズが標準

・コントラスト、照明、陰影の表現が、前モデルより向上

・手や文字、空間の位置などの、改善

・少ないプロンプトで、高品質な画像の生成が可能

・プロンプトの汲み取り能力の向上

□ 公式モデルの比較と、注意点

これは、Stability AIが公開している画像です。最新バージョンであるSDXLと、以前のバージョンのStable Diffusionで生成した画像の、どちらの画像が良かったかを調査した結果です。SD1.5よりも、はるかにSDXLが好まれているのが分かります。

ただしこれは、Stable Diffusionの公式モデルで比較した結果のはずです。

モデル(チェックポイント)と言われるものは、次の4種類に大別することができます。

SDXLの公式モデル(初期モデルとも言われている。基本的に1つ)

SD1.5の公式モデル(初期モデルとも言われている。基本的に1つ)

SDXLをベースにしたモデル(チェックポイントとも呼ばれている。無数にある)

SD1.5をベースにしたモデル(チェックポイントとも呼ばれている。無数にある)

私たちが普段よく見ていて使っているのは、4つのうちの後半2つです。それらのモデル(チェックポイント)は、公式モデルをベースに追加学習(fine-tuning)を行っていて、特定の絵柄に特化したモデルになっています。

オールラウンダーである公式モデルのみよりも、特化学習させたモデルの方が、望み通りの画像が出てくれてクオリティが高くなりやすいです。例えば、日本人に特化させて学習させたモデルの方が、人種まんべんなく学習させたモデルよりも、高品質に日本人を描いてくれます。

(基本的に、SD1.5系のチェックポイントよりも、最新のSDXL系のチェックポイントの方が、クオリティは高いです。しかし、チェックポイントごとにも絵柄の得意不得意があります。そのため、毎回必ずSDXL系の方がクオリティが高いわけではないので、注意してください。例えば、SD1.5系は、今まで使われてきて情報が豊富なので、高品質な画像を作るためのプロンプトが多く集まっているという利点があります。)

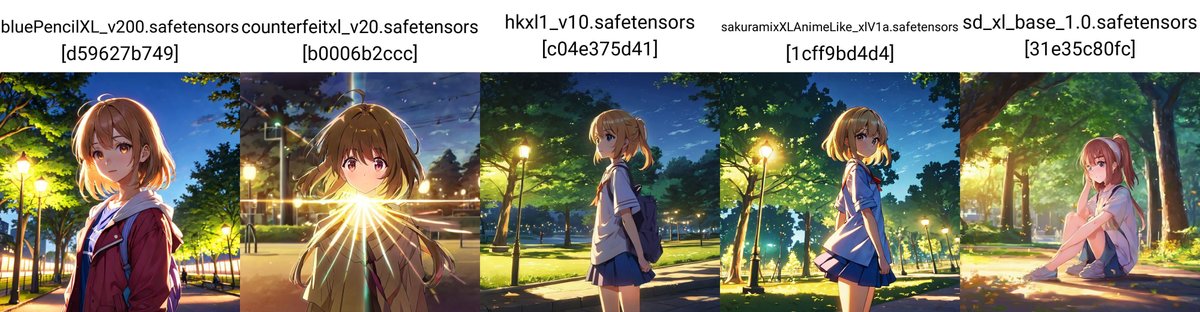

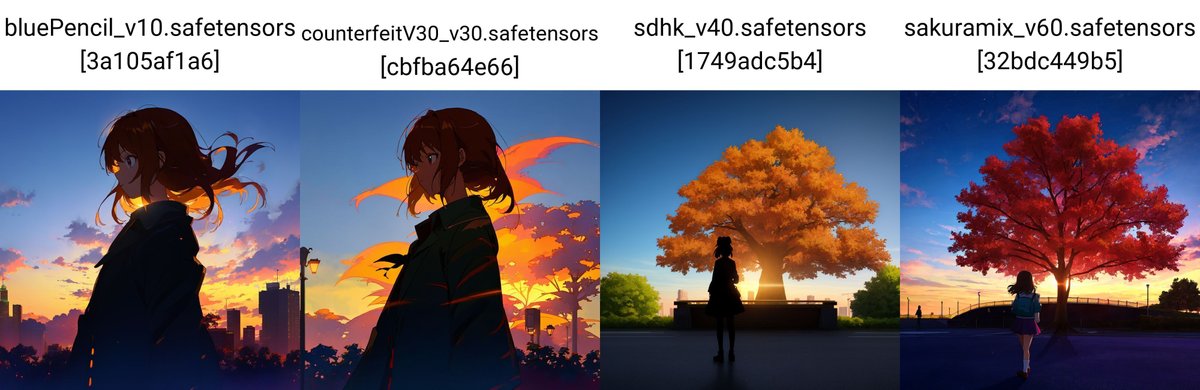

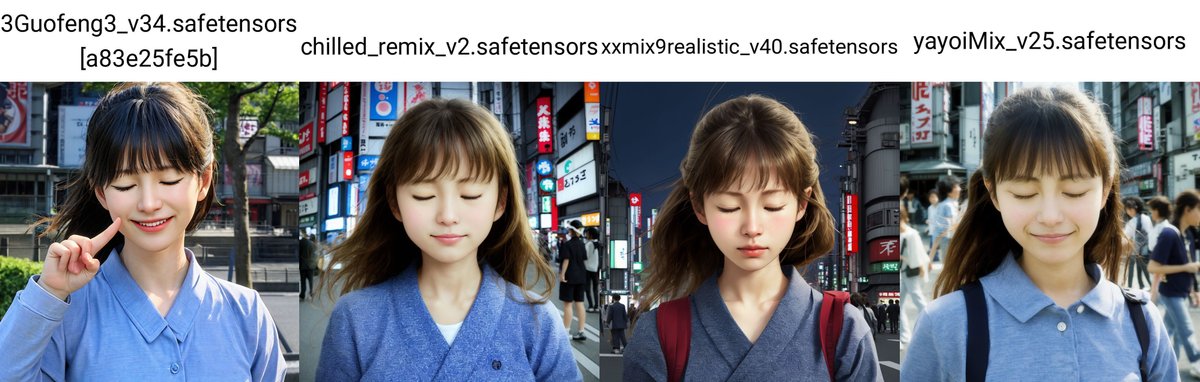

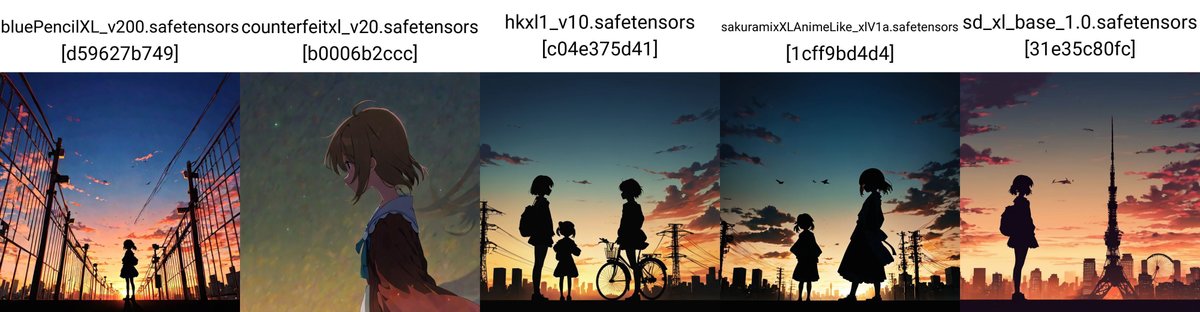

□ SDXLとSD1.5の比較

✓ SDXLのメリット

・手軽に高品質

・絵の崩れの減少

・画像のサイズが最初から大きい

・プロンプトのくみ取り能力の向上

SDXLでは、プロンプトの工夫を頑張らなくても、手軽に高品質な画像を生成できます。例えば、「最高傑作、最高品質、詳細」などの品質系のプロンプトは、ありなしで画像の品質はほとんど変わりません。基本的には、絵に描きたい内容だけ記述すれば、大丈夫です。Midjourneyもそうなので、Midjourneyのプロンプトの書き方に近くなりました。

また、絵の崩れがとても減りました。SD1.5では絵の崩れが多く、何回も画像生成を行う必要がありました。SDXLであっても手指などの崩れは、まだ多いですが、SD1.5より絵の完成度が上がっています。

また、主に1024×1024あたりのサイズでAIの学習がされたこともあり、最初からそのサイズ周辺で画像生成ができます。SD1.5では、主に512×512あたりのサイズでAIの学習がされているので、最初はそのサイズ周辺で画像生成をし、Hires.fixなどを使う必要がありました。Hires.fixでは元画像と絵が変わってしまうデメリットがあり、それを避けるにはControlNetなどの拡張機能を入れる必要があり、面倒でした。

加えて、プロンプトのくみ取り能力も向上しています。SDXLでは、SD1.5よりもさらに多くの学習がされたので、その分だけ生成できる物事が増えています。

✓ SDXLのデメリット

・生成に時間がかかる(要求されるPCスペックが上がった)

・ランダム性が減った

・絵が硬い気がする

画像サイズが大きくなったこともあり、生成に時間がかかるようになりました。

また、絵の表現幅が狭まった気がします。別で解説予定のControlNetやLoRAを使っているんじゃないかと思うくらい、似たキャラクターやポーズが出てきます。SD1.5は、暴れ馬みたいな感じで絵の崩れも多いですが、その分ランダム性はあります。

また、SDXLは絵が硬くなったと感じます。特に髪の毛が分かりやすくて、ふわふわ感が減った気がします。プロンプトを変えてもポーズや絵が中々変わらず、操作感も硬い印象です。

また、Stable Diffusion自体の欠点ではありますが、画像生成の能力、例えばプロンプトのくみ取り能力は、他の画像生成AIサービスと比べると少し低いです。例えば

・アイテム

・ポーズ

・色

など、なかなか思った通りには出てくれません。ちなみに最もプロンプト通りに画像生成できるのは、現状DALL-Eです。

サービスごとに、それぞれ得意不得意はあるので一概には言えませんが、DALL-EとMidjourneyでは、Stable Diffusionよりも手軽に高品質な画像を作れます。とはいえ、Stable Diffusionはオープンソースであり、拡張機能が豊富だったり、何でも生成できて自由だったり利点も大きいです。

✓ SD1.5のメリット

・生成が速い

・ランダム性がある

・情報が多い

SD1.5では、基本の画像サイズが512×512あたりなので、生成のスピードは速いです。ただし、Hires.fixなどで拡大するとなると、SDXLと生成時間はあまり変わらないです。

SD1.5では、SDXLよりもランダム性がある気がします。1.5では生成される画像が、暴れ馬みたいな感じで絵の崩れはありますが、その分いちおう色々なキャラが出てきます。

また、現時点では、SDXLよりもSD1.5の情報が多いです。SD1.5は1年以上使われてきて、今でもまだ現役だからです。チャックポイントやLoRAモデルも、SD1.5の方が多いと思います。

✓ SD1.5のデメリット

・絵の崩れが多い

・プロンプトの工夫が必要

SD1.5は、とにかく絵の崩れが多いです。そのため、何回も生成したり、修正したりすることになります。

また、SD1.5では、品質系のプロンプトはほぼ必須です。上手い人のプロンプトを参考にしたり、自分で何回も試す必要があり、初心者向きではないなと感じます。

□ どっちを使えばいい?

初心者には、SDXLがオススメです。手軽に高品質な画像を作れるのが、SDXLだからです。できれば、比較するために、両方インストールして使ってください。

SDXLは、SD1.5と比べると、プロンプトの工夫はそこまで必要なく、絵の崩れも少ないので、初心者にはSDXLが合っていると思います。

おそらく今後は、XLシリーズが標準になり、アップデートされていくはずなので、今から慣れておくのが得策です。

■ Stable Diffusion画面の見方・使い方 ■

ここからは、主要な機能をまとめて解説していきます。(参考:公式サイト)

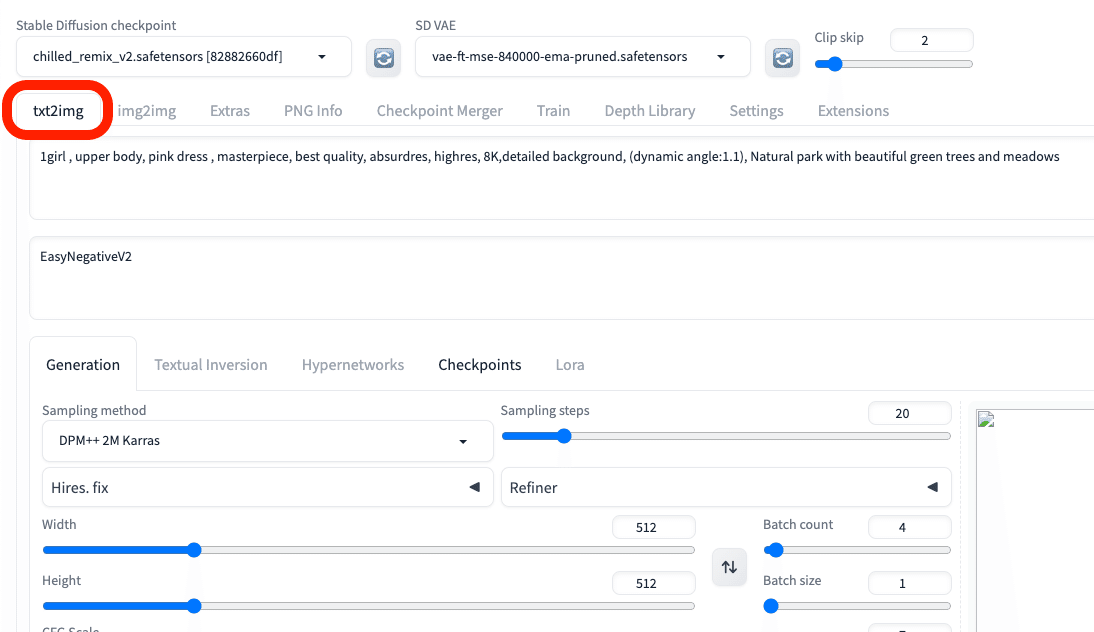

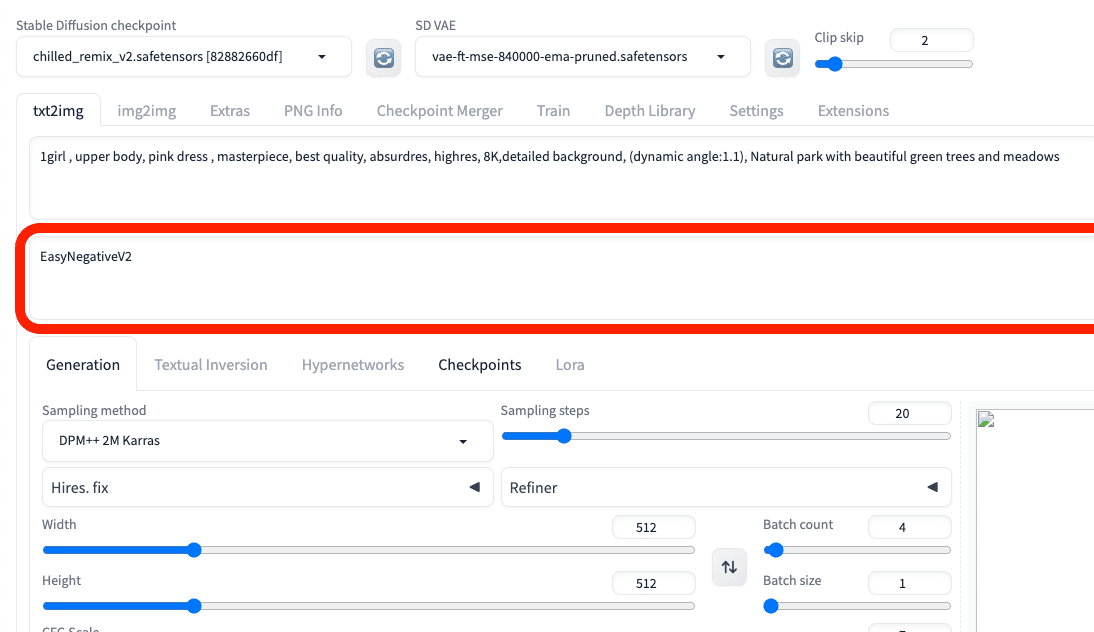

■ テキストから画像を生成

txt2imgは、テキストから画像を生成するために使う場所です。

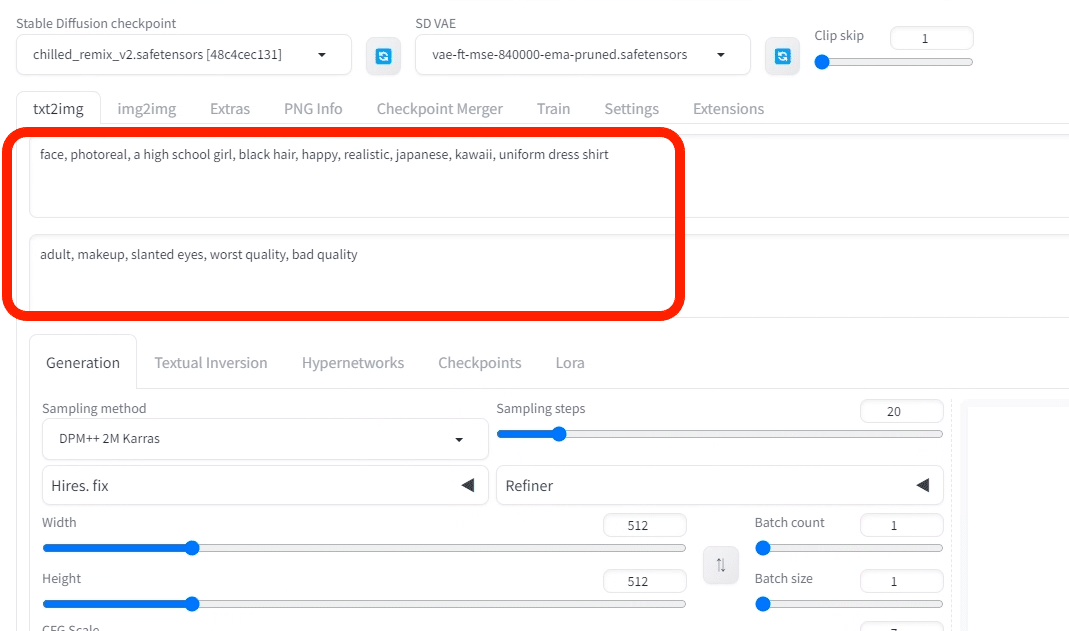

■ プロンプトの基本

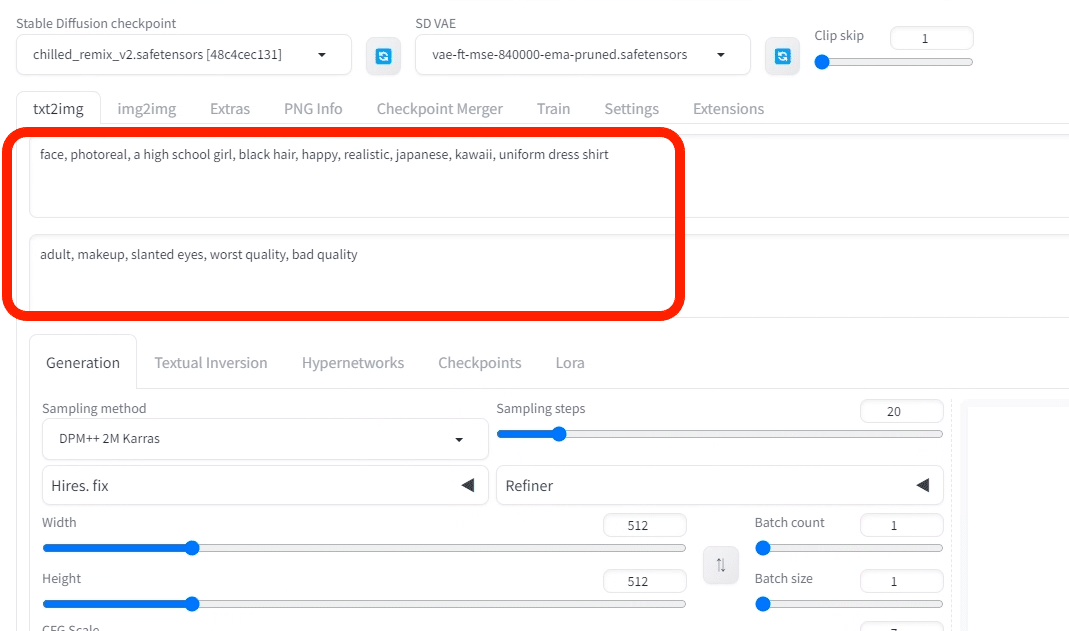

ここに、生成したい画像の説明文を入力します。

・上の段(プロンプト):生成したい画像の特徴

・下の段(ネガティブプロンプト):生成したくない画像の特徴

を入力してください。

入力するテキストは、英語で、カンマで区切って入力します。文章でも生成できますが、「可愛いネコを書いてください」のような命令文や会話文ではなく、「可愛いネコ」のように書いてください。

以下は、プロンプトの例です。

・プロンプト:girl, face, smile, photo

・プロンプト:girl, ocean, standing, anime style

・ネガティブプロンプト:worst quality, bad quality, low quality, ugly, monochrome, dark

Width / Heightで、画像のサイズを設定できます。SDXL用のモデルを使う方は、1024あたりに設定してください。SD1.5用のモデルを使う方は、512あたりに設定してください。

・SD1.5は512*512サイズ

・SDXLは1024*1024サイズ

の画像で主に学習されたため、これらのサイズから離れるほど、絵の破綻が多くなります。オススメのサイズは、以下のとおりです。

✓ SD1.5

・正方形:512*512

・縦長(2:3):400*600

・横長(3:2):600*400

✓ SDXL

・正方形:1024*1024

・縦長(9:16):768*1344

・横長(16:9):1344*768

1500*1500サイズを超える画像になると、GPUにかかる負担が大きくなり、エラーが出やすくなります。

次に、右側にある「Generate」ボタンをクリックすると、画像が生成されます。このとき、GPUの性能が良いほど、待ち時間が短くなります。

再度「Generate」ボタンをクリックすると、プロンプトは同じままでも、別の画像が生成されます。

SD1.5では、プロンプトを少し工夫しないと、高品質な画像は生成されませんでした。例えば、最高品質や傑作、精細など、品質に関するプロンプトを大量に使っているのを見たことがあるかもしれません。

しかし、SDXLでは、プロンプトの攻略は、そこまで重要ではなくなりました。なぜなら、品質に関するプロンプトを入れなくても、高品質の画像が生成されるからです。

テクノロジーの発展を考えると、プロンプトを工夫しなくても高品質な画像が作れるようになるはずです。そのため、SD1.5よりもSDXLのプロンプトが、標準のスタイルになっていくと思うので、SDXLに慣れておいてください。

生成中に「Interrupt」をクリックすると、処理を中断できて、途中結果のまま出力されます。

□ ネガティブ プロンプト

ネガティブプロンプトは、普通のプロンプトとは逆に、生成されたくない特徴を入力します。例えば「low quality」や「bad hands」などです。

✓ SD1.5

SD1.5では、クオリティを上げたいときは、普通のプロンプトを工夫するよりも、ネガティブプロンプトを入れた方が簡単に上がることがあります。

SD1.5では、ネガティブプロンプトは普通のプロンプトと同じくらい重要で、ほぼ必須の設定です。

✓ SDXL

一方でSDXLは、この通りで、ほとんど品質は変わりません。

この性質は、Midjourneyに似ています。Midjourneyにもネガティブプロンプト機能はありますが、普通のプロンプトだけで高品質な画像を作成可能です。そのため、品質を上げるためにネガティブプロンプトを使うというよりは、ふつうに「生成したくない特徴を記述する」という目的で使われています。

SDXLも、Midjourneyのようになって来ています。品質を上げるためにプロンプトを攻略する必要性は、これから先も減っていくはずです。

注意点としては、普通のプロンプトよりもネガティブプロンプトの方が、画像への影響度が低い気がします。つまり、普通のプロンプトの方が、絵に反映されやすいです。そのため、ネガティブプロンプトを頑張って工夫するよりも普通のプロンプトを調整する方が、表現したいことを画像に反映させやすいです。

□ プロンプトまとめ

プロンプトに書くことのまとめが以下です。

・テーマ:人物、動物、キャラクター、場所、物体など

・絵柄:フォトリアル、イラスト、水彩画、油絵など

・場所:学校、オフィス、宇宙、戦場、海、街中、東京など

・照明:太陽光、シネマティック、スポットライト、スタジオライトなど

・色合い:鮮やか、淡い、明るい、単色、カラフル、白黒、パステルなど

・カメラ:ポートレート、ヘッドショット、クローズアップ、広角など

全て含める必要はなく、順番もあまり気にする必要はありません。単語が50個以上くらいの長文になったら、重要なプロンプトは、できるだけ前の方に位置させてください。前の方が、画像に反映されやすいです。

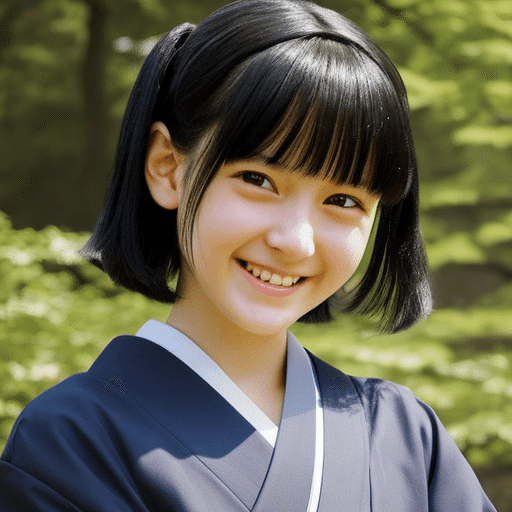

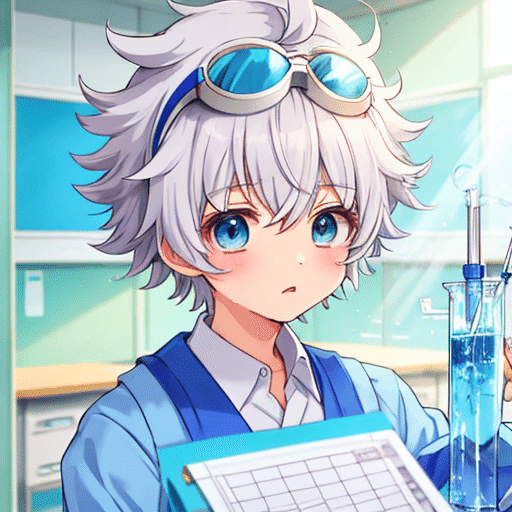

プロンプトを入力し、生成した結果がこちらです。

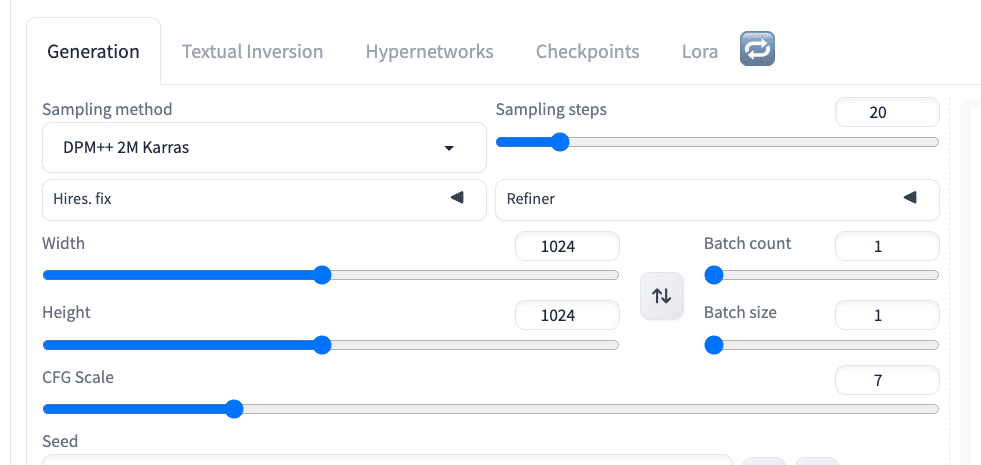

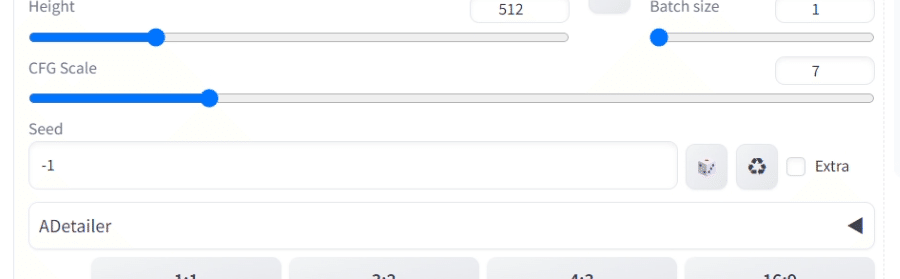

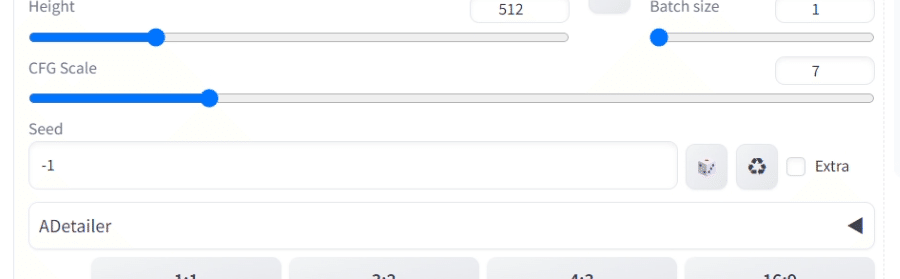

■ 画像比率を変更するなら、WidthとHeight

WidthとHeightは、生成する画像の横幅と高さを設定するところです。右の矢印マークで、画像サイズを入れ替えることができます。

・SD1.5は512*512サイズ

・SDXLは1024*1024サイズ

の画像で主に学習されたため、これらのサイズから離れるほど、絵の破綻が多くなります。オススメのサイズは、以下のとおりです。

✓ SD1.5

・正方形:512*512

・縦長(2:3):400*600

・横長(3:2):600*400

✓ SDXL

・正方形:1024*1024

・縦長(9:16):768*1344

・横長(16:9):1344*768

□ WidthとHeightの注意点

・SD1.5は512*512サイズ

・SDXLは1024*1024サイズ

この推奨サイズから離れると、絵の破綻が多くなります。そのため、特にSD1.5を使う場合、画像サイズを拡大するときにはHires.fixを使うようにしてください。

Hires.fixは、後ほど解説します。

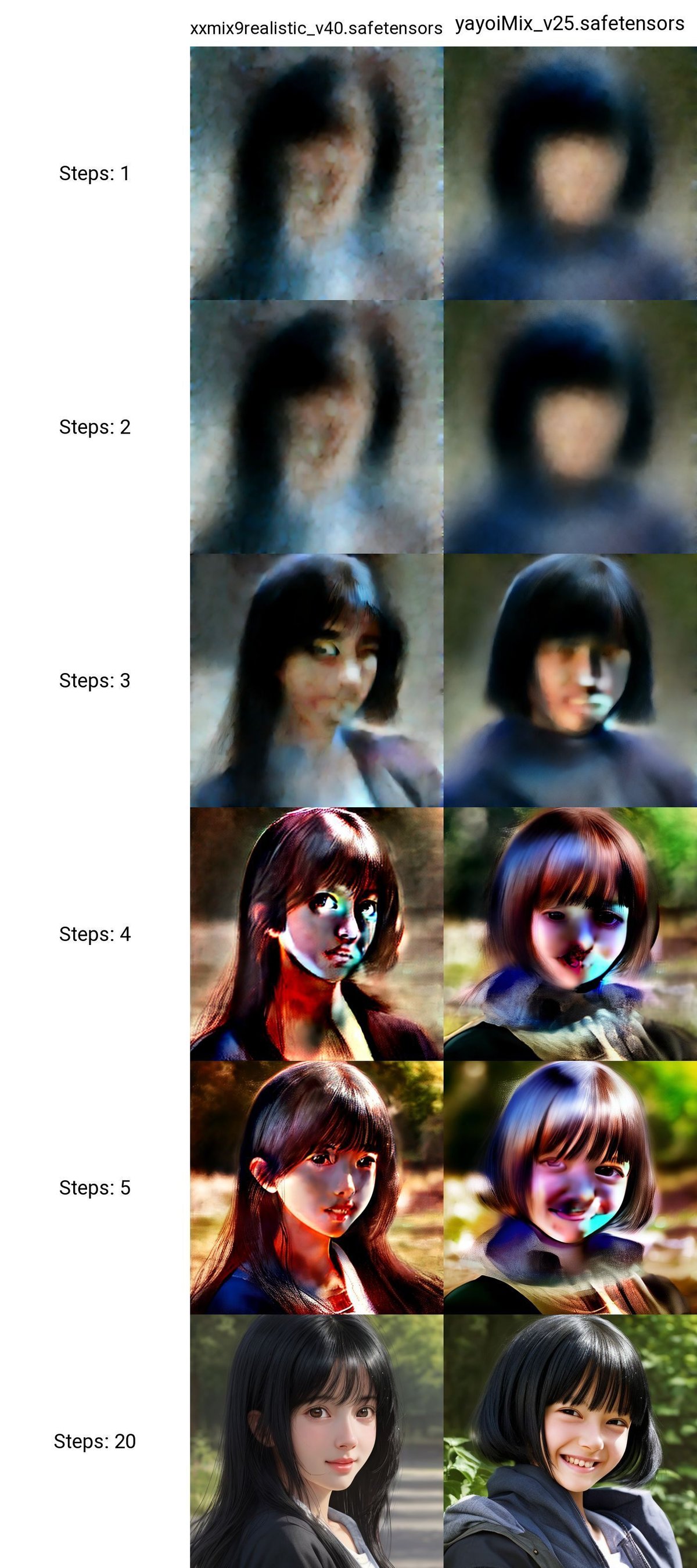

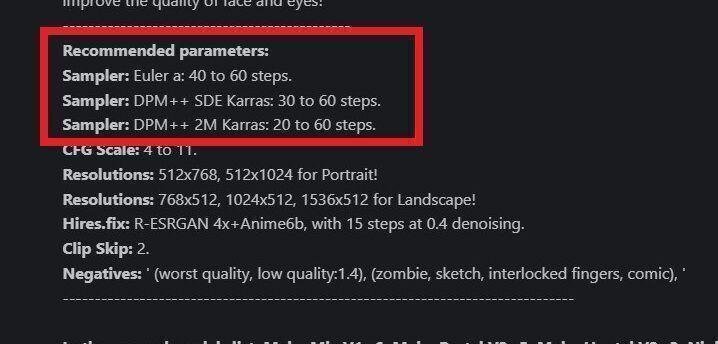

■ Sampling steps(ステップ数)

画像生成AIは、ノイズが多い画像からノイズを徐々に取り除いていくことで、綺麗な絵が作られるという仕組みです。

Sampling stepsでは、このノイズ除去処理のステップ数を調整することができます。生成する画像を、何回くりかえし改善するか設定するところだと思ってください。ステップ数とよく呼ばれています。

ステップ数が多いほど、クオリティがアップしますが、画像生成に時間がかかります。逆に、ステップ数が少ないほど、画像のクオリティが悪くなりますが、画像生成にかかる時間は短くなります。

ステップ数を増やすことで品質が上がるとはいえ、品質の上昇度合いはすぐに横ばいになります。そのため、必要最低限に設定するのが普通です。ほとんどの場合「20前後 ~ 60」くらいに設定します。

基本的に、初期設定のままで大丈夫です。絵の調整をしたいときに、ステップ数を増やしてください。

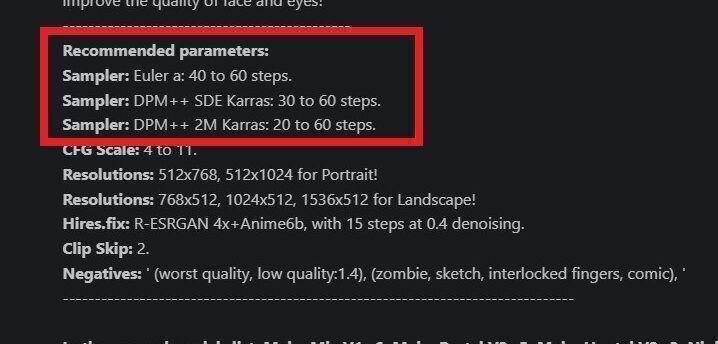

モデルのサイトの説明欄に、ステップ数に関して記載されていることがあるので、それも参考にしてください。

これはCivitaiにある「MeinaMix」というモデルです。

・Euler a:ステップ数 40 ~ 60

・DPM++ SDE Karras:ステップ数 30 ~ 60

・DPM++ 2M Karras:ステップ数 20 ~ 60

推奨と書かれています。

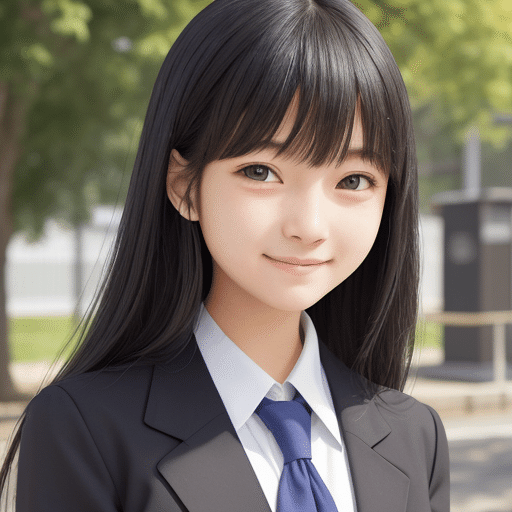

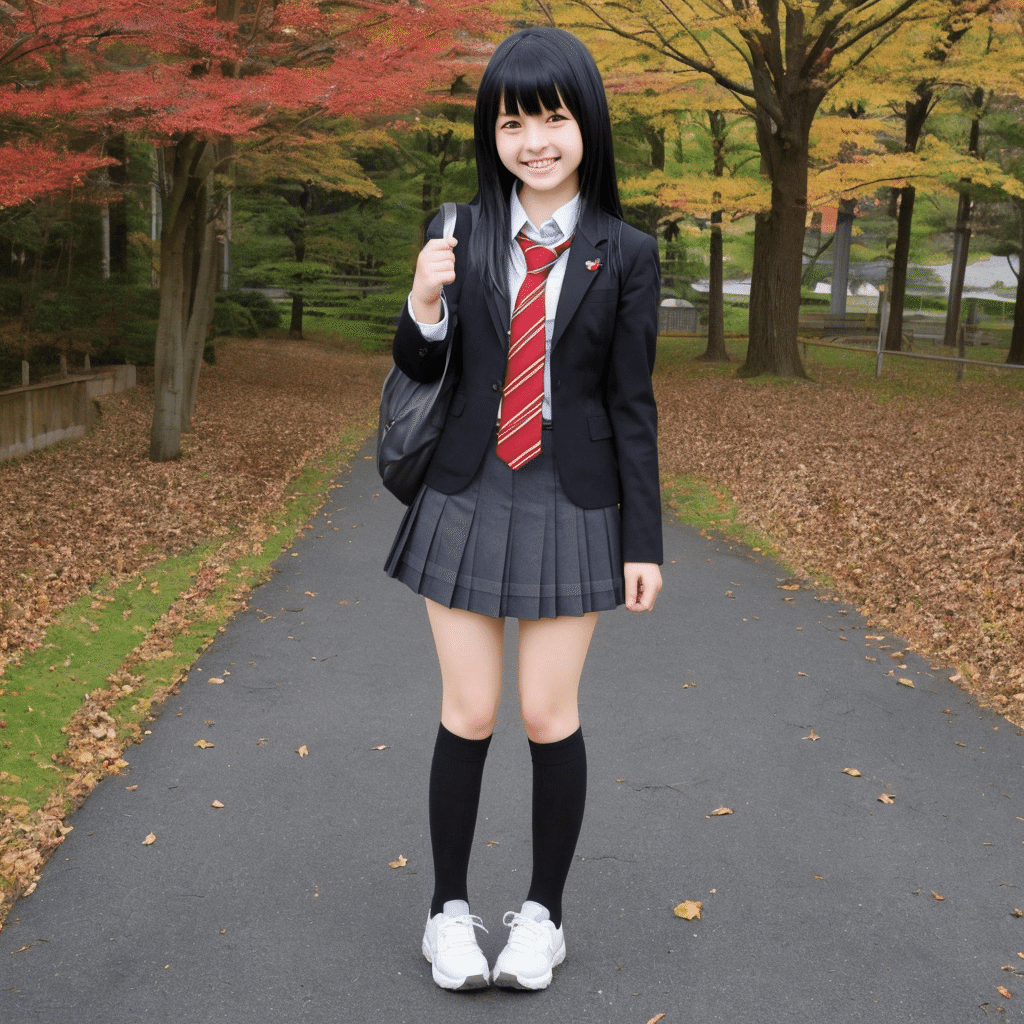

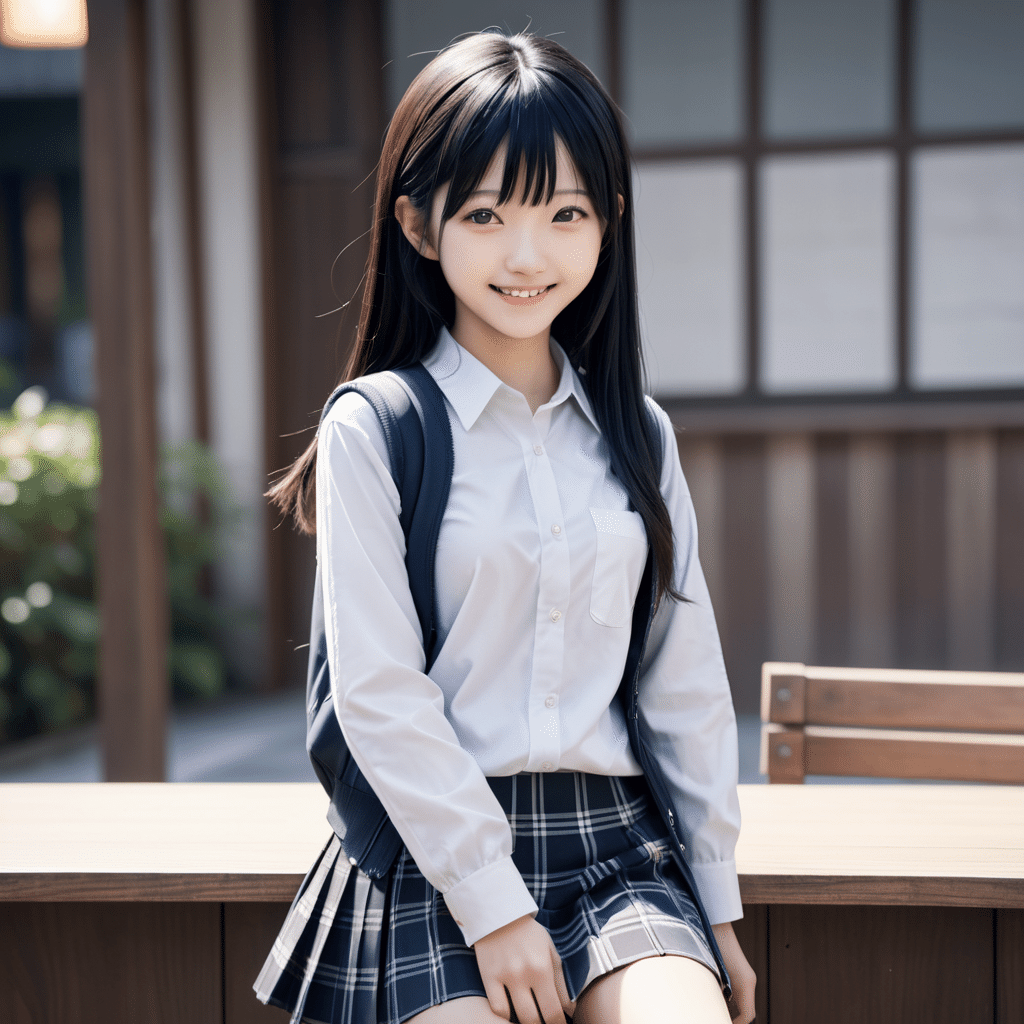

説明欄に推奨が書かれていなくても、プロンプトが記載されている画像があるので、それを参考にしてください。この画像のモデルは「Beautiful Realistic Asians」です。

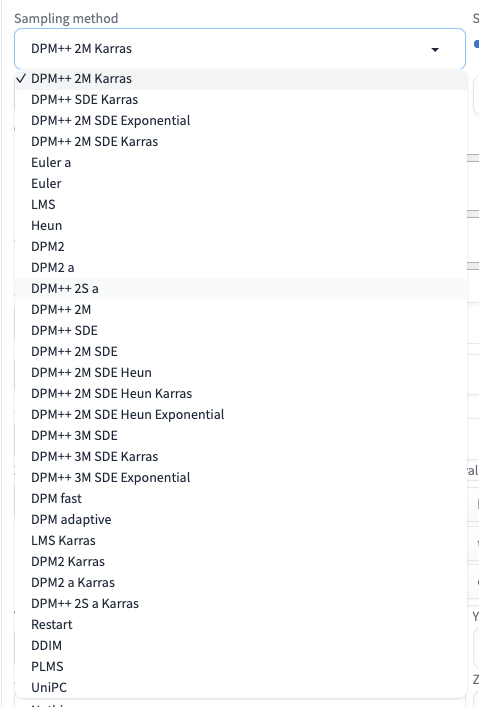

■ Sampling method(Sampler)

Sampling methodとは、画像生成のときに、ノイズを除去するアルゴリズムのことです。Sampler(サンプラー)とも呼ばれています。

画像生成AIは、ノイズが多い画像からノイズを徐々に取り除いていくことで、綺麗な絵が作られるという仕組みです。

テキストから画像生成を行うときに、どのようにノイズを減らすかは、Sampling methodごとに少し異なっています。そのため、Sampling methodを変えると、絵の内容が少し変わります。

Sampling methodには、ノイズ除去のアルゴリズムの一覧が表示されています。同じプロンプトであっても、サンプリング方法を変えることで、品質や生成時間に違いが現れます。

たくさんあって迷うと思いますが、初期設定のままで大丈夫です。なぜなら、Sampling methodを変えても、大きな変化は無いからです。私は、画像の細かい調整を行うときに、たまに使う感じです。仕上げに使うくらいなので、最初のうちは、初期設定のまま使ってください。

また、選び方の1つとして、モデルごとの推奨されているサンプリング方法を使うのがおすすめです。

これはCivitaiにある「MeinaMix」というモデルです。

説明欄に

・Euler a

・DPM++ SDE Karras

・DPM++ 2M Karras

推奨と書かれています。

説明欄に推奨が書かれていなくても、プロンプトが記載されている画像があるので、それを参考にしてください。この画像のモデルは「Beautiful Realistic Asians」です。

基本的に、

・初期設定のまま

・モデルが推奨しているもの

を使っておけば大丈夫です。あとは、自分で試してみてください。

他のモデルでも試した結果が、以下です。

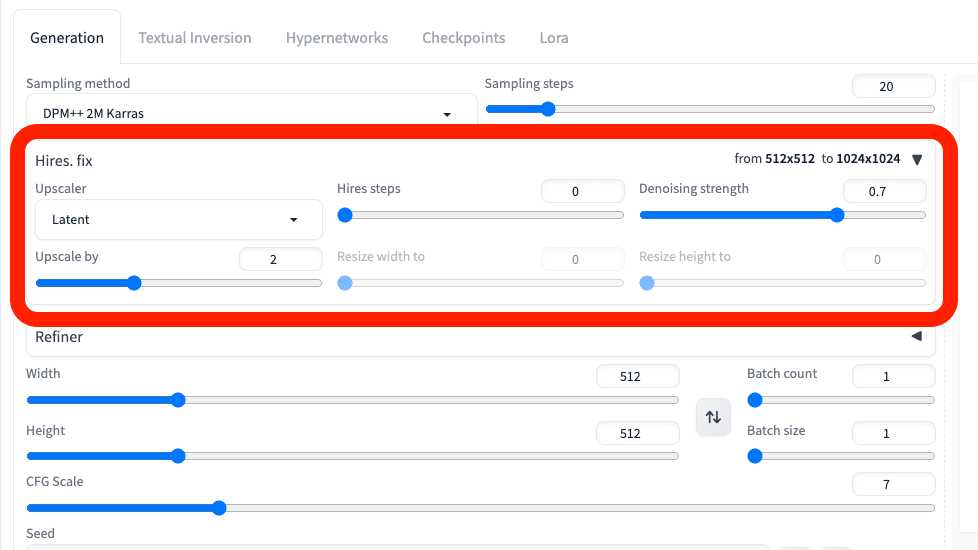

■ 画像を高品質化するなら、Hires.fix(ハイレゾ フィックス)

Hires.fixは、高品質かつ大きめの画像を生成するための機能です。はじめは小さいサイズで画像を作成し、それを拡大しつつ、絵をあまり変えないまま細部まで綺麗にするという仕組みです。High resolution fixの略で、ハイレゾフィックスと呼ばれています。

SDXLでは、最初から高品質な画像が1024サイズで生成されます。そのため、SDXLではHires.fixはあまり必要なくなりました。特にSD1.5を使う方向けの説明となります。

SD1.5では、画像の拡大をしたいときは、Hires.fixを使ってください。

拡大前の絵の内容を保持したい場合は、ControlNetを使う必要があります。説明が長くなってしまうので、ControlNetの記事で解説します。

Width / Heightで、はじめから大きな画像サイズに設定することもできます。しかしSD1.5では、512*512の画像サイズでAIの学習されたものが多いので、512*512サイズから離れるほど、絵の破綻が多くなります。そのため、Width / Heightで最初から大きな画像を生成するのではなく、512サイズ付近の設定のまま、Hires.fixで画像を拡大するのがオススメです。

□ Upscale by

Hires.fixは、右上の▼マークをクリックし、開くだけで有効になります。オフにしたいときは▼マークをクリックして閉じてください。

Hires.fixでは、主にUpscale byとDenoising strengthの2つです。この2つだけ覚えておけば大丈夫です。

「Upscale by」は、Hires.fixにおいての拡大率です。2なら 512*512 サイズが2倍になり、1024*1024 サイズになります。

Upscale byの右にある「Resize width to」と「Resize height to」で、画像の幅と高さを細かく調整することができます。画像の縦横比を1:1以外にしたい場合は、ここを調整してください。

基本的には、Width / Heightで画像比率を設定し、Upscale byを使う方が上手く行きやすいです。

注意点として、画像サイズが1500*1500サイズくらいになると、GPU不足でエラーになります。

そのときは、まずはストップをクリックして終了します。次に、設定の歯車マークをクリックし、VRAMオプションに✓してください。

基本的に、大きい画像(1500*1500サイズくらい)は、生成しないようにしてください。

Hires.fixのデメリットとしては、画像を拡大するときに、絵が変わってしまうことです。絵をほとんど変えずに拡大するには、img2imgやControlNetを使う必要があります。img2imgに関しては、後ほど解説します。ControlNetは、説明は使い方が少し難しいので、別の記事でまとめて解説します。

□ Upscaler(アップスケーラー)

Upscalerは、画像の拡大のときに使われるアルゴリズムの種類です。Sampling method(Sampler)と似たようなものだと思ってください。

Sampling methodと同様に、Upscalerを変えると、絵が少しだけ変わります。最後の微調整に使うくらいかなと思います。

これについても種類がたくさんありますが、基本的に初期設定のままで大丈夫です。私はほとんど初期設定のままです。

□ Hires steps(ハイレゾ ステップ数)

Hires steps(ハイレゾ ステップ数)は、Hires.fixで画像を拡大する際に機能するステップ数です。こちらも、初期設定のままで大丈夫です。

先ほど説明した「Sampling steps(ステップ数)」と似たようなものだと考えてください。拡大される画像を何回くりかえし改善するか設定するところです。

値を大きくするほど生成に時間がかかるので、必要最低限で設定します。普通のステップ数(Sampling steps)と同様に、ステップ数を多くすればクオリティはアップしますが、生成に時間がかかります。増やしても、ある程度からはクオリティはほぼ変わりません。

Hires stepsを0に設定すると、ステップ数で設定している値(初期設定だと20)が使われます。

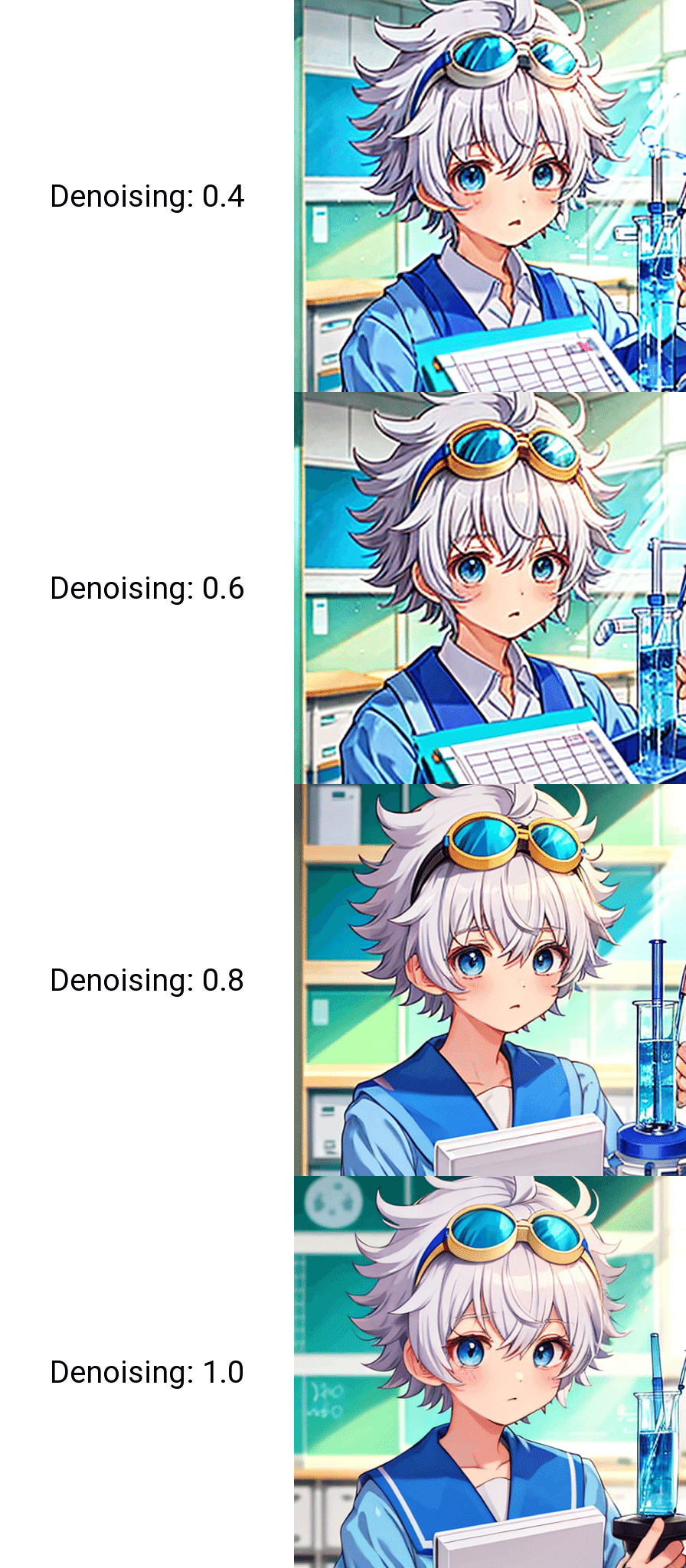

□ Denoising strength

画像生成AIは、ノイズが多い画像からノイズを徐々に取り除いていくことで、綺麗な絵が作られるという仕組みです。

Denoising strengthとは、Hires.fixにおいての画像拡大時に、ノイズ除去度合いを調整する機能です。後で解説するimg2imgやInPaintを使うときにも使用します。

Denoising strengthの値が小さいと、元画像に近い画像が生成されますが、ぼやけることがあります。反対に値が大きいと、高品質になりますが、元画像の絵から離れます。

Denoising strengthは、特にimg2imgのときに重要です。これも初期設定のままで大丈夫ですが、色々試してみてください。

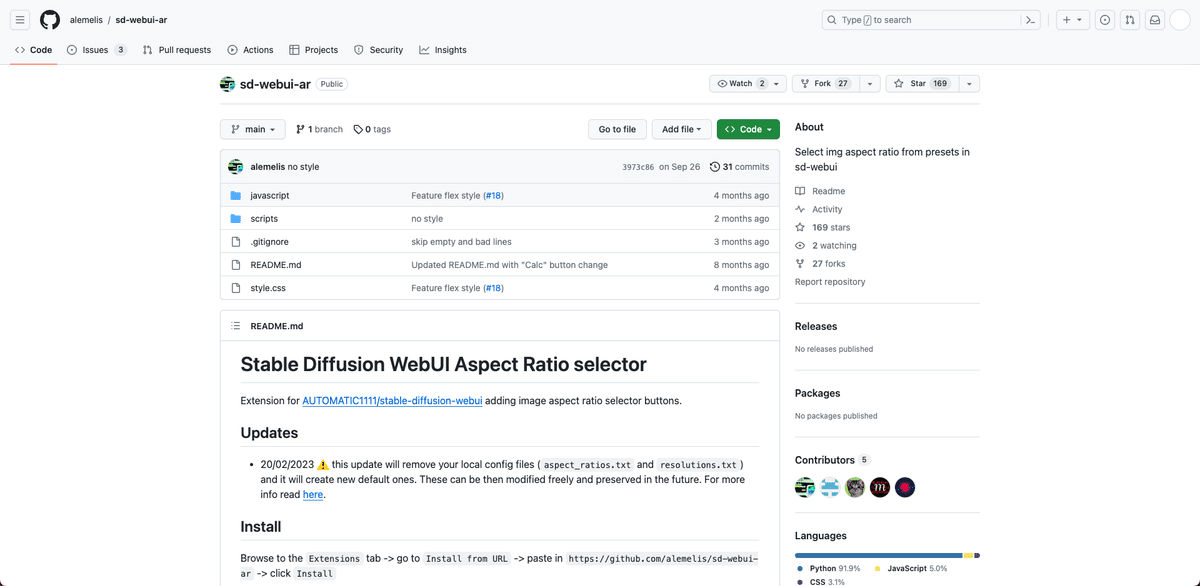

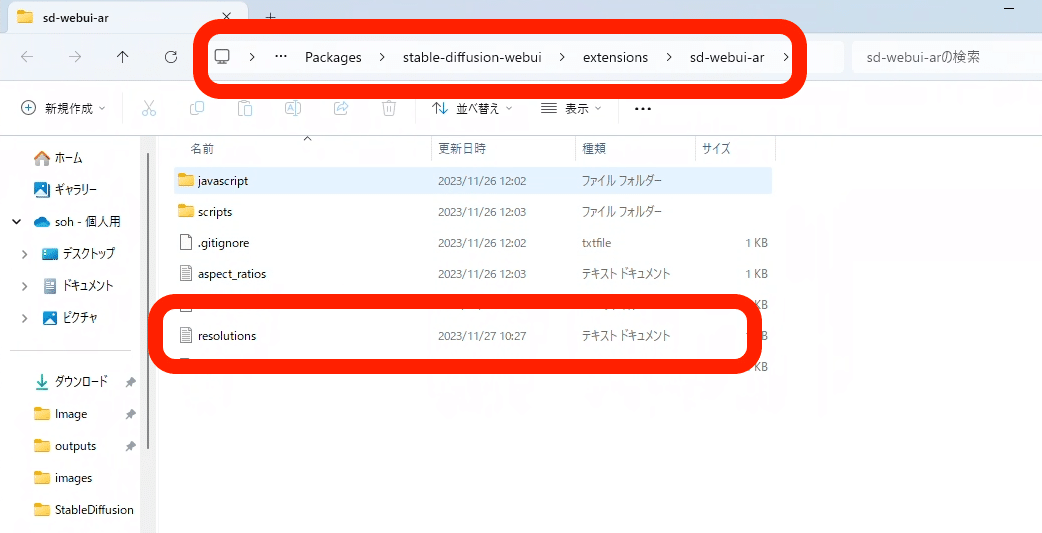

■ 画像サイズ/比率を一瞬で設定できる拡張機能

画像サイズを1クリックで変えられる方法を紹介します。

「sd-webui-ar」という拡張機能を使います。自分で画像サイズをカスタマイズもできる、とても便利な拡張機能です。

□ インストール方法

インストールするには、sd-webui-ar サイトに行き、URLをコピーします。

この欄に貼り付けて、Installをクリックしてください。

次に、Installedに移り、Apply and quitをクリックしてください。Stable Diffusionが停止するので、Launchをクリックし、再起動してください。これでインストール完了です。

□ 使い方

設定したい比率をクリックするだけです。Heightを基準にし、サイズが自動で調整されます。

画像サイズは、自分でカスタマイズしたものを使うこともできます。

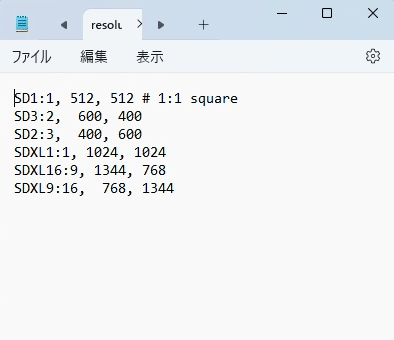

StabilityMatrix → Data → Packages → stable-diffusion-webui → extensions → sd-webui-ar → resolutions のテキストファイルを開いてください。

SD1:1, 512, 512 # 1:1 square

SD3:2, 600, 400

SD2:3, 400, 600

SDXL1:1, 1024, 1024

SDXL16:9, 1344, 768

SDXL9:16, 768, 1344

このように、記述します。コピペして使ってもらって大丈夫です。

テキストファイルを変更した場合は、Stable Diffusionを再起動すると、画面に反映されます。

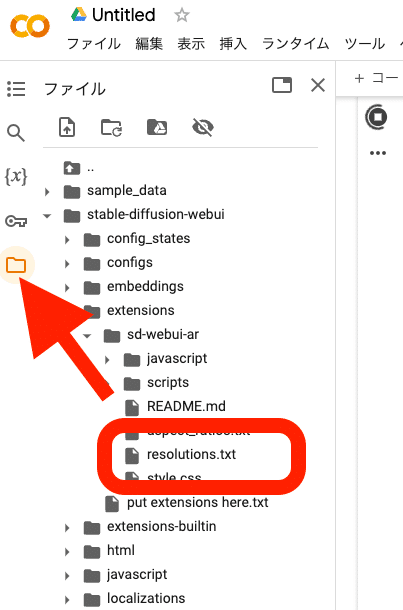

□ クラウド環境での設定

✓ Googleドライブと連携するColab

Googleドライブと連携するColabでは、拡張機能の設定方法は、ローカル環境と同じです。

フォルダの場所は、sd → stable-diffusion-webui → extensions → sd-webui-ar → resolutions となっています。

✓ Googleドライブと連携しないColab

使っていない拡張機能のところを、画像のように編集してください。

!git clone https://github.com/alemelis/sd-webui-ar.git /content/stable-diffusion-webui/extensions/sd-webui-ar

画像サイズのプリセットを変更したい場合は、Colabの起動中に、画像のようにフォルダを開き、「resolutions.txt」を編集してください。そして、Colabを再起動してください。

■ここまでの、まとめ

ここまでの紹介した機能だけで、たくさんの絵柄の表現や、高品質な画像を作ることができます。

復習として、実践してみましょう。詳しい内容は、以前の内容に戻って復習してください。

プロンプトには、生成したい画像の特徴を書いてください。プロンプトは、英語単語または単語の集まりで入力し、それぞれはカンマで区切ります。

ネガティブプロンプトには、生成されたくない画像の特徴を書いてください。SDXLでは、品質に関するネガティブプロンプトを書かなくても、高品質な画像が生成されます。

チェックポイントでは、モデルを切り替えられます。主に

・リアル風

・イラスト風

を変えたいときに、それぞれ得意なモデルを使います。

VAEは、オートマチックのままでも大丈夫です。もし色が薄くなったり、エラーが出たら、以下のVAEを使ってください。

・SDXLを使う場合:「sdxl_vae」

・SD1.5を使う場合:「vae-ft-mse-840000」

モデルごとに推奨されているVAEがあれば、それを使ってください。ただしVAEを変えても、絵はほとんど変わらないはずです。

画像サイズは、ここで変えられます。推奨サイズは、以下のサイズです。

✓ SD1.5

・正方形:512*512

・縦長(2:3):400*600

・横長(3:2):600*400

✓ SDXL

・正方形:1024*1024

・縦長(9:16):768*1344

・横長(16:9):1344*768

特にSD1.5で画像サイズを大きくしたいなら、Hires.fixがオススメです。

Hires.fixは、右上の▼マークをクリックし、開くだけで有効になります。オフにしたいときは▼マークをクリックして閉じてください。

Upscale byで、画像サイズを何倍にするか設定します。Denoising strengthを上げるほど、クオリティが上がりますが、元画像の絵から離れます。下げるほど、元画像を維持できますが、画像がぼやけます。

ネガティブ:adult, makeup, slanted eyes, worst quality, bad quality(SD1.5)

画像生成した結果を見て、上手く行っていなければ、プロンプトを微調整してください。

また、Sampling methodやSampling stepsを調整することでも、微調整できます。

画像生成AIは、ノイズが多い画像からノイズを徐々に取り除いていくことで、綺麗な絵が作られるという仕組みです。

Sampling stepsでは、このノイズ除去処理のステップ数を調整することができます。生成する画像を、何回くりかえし改善するか設定するところだと思ってください。ステップ数とよく呼ばれています。

Sampling methodとは、画像生成のときに、ノイズを除去するアルゴリズムのことです。Sampler(サンプラー)とも呼ばれています。

テキストから画像生成を行うときに、どのようにノイズを減らすかは、Sampling methodごとに少し異なっています。そのため、Sampling methodを変えると、絵の内容が少し変わります。

■ Batch countとBatch size(バッチ回数とバッチサイズ)

Batch count:画像生成を繰り返す回数

Batch size:同時に画像生成をする枚数

例えば、Batch countを4にする場合、1枚目の画像生成をして、終わったら2枚目の画像生成をし、次に3枚目と続きます。一方で、Batch sizeを4にする場合、4枚の画像生成を1回で同時に行います。

Batch sizeの方がVRAMの使用量が多くなるので、基本的にBatch countを使ってください。

Batch countは、複数の画像を生成したいときに便利です。Seedについては後で説明しますが、画像ごとにSeedが異なるので、同じプロンプトのまま、絵が異なった画像を一度にたくさん生成できます。

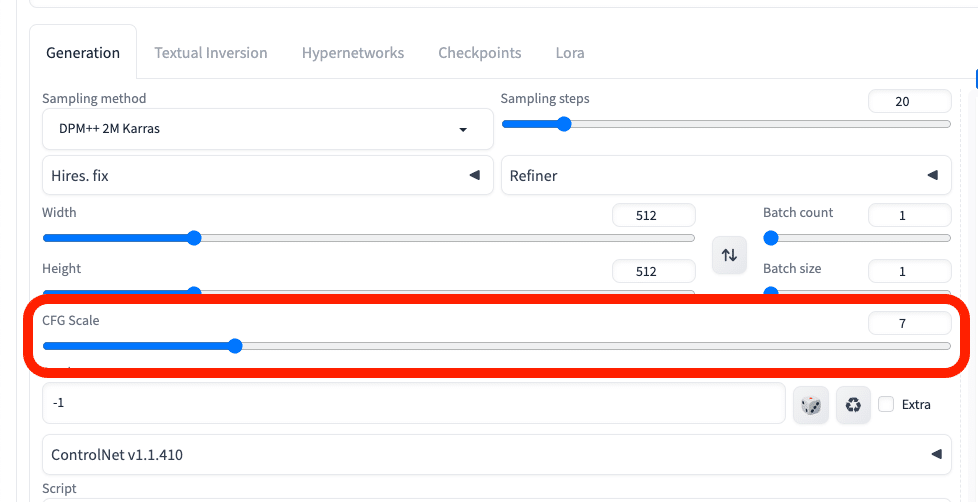

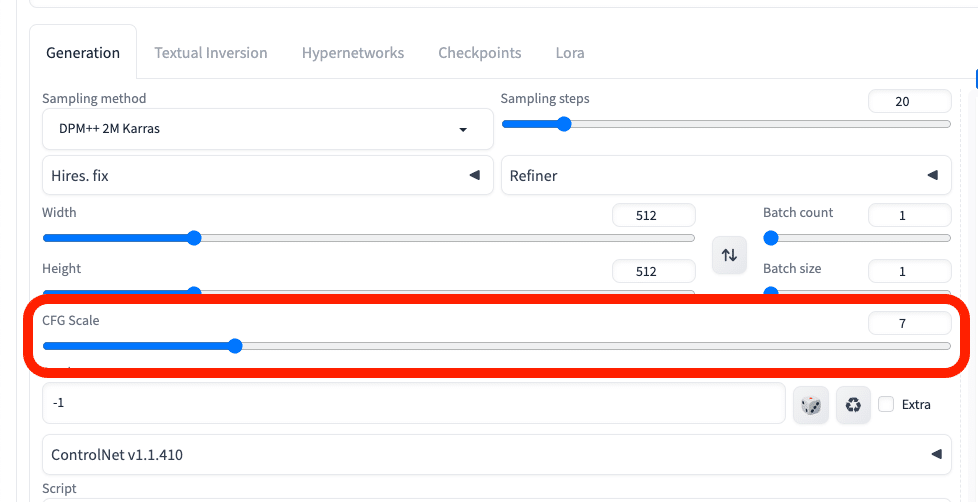

■ 絵に変化を加えるCFG Scale

CFG Scaleは、「生成される画像が、プロンプトにどれくらい忠実か」設定するところです。値が大きいほど、プロンプトに忠実になります。値が小さいほど、より創造的または意外な結果になり、プロンプトから離れます。

ネガティブ:Other people, bad quality, monochrome

(SD1.5)

ただし実際に使っている身としては、CFGを上げても、絵はそこまでプロンプト通りにはなりません。値を上げても、変化がなかったり、絵が破綻します。下げても、絵が破綻しやすくなります。

初期設定の7前後で生成し、絵の変化を見るのがオススメです。プロンプト通りの絵にならないときは、CFGを変えてみてください。

また、モデルのサイトの説明欄を参考にしたり、試してみてください。

これはCivitaiのイラスト調のモデル「MeinaMix」です。CFG Scaleは、「4~11」が推奨されています。このように、モデルの説明欄に書かれていることもあります。

CFGが低いほど、頭にゴーグルが付いていて、本来とは逆の結果になっています。そのため、絵の内容を変える機能だと割り切って使っています。

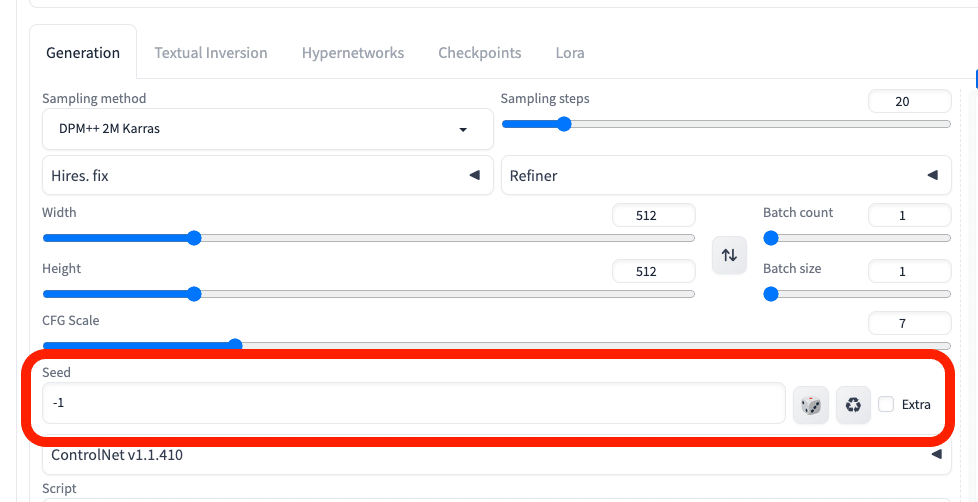

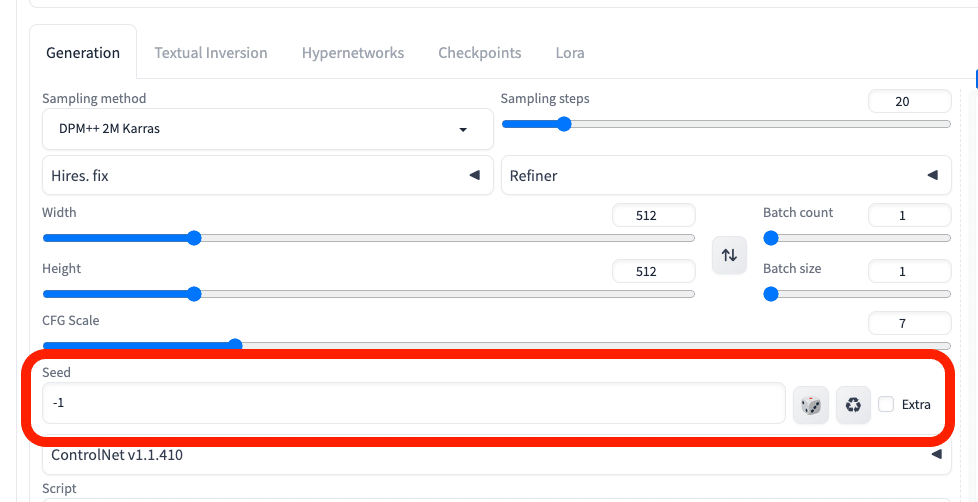

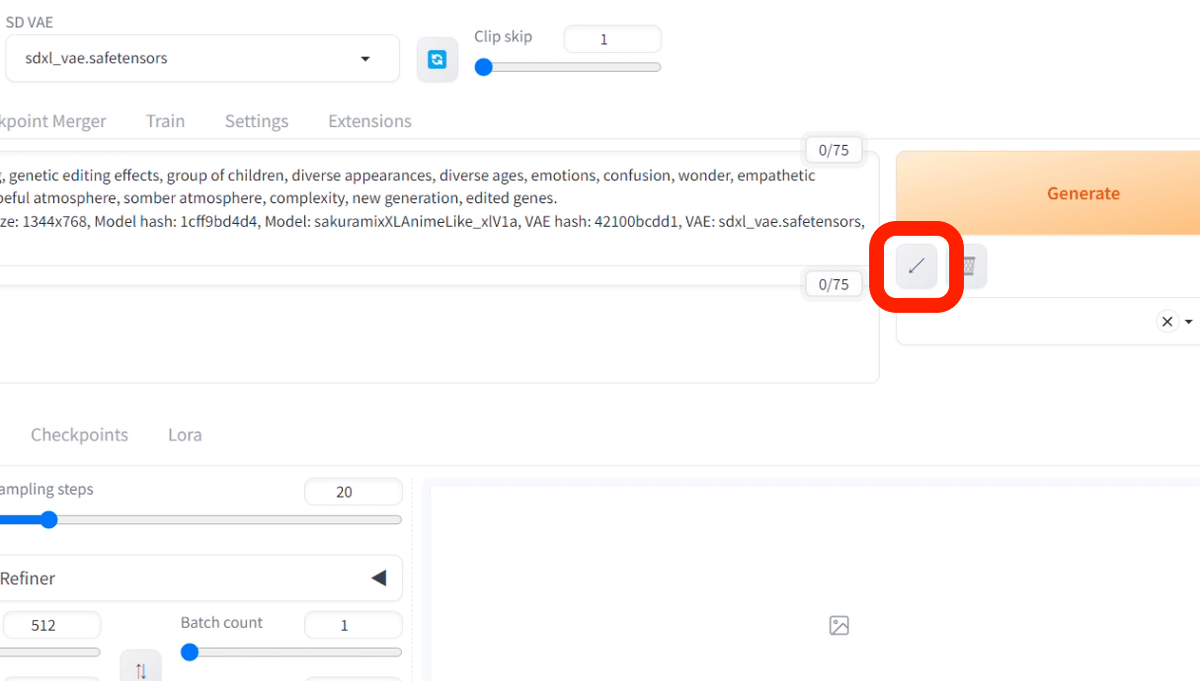

■ 比較検証に必須なSeed

Seedとは、画像生成の計算に使われるランダムな値のことです。画像生成のときに使われたSeedは、ここに表示されます。

同じSeedを使うと、同じノイズで画像生成が行われます。つまり、同じプロンプトやパラメータ、Seedで画像を生成すると、同じ画像を作ることができます。

逆に、異なるSeedであれば、同じプロンプトやパラメータを使っても、別の画像が生成されます。画像生成AIでは、普通Seedは毎回違うので、いつも異なる画像が生成されます。

これは同じSeedを設定して、画像生成した例です。

生成されたSeedを、右側のリサイクルアイコンをクリックすることで、再利用できます。

初期設定ではSeedは「-1」になっています。「-1」はランダムという意味で、「-1」だけは同じ数字でも別の画像が生成されます。サイコロをクリックすると、簡単に「-1」に設定可能です。

これは、元のプロンプトに「smile」を加えたものです。元の画像の特徴を保ちつつ、少し変化を加えることができます。これくらいの表情の変化なら、Seedの固定で同じ人物を維持できます。

しかし、プロンプトを変えるほど、元画像の人物から離れるので、注意してください。

例えば、この画像のプロンプトは、「park」と「office, coffee」以外は同じです。もちろん同じSeedを使っていますが、別人になっています。

ポーズや服装を変えても人物を維持したい場合は、ControlNetなどの中上級者向けの技術が必要です。やや難しく説明が長くなるので、別の記事でまとめて解説します。

何か比較検証したいときには、Seedを自分で設定してから画像生成をします。

例えば、CFGの影響度合いを調べたいなら、例えばSeedを「123」に固定して、CFGを1つずつ変えるなどします。Seedの値は、何でも大丈夫です。Seedとプロンプトなどの他のパラメータを固定することにより、調べたいものの影響度だけ画像に反映されます。

■ 比較検証に便利なScript X/Y/Z plot

Scriptに関しては、よく使う「X/Y/Z plot」を解説します。X/Y/Z plotは、同時に複数パラメータを変えながら、画像生成ができる機能です。

結果は1枚の画像に、表としてまとめられるので、各パラメータの影響度合いが分かりやすいです。比較したい機能がある場合に便利で、よく使います。

Xは横方向に、Yは縦方向に表示されます。「type」には比較できる項目が表示されるので、比較したい項目を1つ選択します。「values」にはtypeのパラメータをカンマで区切って入力します。

typeがチェックポイント(モデル)のような場合は、valuesには数値ではなく、名前を入力します。右のアイコンをクリックすると、インストール済みのモデルを一覧で入力してくれるので便利です。

次に、下の方にある設定の説明をしていきます。

Draw legendは、表の凡例です。画像の上や横に書かれている項目のことです。

「Keep -1 for seeds」はSeedをランダムにして、画像の表を作るという意味です。X/Y/Z plotは、比較したい条件以外は固定して画像の表を作る機能です。もちろんSeedも固定されていますが、「Keep -1 for seeds」をONにすると、ランダムなSeedで画像の表が作られます。基本的に、オフで使ってください。

「Include Sub Images」をオンにすると、表になっていない個別の画像も生成されます。編集画面に持っていきやすいです。ちなみに、オフにしていても、画像の保存自体は自動で行われています。グリッド画像、個別の画像ともに、自動で保存されます。

「Include Sub Grids」は、XYZ軸の3軸で生成したときに、X軸とY軸だけの表も生成してくれる機能です。こちらも、オフにオンしていても、画像の保存自体は自動で行われています。

「Grid margins (px)」は、画像と画像の間の余白のことです。

「Swap X/Y axes」などは、軸の入れ替えです。

X/Y/Z plotを使えば作業の効率化ができます。ぜひ、使ってみてください。typeの種類がとても多く、私自身すべては把握していません。良さそうな機能があれば追記します。

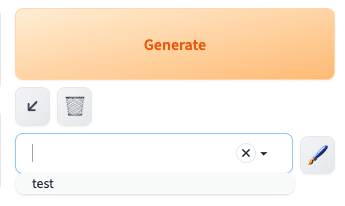

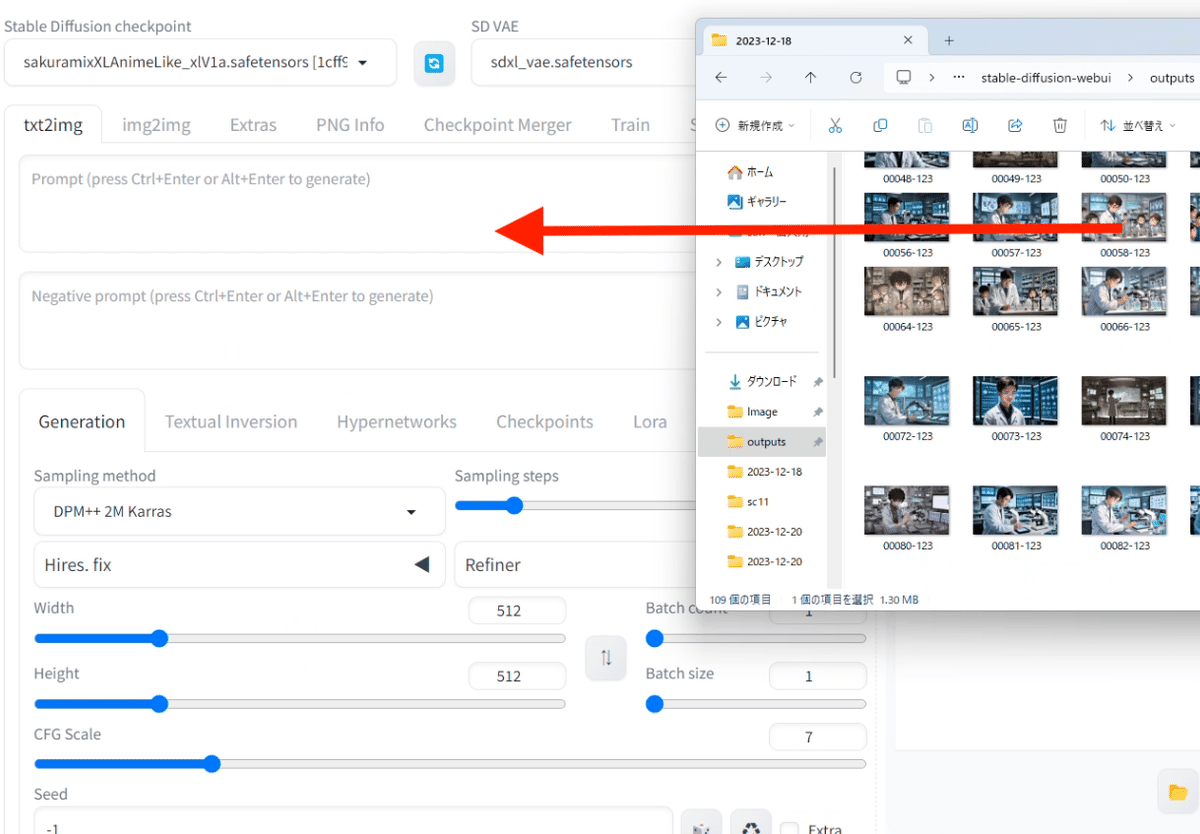

■ Generateボタン周辺の説明

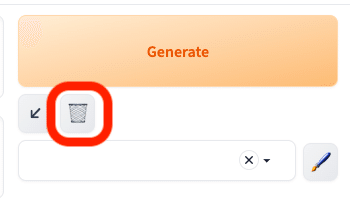

この矢印ボタンは、最後に使ったパラメータを読み込むことができる機能です。「ページを再読み込みした時に、先ほどと同じ設定を使いたい」という時に便利です。クリックするだけで、自動で最後に設定したプロンプトやパラメータが割り振られます。

また、プロンプトやパラメータなどの生成データをコピーできるサイトがある場合にも使えます。そこで生成データをコピーした後に、

プロンプト欄に貼り付けて、矢印をクリックします。

すると、プロンプトやパラメータを自動で割り振ってくれます。

ゴミ箱マークのアイコンは、プロンプトを消去できる機能です。パラメータは消去されません。

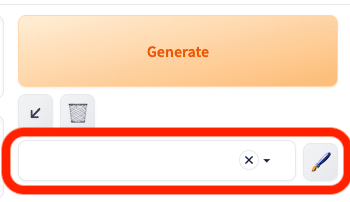

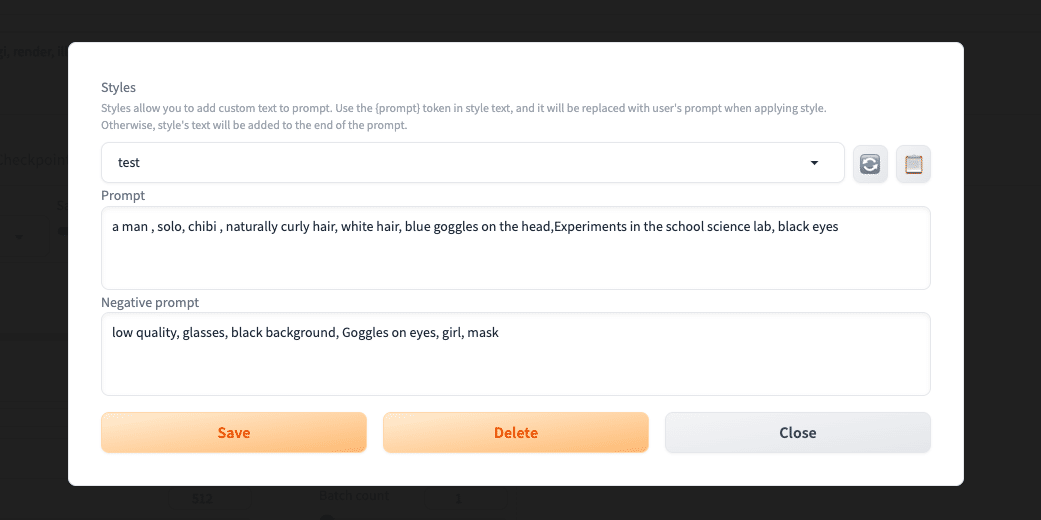

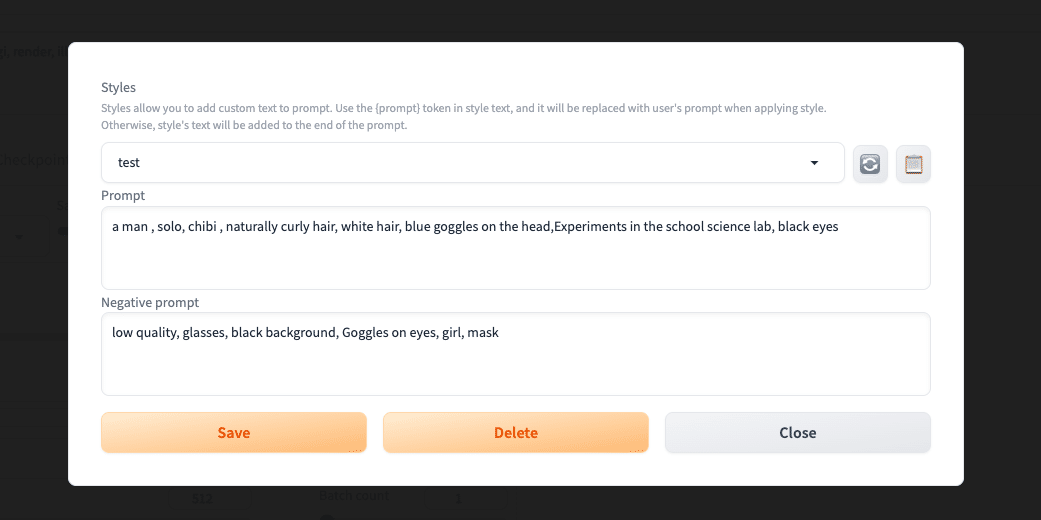

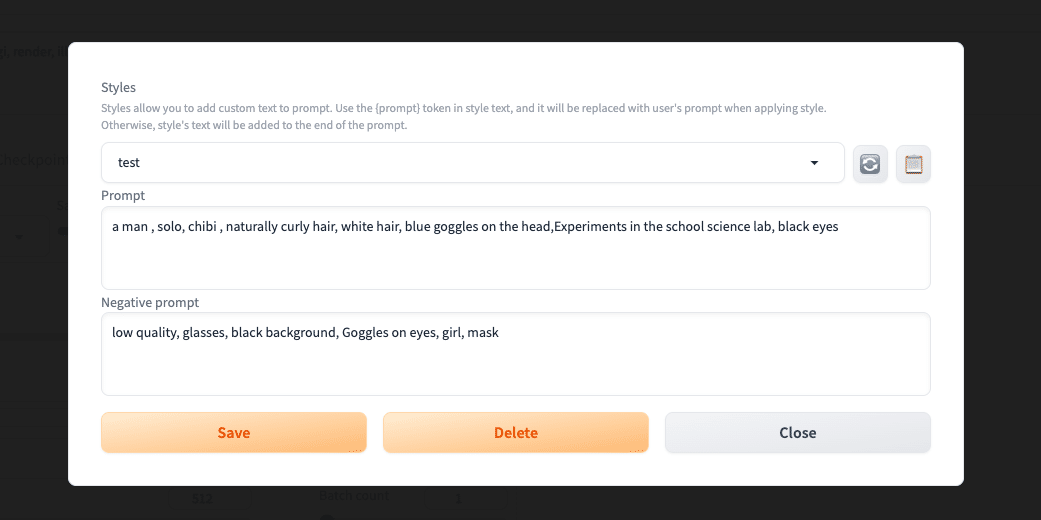

ペンのアイコンは、プロンプトを保存できる機能です。ペンのアイコンをクリックすると、このような画面になります。ここでプロンプトを入力し、保存します。

保存した後は、画像のように設定し、

ペンのアイコンをクリックし、もう1度この画面を開き、右上のメモ帳アイコンをクリックすると、プロンプトがStable Diffusionの画面に割り振られます。

保存したテンプレートが表示されないときは、右上の再利用アイコンをクリックすると表示されます。

よく使うプロンプトは、この機能を使って保存してください。

保存したプロンプトを削除したい場合は、Deleteボタンを押すだけです。

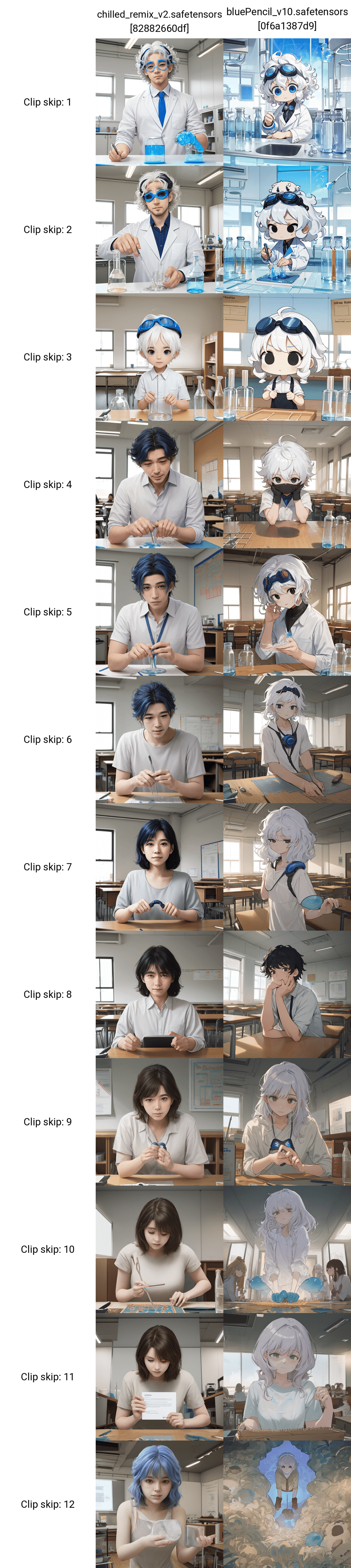

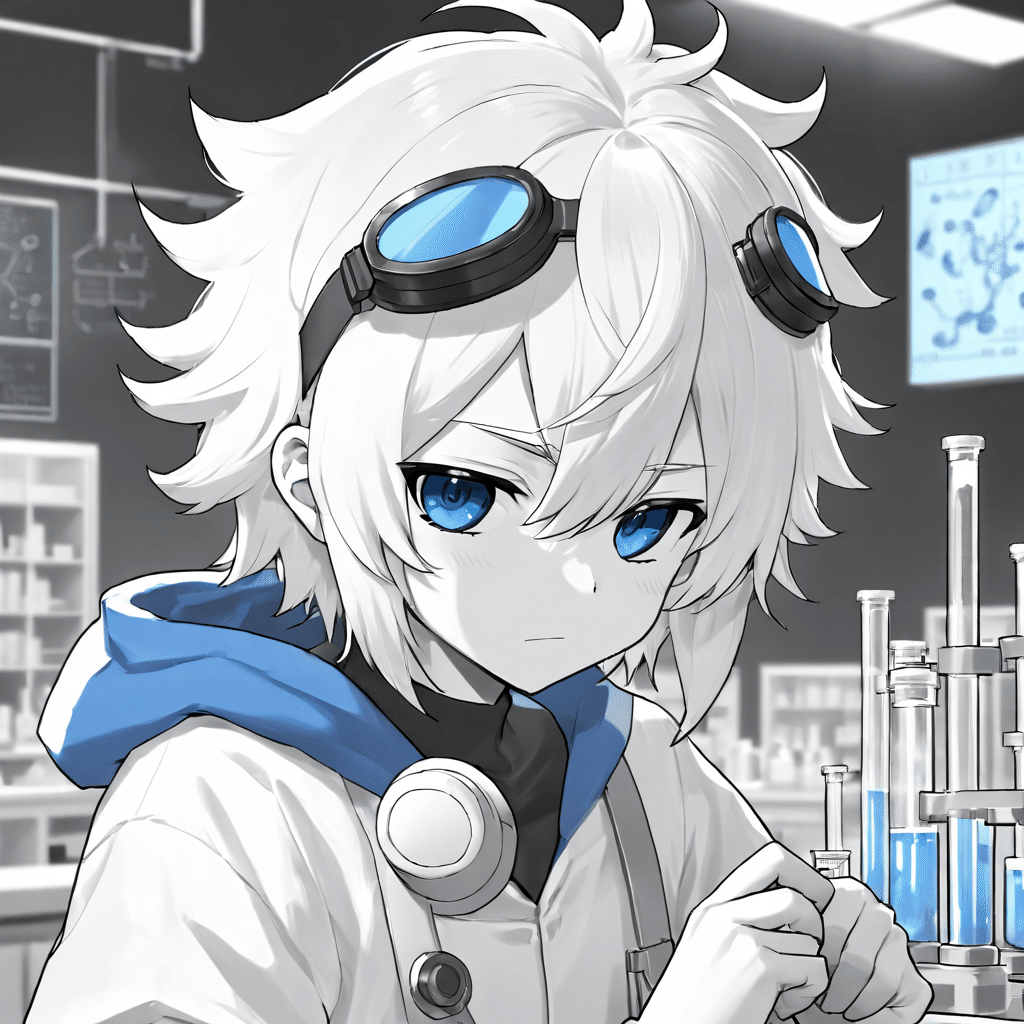

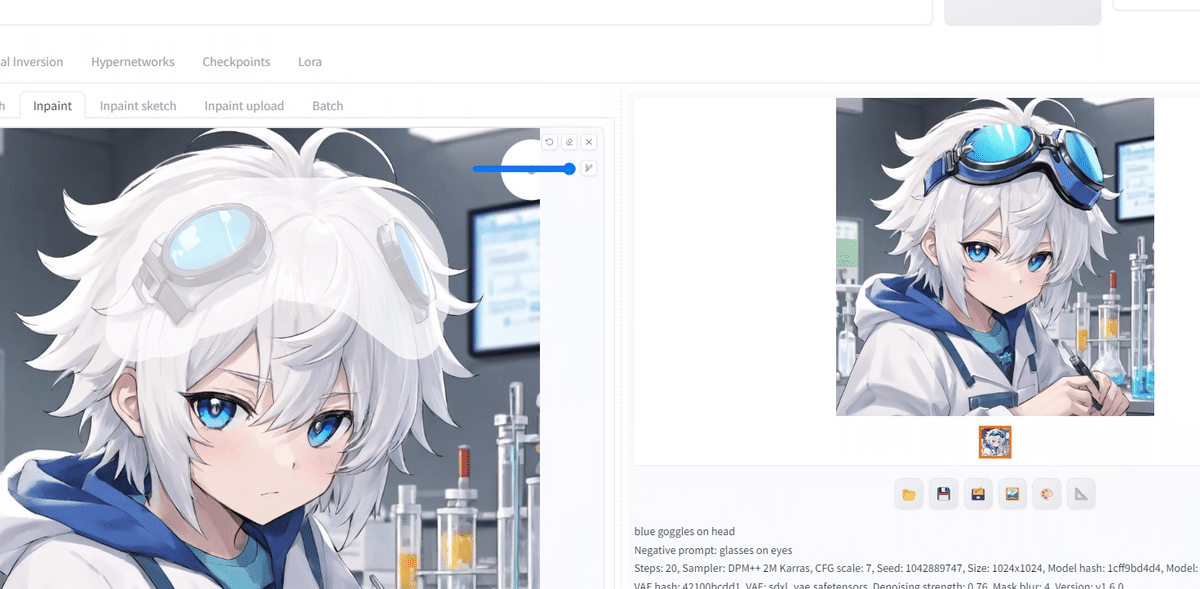

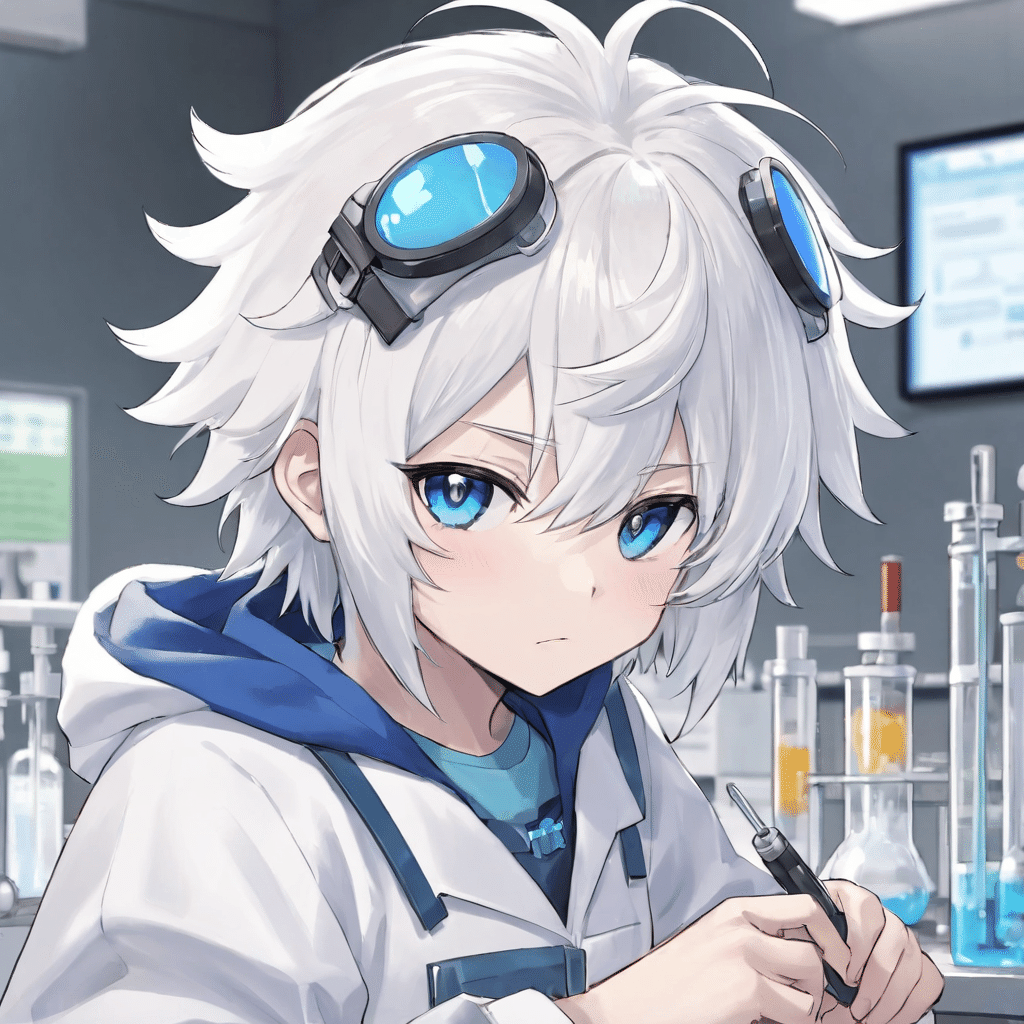

■ Clip skip (SD1.5向け)

Clip skipは、画像生成を途中で中断できる機能です。これにより、プロンプトがどれくらい忠実に画像に反映されるか、調整することができます。絵を変化させたいときにも、よく使う機能です。(参考サイト1・参考サイト2)

Clip skipは、1〜12で設定できます。この設定欄の表示方法は、後ほど説明します。

ネガティブ:low quality, glasses, black background, Goggles on eyes, girl, mask

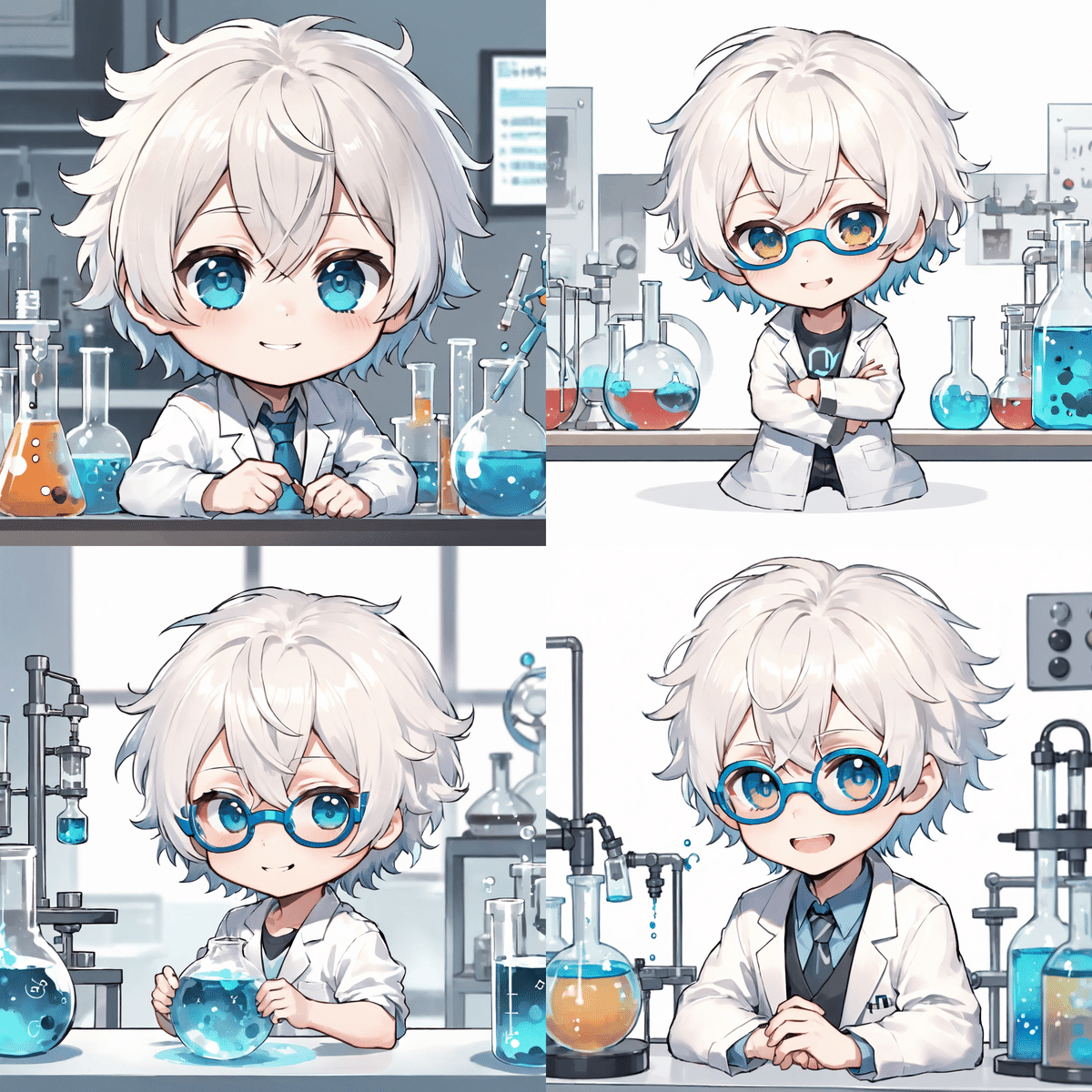

プロンプト:男性, ソロ, チビ, 自然な巻き毛, 白髪, 頭に青いゴーグル, 学校の理科室での実験, 黒い目

Clip skipの値が小さいほど、プロンプトに近い画像が生成されます。

Clip skipの値が大きいほど、プロンプトから離れた画像が生成されます。

1にしておけば良いと思うかもしれませんが、2の方がプロンプトに正確になるモデルも多いです。おそらく、AIが余計な描き込みを追加するので、最終結果よりも少し手前で止めておくと、良い結果が得られるんだと思います。そのため、「推奨設定:2」というモデルは多いです。ほとんどの場合、1か2で上手くいきます。多くても3、4くらいで十分です。

これは、MeinaMixというモデルです。このように、モデルの説明欄に、推奨設定が記載されていることがあります。

似た機能にCFGスケールがあります。「生成する画像が、プロンプトにどれくらい忠実か」設定するところです。値が大きいほどプロンプトに忠実になり、値が小さいほどプロンプトから離れて、より創造的になります。

違いとしては、次のような感じです。

・Clip skip:画像生成を途中で完了させることで、目的に近い画像を生成

・CFG scale:プロンプトにより強く従わせて、目的に近い画像を生成(プロンプト全体を強調する感じ)

ちなみにSDXLでは、Clip skipを変更しても、絵は変わらないみたいです。

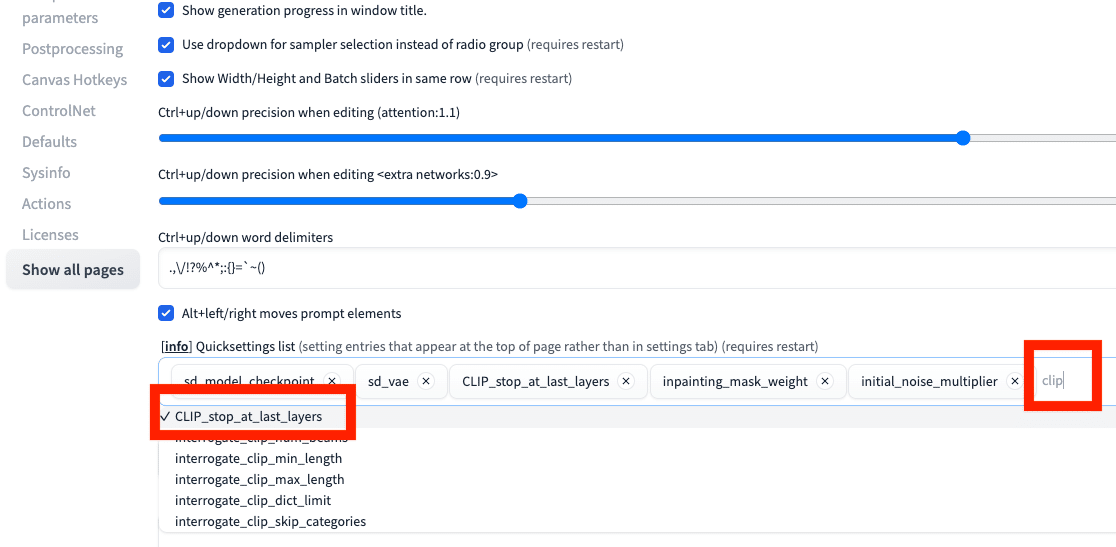

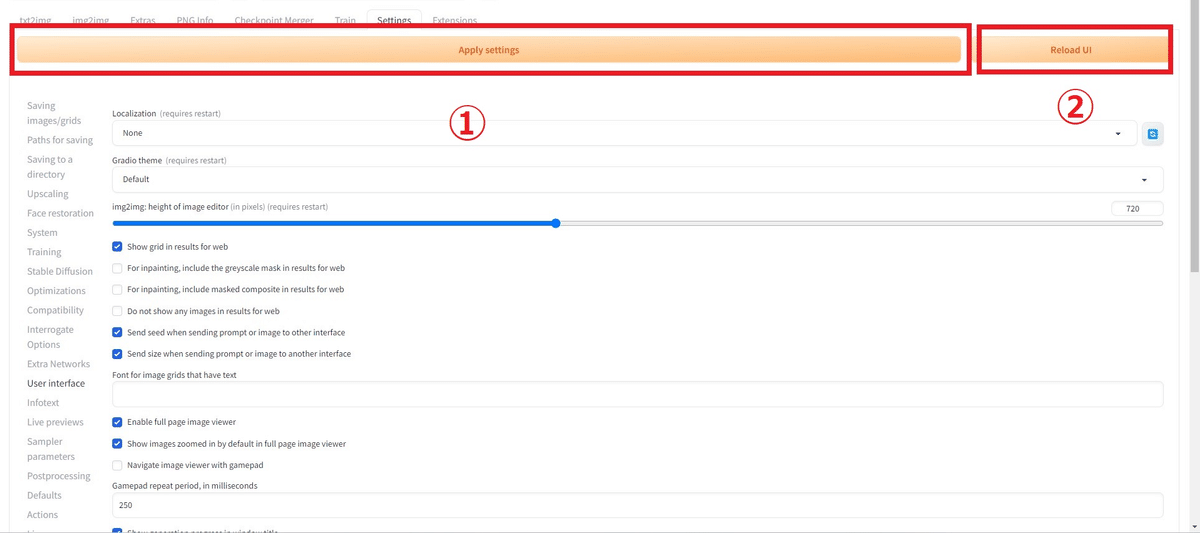

Clip skipの設定欄が表示されていない場合は、Settings → User interface を開いてください。

「[info] Quicksettings list」で、clipと少し入力すると、「CLIP_stop_at_last_layers」が出てくるのでクリックしてください。これがClip skipです。

設定を変更したら、最後に忘れずに「Apply settings」→「Reload UI」をクリックし、Stable Diffusionを再起動してください。

■ Refiner (中上級者向け)

□ Refinerの説明

Refinerとは、より精細で高品質な画像を生成するための機能です。

普通のモデルで画像を生成し、次にRefinerがさらに処理を行い品質を上げるというのが、Refinerの使い方です。ただし、変化はほぼありません。

本来は、各モデルごとにモデル専用のRefinerが必要です。しかし、Refinerがあるのは公式モデルくらいで、他のモデルはRefinerまでは用意されていません。Refinerありなしで生成された画像を見比べても、ほとんど変化は感じられないので、作成する方が居ないのだと思われます。

□ Refinerの使い方

まずは公式ページから、Refinerをダウンロードしてください。

モデル(チェックポイント)と同じ場所に保存します。

Refinerをオンにするには、▼マークをクリックし開くだけです。オフは閉じるだけです。

Checkpoint欄にRefinerを設定し、Switch atでRefinerが適用されるタイミングを設定します。

ステップ数が20なら

・Switch at 0.8:4ステップ分だけRefinerが適用される

・Switch at 0.6:8ステップ分だけRefinerが適用される

という感じです。Switch at1は、Refinerなしと同じです。

□ Refinerの使い道

RefinerのCheckpointは、普通のモデルも割り当てることができます。そのため、1回の画像生成で2つのモデルを組み合わせて生成可能です。

組み合わせとしては、以下のような感じです。

1.イラスト系のモデル → リアル系のモデル

2.リアル系のモデル → イラスト系のモデル

3.イラスト系のモデル → イラスト系のモデル

4.リアル系のモデル → リアル系のモデル

イラスト系のモデルではリアル系のモデルよりも、大げさな絵を生成することができます。「イラスト系のモデル → リアル系のモデル」ではそれを活かし、大げさな絵にしつつリアル系の絵に仕上げることができます。

上の画像は、イラスト系のモデルに、リアル系のモデルでリファイナーを半分かけた結果です。目が大きいところがイラストっぽいですが、リファイナーを適用することによってリアルさを出しています。

「リアル系のモデル → イラスト系のモデル」は、セミリアルなイラストを作りたいときにオススメです。

3.イラスト系のモデル → イラスト系のモデル

4.リアル系のモデル → リアル系のモデル

は、絵柄を、他のモデルでミックスしたいときにオススメです。

注意点として、SDXLとSD1.5の互換性はないので、モデルとRefinerのバージョンは合わせてください。FooocusというWebUIを使えば、バージョン関係なしに使えるみたいです。

■ テキストから画像生成のまとめ

ここまでの内容で、テキストから画像を生成するための基本は、習得できています。

復習として、実践してみましょう。詳しい内容は、以前の内容に戻って読んでください。

プロンプトには、生成したい画像の特徴を書いてください。プロンプトは、英語単語または単語の集まりで入力し、それぞれはカンマで区切ります。

ネガティブプロンプトには、生成したくない画像の特徴を書いてください。SDXLでは、品質に関するネガティブプロンプトを書かなくても、高品質な画像が生成されます。

チェックポイントでは、モデルを切り替えられます。主に

・リアル風

・イラスト風

を変えたいときに、それぞれ得意なモデルを使います。

VAEは、オートマチックを使っておけば、ほとんど上手くいきます。

もし、色が薄かったり、エラーが出たら、以下の有名なVAEを使ってください。

・SDXLを使う場合、VAEは「sdxl_vae」

・SD1.5を使う場合、VAEは「vae-ft-mse-840000」

モデルごとに推奨されているVAEがあれば、それを使ってください。ただしVAEを変えても、絵はほとんど変わりません。

画像サイズは、ここで変えられます。推奨サイズは、以下の正方形のサイズです。比率を変えたい場合は、正方形サイズに近いものを使うと、絵の破綻が少なくなります。

✓ SD1.5

・正方形:512*512

・縦長(2:3):400*600

・横長(3:2):600*400

✓ SDXL

・正方形:1024*1024

・縦長(9:16):768*1344

・横長(16:9):1344*768

特にSD1.5で画像サイズを大きくしたいなら、Hires.fixがオススメです。それ以外の方法は、img2imgで解説します。

Hires.fixは、右上の▼マークをクリックし、開くだけで有効になります。オフにしたいときは▼マークをクリックして閉じてください。

Hires.fixでは、主にUpscale byとDenoising strengthです。Upscale byで、画像サイズを何倍にするか設定します。Denoising strengthを上げるほど、クオリティが上がりますが、元画像の絵から離れます。下げるほど、元画像を維持できますが、画像がぼやけます。

画像生成した結果を見て、上手く行っていなければ、プロンプトを微調整してください。

また、Sampling methodやSampling stepsを調整することでも、微調整できます。

CFG Scaleも、絵の内容を変えたいときに有効です。

CFG Scaleは、「生成される画像が、プロンプトにどれくらい忠実か」設定するところです。値が大きいほど、プロンプトに忠実になります。値が小さいほど、より創造的または意外な結果になり、プロンプトから離れます。

7±4くらいがオススメです。

また、SD1.5のみですが、Clip skipも同様に、絵の内容を変えたいときに有効です。普通は1〜3くらいで調整します。

・同じまたは似たような画像を作りたいとき

・比較検証をしたいとき

にSeedは有効です。

Seedとは、画像生成の計算に使われるランダムな値のことです。画像生成のときに使われたSeedは、ここに表示されます。

画像生成AIは、ノイズが多い画像からノイズを取り除き、キレイなイラストを作るという仕組みです。同じSeedを使うと、同じノイズから画像生成が行われます。そのため、同じプロンプトやパラメータ、Seedで画像を生成すると、同じ画像を作ることができます。

逆に、異なるSeedであれば、同じプロンプトやパラメータを使っても、別の画像が生成されます。画像生成AIでは、普通Seedは毎回違うので、いつも異なる画像が生成されます。

生成されたSeedを、右側のリサイクルアイコンをクリックすることで、再利用できます。

初期設定ではSeedは「-1」になっています。「-1」はランダムという意味で、「-1」だけは同じ数字でも別の画像が生成されます。サイコロをクリックすると、簡単に「-1」に設定可能です。

画像を複数枚一気に生成したいときは、Batch countやScriptのXYZ Plotが有効です。

Batch count:画像生成を繰り返す回数

Batch size:同時に画像生成をする枚数

例えば、Batch countを4にする場合、1枚目の画像生成をして、終わったら2枚目の画像生成をし、次に3枚目と続きます。一方で、Batch sizeを4にする場合、4枚の画像生成を1回で同時に行います。

Batch sizeの方がVRAMの使用量が多くなるので、基本的にBatch countを使ってください。

X/Y/Z plotは、同時に複数パラメータを変えながら、画像生成ができる機能です。

結果は1枚の画像に、表としてまとめられるので、各パラメータの影響度合いが分かりやすいです。比較したい機能がある場合に便利で、よく使います。

■ 応用:プロンプトの強調

プロンプトを()でくくると、その単語の影響を強めたり弱めたりできるそうですが、実はあまり効果はありません。

以下は、ショートヘアの影響を1.5倍強めるという意味です。弱めたい場合は、 「(short hair:0.7)」のように書きます。過度に強調すると、絵が破綻してきます。だいたい1.5〜2倍以下になるようにしてください。

girl, photoreal, tokyo, (short hair:1.5), standing

ちなみに、very short hairなどにしても、あまり効果はなかったです。試してみてください。

プロンプトの強調よりも、似た意味のプロンプトを別で追加するほうが、上手く行きやすいと感じます。画像は、「short hair」に加えて「pixie cut」というプロンプトを入れました。

他にも、明るいという意味の「bright」で絵の明るさが変わらない場合は、brightを強調するよりも、

・clear sky(快晴)

・clear weather(快晴)

・sunlight(太陽光)

などのように、光や照明に関するプロンプトを追加する方が上手くいきます。

ただし、この方法でも、大きな変化は得られないこともあります。そんなときは、LoRAが有効になることもあるので、後ほど解説します。それでも厳しければ、Stable Diffusionの発展を待つか、他の画像生成AIを使うのが良さそうです。

■ PNG Info

PNG Infoは、画像をアップロードするだけで、その画像の生成に使われたプロンプトやパラメータなどの生成データを表示してくれる機能です。

生成した画像には、プロンプトやパラメータなどの生成データも一緒に保存されているので、それが表示されます。

ただし、他のソフトで画像を加工したり、生成データを削除した画像の場合は、PNG Infoに読み込ませてもデータは表示されません。例えば、画像をPNGからJPGに変更すると、生成データは消えてしまいます。

「Send to txt2img」などのボタンをクリックすると、プロンプトやパラメータなどの情報を一括で送ってくれます。モデルは、手動で変更してください。

■ 画像から画像を生成する、img2img

img2imgは、画像から画像を生成する機能です。元画像の絵を保ちつつ、少し変化を加えたり、絵柄を変えるときに使います。また、生成した画像を修正したいときにも、便利な機能です。

ここに、画像をドロップして使います。

あるいは、txt2imgで生成した画像の下に表示されている、写真マークのアイコンをクリックすると、プロンプトなどのパラメータごとimg2imgに送信できます。

img2imgではプロンプトなしでも画像生成できますが、プロンプトなしだとクオリティがとても低くなったり、元画像とかけ離れた画像が生成されます。元画像のプロンプトはあまり変えず、調整したい内容のプロンプトを追加してください。

■ Denoising strengthで、変化度を調整する

画像生成AIは、ノイズが多い画像からノイズを徐々に取り除いていくことで、綺麗な絵が作られるという仕組みです。

Denoising strengthは、ノイズ除去度合いを調整する機能です。Hires.fixやimg2imgでよく使います。

Denoising strengthの値が小さいと、元画像に近い画像が生成されますが、ぼやけたりクオリティが下がることがあります。反対に値が大きいと、高品質になりますが、元画像の絵から離れます。Hires.fixよりも、ぼやけることは少ないです。

大きい変化を加えたいときはDenoising strengthを高めに、小さい変化を加えたいときはDenoising strengthは低めに設定してください。初期設定のままでも大丈夫ですが、色々試してみてください。

img2imgでは、元画像と同じSeedを使うと画質が悪くなるので、ランダム(-1)にするか、別のSeedを使ってください。

img2imgを使えば、このように、元画像を保ちつつ絵柄を変えることができます。

ただし、絵は元画像と似てはいますが、少し変わってしまいます。元画像と同じ絵にしつつ、絵柄だけを変えたい場合は、ControlNetを使ってください。

■ Resize mode

Resize modeは、元画像と違う画像比率でimg2imgするときに、必要になる設定です。ややこしいので、基本的に元画像を同じ画像比率で、画像生成するようにしてください。そうすれば、Resize modeの設定を気にする必要はなくなります。

Denoising strength:0

Denoising strength:0

Denoising strength:0

Denoising strength:0

「Resize mode」は、元画像を別の画像サイズに変更するときに選択するモードで、3種類+1あります。

Just resize – 元画像の縦横比を無視して、そのまま画像サイズを変更するので、歪むことがあります。

Crop and resize – 元画像の縦横比を保ったまま、画像サイズを変更します。このとき、はみ出した部分はカットされます。

Resize and fill – 元画像の縦横比を保ったまま、画像サイズを変更します。このとき、足りない部分はAIが補完してくれます。

Just resize (latent upscale)- Just resizeと同じですが、Upscalerだけ違います。(Upscalerは、画像生成のときに使われる計算の種類のことです。)

上の画像では、Denoising strengthの値は0です。Denoising strengthはノイズの量を調整する機能です。値が小さいと元画像に近い画像が生成されますが、ぼやけることがあります。値が大きいと高品質になりますが、元画像とは違った絵が生成されます。

もし元画像の画像比率と異なる比率でimg2imgを使うときは、以下の生成結果を参考にしてください。

Denoising strength:0.75

Denoising strength:0.75

Denoising strength:0.75

Denoising strength:0.75

Denoising strengthを上げれば、画像サイズを変更してできた隙間に、プロンプトに応じて描き込みをしてくれます。

ただし、Denoising strengthが低いと、先ほどのように、おかしな絵になったりします。そのため、img2imgを使うときは、基本的に元画像と同じ画像比率を設定するようにしてください。

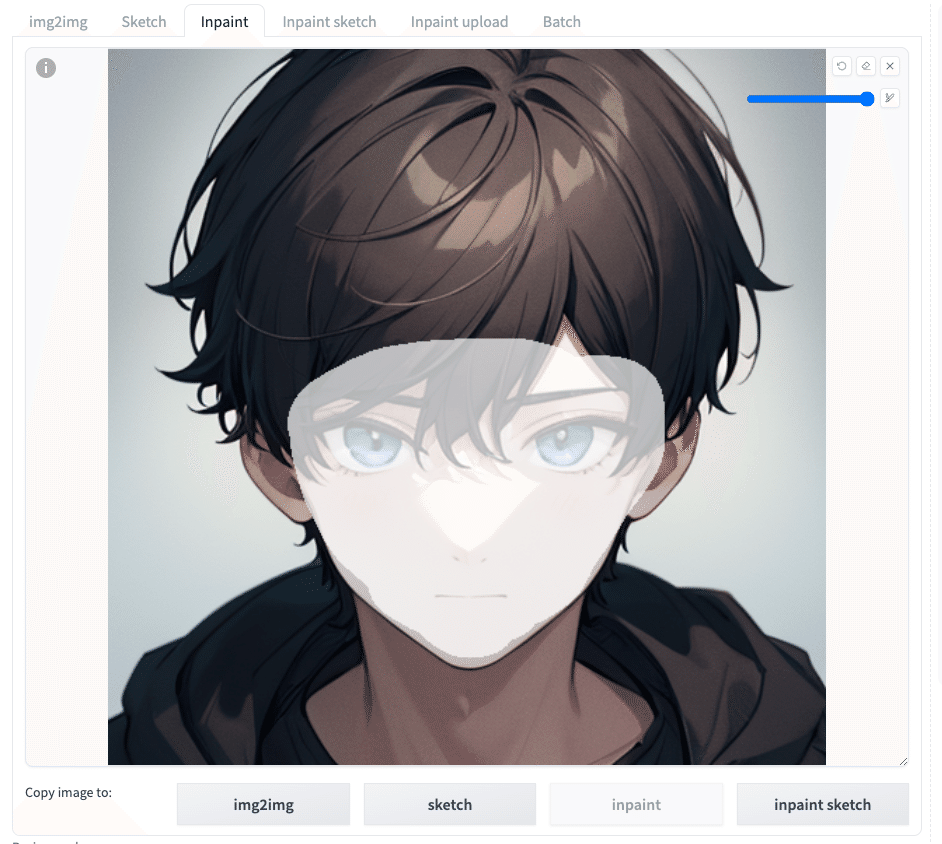

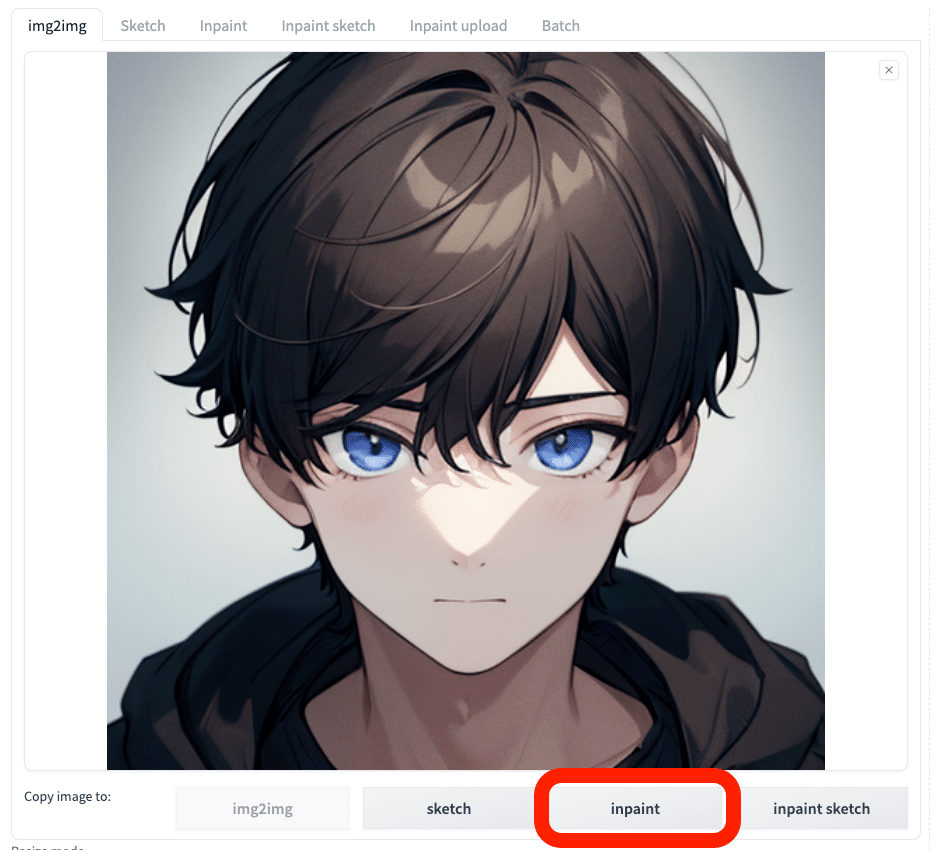

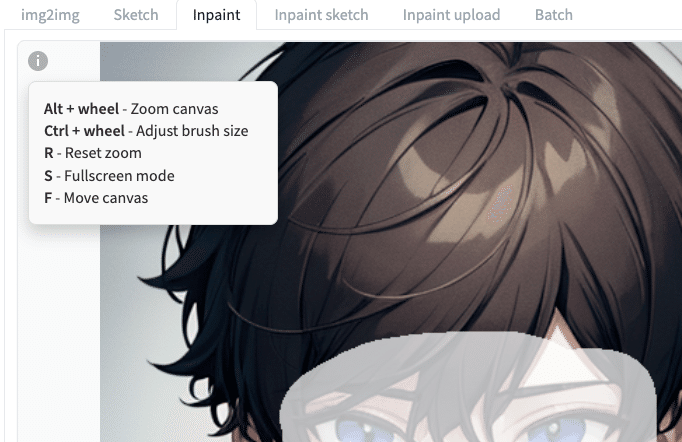

■ Inpaint

「Inpaint」は、画像の一部をマスクして、その部分を編集する機能です。マスクとは「おおい隠す」という意味です。

このように、表情を変えるなど、一部だけを変えたいときに、Inpaintは便利です。

下にあるInpaintをクリックすると、img2imgの画像をそのままInpaintに送ることができて便利です。

また、インペイントは、修正したい時にもよく使います。

インペイントの場合では、インペイントした部分に関するプロンプトだけでも上手くいきます。変化が少ないなと感じたら、元画像のプロンプトは省き、インペイントで変更したい内容だけを入力してください。

あとは、Denoising strengthも有効です。値を上げるほど、変化が大きくなります。

1番左の「戻るアイコン」は、マスクした部分を1回ずつ戻すことができます。

左から2番目の「消しゴムアイコン」は、マスクした部分をまとめて消去できます。

左から3番めの「✕アイコン」は、画像を閉じることができます。

その下の「筆アイコン」は、マスクのサイズを変更できます。

キャンバスにカーソルがある状態で、左上の操作をすると、キャンバスを拡大したりすることができます。

Mask blurは、元画像とマスクした部分の境界を、どの程度ぼかすか設定するところです。値が大きいほど、ぼかしが多くなり、境界部分が滑らかになります。初期設定の4のままで大丈夫です。

Mask modeは、

・Inpaint masked:マスクした部分で画像生成をします。

・Inpaint not masked:マスクした部分以外で画像生成をします。

他のInpaintの機能については、ほぼ使っていなくて、あまり理解していないので省略します。

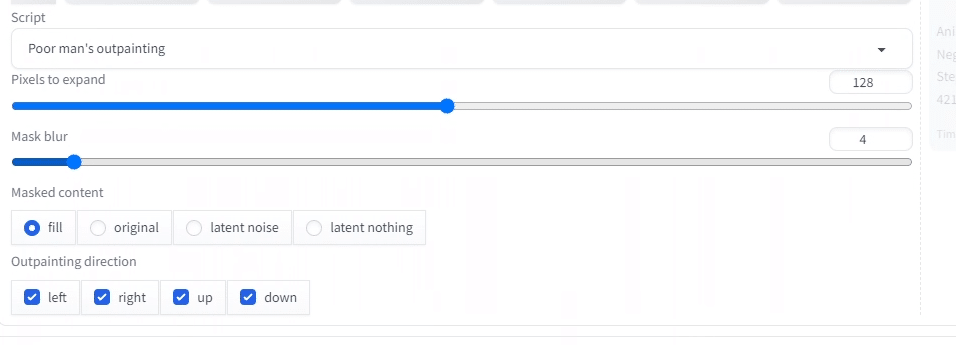

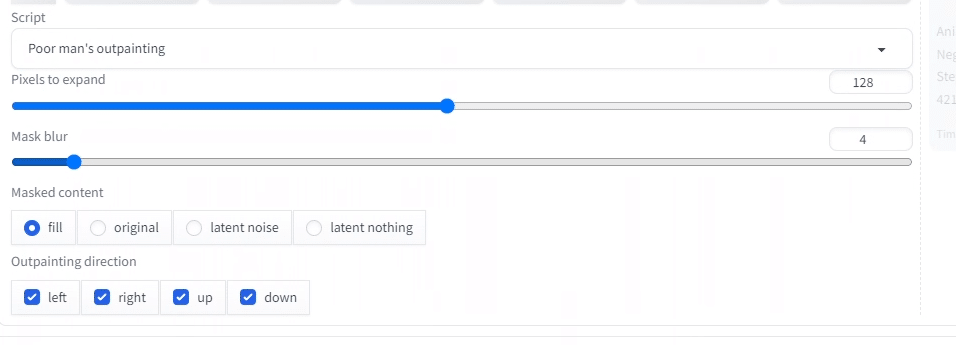

■ Outpaintで、画像の外側を描く

Outpaintには、Scriptの

・Outpainting mk2

・Poor man's outpainting

を使います。

Stable Diffusionのアウトペイントは、クオリティがあまり高くありません。アウトペイントについては、MidjourneyやAdobe Fireflyの方が精度が高いと感じています。

特にSD1.5では、クオリティが低くて、あまり使い物になりません。とはいえ、SDXLでは、絵の破綻が減ったので、SD1.5よりは使えます。

(SD1.5)

どちらも使い方は、似ています。以下のパラメータ設定以外は、内部の技術がよく分からないので省略します。

・Pixels to expand:どれくらい拡張するか

・Mask blur:境界部分を滑らかにする

・Outpainting direction:アウトペイントする方向

アウトペイントは1度で上手くいくことは少ないです。アウトペイントのパラメータを調整するだけではなく、ステップ数やSeedなどの他のパラメータも変えながら調整してください。

■ クオリティを上げる方法 ■

■ 崩れた顔を修正できるAdetailerとは

特に顔が小さく描かれた人物は、顔が崩れた絵になりがちです。インペイントで修正することもできますが、面倒だったり、なかなか直らなかったりします。

そこで、顔の崩れを修正する方法で、比較的簡単であり効果が出やすいのが、Adetailerです。Adetailerとは、生成した画像の顔や手を自動で検出し、修正をしてくれる拡張機能です。

ただし、Adetailerに関しても、万能な機能ではありません。以下が、注意点です。

・手指修正にはあまり効果がない

・顔修正も上手く行かないことがある

・生成時間が1.5倍くらいになる

手指の修正に関しては、ほとんど改善がないので使っていません。顔に関しては、インペイントよりも上手く修正してくれるかな、という感じで、修正がうまく行かないことも多々あります。

まだ改善が望まれますが、顔修正において、現状では1番オススメの方法です。

Adetailerには、細かい機能がたくさんありますが、私は全てを使いこなしている訳ではありません。そのため、基本的な機能に絞って解説します。

□ インストール方法

GitHubの公式ページに行き、緑色のCodeボタン → URLをコピーしてください。

次に、Stable Diffusion画面に移ります。Extensions → Install from URL でURLを貼り付けて、インストールをクリックしてください。

次に、Installed欄で、Apply and quitをクリックしてください。Stable Diffusionを再起動すると、拡張機能がインストールされます。

Seedの下あたりに、拡張機能は表示されます。

□ Adetailerの基本操作

Adetailerを有効にするには、▼マークをクリックして開き、

Enable Adetailerにチェックを入れてください。チェックが入っていると、有効になります。

Adetailerは、処理に時間がかかるので、基本的に顔の生成が上手く行かなかった画像だけに使うのがオススメです。

顔を上手く描けなかった画像を、プロンプト欄にドロップしてください。PNG infoからtxt2imgに送っても大丈夫です。

生成データが表示されるので、矢印マークで、パラメータを割り振ります。モデルは手動で選択してください。

プロンプトやSeedなどのパラメータが同じなので、同じ画像を作ることができます。この状態のまま、Adetailerを有効にし、画像生成をするだけです。同じ画像を作りつつ、顔だけ修正することができます。

結果は以下です。

特に小さい顔は崩れがちですが、Adetailerのおかげで、小さい顔も修正できています。

face 0.8などの数値は、80%の確率で、顔であると認識されていることを意味しています。

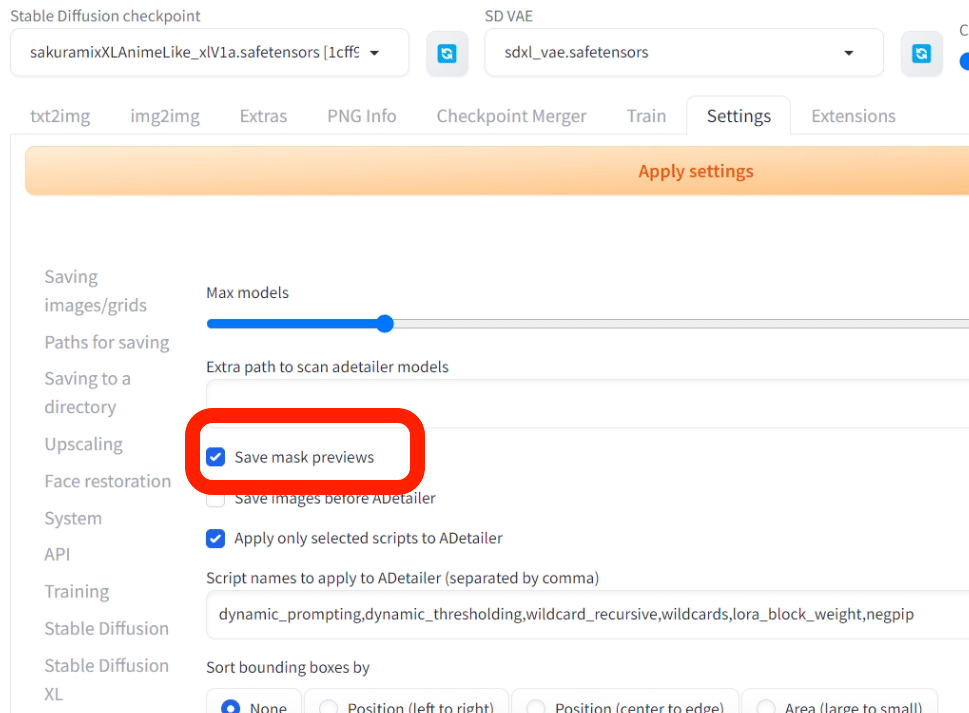

Settings → Adetailerで、Save mask previewsにチェックを入れておくと、数値が表示されるプレビュー画像も保存されます。

ちなみに、img2imgでもAdetailerは使用可能です。

ただし、img2imgだと、絵が変わってしまうので、私はtxt2imgで使っています。img2imgのインペイントでも使えますが、上手くマスクしないと、Adetailerの調整範囲とバランスが合わず、低クオリティになってしまいがちです。

□ Adetailerのモデル

Adetailerのモデルは色々ありますが、face_yoloを使っておけば大丈夫です。yolo系が1番うまくいきます。

公式ページに、違いが記載されていたので、いちおう紹介しておきます。

・yolo系:イラスト系・リアル系の画像の両方に効果的

・mediapipe:リアル系の画像に効果的

手指や体を修正できるモデルも用意されていますが、あまり効果がないので使っていません。また、顔系であっても、あまり効果がない時もあります。

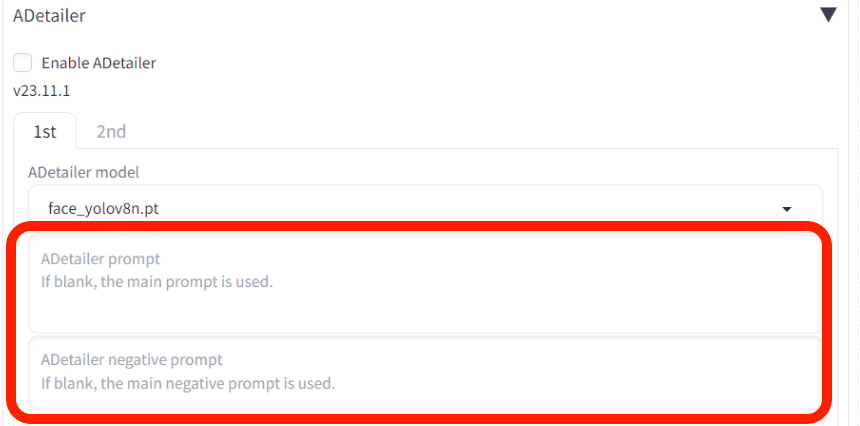

□ Adetailerのプロンプト

ここは、Adetailer用のプロンプト入力欄です。必須ではありません。空白だと、普通のプロンプトが使われます。

表情を変えたい、AdetailerでLoRAを適用したいときは、Adetailer用のプロンプトも書いてください。

□ Adetailerのパラメータ

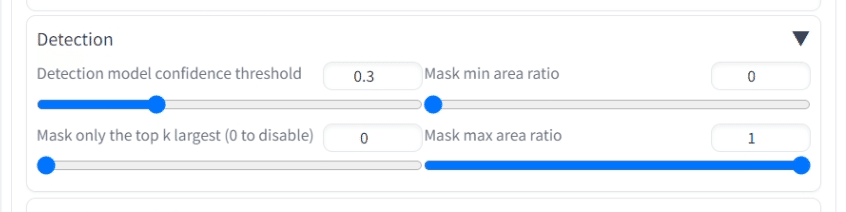

Detection欄では、Detection model confidence thresholdを主に調整します。

例えば初期設定だと、顔の検出値が0.3以上の顔だけ、Adetailerで修正されます。たくさんの顔を修正したいときは、この値を下げてください。

Inpainting欄では、以下をよく使います。

・Inpaint mask blur:Adetailerで修正する部分としない部分の境界のなめらかさを調整。上げるほどなめらかになりますが、ぼやけることがあります。下げるほど、修正した部分としていない部分の境界が目立ちます。

・Inpaint denoising strength:修正度合いの調整。上げるほど大きく変化しますが、絵が破綻することがあります。

■ 参考になる、おすすめサイトの紹介

AIイラストのクオリティを上げるには、まずは上手い人の真似をするところからだと思っています。

これから紹介するサイトなどで、好みの画像があれば、プロンプトをコピペして試してみてください。そして、プロンプトを追加したり、削除したりして、自分のオリジナルを作ってください。

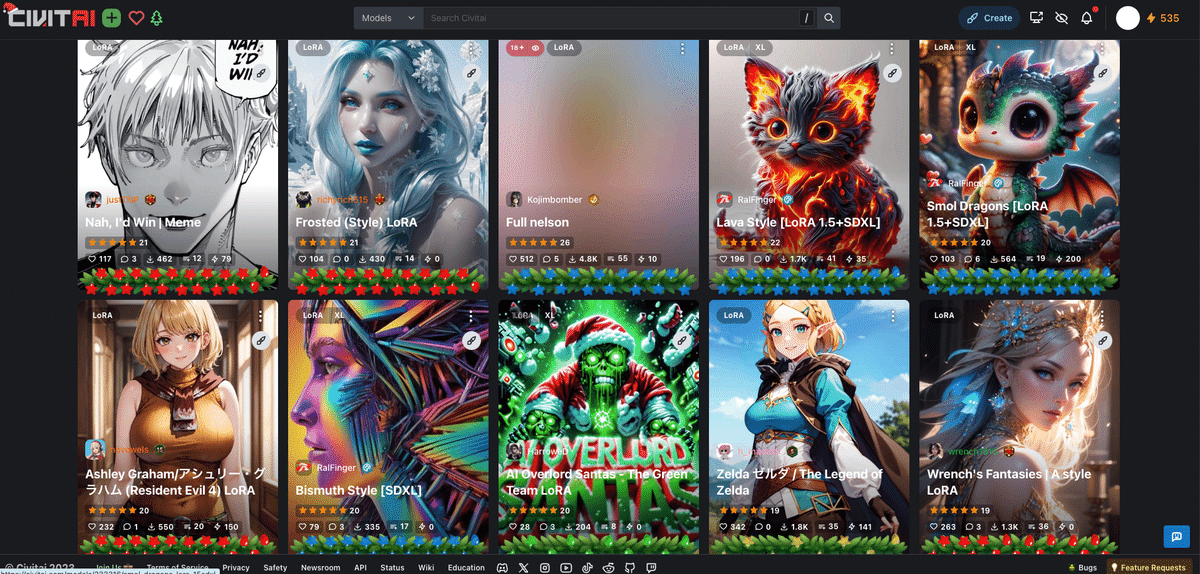

□1.Civitai

Civitaiは、Stable Diffusionのような画像生成AIサービスで使うモデルが共有されているサイトですが、作品も共有されています。

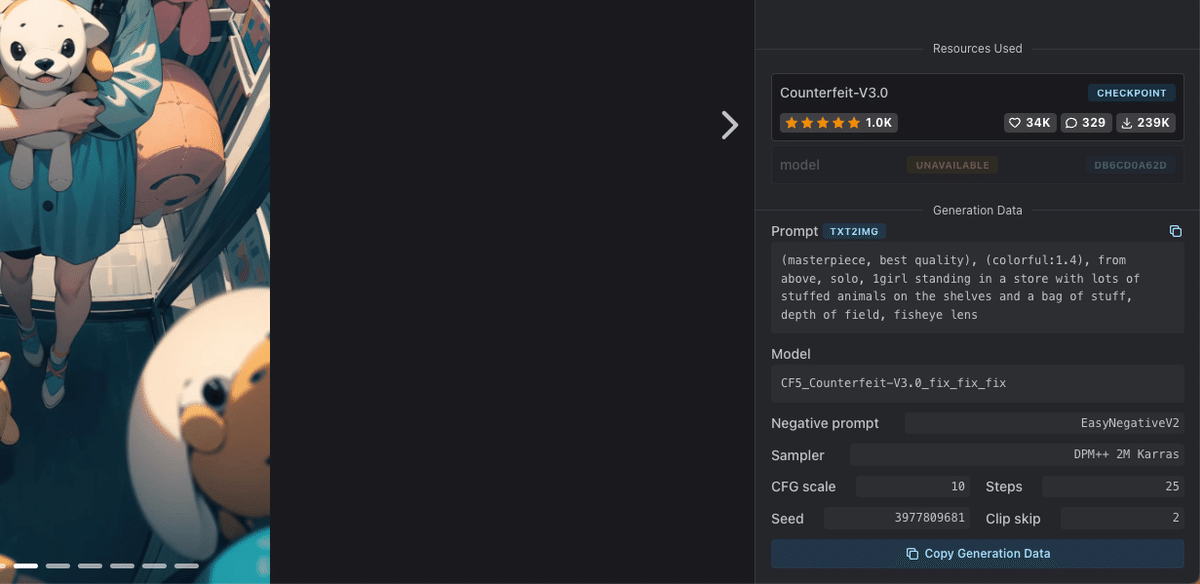

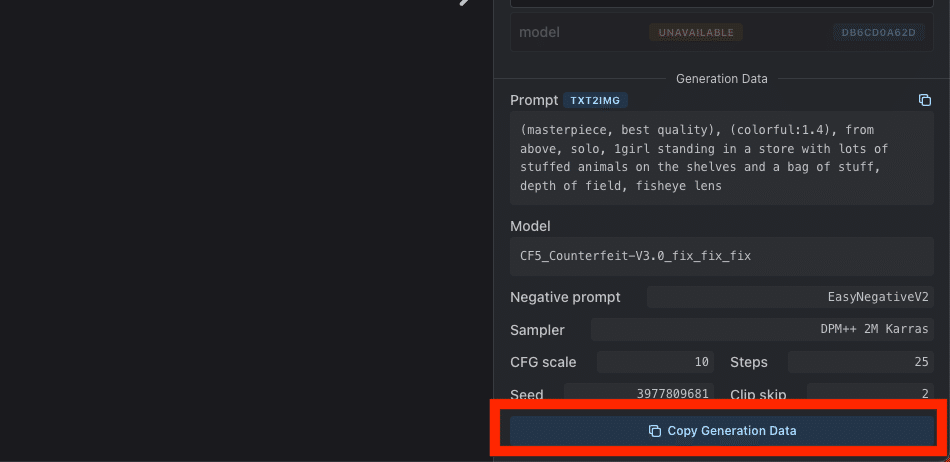

今回は、Counterfeit-V3.0 というモデルで作成された画像に似た画像を作ってみます。

右下のところをクリックしてください。プロンプトとパラメータをコピーできます。

次に、生成データをプロンプト欄に貼り付けて、矢印をクリックします。すると、プロンプトやパラメータを自動で割り振ってくれます。

モデル(チェックポイント)とVAEは、自分で設定してください。

できた画像は、こちらです。元画像 ↓ と近いと思います。

全てのプロンプトやパラメータが同じであれば、同じ画像を作ることができます。

ただし、

・LoRA

・Embedding

・外部のアップスケーラー

など、特殊なものを使ったいる場合は、同じ画像にはなりません。

□2.PromptHero

高品質な画像が掲載されているサイトです。

プロンプトなどの、生成データが公開されている画像もあるので、学びになります。また、こちらのサイトは外国人ユーザーが多いので、絵柄の幅が広いです。

こちらも、生成データが公開されている作品があり、参考になります。ただしCivitaiとは違い、生成データは1つずつコピーする必要があります。

Seedは公開されていないので、完璧な再現はできませんが、ある程度、似た画像は作れます。

□3.chichi pui

こちらは、日本人ユーザーが多いサイトです。美少女系の画像が多いので、美少女を作りたい方におすすめです。

□4.AIイラスト呪文生成器

種類別に用意されているワードを選択していくだけで、プロンプトが作れるサイトです。

■ チャットAIにプロンプトを考えてもらう

□ 物語からプロンプト

クオリティが高い1枚絵を作るなら、プロンプトはある程度たくさんあった方が良いです。プロンプトが少ないと、シンプルでありきたりな絵になります。

以下の、プロンプトの例を使うのも1つの方法です。

・テーマ:人物、動物、キャラクター、場所、物体など

・絵柄/画風:写真、イラスト、水彩画、油絵など

・場所:学校、オフィス、宇宙、戦場、海、街中、東京など

・照明:太陽光、シネマティック、スポットライト、スタジオライトなど

・色合い:鮮やか、淡い、明るい、単色、カラフル、白黒、パステルなど

・カメラ:ポートレート、ヘッドショット、クローズアップ、広角など

また、ChatGPTに考えてもらうこともできます。以下が例です。

私:あなたに短い物語を考えてもらいます。私がテーマを1つ選ぶので、題名と内容を端的にいくつか挙げてください。

私:あなたに短い物語を考えてもらいます。私がテーマを1つ選ぶので、題名と内容を端的にいくつか挙げてください。内容は、医学とテクノロジーに関してでお願いします。

上記のように、ChatGPTにまず物語のテーマを提案してもらいます。テクノロジー、恋愛、スポーツなど、こちらからテーマを絞った上で提案してもらうのが、オススメです。

ChatGPTが、いくつか物語案をくれます。そこから1つ選択し、次のように再度お願いをします。

私:

題名: 「遺伝子の再設計」

内容: 遺伝子編集技術の進化により、遺伝子病を完全に治療する時代が到来。主人公の遺伝学者は、この技術を使って新たな人類を創造しようとするが、彼の野望は倫理的な論争を巻き起こす。

上記について、あらすじを短めの文章で4つ挙げてください。

すると、ChatGPTがあらすじを送ってくれるので、それを画像生成に使います。

私:あらすじ1についての画像を生成してください。必要があれば、内容を詳細に盛り込んでください。

結果が、以下です。

この方法のメリットは、物語に沿って画像生成をしてもらうので、プロンプトの内容が豊富になることです。また、画像にストーリー性も生まれます。

ただし、考えてもらったプロンプトが、画像として必ず反映されるわけではないのが、Stable Diffusionの現状です。DALL-E3は最もプロンプトのくみ取り能力が高いですが、それでも絵に表現できないことは多くあるので、テクノロジーの発展を待つ必要があります。

また、今回は使っていませんが、ControlNetを使用すると、ある程度は同じキャラクターを保ったまま画像生成できます。ただし、こちらも仕事レベルで使えるかと言うと微妙なレベルです。

ちなみに、今回の物語を考えてもらう以外にも、方法は色々あります。例えば、以下です。

・サムアルトマンが描く理想の未来を教えてください。

・20年後の中国のテクノロジー最先端都市は、どのようになっていると予想しますか?

など、偉人の考えや、未来予想をプロンプトに変えてもらう方法もあります。

□ 特徴を質問させる

次は、自分が描きたいことが、ある程度は決まっている場合に有効です。

以下は、一例です。

私:画像生成をするために、キャラクターの特徴を一緒に考えてもらいます。以下が特徴です。他に特徴を教えるので、10個くらい私に質問してください。

・年齢:50歳の大男

・種族:鬼と人間のハーフ

・髪:アフロドレッドの黒色ロングヘア。オールバック。

・肌:赤みを帯びたアジア人の肌色

・体型:筋骨隆々。人間離れした筋肉。

・表情:怒りの目つき。歯を食いしばっている。

・入れ墨:右肩に鱗模様の入れ墨

・背景:燃えた、戦場の跡地

・服:上裸。ボロボロの太い綱のベルト。ボロボロの軍服。

ChatGPT:

素晴らしいキャラクターの特徴ですね!画像を生成するために、もう少し詳細を教えていただけますか?このキャラクターはどのような武器やアイテムを持っていますか?

キャラクターの足元にはどのような靴や足装束をしていますか?

キャラクターの表情には特別な特徴がありますか?例えば、特殊な形の眉毛や目など。

鬼の特徴として、角や特殊な耳などがありますか?

キャラクターの手には特別な特徴がありますか?例えば、長い爪や特殊な装飾など。

キャラクターの入れ墨には特別な色やデザインがありますか?

ボロボロの軍服の詳細をもう少し教えていただけますか?例えば、特定の色やデザイン、バッジなど。

キャラクターの背景には他に何か特別な物がありますか?例えば、破壊された建物や特定の風景など。

キャラクターのポーズや姿勢には特別なこだわりがありますか?

このキャラクターに関連する他のキャラクターや物語の要素がありますか?

これらの追加情報を教えていただければ、より詳細な画像を作成することができます。

あとは、ChatGPTの質問に答えて、画像生成するだけです。

・顔

・服装

・武器

など、限定すると、さらにChatGPTも質問しやすくなると思いますし、ありきたりな内容になりにくいです。

次も、チャットAIを使う方法です。今回は、ChatGPTにキャラクターデザインを考える補助をしてもらいます。

キャラデザを考えるのが面倒な場合も、以下の方法を使えば、内容を整理してプロンプトに落とし込むことができます。

私:キャラクターを生成するためのプロンプトを考えてもらいます。まず、見た目の細かい特徴について私が答えるので、20個くらい質問してください。

ChatGPT:

キャラクターの性別は何ですか?

このキャラクターの年齢範囲は何歳ですか?

キャラクターの身長はどれくらいですか?

彼らの体型はどのようなものですか(細身、筋肉質、ぽっちゃりなど)?

髪の長さはどのくらいですか?

髪の色は何色ですか?

髪のスタイルはどのようなものですか(ストレート、カーリー、アップスタイルなど)?

目の色は何色ですか?

彼らの肌の色はどのようなものですか?

顔の特徴は何かありますか(ほくろ、しわ、傷など)?

彼らはメガネやコンタクトを使用していますか?

彼らの服装スタイルはどのようなものですか(カジュアル、フォーマル、ユニークなど)?

アクセサリーは身に着けていますか(指輪、ネックレス、ブレスレットなど)?

彼らの足のサイズはどのくらいですか?

靴のスタイルはどのようなものですか(スニーカー、ブーツ、サンダルなど)?

タトゥーやボディアートはありますか?

彼らの好きな色は何色ですか?

キャラクターの性格はどのようなものですか?(これが外見に影響を与える場合)

彼らの職業や役割は何ですか?(これが服装やアクセサリーに影響を与える場合)

彼らに持たせたいアイテムや小道具はありますか?

これらに回答していき、「最後にStable Diffusion用のプロンプトを書いてください」と送信すれば、プロンプトを作ってもらえます。結果は以下です。

この方法は、「漠然と描きたいことは思い浮かんでいるけど、言語化できていないとき」などに便利なので、試してみてください。

■ 上手い人を真似る方法(画像からプロンプトを推測)

上手い人のAIイラストを真似したいと思っても、プロンプトが公開されていないこともあります。そこで役に立つのが、画像からプロンプトを推測する方法です。

画像から新たな画像を生成する方法(image to imageやimg2imgと呼ばれる)では、元画像と似すぎてしまい、丸パクリになりがちです。しかし、画像からプロンプトを推測する方法では、雰囲気は似ますが、同じ絵にはならないので、丸パクリになりにくいというメリットがあります。

また、この方法は、自分でプロンプトを考える手間を減らせるので、面倒くさがりな人にオススメです。

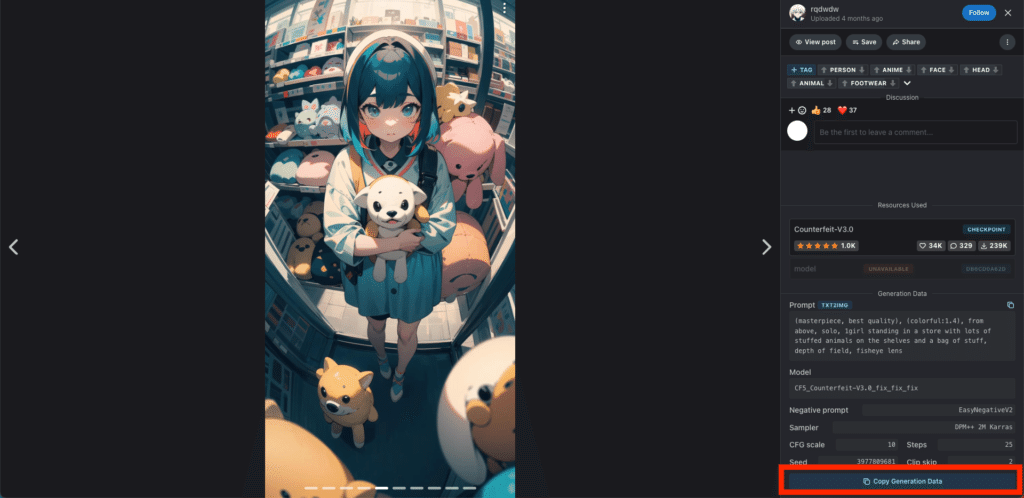

今回は、この画像に似た画像を生成します。Counterfeitというモデルで生成された画像です。

プロンプトなどの情報が公開されているので、同じ画像を作ることもできますが、プロンプトは見ずに似せることが今回の目的です。

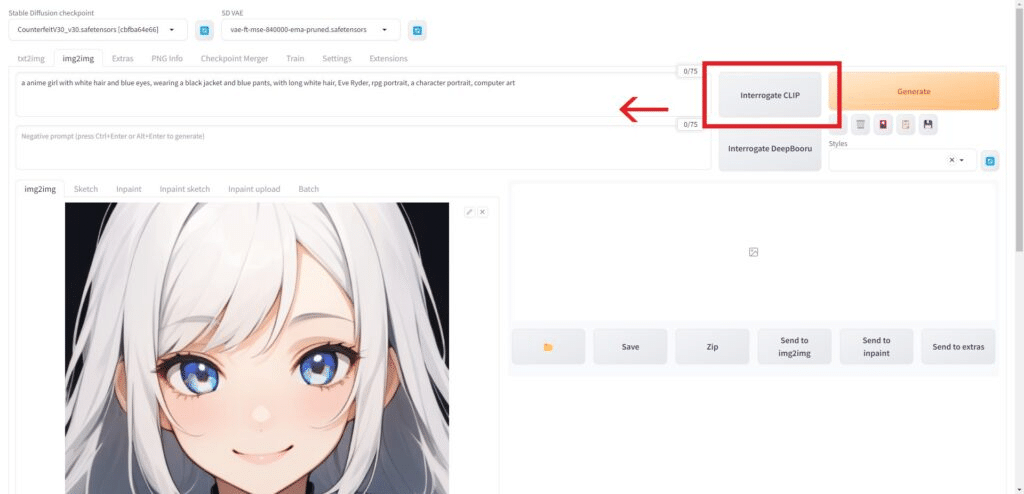

□ Interrogate CLIP/DeepBooru

「Interrogate CLIP/DeepBooru」は、画像からプロンプトを推測してくれる機能です。画像を完璧に再現できるプロンプトを提供してくれるわけではありませんが、似たような画像は生成することができます。

画像をアップロードして、「Interrogate CLIP/DeepBooru」をクリックするだけです。初めて実行するときだけ、数GBのモデルがダウンロードされるので、数分~数十分かかります。

Interrogate CLIP/DeepBooruは同じような機能です。試してみてください。

結果は以下のとおりです。

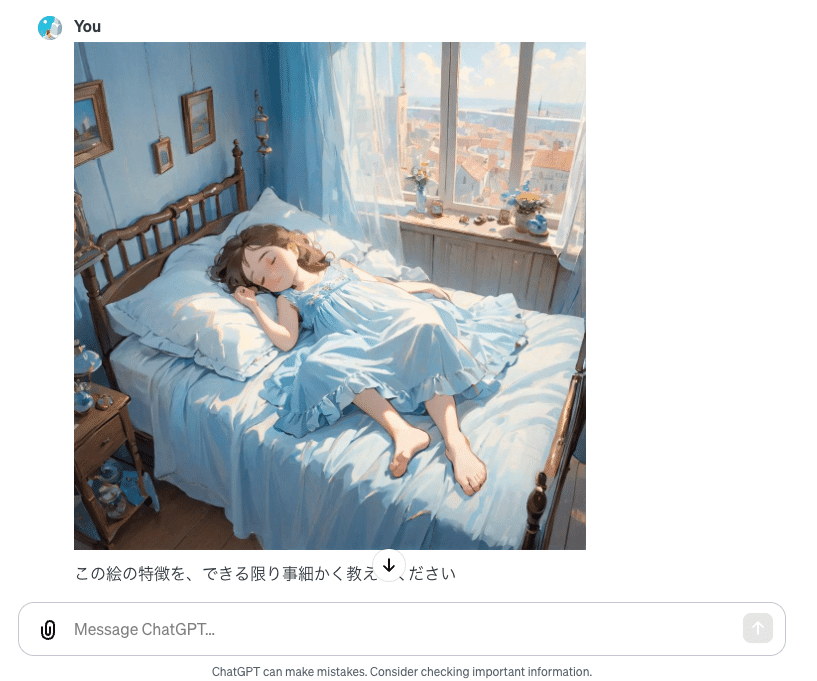

□ ChatGPTなどのチャットAIに聞く

次は、チャットAIにプロンプトを推測してもらいます。ChatGPTやBing AIで可能です。

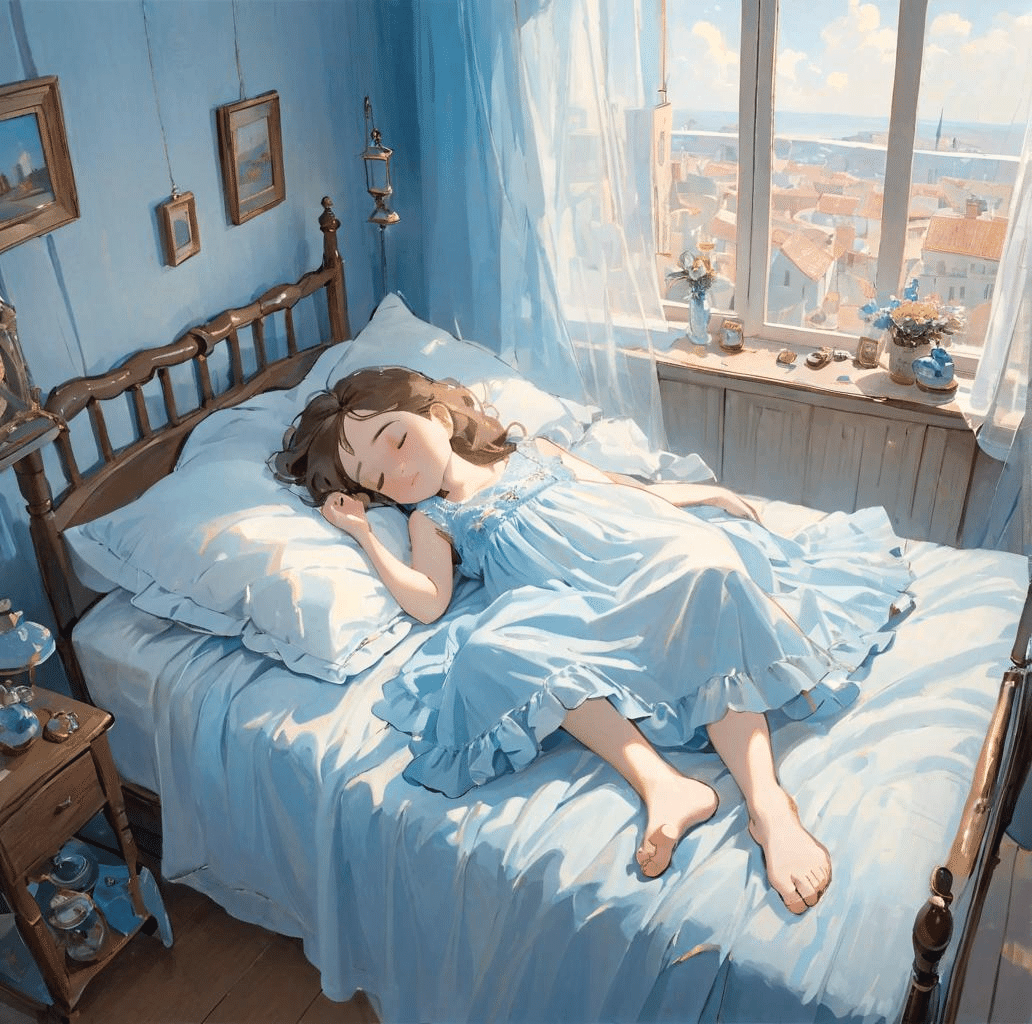

私:この絵の特徴を、できる限り事細かく教えてください

ChatGPT:この絵の特徴は次のとおりです:

キャラクター: 画像の中央には、穏やかな表情で眠る若い女の子がいます。彼女の肌はなめらかで、頬はわずかに赤みを帯びています。

髪型: 彼女の髥は茶色がかった黒で、自然に波打っており、ベッドの枕に広がっています。

ドレス: 女の子は膝丈の水色のドレスを着ており、フリルが特徴です。ドレスは柔らかい布でできているように見えます。

ポーズ: 女の子は仰向けに横たわり、両腕を柔らかく曲げ、一方の足をもう一方の足の上に軽く置いてリラックスしています。

光と影: 部屋は自然光で満たされており、柔らかい影がベッド、床、壁に落ちています。

ベッド: アンティーク風の木製ベッドフレームがあり、ベッドカバーと枕も水色で統一されています。

部屋の装飾: 壁には絵画が飾られ、サイドテーブルには花瓶が置かれ、青と白の装飾品が見られます。

窓と景色: 窓からは青い空と海沿いの町が見え、窓辺には風に揺れるカーテンがあります。

全体の雰囲気: 絵全体には落ち着いた、平和で静かな雰囲気が漂っています。

これらの詳細は、絵が持つリラックスした雰囲気と、細かなディテールへのこだわりを反映しています。

私:それらの特徴を盛り込んだStable Diffusion用のプロンプトを書いてください

こんな感じで依頼します。

ChatGPTに搭載されているDALL-E3では、文章でも画像生成できるので、ChatGPTはよく文章でプロンプトを書いてきます。そのため、命令文や会話文ではなく、フレーズをカンマで区切って記述するように依頼してください。

生成結果は、以下のとおりです。

今回の画像からプロンプトの推測については、Interrogate DeepBooruとChatGPTが、元画像に近い画像を生成できました。画像ごとに変わるので、試してみてください。

生成された結果を見て、過不足があれば、ChatGPTにプロンプトを修正してもらったり、自分で修正します。

ChatGPTは、けっこう的確に元画像の内容を、文字に起こしてくれます。とはいえ、Stable Diffusionのプロンプトくみ取り能力はあまり高くないので、プロンプト通りの画像生成は、あまりしてくれません。そのため、似せることにこだわると、相当な時間がかかってしまうのが、現状です。

とりあえずは、ある程度、雰囲気が似た画像を作ることはできます。人間の手直しは必要ですが、このような方法で、上手い人を真似ることができます。

□ 人間の手で微調整

ChatGPTで推測されたプロンプトに、さらに私が調整した結果が以下です。

■ コピペOK!プロンプトのテンプレート / SDXLとSD1.5の比較 ■

プロンプトの例は、以下のとおりです。

・テーマ:人物、動物、キャラクター、場所、物体など

・絵柄:フォトリアル、イラスト、水彩画、油絵など

・場所:学校、オフィス、宇宙、戦場、海、街中、東京など

・照明:太陽光、シネマティック、スポットライト、スタジオライトなど

・色合い:鮮やか、淡い、明るい、単色、カラフル、白黒、パステルなど

・カメラ:ポートレート、ヘッドショット、クローズアップ、広角など

全て含める必要はなく、順番もあまり気にする必要はありません。単語が50個以上くらいの長文になったら、重要なプロンプトは、できるだけ前の方に位置させてください。前の方が、画像に反映されやすいです。

今回は、カメラや照明に関するプロンプト一覧を、紹介していきます。カメラアングルや照明を変えるだけで、絵は全く違ったものになります。ぜひ試してみてください。

□ 基本

ネガティブ: adult, makeup, nsfw, dyed hair, skirt(以降ネガティブは同じ)

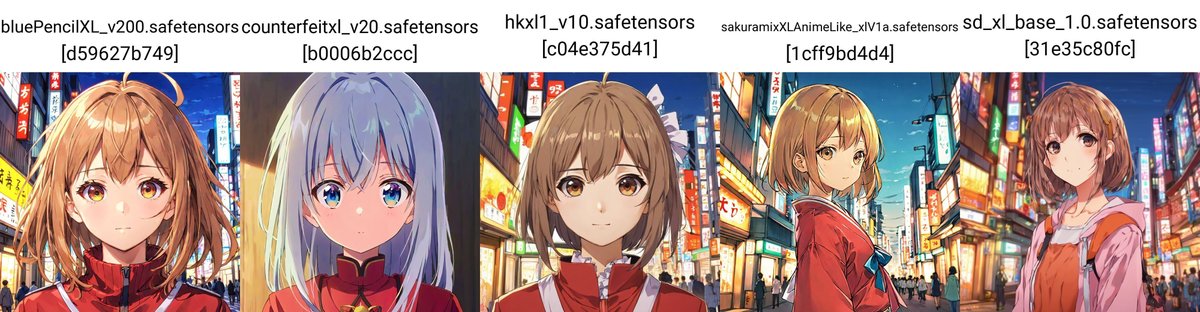

SDXL

ネガティブ: adult, makeup, nsfw, dyed hair, skirt(以降ネガティブは同じ)

SD1.5

SD1.5のみHires.fixあり

これがリアル系の基本プロンプトです。ここに、プロンプトを1つだけ追加し、そのプロンプトの影響度合いを確かめます。ネガティブプロンプトやSeedは、固定しています。上がSDXL、下がSD1.5です。

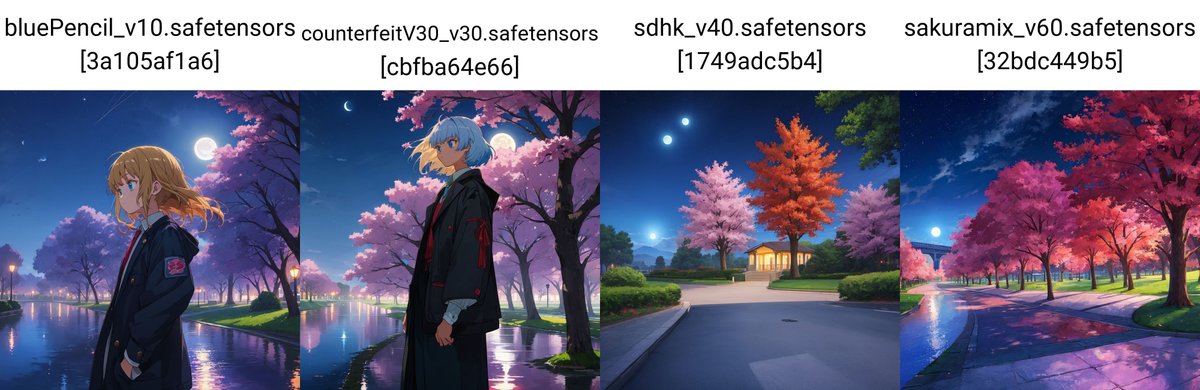

ネガティブ:monochrome, nsfw(以降ネガティブ同じ)

SDXL

ネガティブ:monochrome, nsfw, bad quality(以降ネガティブ同じ)

SD1.5(Hires.fixあり)

同様に、こちらはイラスト系のベースです。プロンプトを1つだけ追加し、そのプロンプトの影響度合いを確かめます。ネガティブプロンプトやSeedは、固定しています。上がSDXL、下がSD1.5です。

□ 最高品質の照明

最高品質のライティングを意味する

・Highest quality lighting

・Top quality lighting

をプロンプトに入れることで、光の当たり具合が良くなることがあります。

□ 美しい光と影

照明の手法よりも、結果的にどう見えるかをプロンプトに入れた方が、絵に反映されやすいこともあります。

□ コントラスト

コントラストとは、明暗や鮮やかさの差のことです。強いコントラスト、あるいはハイコントラストは、光が当たっている部分と、光が当たらず影になっている部分が、はっきりと別れているのが特徴です。

コントラストについては、イラスト系のモデルの方が変化が分かりやすいです。以下のリアル系のモデルの画像では、上手くいっていません。

□ 太陽光 / 快晴

太陽光は明るくしたいときに使いますが、これだけだと明るさが微妙な場合も多いです。そのため、青空・快晴・明るいなどのプロンプトを、付け加えることをオススメします。

□ 黒い背景

黒い背景にすると、被写体が際立ちます。ライティング手法に、クロスライティングがありますが、Stable Diffusionだと中々反映されないので、

・black background

・dark background

というプロンプトを使います。今回は、「park」というプロンプトを除外して生成しています。

絵をシンプルにしたい場合は、「white background」などもオススメです。

□ 色付き照明

□ 逆光、リム照明

逆光とは、カメラを光の方向に向けて撮影する方法です。被写体を際立たせたいときに使います。リム照明とも呼ばれます。似たものに、シルエット照明もあります。

・backlighting

・Rim Lighting

・silhouette lighting

SDXLは、逆光のプロンプトの効きが悪かったです。

□ 木洩れ日

木洩れ日は、

・sunlight filtering through trees

・dappled sunlight

というプロンプトを使います。

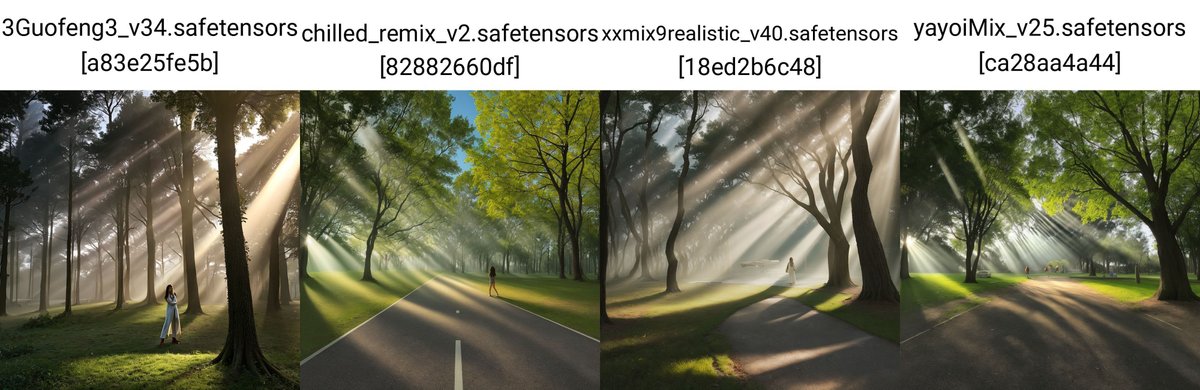

SD1.5

SD1.5

SDXL

SDXL

SD1.5

SD1.5

□ 放射線状の光

放射線状の光は、crepuscular raysというプロンプトを使います。

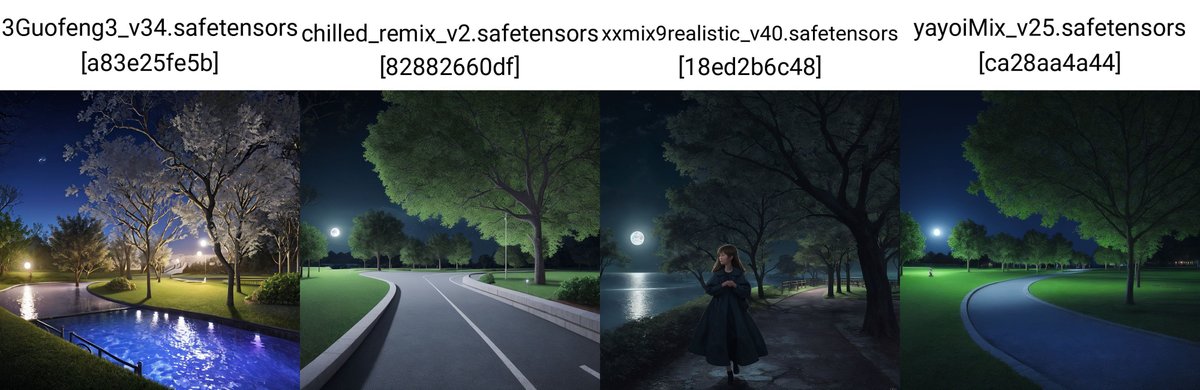

□ 光の線

□ 月明かり

□ レンズフレア

レンズフレアとは、とても明るい光がレンズに入り、円形の光などが画像として現れる状態です。

□ 柔らかい光

□ 下からの光

SDXLでは、品質系のプロンプトを入れなくても、高品質な画像が作れます。わざわざ、「最高品質、詳細、8k」などと入れなくても良くなり、描きたいことのみ記述すれば大丈夫です。

ただし、ランダム性や動き、多様性が少なくなったと感じます。LoRAを使ってるんじゃないかと思うほど、似たキャラが出てきます。品質系のプロンプトの重要性は下がった一方で、キャラクターに多様性や動きを与えるプロンプトが必要になった気がします。

Stable Diffusionは、DALL-E3のようにプロンプト通りには、あまり生成されません。そのため、自在に扱えるようになるにはまだ時間がかかりそうです。

■ カメラ 編

□ 基本

ネガティブ: adult, makeup, nsfw, dyed hair, skirt(以降ネガティブは同じ)

SDXL

ネガティブ: makeup, nsfw, dyed hair, skirt, infant, worst quality(以降ネガティブは同じ)

SD1.5

ネガティブ:monochrome, nsfw(以降ネガティブ同じ)

SDXL

ネガティブ:bad quality(以降ネガティブ同じ)

SD1.5はHires.fixあり

□ ハイアングル(上から撮影)

カメラを上から下に向けて撮影することを、ハイアングルと言います。カメラを構える位置は、関係ありません。

□ ローアングル(下から撮影)

カメラを下から上に向けて撮影することを、ローアングル、あおり撮影と言います。カメラを構える位置は、関係ありません。

その他、以下のような撮影方法があります。ただし、画像に反映されるとは限りません。

・ハイポジション:人の目線より高い位置で撮影すること。カメラの角度は、関係ありませんが、ハイアングルと相性が良いです(上からの景色撮影など)。

・アイレベル:人の目線と同じ位置で撮影すること。カメラの角度は、関係ありません。

・ローポジション:人の目線より低い位置で撮影すること。カメラの角度は、関係ありませんが、ローアングルと相性が良いです(下からの建物撮影など)。

□ 全身

全身は、「full body」がよく使われています。その他、足元に関する記述、例えば靴やズボンの内容を含めると、全身の絵になりやすいです。また、縦長画像にすると、全身が生成されやすくなります。

□ 上半身

上半身を表現するには、以下を使います。

・waist shot:腰から上

・upper body:上半身

他にも、

・shoulder shot

・bust shot

などがあります。

□ 横顔

横顔は、

・profile angle

・side angle

などで表現します。

□ ドアップ

(extreme) close upは、顔のドアップになるプロンプトです。

SDXL

肌に関することを入れると、ドアップになりやすいです。

□ ボケ

背景をぼかすことで、被写体に集中させることができます。「Bokeh(photo)」というプロンプトを使います。

□ 長時間露光

長時間露光とは、シャッタースピードを遅くして(シャッターが開いている時間を長くして)撮影する方法です。シャッタースピードを遅くすることで、レンズから多くの光を取り込むことができます。

SDXL

かろうじて、SDXLの公式モデルのみ反映されました。SD1.5では反映されませんでした。

SD1.5

□ 後ろ姿

後ろ姿は、

・back shot

・back view

・from behind

というプロンプトを使います。

□ よそ見をする

AIイラストは、カメラ目線が多いので、プロンプトで工夫が必要です。

・look away

・looking away

というプロンプトが有効です。

□ 見上げる / 見下ろす

・look up / down

・looking up / down

□ 閉じた目

閉じた目は

・closed eyes

・eyes closed

というプロンプトを使います。

□ 横たわっている

横たわっている状態は

・lie down

・lying

というプロンプトを使います。

□ 広角レンズ / 魚眼レンズ

広角レンズとは、広い範囲を撮影できるレンズです。魚眼レンズは広角レンズの一種ですが、特に歪みを強調していて、画面中央の被写体が大きく、周囲が小さく写ります。

□ モーションブラー

動いている感じを表現するなら、「motion blur」というプロンプトがオススメです。絵の動きが少ないなと思ったら、よく追加しています。

□ シルエット

細部は描かず、大枠だけを表現したい場合は、「silhouette」がオススメです。

□ 遠くから撮影

■ 品質編

□ SDXL

ネガティブ: adult, makeup, nsfw, dyed hair, skirt

SDXL

ネガティブ: adult, makeup, nsfw, dyed hair, skirt

SDXL

上がベースで、下が品質系プロンプトをたくさん入れた画像です。

SDXLでは、品質系のプロンプトを入れても、あまり品質に違いはありません。テクノロジーの発展を考えると、画像生成AIの品質は上がっていくはずです。そのため、品質系のプロンプトの重要度は、下がっていくと思っています。

プロンプトを増やすほど、重要なプロンプトの影響度も薄まってしまうので、絵に含めたい事だけ、記述しておくことをオススメします。

ネガティブ: adult, makeup, nsfw, dyed hair, skirt

ネガティブ: adult, makeup, nsfw, dyed hair, skirt, worst quality, bad quality, low quality, ugly

ネガティブプロンプトをたくさん入れても、やはり品質はさほど変わりません。

ネガティブ:なし

ネガティブ:なし

ネガティブ:なし

ネガティブ:worst quality, bad quality, low quality, ugly

□ SD1.5

ネガティブ: adult, makeup, nsfw, dyed hair, skirt

SD1.5

SD1.5のみHires.fixあり

ネガティブ: adult, makeup, nsfw, dyed hair, skirt

ネガティブ: adult, makeup, nsfw, dyed hair, skirt

SD1.5

SD1.5のみHires.fixあり

ネガティブ: adult, makeup, nsfw, dyed hair, skirt, worst quality, bad quality, low quality, ugly

最近は、高品質なモデルが増えてきているので、SD1.5でも品質系プロンプトの重要度は下がりつつあります。とはいえ、特にネガティブプロンプトを入れた方が、品質は上がりやすいです。

SD1.5を使うときは、品質系のプロンプトはまだ必要です。

ネガティブ:なし

Hires.fixあり

ネガティブ:なし

Hires.fixあり

ネガティブ:なし

Hires.fixあり

ネガティブ:worst quality, bad quality, low quality, ugly

Hires.fixあり

■ その他

□ 基本

ネガティブ: adult, makeup, nsfw, dyed hair, skirt(以降ネガティブは同じ)

SDXL

ネガティブ: adult, makeup, nsfw, dyed hair, skirt(以降ネガティブは同じ)

SD1.5

SD1.5のみHires.fixあり

これがベースです。

ネガティブ:なし

ネガティブ:なし

Hires.fixあり

□ 濃い色合い

・vivid colors

・vibrant colors

・high saturation

・Colorful

SDXL

SD1.5

あとは、

・monochrome(白黒)

・pale color(薄い色)

などを、ネガティブプロンプトに入れるのも効果的です。

SDXL

SD1.5

■ 特殊な絵を作るには ■

■ LoRAとは

LoRA(Low-Rank Adaptation)とは、少ない計算量で追加学習できるAI技術です。LoRAモデルを使うことで、より簡単に特定の絵柄を生成できるようになります。

例えば、

・特定のキャラクター

・特定の服装、髪型、ポーズ

・特定の絵柄

などを、簡単に生成できます。

プロンプトで表現するのが難しい内容があったら、LoRAモデルを探してみてください。プロンプトを工夫するよりも簡単に、絵を作れるかもしれません。

モデル(チェックポイント)と言われるものは、次のように分けることができます。

SDXLの公式モデル(ベースモデルや初期モデルとも言われている。基本的に1つ)

SD1.5の公式モデル(ベースモデルや初期モデルとも言われている。基本的に1つ)

SDXLをベースにしたモデル(チェックポイントとも呼ばれている。無数にある)

SD1.5をベースにしたモデル(チェックポイントとも呼ばれている。無数にある)

私たちが普段よく見ていて使っているのは、4つのうちの後半2つです。それらのモデル(チェックポイント)は、公式モデルをベースに追加学習(fine-tuning)を行っていて、特定の画風に特化したモデルになっています。

オールラウンダーである公式モデルのみよりも、特化学習させたモデルの方が、望み通りの画像が出てくれてクオリティが高くなりやすいです。例えば、日本人に特化させて学習させたモデルの方が、人種まんべんなく学習させたモデルよりも、高品質に日本人を生成してくれます。

そして、さらに絵柄を特化した画像を生成したいときに使うのが、LoRAモデルです。特定の人物や、キャラクターを生成できます。LoRAモデルは、単体では使わず、チェックポイントとセットで使います。

注意点は以下のとおりです。

・効果がないこともある

・元画像と絵柄が乖離することがある

・SDXL、SD1.5バージョンごとの、LoRAモデルを使う必要がある

LoRAは、モデルよりもはるかに多くて、玉石混交です。

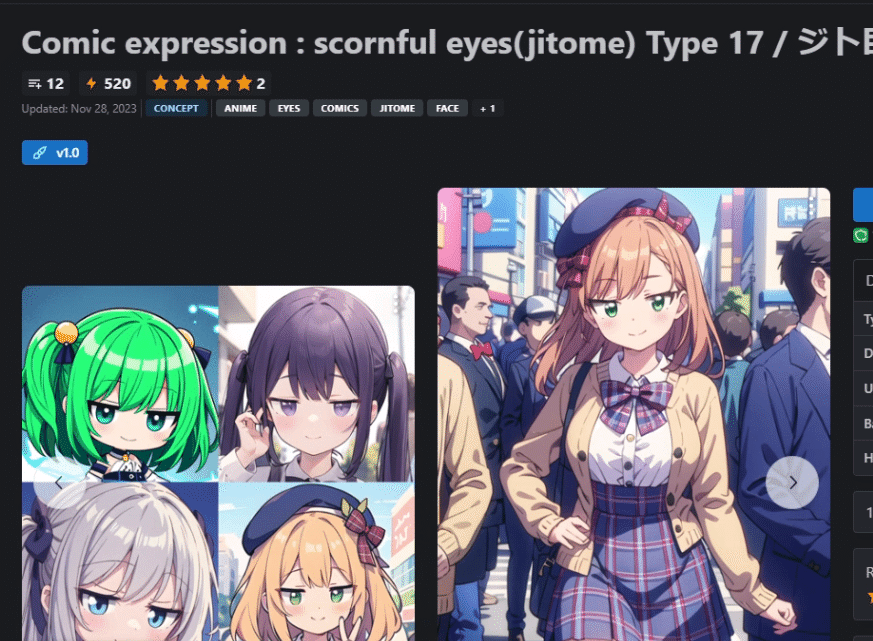

□ LoRAの紹介

いくつか紹介します。ただし、私が使ったことが無いのも含まれているので、効果があるかどうかは分かりません。

デフォルメされた目を表現できるLoRAモデルです。

・Comic expression : scornful eyes(jitome) Type 17 / ジト目 Type 17

・Comic expression eyes 10 / デフォル眼10

・Detail Tweaker LoRA (细节调整LoRA)

・Detail Tweaker XL

描き込みを追加できる、有名なLoRAモデルです。逆にマイナスにすることで、よりシンプルな絵にするこもできます。

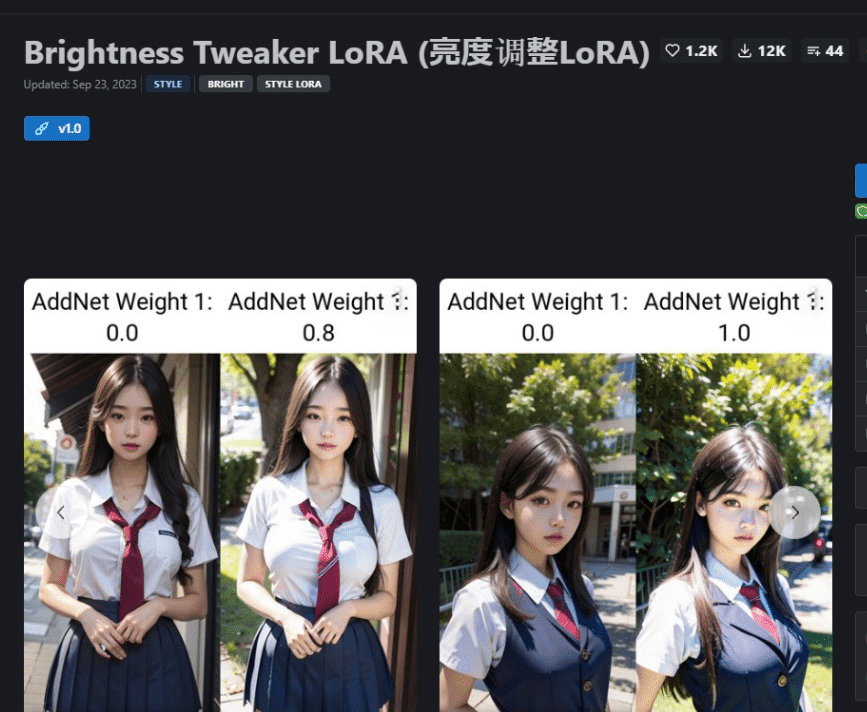

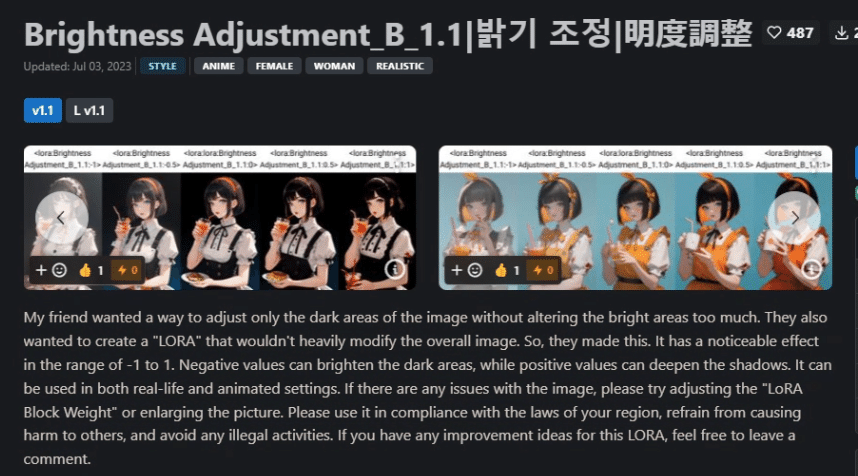

これらは、明るさを調整できるLoRAモデルです。

・Brightness Tweaker LoRA (亮度调整LoRA)

・Brightness Adjustment_B_1.1|밝기 조정|明度調整

・Reference Sheet / Model Sheet

・CharTurnerBeta - Lora (EXPERIMENTAL)

・五视图角色立図绘(多观观人观)

キャラデザ設定画が表現できるLoRAモデルです。

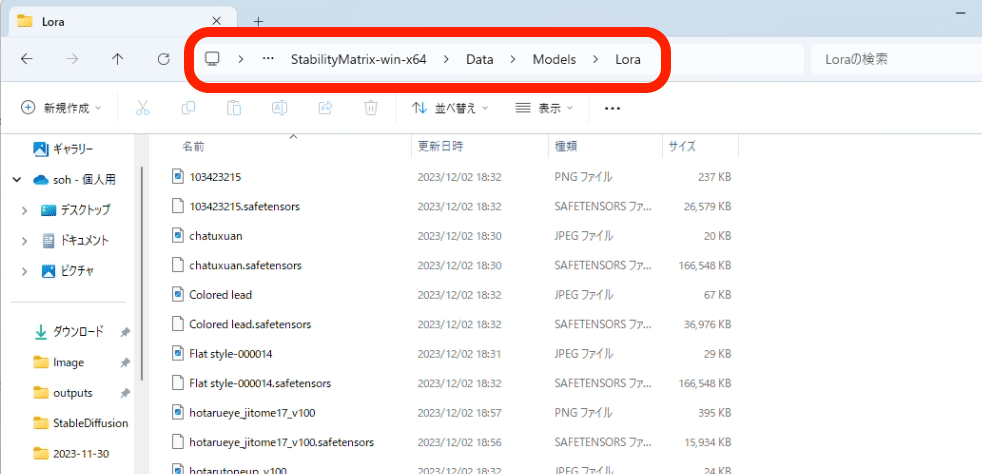

□ LoRAのインストール方法

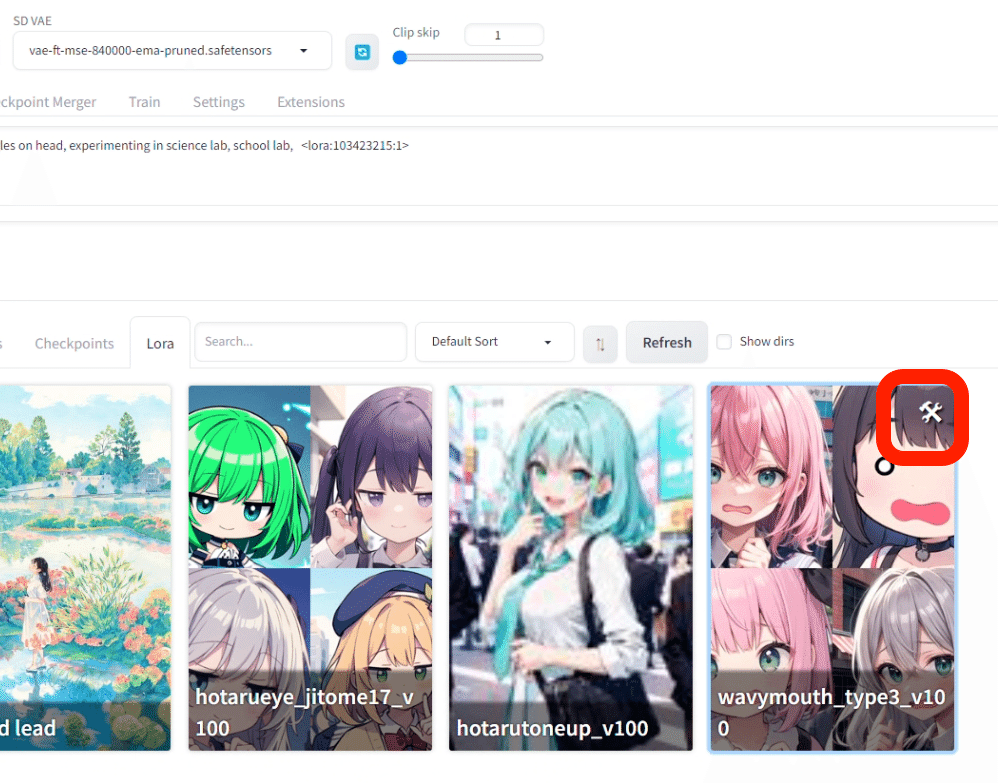

画像のようにLoRAのみにチェックを入れると、LoRAを見つけやすいです。

SDXL系のモデルを使うならLoRA XLをダウンロードし、SD1.5系のモデルならLoRA無印をダウンロードします。

LoRAのインストール方法はモデルと同じですが、LoRA専用の保存場所に保存してください。

その後、Stable Diffusionを再起動すると、LoRAが読み込まれます。

サムネイルを設定したい場合は、LoRAモデルのファイル名と同じ名前の画像ファイルを追加してください。

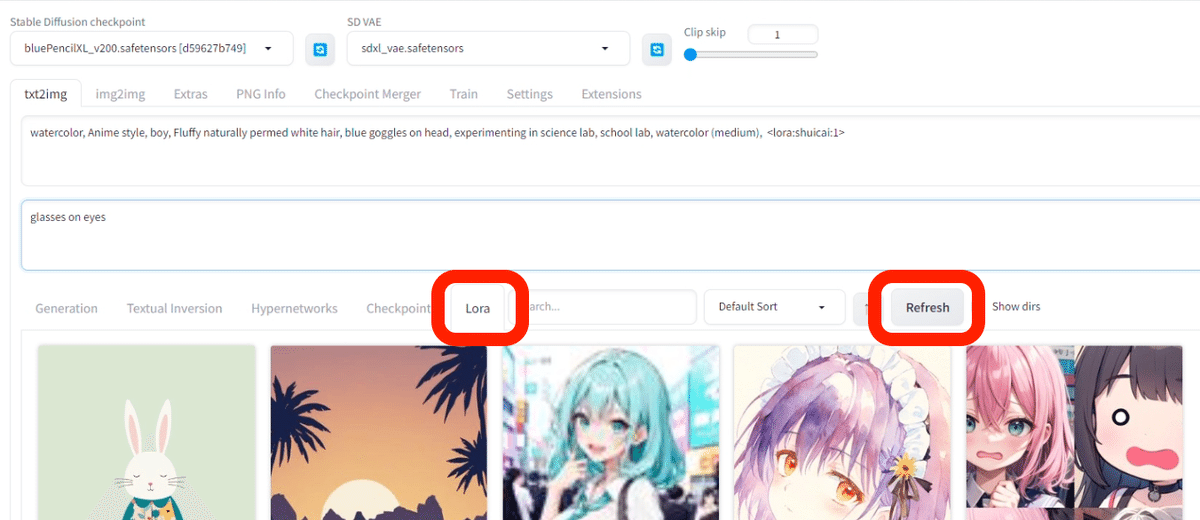

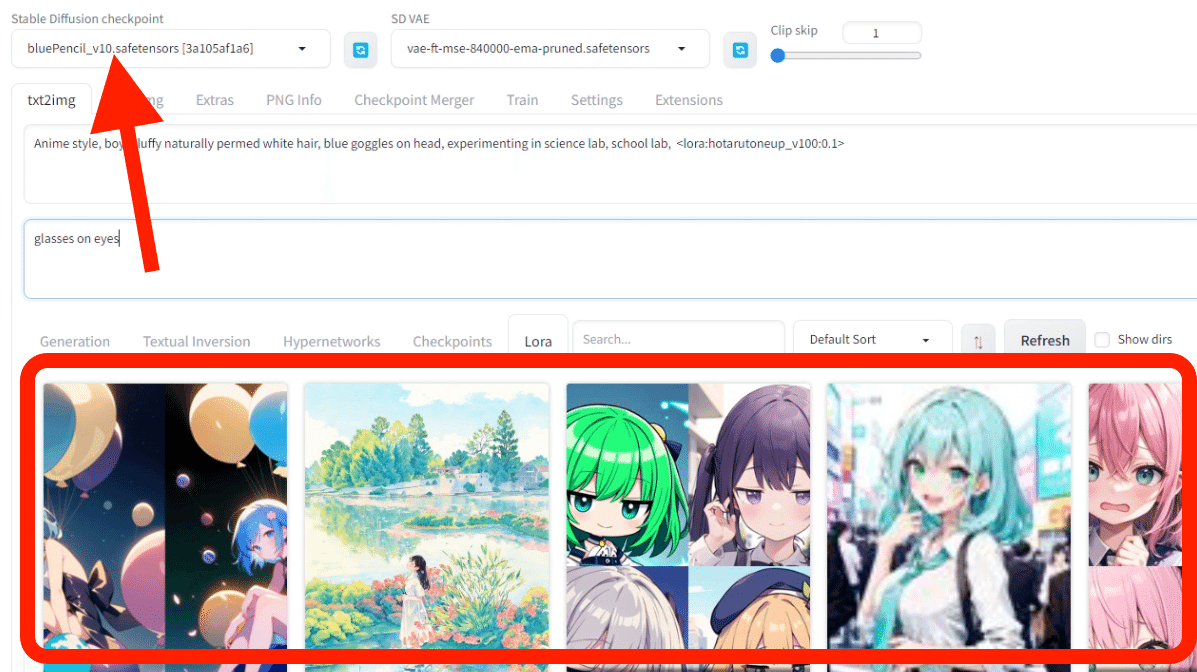

LoRAは、ここから確認できます。Stable Diffusion起動中にインストールした場合は、Refreshボタンをクリックすると、読み込みが完了します。

SDXL系のモデルを選択しているときは、SDXLと互換性のあるLoRAだけ表示されます。SD1.5系のモデルを選択しているときは、SD1.5と互換性のあるLoRAが表示されます。ただし、表示されているからといって、必ず互換性があるとは限りません。

□ LoRAの使い方

LoRAを使うには

・LoRAタグ

・トリガーワード

が必要です。トリガーワードは不要なこともあります。

LoRAタグを追加するには、LoRAモデルをクリックするだけです。以下のように書きます。

普通のプロンプト, <lora:name:0.8>, トリガーワード

LoRAタグの数値は、LoRAの影響度合いです。普通は、0.7前後くらいで上手くいきます。下げすぎるとLoRAの効果が無くなり、上げすぎると絵が破綻します。

トリガーワードは、Civitaiのここからコピー可能です。

LoRAは1クリックで適用できますが、トリガーワードを毎回Civitaiからコピペするのは面倒です。そこで、これを簡単にする方法があります。設定マークから設定を開き

アクティベーション テキスト欄に、トリガーワードを貼り、Saveをクリックします。すると、

LoRAモデルを選択するだけで、トリガーワードも同時で反映されるようになります。

この記事が参加している募集

この記事が気に入ったらサポートをしてみませんか?