WavToolでAIと音楽をつくってみる

はじめに

ChatGPTをはじめ各種LLMをベースにしたAIが話題になっていますが、音楽やサウンドデザインのツールにも少しずつAIの波がきているようです。

今年、2023年3月にリリースされ、GPT-4を活用したAI音楽制作ツールとして話題となったWavToolを使ってみました。WavToolを使ってみてのファーストインプレッションや考えたことなどまとめておこうと思います。

WavToolとは?

WavToolとは、ブラウザで動くDAWで、GPT-4ベースのチャットUIを搭載し、テキストでAIに指示を出して音楽制作を行うことができます。無料版と月額20ドルのフル機能版(Pro)があり、全ての機能が無料版でも使えますが、無料版は8時間あたり5回までしかチャットでの指示が出せないようです。(2023年5月現在)

5回だと短い曲であっても何かを作るのは難しいと思うので、Pro版の契約は必須になってくるかと思います。

上の画面のように、一見、普通のDAW(音楽制作)の様なのですが、右側にチャットボックスがあり、ここでConductorと呼ばれるAIと会話しながら、MIDIデータを打ち込んでもらったり、音色を作ってもらうことができるようになっています。

あと、AIから少し脱線しますが、このWavTool、オンラインで使えるDAWというだけでなく、トラックで使えるデバイスがノードベースで組み立てられるようになっています。この野心的な取り組みは素晴らしいですね。

WavToolのConductorの仕組みは?

WavToolはオープンソースではないのであくまで推測になってしまいますが、少しConductorの仕組みを考えてみます。

上の画像の様に、ChatGPTは、ドラムパターンやコード進行などの音楽の情報(≒楽譜)を可読性のある形で返答してくれます。なので、ChatGPTのAPIから返ってきた上の様な情報をWavTool側でMIDIデータに変換しているのではないかと推測できます。

以前、QosmoのNao Tokuiさんも同様のことをやられていました。

Hey ChatGPT, give me a neat drum pattern!

— Nao Tokui (@naotokui_en) March 7, 2023

TR-ChatGPT: https://t.co/MSmcjiEGHF pic.twitter.com/igfhgAOoGB

WavToolを使って音楽(の断片)を作ってみる

トライアル1 - 少し抽象度の高い指示で作ってみる

分かりやすいサンプルとして、ネオソウルっぽい曲を作ってみることにしました。まずは以下の様に、なんとなくジャンルや雰囲気だけ伝えて作れるか試してみることに。

この動画では、うまく行っている様にも見えるのですが、実はこの動画を撮影する前は基本的な8ビートのパターンの入力自体が難しく、ハイハットが1拍目にしかなかったり、そもそもビートらしいものになっていなかったり、大分苦戦しました。(撮影時はたまたま1回目でうまくいった感じです)

英語でやっても同様の精度感だったので、使用する言語はあまり関係がないと思われます。

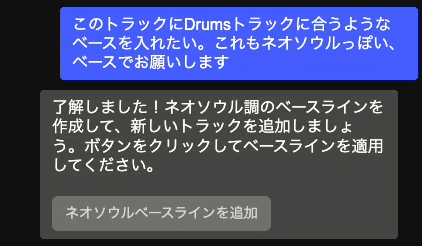

先ほどのドラムに合わせてベースをお願いしました。これは一旦、これでよしとしました。

今度は先ほどのベースに合わせてコードもお願いしました。しかし、ベースラインとコードが全然合っていません。おそらく、先ほどベースを打ち込んだ時に想定していたコード進行を忘れてしまったんじゃないかと。短期記憶能力はそれほど高くなさそうです。

このあと、結局どうやってもうまくいかなかったため、先にコードを入力してもらって、その後、ベースを入力する流れに変更したらなんとか合わせてくれました。

トライアル2 - 具体性の高い指示で作ってみる

指示がちょっとフワッとしすぎていたのかなと反省して、リセットして、より具体的な指示を出してみることにしました。きっと有名な曲ならコード進行などは知っているのではないか思い、曲を指定してアレンジする形で作ってみることにしました。

今回は、H.E.R. / Daniel Caesarの名曲、"Best Part"のコード進行を指示してみました。非常に有名な曲なので、きっと知っているはず。

しかし、Conductorが入力してくれたのは、全く違うコード進行でした。本当は、Dmaj7 - Am7 - Gmaj7 - Bbmaj7のはずですが…

試しにChatGPT(GPT-4)でも聞いてみました。

GPT-4も知っている風な受け答えをしていますが、コード進行が明らかに間違っていますね。音楽についてはまだそもそも学習が足りていないのかもしれません。そもそもGPT-4が知らないのなら、WavToolのConductorが間違ってしまうのは仕方ないですね。

結局、コード進行はこちらから直接コード進行を指定して打ち込んでもらうことにしました。4和音を指定しているのに3和音しか入力してくれなかったり、少し苦労はしつつも最終的にうまく入力してくれました。

次はドラムの入力です。基本的な8ビートを入力して欲しかったのが今回はなかなかうまくいかず、こちらも全て具体的に指定して入力してもらいました。

ここでMIDIの入力ではなく、音色の変更をお願いしてみることにしました。WavToolは、DAWとして基本機能が充実していて、エフェクトもノードベースで追加していくことができます。

音色についてはあえて「柔らかくふんわりとした雰囲気」という抽象的な指示の仕方をしてみたら、リバーブとコンプレッサーを追加してくれました。リバーブについては、言葉のイメージに合っているのではないでしょうか。

最後にベースを追加します。

コードを入力してからしばらく別のやりとりが続いたせいか、やはりコード進行を覚えてはくれていませんでした。色々と苦戦したので、最後は手入力でなんとか完成(?)させました。

AIをワークフローに取り入れるためには?

WavToolを使うことを通して、音楽に限らず、LLMベースのAIをクリエイティブな制作物に取り入れていくとしたらどうなっていて欲しいか?ということを改めて考えさせられました。自分にとって重要なポイントや「こうなったらいいなー」という妄想を少しまとめておきます。

試行回数を無限に増やしてくれる、テンプレートを一気に作ってくれる

試行回数はあらゆるクリエイティブ作業にとって非常に重要だと思いますが、手作業でやるのは面倒な色々なパターンを手軽に試せるようになったら嬉しいです。

WavToolのConductorを使う上では、一番のストレスが処理待ち時間が長いことでした。これはAPI側の処理能力やアクセスの集中によるものだと思うので、WavToolの問題ではないと思いますが、現状では、1回の試行に時間がかかりすぎてしまい、試行回数がなかなか増やせません。ここが改善されるだけでも大きいような気がします。もしくは、一回の指示で一気に曲のベースになるテンプレートを生成してくれると非常にありがたいかもしれません。

自分のボキャブラリーにないことを引き出してくれる

ある程度DAWを扱える人にとっては、自分で理解できていること、出来るだけのことをやるのであれば、AIを介さずにMIDIキーボードなり、マウスで入力した方が速いと思います。

あえて中間の言語を介在させてつくるのであれば、自分のボキャブラリーにはないことを会話の中で引き出してくれると嬉しいかもしれません。良きバンドメンバーやメンターのような新しい発見をさせてくれる存在になって欲しい。

自分のことを理解した上でサポート、成長させてくれる

前項の発展形ですが、究極的には、自分自身の嗜好性などを学習した上で自分のことをサポートしたり、成長させてくれるような存在になるとしたら素晴らしいですね。例えば、ツールを使っていくうちに自分の好みのサウンドを理解してくれた上で新しいサウンドのパターンを提案してくれたり。

まとめ

上述の通り、現状としては本格的に制作に使うのはなかなか難しいし、ある程度はDAWを使えている自分にとってはもどかしいなと感じる部分も多かったです。(自分の使い方が下手なだけ、という説も十分あると思うのですが)

ただ、悲観しているわけでなく、まだこの手のツールの黎明期であるし、日々様々なAPIやアルゴリズムが登場しているので、今後、今までは想像もしていなかったようなツールの進化やそれを使った音楽が登場すると思うとワクワクします。引き続き注目していきたいと思っています。

この記事が気に入ったらサポートをしてみませんか?