#SIGGRAPH2023 キャラクターアニメーション:人間の手で何をすべきなのかを探る

今年の論文セッションで個人的に一番興味があったセッションの聴講メモです。

Technical Paper: Character Animation: Knowing What To Do With Your Hands

テクニカルペーパー:

キャラクターアニメーション:「自分の手で何をすべきかを知る」

Session Chair: Michael Neff

University of California Davis/Meta

セッション座長:マイケル・ネフ

カリフォルニア大学デービス校/Meta

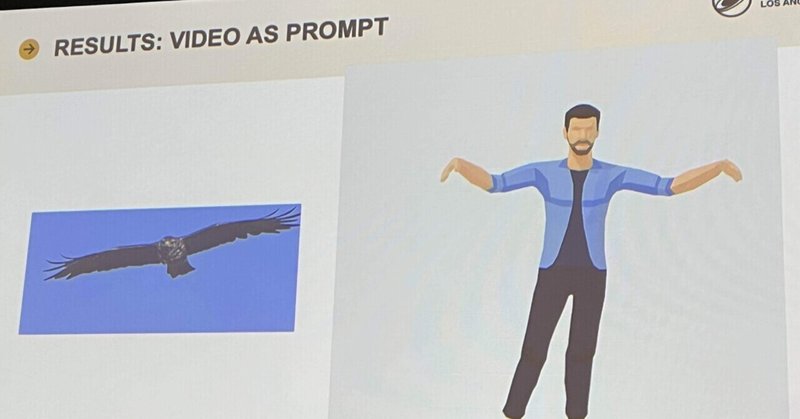

GestureDiffuCLIP: Gesture Diffusion Model With CLIP Latents

Authors: Tenglong Ao, Zeyi Zhang, Libin Liu

GestureDiffuCLIP: CLIP潜在によるジェスチャー拡散モデル

ベストペーパーだそうな

https://arxiv.org/abs/2303.14613

https://twitter.com/_akhaliq/status/1640543753709428736?s=46&t=jgQwk-8DSR4rWrfqK70Ylw

GestureDiffuCLIP: Gesture Diffusion Model with CLIP Latents

— AK (@_akhaliq) March 28, 2023

abs: https://t.co/iRC7FZS8Nd pic.twitter.com/70zjR7rBre

2:11pm - 2:22pm PDT

Bodyformer: Semantics-guided 3D Body Gesture Synthesis With Transformer

Authors: Kunkun Pang, Dafei Qin, Yingruo Fan, Julian Habekost, Takaaki Shiratori, Junichi Yamagishi, Taku Komura

https://dl.acm.org/doi/abs/10.1145/3592456

東北大なのね

本研究では、人間のポーズを生成するために、長期的な文脈情報を取り込むための変換器ベースの手法を提案

- ジェスチャパターンの長尾分布を扱うために、モード位置埋め込みを導入

- そして、変換器を小規模なデータセットで学習するために、モード内事前学習を導入

- 本アプローチは、音声のリズムや文脈に応じた高品質な動きを生成することができる。

2:22pm - 2:33pm PDT

Listen, Denoise, Action! Audio-Driven Motion Synthesis with Diffusion Models

Authors:

Simon AlexandersonRajmund NagyJonas BeskowGustav Eje Henter

https://youtube.com/watch?v=Qfd2EpzWgok&feature=sharec

https://www.speech.kth.se/research/listen-denoise-action/

2:33pm - 2:44pm PDT

How Important Are Detailed Hand Motions for Communication for a Virtual Character Through the Lens of Charades?

Authors: Alex Adkins, Aline Normoyle, Lorraine Lin, Yu Sun, Yuting Ye, Massimiliano Di Luca, Sophie Jörg

Cahrade(シャレード)を使う

https://dl.acm.org/doi/full/10.1145/3578575

https://research.facebook.com/publications/how-important-are-detailed-hand-motions-for-communication-for-a-virtual-character-through-the-lens-of-charades/

https://people.computing.clemson.edu/~sjoerg/communication/Adkins23_CommunicationPaper.pdf

2:44pm - 2:55pm PDT

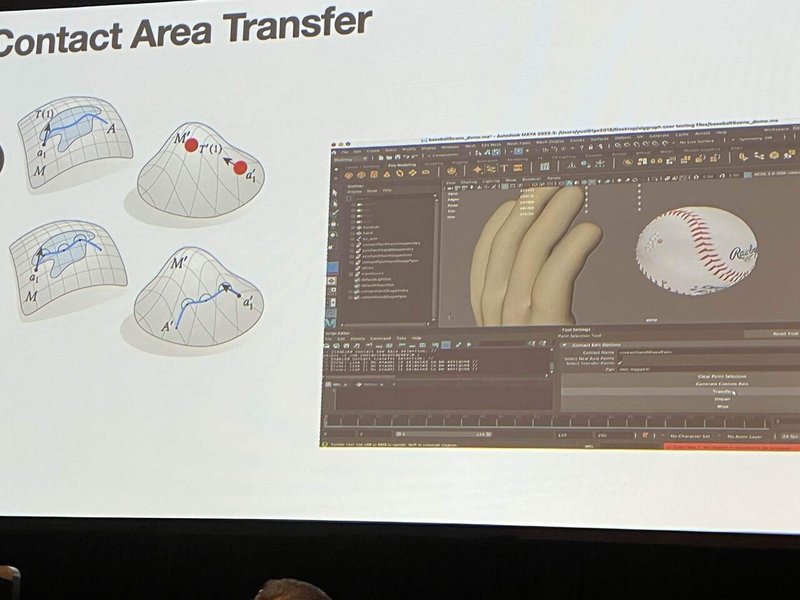

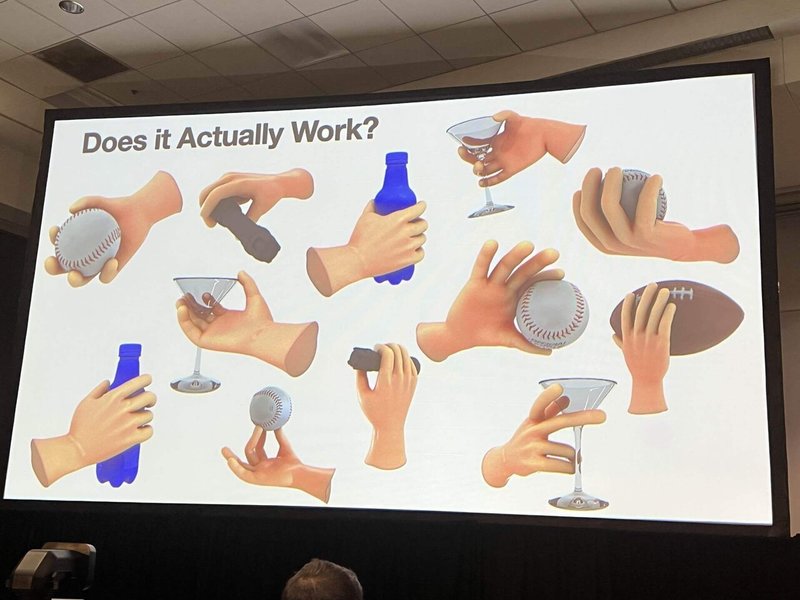

Contact Edit: Artist Tools for Intuitive Modeling of Hand-object Interactions

Authors:

Arjun Lakshmipathy, Nicole Feng, Yu Xi Lee, Moshe Mahler, Nancy Pollard

カーネギーメロンETCだ

物を握らせるプロダクションツール

https://youtube.com/watch?v=Qnpmfa0iBGI&feature=sharec

実際のコンタクトエリアにマッチさせるために回転と移動を処理する

ここまでガチな位置合わせしただけあって結果がすごい

2:55pm - 3:05pm PDT

Synthesizing Dexterous Nonprehensile Pregrasp for Ungraspable Objects

Authors: Sirui Chen, Albert WuC. Karen Liu

把持不可能な物体に対する器用な非包括的前把持の合成

優れたプレグラスプ(pre-grasp: 把持できるかどうか)の見極めは難しい

- 明確な定量的指標がない

- 把持を成功に導く必要がある

-計算コストの高いクエリ

- データ駆動型アプローチ

- 事前把握の計算にはコストがかかる

良い把持のための豊富な要件

- 把持可能な形状を露出させる

- 障害物を避ける

- 物理的な妥当性

- 観察:少なくとも1回の環境接触

3:05pm - 3:30pm PDT

Character Animation: Knowing What To Do With Your Hands - Q&A and Interactive Discussion

質疑応答は会場質問なのかなと思ったら、チェアの質問に答えていく感じになった。

GestureDiffuCLIPの著者Ao(アオ)さんに質問した。CLIPの動画への応用について。頭の中にアルゴリズムはあるらしい。逆にこっちにもいろいろ質問された。PhD学生なのか…将来楽しみだな

そこでDeemos(@DeemosTech)のQixuan Zhangにも会った、

というか彼は私のことよく知っていていつも研究をウォッチしてくれているらしいです。

いやDeemosの方がすごいでしょ…

今回はペーパー数本と、Real-Time-Liveの発表もあるんだってさ!これは期待。

そんなわけで収穫多かったセッションでした。

追記。

DeemosのQixuan Zhangから発表情報もらった

Check in!

— Deemos Tech @ SIGGRAPH (@DeemosTech) August 6, 2023

We're at #SIGGRAPH2023 from 6 Aug-14 Aug 🎉

Looking forward to meeting new friends in LA 🗺️

No booth but 3 presentations🎙️

Feel free to contact us to schedule a meeting 📧#3D #CG #GenerativeAI pic.twitter.com/EhQQcvnNcw

1/3) Real-time Live|Tuesday, 8 August 2023, 6pm - 7:45pm PDT @ West Hall B

— Deemos Tech @ SIGGRAPH (@DeemosTech) August 6, 2023

We are excited to showcase ChatAvatar at the Real-time Live! session, highly recommand, which is also public on Twitch at https://t.co/6p11xx46QO

For more details, please visit https://t.co/CKc38W5hky pic.twitter.com/m9ncjW80uu

2/3) Technical Paper|Monday, 7 August, 10:45am - 12:15pm PDT @ Room 502 AB

— Deemos Tech @ SIGGRAPH (@DeemosTech) August 6, 2023

In Motion Recipes and Simulation Session we will introduce our latest parametric Head-Neck Model, HACK.

HACK enhances the richness and authenticity of digital characters by incorporating anatomical… pic.twitter.com/xFqDqLaPFw

3/3) Technical Paper|Thursday, 10 August, 10:45am - 12:15pm PDT

— Deemos Tech @ SIGGRAPH (@DeemosTech) August 6, 2023

In Making Faces With Neural Avatars session we will introduce our Production-Ready 3D framework, DreamFace.

As behind ChatAvatar, DreamFace has achieved impressive results in character generation.

For more… pic.twitter.com/PUBUc6ySop

Only real-time Live sessions

— Deemos Tech @ SIGGRAPH (@DeemosTech) August 6, 2023

そうよ、RealTimeLiveはココじゃなきゃ見れないやつよね!

SIGGRAPH ASIA公式メディア写真に使われていて

— Dr.(Shirai)Hakase (@o_ob) August 30, 2019

ヒェッってなったhttps://t.co/h6syZanHPP pic.twitter.com/Vo94AQBtY5

この記事が気に入ったらサポートをしてみませんか?