ReAct: Synergizing Reasoning and Acting in Language Models (言語モデルにおける推論と行動の相乗効果)

「Google AI Blog」の記事「ReAct: Synergizing Reasoning and Acting in Language Models」が面白かったので、簡単にまとめました。

1. はじめに

近年、思考の連鎖 (CoT: Chain of Thought) を促した言語モデルは、さまざまな算術、常識推論タスクに優れ、創発的な能力を発揮します。ただし、独自の内部表現を使用するため、リアクティブに探索・推論したり、知識を更新したりする能力が制限されます。

一方、最近の研究では、事前学習済み言語モデルで「テキストコンテキスト」を「テキスト行動」にマッピングすることで、さまざまなインタラクティブ環境 (例: テキストゲーム、Webナビゲーション、ロボティクス) で行動を決定しています。ただし、それらは多段階の目標について抽象的に推論したり、作業記憶を維持したりしません。

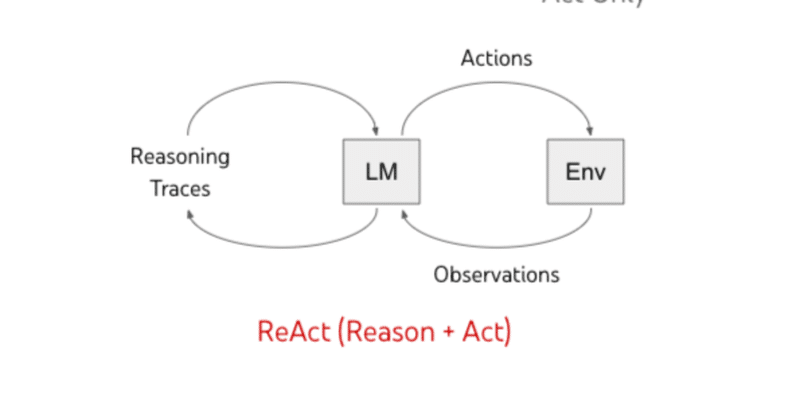

「ReAct: Synergizing Reasoning and Acting in Language Models」では、「推論」(行動理由の推論) と「行動」(理由に従って行動) を組み合わせて、言語モデルでさまざまな言語推論と意思決定タスクを解くための手法を提案します。

2. Reason + Act = ReAct

「ReAct」では、言語モデルは「推論」(行動理由の推論) と「行動」(理由に従って行動) の両方を交互に実行します。「行動」は外部環境 (Env) から新しい情報を「観察」として収集します。「推論」は外部環境に影響を与えませんが、代わりに、コンテキストを推論し、将来の推論と行動に有用な情報で更新し、モデルの内部状態に影響を与えます。

3. ReActプロンプト

「推論」(行動理由の推論) と「行動」(理由に従って行動) の相乗効果により、モデルは動的な推論を実行して、行動するための高レベルの計画を作成、維持、調整できます。また、外部環境 (Wikipediaなど) と相互作用して追加情報を推論に組み込むこともできます。

以下に、質問に対する「標準プロンプト」(Zero-Shot)、「推論のみ」(Reason only)、「行動のみ」(Act only)、「ReAct」(Reason + Act)を比較する例を示します。

◎ 質問

Question: 「物理学についての7つの簡潔なレッスン」は、何年からフランスで活動しているイタリアの物理学者によって書かれたものでしょうか?

◎ 標準プロンプト (Zero-Shot)

Answer: 1986 (不正解)

◎ 推論のみ (Reason only)

Thought: 一歩一歩考えよう。「物理学についての7つの簡潔なレッスン」はカルロ・ロヴェッリによって書かれました。カルロ・ロヴェッリは1990年からフランスで仕事をしています。

Answer: 1990 (不正解)

◎ 行動のみ (Act only)

Act 1: Search [物理学についての7つの簡潔なレッスン]

Obs 1: 「物理学についての7つの簡潔なレッスン」は、イタリアの物理学者カルロ・ロヴェッリによる短編集である。原著はイタリア語で出版され…

Act 2: Lookup [カルロ・ロヴェッリ]

Obs 2: (Result 1/1) 「物理学についての7つの簡潔なレッスン」は、イタリアの物理学者カルロ・ロヴェッリによる短編集です。

Act 3: Finish [1983] (不正解)

◎ ReAct (Reason + Act)

Thought 1: 「物理学についての7つの簡潔なレッスン」を検索し、その著者を見つけ、その著者がその後いつフランスで仕事をしたかを調べる必要がある。

Act 1: Search [物理学についての7つの簡潔なレッスン]

Obs 1: 「物理学についての7つの簡潔なレッスン」は、イタリアの物理学者カルロ・ロヴェッリによる短編集である。原著はイタリア語で...

Thought 2: 「物理学についての7つの簡潔なレッスン」の著者はカルロ・ロヴェッリである。次はカルロ・ロヴェッリを検索して、彼がその後いつフランスで仕事をしたかを探す必要がある。

Act 2 : Search [カルロ・ロヴェッリ]

Obs 2: カルロ・ロヴェッリは、イタリアの理論物理学者、作家で、イタリア、アメリカ、そして2000年以降はフランスで活動している。...

Thought 3: カルロ・ロヴェッリは2000年からフランスで仕事をしている。だから、答えは2000年だ。

Act 3: Finish [2000] (正解)

4. 結果

「HotPotQA」(質問応答)、「Fever」(事実検証)、「ALFWorld」(テキストベースゲーム)、 「WebShop」(Webナビゲーション ) の 4つのベンチマークで評価しました。

「HotPotQA」「Fever」では、モデルがWikipedia APIにアクセスできるため、ReAct は通常のアクション生成モデルよりも優れていますが、「CoT」と競合しています。最良の結果をもたらすアプローチは、内部知識と外部情報の両方を使用する「ReAct」と「CoT」の組み合わせです。

「ALFWorld」「WebShop」では、OneShotとTwo-Shotの両方を備えた「ReAct」は、既存のものよりも成功率が34%、10%と向上し、最大105のタスクインスタンスで学習された模倣学習よりも優れています。

5. おわりに

「ReAct」は、言語モデルで「推論」(行動理由の推論) と「行動」(理由に従って行動) を相乗作用させる、シンプルで効果的な手法です。

実験を通じて、「ReAct」がさまざまな言語推論と意思決定タスクにおいて優れたパフォーマンスをもたらすことがわかりました。

関連

この記事が気に入ったらサポートをしてみませんか?