Language Models Perform Reasoning via Chain of Thought (言語モデルに思考の連鎖を促す)

「Google AI Blog」の記事「Language Models Perform Reasoning via Chain of Thought」が面白かったので、簡単にまとめました。

1. はじめに

近年、言語モデルのサイズ拡大が、自然言語処理タスクのパフォーマンス向上につながることが知られています。今日の言語モデルは100B以上のパラメータを持ち、学習例なしに「感情分析」や「機械翻訳」などのタスクで、優れたパフォーマンスを発揮します。しかし、「算術推論」や「常識推論」など、多段階の推論タスクには苦労しています。

「Chain of Thought Prompting Prompting Elicits Reasoning in Large Language Models」では、言語モデルの推論能力を改善するためのプロンプト手法を探ります。「CoTプロンプト」(Chain of Thought)と呼ばれるこの手法により、多段階の問題を中間段階に分解できます。「CoTプロンプト」によって、パラメータが100B以上の言語モデルは、標準プロンプトでは解決できない複雑な推論の問題を解決できるようになります。

2. 標準プロンプト と CoTプロンプト の比較

「標準プロンプト」では、質問と回答の例を与えることで、質問に対する回答を生成するように促します。「CoTプロンプト」では、質問と中間段階付きの回答を与えることで、回答だけでなく、中間段階も生成するように促します。

【標準プロンプト】

◎ 入力

Q: ロジャーはテニスボールを5個持っています。彼はさらに2缶のテニスボールを購入します。1缶にテニスボールが3個入っています。彼は今何個のテニスボールを持っていますか?

A: 答えは11です。

Q: 食堂に23個のリンゴがありました。20個でお弁当を作って、6個買ったら、りんごは何個ありますか?

◎ 出力

A: 答えは27個です。 (不正解)

【CoTプロンプト】

◎ 入力

Q: ロジャーはテニスボールを5個持っています。彼はさらに2缶のテニスボールを購入します。1缶にテニスボールが3個入っています。彼は今何個のテニスボールを持っていますか?

A: ロジャーはテニスボールを5個持っていました。テニスボール3個入り2缶でテニスボール6個分です。5+6=11です。答えは11です。

Q: 食堂に23個のリンゴがありました。20個でお弁当を作って、6個買ったら、りんごは何個ありますか?

◎ 出力

A: 食堂にはもともと23個のりんごがありました。彼らは昼食を作るのに20個を使いました。つまり、23-20=3 です。さらに6個のリンゴを購入したので、3+6=9です。答えは9です。 (正解)

3. 算術推論

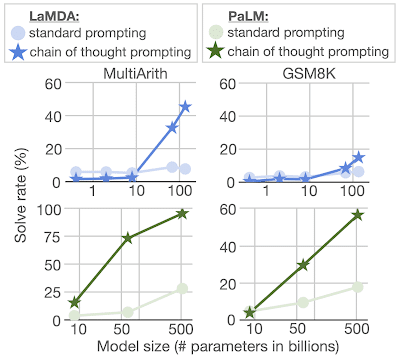

以下は、「標準プロンプト」と「CoTプロンプト」を「算術推論」のベンチマーク (MultiArith / GSM8K) で評価したグラフです。

100B以上のモデルでは、「標準プロンプト(●)」より「CoTプロンプト(★)」の方が上回っていることがわかります。

4. 常識推論

以下は、「標準プロンプト」と「CoTプロンプト」を「常識推論」のベンチマーク (CommonsenseQA / StrategyQA / BIG-Bench の Date Understanding と Sports Understanding) で評価したグラフです。

100B以上のモデルでは、「標準プロンプト(●)」より「CoTプロンプト(★)」の方が上回っていることがわかります。

5. おわりに

「CoTプロンプト」は、言語モデルの推論タスクを実行する能力を向上させるための、簡単で広く適用可能な手法です。算術推論や常識推論に関する実験を通じて、「CoTプロンプト」の特性は、モデル規模によって発揮されることがわかりました。

関連

この記事が気に入ったらサポートをしてみませんか?