Mistral NeMo の概要

以下の記事が面白かったので、簡単にまとめました。

1. Mistral NeMo の概要

「Mistral NeMo」は、Mistral AI と NVIDIA が共同で学習した 12Bの事前学習済み生成テキストモデルで、サイズが小さいまたは同等の既存のモデルよりも大幅に優れています。最大128Kトークンのコンテキストウィンドウを提供します。標準アーキテクチャを採用しているため、使いやすく、「Mistral 7B」を使用するあらゆるシステムで簡単に置き換えることができます。

研究者や企業での採用を促進するために、Apache 2.0の下で、事前学習済みのベースチェックポイントと指示チューニング済みのチェックポイントをリリースしました。「Mistral NeMo」は quantisation awareness を使用して学習されており、性能の低下なしにFP8推論が可能です。

次の表は、「Mistral NeMo」のベースモデルの精度を、最近の2つのオープンソースの事前学習済みモデル「Gemma 2 9B」「Llama 3 8B」と比較したものです。

2. グローバルな多言語モデル

このモデルは、グローバルな多言語アプリ向けに設計されています。「Function Calling」について学習され、大きなコンテキストウィンドウを備え、英語、フランス語、ドイツ語、スペイン語、イタリア語、ポルトガル語、中国語、日本語、韓国語、アラビア語、ヒンディー語に特に優れています。これは、人間の文化を形成するすべての言語で最先端のAIモデルをすべての人に提供するための新たな一歩です。

3. より効率的なトークナイザー

「Mistral NeMo」は、100を超える言語で学習された「Tiktoken」に基づく新しいトークナイザー「Tekken」を使用しており、以前のMistralモデルで使用されていた「SentencePiece」よりも効率的に自然言語テキストとソースコードを圧縮します。特に、ソースコード、中国語、イタリア語、フランス語、ドイツ語、スペイン語、ロシア語の圧縮効率が約 30% 向上しています。また、韓国語とアラビア語の圧縮効率もそれぞれ 2 倍と 3 倍向上しています。Llama 3トークナイザーと比較すると、Tekken は全言語の約 85% のテキスト圧縮においてより優れていることが証明されています。

4. 指示のファインチューニング

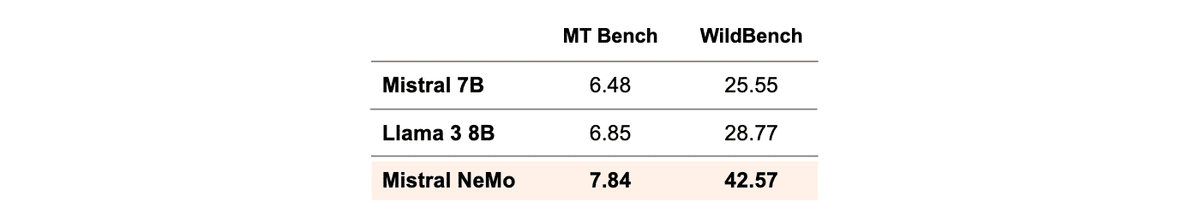

「Mistral NeMO」は、高度な微調整と調整フェーズを経ています。「Mistral 7B」と比較すると、正確な指示の遵守、推論、複数ターンの会話の処理、コードの生成がはるかに優れています。

6. Mistral Nemo 使用

ウェイトは、ベースモデルと指示モデルの両方でHuggingFaceにホストされています。今すぐ mistral-inference で「Mistral NeMo」を試し、mistral-finetune で適応させることができます。「Mistral NeMo」は、open-mistral-nemo-2407 という名前で「la Plateforme」に公開されています。このモデルは、NVIDIA NIM inference microserviceとしてコンテナにパッケージ化されており、ai.nvidia.com から入手できます。