Stable Diffusion 2.0をAUTOMATIC1111版WebUIなどで使う方法

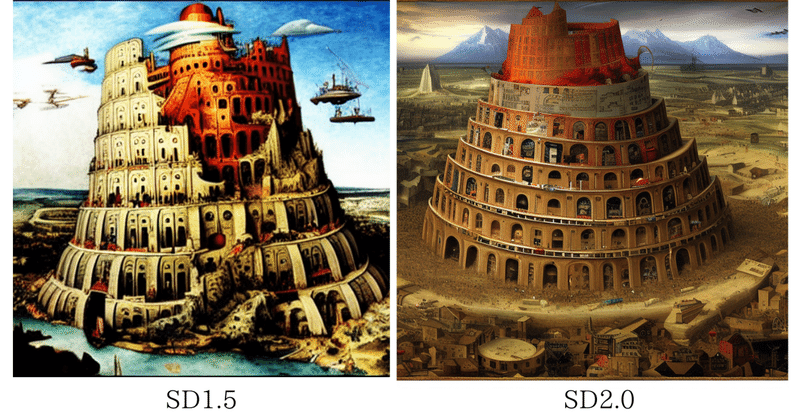

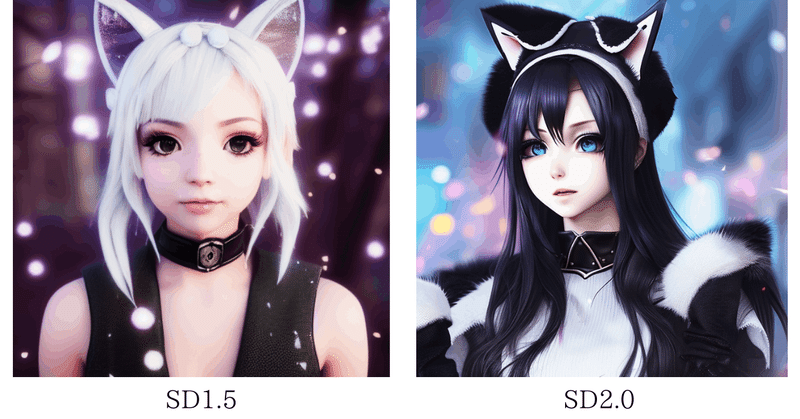

今月(2022年11月)24日、生成画像の品質を大幅に向上させたStable Diffusion 2.0(SD2.0)がリリースされました。

これを多機能と使いやすさで定評のあるWebユーザーインターフェイスのAUTOMATIC1111版Stable Diffusion web UIで使う方法について解説します。

また、他のおすすめのWebUIの使い方も紹介します。あまり複雑な機能を求めないのなら、こちらの方が起動や描画が早くて、よいかもしれません。

なお、SD2.0の概要などは、以下の記事を参考にしてください。

1.AUTOMATIC1111版WebUIにSD2.0を導入する方法

今回は、AUTOMATIC1111版Stable Diffusion web UIにSD2.0を導入するために、camenduruさんのGoogle Colabノートを使用します。

まず、以下のサイトにアクセスして、Colabノートを開きます。その際、Googleアカウントへのアクセスを求められたら、自分のアカウントにログインしてください。

すると、セルが一つだけ現れ、そこにコードが記載されています。(以下のコードをそのまま自分のColabノートにコピーして、実行しても、同じように動作します。)

ここでメニューの「ランタイムのタイプの変更」で「GPU」を選択しておきます。

!git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

%cd /content/stable-diffusion-webui

!wget https://huggingface.co/stabilityai/stable-diffusion-2/resolve/main/768-v-ema.ckpt -O /content/stable-diffusion-webui/models/Stable-diffusion/768-v-ema.ckpt

!wget https://raw.githubusercontent.com/Stability-AI/stablediffusion/main/configs/stable-diffusion/v2-inference-v.yaml -O /content/stable-diffusion-webui/models/Stable-diffusion/768-v-ema.yaml

!python launch.py --share --xformers --enable-insecure-extension-access あとは、セルの実行ボタンをクリックして、最後に表示されるRunning on public URL: の後のリンクをクリックすると、Stable Diffusion web UIの操作画面が開きます。セルの実行ボタンを押してから5分くらいで起動します。

操作画面でプロンプトを入力し、Generateボタンをクリックすると、1枚10秒程度で画像が表示されます。

TheLastBenさんの「fast-stable-diffusion」でも、AUTOMATIC1111版WebUIにSD2.0を導入することができるようになっています。このColabノートで、ランタイムのタイプにGPUを選択し、4番目の「Model Download/Load」と最後の「Start stable-diffusion」のセルでModel_Version:にV2-512pxかV2-768pxを選択し、「Use_Gradio_Server:」にチェックして、セルの実行ボタンをクリックしてください。

最後に表示されるRunning on public URL:の後のリンクをクリックすると、操作画面が開くはずですが、筆者の場合は、RAMのメモリーが足りなくて、途中で失敗してしまいました。

2.AUTOMATIC版WebUIでSD2.0と他のモデルデータを切り替えて使う方法

以下のコードをColabノートのセルにコピーして実行すると、AUTOMATIC版WebUIの操作画面の左上のStable Diffusion checkpointでSD2.0とSD1.4を切り替えて使うことができます。

※切り替える場合は、途中でRAMのメモリーが足りなくなって失敗することがあります。SD2.0はできるだけ単独で使用した方がよさそうです。

!git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

%cd /content/stable-diffusion-webui

!wget https://huggingface.co/camenduru/sd14/resolve/main/sd-v1-4.ckpt -O /content/stable-diffusion-webui/models/Stable-diffusion/sd-v1-4.ckpt

!wget https://huggingface.co/stabilityai/stable-diffusion-2/resolve/main/768-v-ema.ckpt -O /content/stable-diffusion-webui/models/Stable-diffusion/768-v-ema.ckpt

!wget https://raw.githubusercontent.com/Stability-AI/stablediffusion/main/configs/stable-diffusion/v2-inference-v.yaml -O /content/stable-diffusion-webui/models/Stable-diffusion/768-v-ema.yaml

!python launch.py --share --xformers --enable-insecure-extension-access「!wget https://huggingface.co/camenduru/sd14/resolve/main/sd-v1-4.ckpt -O /content/stable-diffusion-webui/models/Stable-diffusion/sd-v1-4.ckpt」の部分を書き換えると、他のモデルデータをダウンロードして、切り替えて使うこともできます。詳細は、以下の記事を参考にしてください。

3.他のWebUIを利用する方法

AUTOMATIC1111版以外の使いやすいWebUIとしては、qunashさんの「Stable Diffusion v 2.0 web UI」があります。

このWebUIは、各種設定の他にNegative promptを入力することができ、Image to ImageやInpainting(部分修正)も使用できます。

このWebUIを利用するには、以下のサイトにアクセスしてColabノートを開いてください。

次に、上部のランタイムのタブから「ランタイムのタイプの変更」をクリックして「GPU」を選択し、「すべてのセルを実行」をクリックします。そして、最後に表示されるRunning on public URL:の後のリンクをクリックすると、操作画面が開きます。セルの実行ボタンを押してから3分弱で起動します。

操作画面でプロンプトを入力しGenerateボタンをクリックすると、Stepsが25のままの場合、1枚15秒程度で画像が表示されます。

この記事が気に入ったらサポートをしてみませんか?