Meta Llama 3:これまでで最も高性能なオープンソース大規模言語モデルの紹介

2024年4月18日、Metaは最新世代のオープンソース大規模言語モデル(LLM)、Meta Llama 3の発表を行いました。このモデルは、多様な用途に対応できる強力なAIツールとして期待されています。今回のブログでは、Meta Llama 3の詳細、開発背景、利用方法、そしてその未来展望について詳しく解説します。

Meta Llama 3の概要

Meta Llama 3は、AWS、Databricks、Google Cloud、Hugging Face、Kaggle、IBM WatsonX、Microsoft Azure、NVIDIA NIM、Snowflakeなどの主要なクラウドプラットフォームで利用可能になります。さらに、AMD、AWS、Dell、Intel、NVIDIA、Qualcommなどのハードウェアプラットフォームもサポートしています。

Metaは、Llama 3の開発において責任ある方法を採用しており、ユーザーが安全に利用できるように様々なリソースを提供しています。例えば、新しい信頼と安全ツールとしてLlama Guard 2、Code Shield、CyberSec Eval 2を導入しました。また、今後数ヶ月で新たな機能の追加や性能向上、長いコンテキストウィンドウ、追加のモデルサイズなどが導入される予定です。

主要機能と性能

Meta Llama 3は、8B及び70Bパラメータの事前学習済み及び指示調整済み言語モデルとして提供され、多様な利用ケースに対応できるよう設計されています。このモデルは、様々な業界ベンチマークにおいて最先端の性能を示し、特に推論能力の向上が顕著です。

Metaは、Llama 3を開発する際、標準的なベンチマークでの性能を評価するだけでなく、現実世界のシナリオでの最適化も重視しました。そのため、高品質な人間評価セットを開発し、12の主要な利用ケース(アドバイスの提供、ブレインストーミング、分類、クローズド質問の回答、コーディング、創造的な執筆、抽出、キャラクター/ペルソナの具現化、オープン質問の回答、推論、書き直し、要約)をカバーする1,800のプロンプトを含んでいます。

モデルアーキテクチャとトレーニングデータ

Llama 3は、標準的なデコーダのみのトランスフォーマーアーキテクチャを採用しており、Llama 2と比較していくつかの重要な改良が加えられています。例えば、128Kトークンの語彙を持つトークナイザーを使用し、効率的に言語をエンコードすることで、モデル性能が大幅に向上しました。また、8,192トークンのシーケンスでトレーニングを行い、自己注意が文書の境界を越えないようにマスクを使用しています。

トレーニングデータのキュレーションにも注力し、Llama 3は公開されているソースから収集された15兆以上のトークンで事前学習されています。このデータセットは、Llama 2で使用されたものの7倍の規模であり、4倍のコードを含んでいます。また、30以上の言語をカバーする高品質な非英語データも5%含まれています。

スケーリングと効率化

Llama 3のトレーニングには、データ並列化、モデル並列化、パイプライン並列化の3種類の並列化技術を組み合わせています。これにより、16K GPUを同時に使用して訓練する際に400 TFLOPS以上の計算効率を達成しました。また、24K GPUのカスタムクラスターでの訓練も行い、GPUの稼働時間を最大化するために、エラーディテクションやメンテナンスを自動化する新しいトレーニングスタックを開発しました。これにより、Llama 2に比べて訓練効率が約3倍向上しました。

指示調整と安全性

Llama 3の潜在能力を最大限に引き出すために、指示調整(instruction fine-tuning)のアプローチも革新しました。このプロセスでは、スーパーバイズド・ファインチューニング(SFT)、リジェクションサンプリング、近似政策最適化(PPO)、直接好み最適化(DPO)の組み合わせを採用しています。これにより、モデルの推論やコーディングタスクでの性能が大幅に向上しました。

Llama 3の安全性を確保するために、内部および外部の専門家によるレッドチーミング(安全性テスト)を実施し、モデルが安全に利用されるようにしています。また、新しい信頼と安全ツールとしてLlama Guard 2、CyberSec Eval 2、Code Shieldを導入しました。

オープンエコシステムの構築

Metaは、オープンエコシステムの構築を推進しており、Llama 3の開発と展開においてもこの理念を重視しています。torchtuneという新しいPyTorchネイティブのライブラリを共同開発し、メモリ効率の高いトレーニングレシピを提供しています。このライブラリは、Hugging Face、Weights & Biases、EleutherAIなどのプラットフォームと統合されており、モバイルやエッジデバイスでの効率的な推論をサポートしています。

Llama 3の未来

Llama 3の8Bおよび70Bモデルは、次世代Llamaの最初のリリースですが、今後も多くのモデルと新機能がリリースされる予定です。現在、最大400Bパラメータのモデルがトレーニング中であり、今後数ヶ月で多言語対応やマルチモーダル機能、さらに長いコンテキストウィンドウなどが追加される予定です。また、Llama 3の詳細な研究論文も公開予定です。

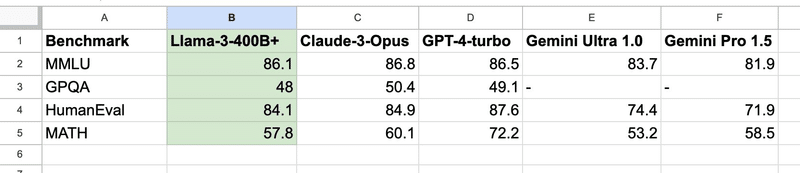

Llama 3 400Bと他の最先端モデルとの性能比較

結論

Meta Llama 3は、これまでで最も高性能なオープンソース大規模言語モデルとして、多様な用途に対応できる強力なAIツールです。Metaの取り組みは、オープンエコシステムの構築と責任あるAI開発を推進するものであり、今後のAI技術の発展に大いに貢献することでしょう。Llama 3を活用して、次世代のAIアプリケーションやツールの開発にぜひ挑戦してみてください。

※この記事は、Metaの公式ブログ記事を基にして、ChatGPTが作成しました。

この記事が気に入ったらサポートをしてみませんか?