米国のデータ戦略はどう進んでいるのか

最近は欧州のデータ戦略が注目されているが、米国はどうしているのかという話をよく聞かれる。確かに、米国政府のデータに関する取り組みはしっかり行われているものの、断片的というかプログラム単位の情報が多く、全体像が分かりにくい。

そこで歴史を紐解いてみることとした。

もともと、データに関して米国は進んでいる

システム設計を行うときにに必ずデータベースについて検討を行うが、主要なデータベースはほとんど米国製である。また、データ設計手法やツールも米国製が多い。インターネットをはじめ、ネットワークの米国の先進性は注目されているが、実はデータの世界も米国がリードをしてきた。

このように製品や方法論が進んでいるため、データに関する人材の層が厚く、これらの専門家が行政と民間企業を行き来することにより、政府のデータ整備、民間のデータサービスの進展が進んいる。

米国の軍事部門に着目してみよう

コンピュータの歴史は、弾道計算から始まったといわれるように軍事部門との関連は切り離しては考えられない。また孫氏の兵法にもあるように、軍事活動において情報を収集し管理分析することは非常に重要である。

製造のための情報モデルとして取り組みが開始した

製造部門でも兵器などを正確に作るためにデータが重要である。1970年台に

米空軍が製造過程を統合的に管理するために(Integrated computer-aided Manufacturing, ICAM)プログラムを推進した。これは現在のCIM(Computer-Integrated Manufacturing)の源流の取り組みともいえる。

そこでは機能モデルと情報モデルの重要性が着目され、その作成、管理する方法論としてIDEF(ICAM DEFnition)が定義された。

機能モデルはIDEF0といわれ、機能を中心に入力(I)、制約(C)、出力(O)、メカニズム(M)のICOMをもちいて関連要素を整理手法としてまとめられた。

情報モデルはIDEF1といわれ、データの概念、関係性、制約、ルール等を整理するモデルである。

その後、1985年にIISS(Integration Information Support System)で、エンティティ・リレーションモデルの汎化を組み込む等の拡張をしてIDEF1X(IDEF1 extention)として定義されている。

米国政府調達標準への採用

IDEF1Xは、1993年に米国政府標準局(NIST)が制定する連邦情報技術調達標準(FIPS)のFIPS184として、軍事部門や製造業の取り組みではなく、連邦政府全体の標準として定義されている。政府調達においては、このデータ設計手法に従わないといけなくなったわけである。また、IDEF0をFIPS183とする等、IDEF群としてFIPSに登録されるとともに、IDEFの名前もIntegrated DEFinitionに変更されている。

CALSとして本格的な展開

CALSというと、製造業で懐かしい言葉だと思う人、建設業で建設CALSを思い浮かべる人が多いだろう。米国の軍事部門で1985年にConmputer-Aided Logistics Supportとして開始され、調達を強化してConmputer-Aided Acquisition and Logistic Support、さらに1993年位から群だけでなく民間製造業へも展開されContinuas Acquisition and Lifecycle Supportへと拡張し、最後はCommerce At Light Speedとも呼ばれたプログラムが行われた。

ここでは「Create once, use many times」というデータの徹底した再利用が目標として掲げられ、推進された。

この時にデータ標準として推奨されたのがIDEF1Xであり、機能モデルのIDEF0、プロセスモデルのIDEF3やSTEP(STandard for the Exchange of Product model data)等とともにデータの標準化とそれに基づくデータ整備がすすめられた。

このデータ管理、活用技術の民間転用でボーイング777の設計、開発が紹介されたこともあり、日本でも1990年になりCALSに急速に注目が高まった。

CALS技術研究組合が設立されるとともに、米国の展示会に100名を越える関係者が視察に行くほどの盛り上がりを見せた。

プロダクトデータ管理(PDM)が中核として、調達効率化のためのデータ標準化の取り組み、今では当たり前の対話型電子マニュアルとライフサイクルでのデータの一元管理と再利用を目指していた。さらに展示で目を引いたのが、スキャニングなどの紙図面の電子化サービスである。多くの企業が出展し、既存データをスキャンしメタデータを付けるデータ関連ビジネスを展開していた。そのため、ダブリン・コア等のメタデータ管理に使う語彙へも注目が集まっていた。

電子政府の観点からもデータに注目が集まる

1990年代後半になるとCALSの取り組みは一定の成果を上げ、EC(Electronic Commerce)に焦点はうつっていった。一方で電子政府の世界に本格的にデータ見直しの流れがやってくる。

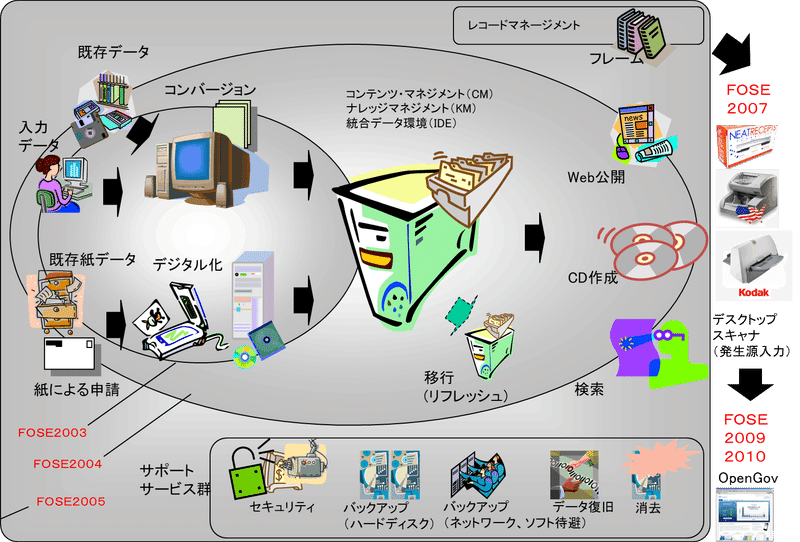

ワシントンDCでは、FOSEといわれる電子政府の展示会を毎年行っていたが、この主要展示やセミナーの変化をデータという観点で整理すると以下のようになる。

2003年は既存データの電子化がポイントで、2004年には過去データとともにフォーム入力などで急速に増えるコンテンツの管理が課題となっている。そして2006年にかけて、その配布方法、リフレッシュやバックアップ等の管理方法に焦点が移っていく。2007年になると発生源入力ができるようにデスクトップスキャナが着目され、2009年位からオープンデータなどのデータの公開と活用が課題になっている。

エンタープライズ・アーキテクチャの推進

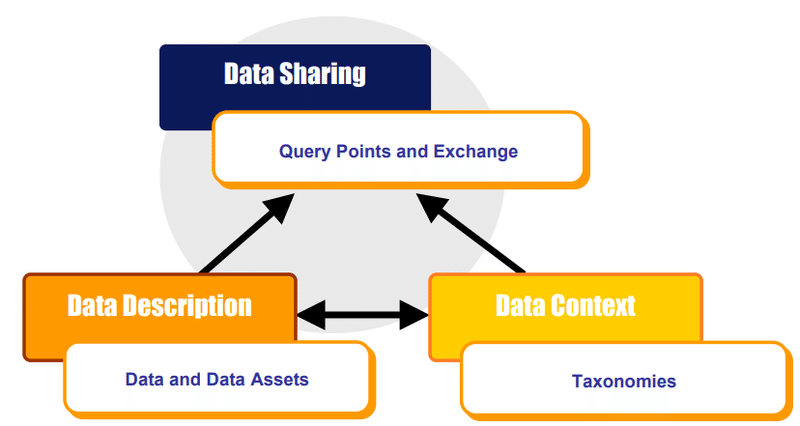

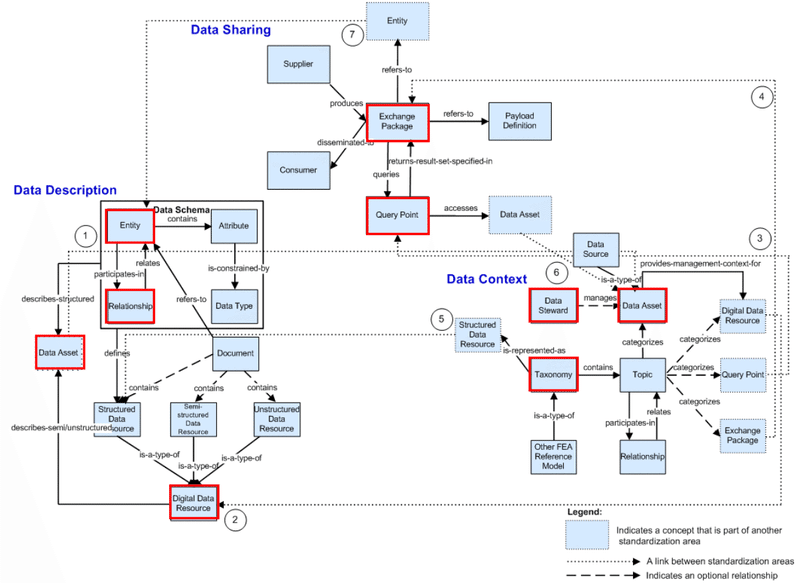

1996年に制定されたClinger-Cohen Actを受けて、1999年にFederal Enterprise Architecture Framework(FEAF)が公表された。連邦政府のシステム間の連携を図るためにアーキテクチャの記述方法を規定している。アーキテクチャは各レイヤのリファレンスモデルも含み、データレイヤでは、データ・リファレンス・モデル(DRM)として、コモン・データモデルを提示した。

これらは、Clinger-Cohen Actだけでなく、関連法にも準拠する形で推進された。

GPRA 1993 : Government Performance and Reform Act

PRA 1995 : Paperwork Reduction Act

CCA 1996 : Clinger-Cohen Act

GPEA 1998 : The Government Paperwork Elimination Act

FISMA 2002 : Federal Information Security Management Act

E-Gov 2002 : Electronic Government

また、OMBの予算関連の各ルールに従い推進されている。

A-11 : Preparation, Submission and Execution of the Budget

A-130 : OMB Circular A-130 Management of Federal Information Resources, first issued in December 1985

これらエンタープライズ・アーキテクチャの取り組みは、情報システム調達の見直しに取り組んでいた日本でも着目され、プロジェクト・マネジメント手法とともに導入された。

しかし、国内の導入では監査視点が重視されモデリングツールを活用するという設計面の意識が希薄であった。そのため、業務・システム最適化計画として導入されたものの、膨大な紙作業が発生してしまい、アーキテクチャを有効に導入することができなかった。また、データのモデリングに関しても有効なリファレンスモデルを作ることができなかった。

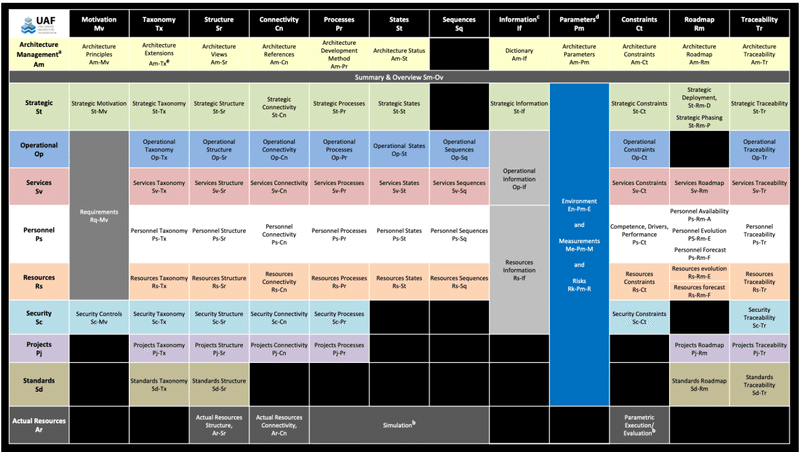

米国でも、FEAに基づくアーキテクチャ整備は負担であり、2010年台半ばに取り組みが終了している。一方、国防総省がもともと進めていたアーキテクチャであるDoDAF(DoD Architecture Framework)は進化を続け、世界のアーキテクチャ・プロジェクトの参照モデルとなり続けている。現在は、DoDAF等を参考にOMGがUnified Architecture Framework® (UAF®)を推進している。

この中で、行を示す各視点に対する縦軸の個々の側面の中で、タクソノミとインフォメーションを定義している。

NIEM(National Information Exchange Model)の推進

2001年の911のテロの時の情報共有の課題を踏まえ、法務省のデータモデルであるGJXDMを発展して、2005年に整備が開始されたデータモデルである。安全保障を中心にデータモデルを整備している。国防総省のデータモデルとも統合され、Joint All Domain Command and Control (JADC2)のキーイネーブラーとして機能している。

一方で汎用的な活用もできるように、2022年にOASIS Open projectとオープン化にも取り組み、現在はNIEM OPENとして推進されている。

OpenDataの推進

2009年にオバマ政権が発足すると、オープンガバメントとオープンデータが急速に推進された。

就任直後にMemorandum on Transparency and Open Governmentに署名し、オープンデータ・ポータルのData.govを公開した。2013年にはMaking Open and Machine Readable the New Default for Government Informationの大統領令を発行するなどオープンデータに取り組み、2017年にFoundations for Evidence-Based Policymaking Actの一部としてオープンデータ関連の法整備が行われた。そして2018年Open, Public, Electronic and Necessary (OPEN) Government Data Actが成立した。

こうしてオープンデータが強力に推進されてきた。

また、2013年にFITARA(Federal Information Technology Acquisition Reform Act)が制定されており、CIOの権限強化などが行われていることもデータ整備に貢献している。

予算関連データの体系化

米国政府は財務データの管理に積極的に取り組んでおり、OMBがリードして、調達から政策評価までの一貫したデータ活用が行われている。1993年のGPRA(Government Performance and Reform Act)により業績計画や目標などの提出が求められるようになった。(2010年にGPRA modernization actで報告周期やデータ内容を強化)1994年にはFASA(Federal Acquisition Streamlining Act)が制定され、高価格帯の調達ではPBC(Performance-Based Contracting)が導入されるなど数値での報告が必要になっている。1996年に制定されたClinger-Cohen ActはITMRA(IT Management Reform Act)とFARA(Federal Acquisition Reform Act)からなるが、ITMRAの中でCPIC(Capital Planning and Investment Control)やPBMの推進が求められた。特にCPICプロセスは重要であり、その流れは現在も予算要求プロセスで活用されている。(FY22 IT Budget)

また、補助金などの執行データを集めるため2006年から運用してきたFederal Funding Accountability and Transparency Actを2014年にDATA Act(Digital Accountability and Transparency Act)に拡張し、さらに2022年に見直しを行っている。

この定型化された予算情報をMAXシステムを通じて集積することで、IT dashboardやUSAspending.govのような予算執行データも含んだ情報公開サイトを実現している。

Federal Data Strategy

2020年に、Federal Data Strategyが公開された。2020年には詳細なアクションプランが公開され本格的にデータ戦略が進むと考えられたが2021年のアクションプランは大幅に遅れ、その後アクションプランが公開されないため、FDSをきちんと強力に推進すべきではないかという意見を言う人もいる。

一方、その中身である各アクションは着実に進展している。政府横断のCDOカウンシルが設立され活発に活動を行うとともに、個別分野での取り組みが進められている。例えば、政府財務データの管理には積極的に取り組んでおり、以前からOMBがリードしてきた調達から政策評価までの一貫したデータ活用をさらに強化しようとしている。また、地理空間のNational Spatial Data Infrastructure (NSDI) Strategic Planが進められているところである。

AIについては、National Artificial Intelligence Initiativeで推進されている。方針が示されるとともに活用事例を集積し、研究開発プロジェクトも推進しているところである。

米国のデータ戦略が停滞しているではないかという意見は、ある意味正しいが、専門的人材が豊富で基盤が揃っていることや個別プロジェクトは着実に進んでいることから今後も注視していくことが重要である。

民間での推進

米国の民間でのデータプラットフォームの推進は言うまでもないだろう。多くのプラットフォーマーが登場してグローバルなビジネスを展開しているところである。

最後に

米国はデータに関してモデリングから管理方法など多くの蓄積があり人材もそろっている。米国のプラットフォーマーにばかり注目するのではなく、基盤を作るエンジニアリングも含み、体系的にキャッチアップしていくことが求められている。

この記事が気に入ったらサポートをしてみませんか?