OpenAI最新モデル!OpenAI o1-preview, o1-miniについて

OpenAIの方から、GPT4oの次のモデルであるOpenAIo1というモデルが発表されました。なかなかOpenAIから新しいモデルが登場されなくて、もうChatGPT解約しようかなという風に思ってた人も多いと思います。

今回の発表で、大きく分けて2つのモデルがリリースされました。OpenAIo1のプレビューというモデルと、OpenAIo1のminiというモデルですね。 当然、これらのモデルは精度がかなり高いんですけれども、ただ色々読んでみると、すべてのタスクにおいて今回のモデルが良いというわけじゃないようです。タスクによっては、これまでのGPT4oの方が良いケースがあるというところが公式のページで書かれていました。つまり、OpenAIo1が最強というわけではないようです。

今回はこれらのモデルについて詳しく解説していこうと思います。最新の生成AIについて知っておきたいという人は、ぜひ見ていってもらえればと思います。

こちらがOpenAI o1の公式のページになっています。

これまで、GPT3.5、GPT4とかですね、GPTシリーズというところで進化してきたんですけども、今回から新しいシリーズなんですかね、OpenAIo1という名前になっています。

o1モデルの特徴

特徴としては、ここにもあるように「DESIGN to spend more time thinking before They respond」ということで、言語モデルが返答を生成する前に、より多くの考える時間を費やします。

言語モデルの精度を向上させるテクニックとして、チェインオブソートと言われるプロンプトのテクニックがあります。言語モデルの論理的な推論能力を上げるのに、すぐに回答を生成させるんじゃなくて、一旦、思考の過程を出力させて、その後に回答を生成させると、より精度が上がりますよというテクニックです。

今回の「more time thinking」というのは、この思考過程を出力させるようにモデルを設計しているというところが、これまでと大きく違うというところになります。これまでは、モデルのインプット、つまりプロンプトの中にこういった例を与えてあげてモデルに考えさせるように出力させてたんですけども、OpenAIo1からはこういったプロンプトを入れなくても、勝手に自分で思考過程を作成して、それを元に回答を生成してくれると。なので、精度が高いですよというのが今回のモデルの特徴になっています。

o1シリーズモデルは複雑な推論を行うために強化学習で訓練された最新の大規模言語モデルになってるみたいです。推論とかね、数学とか科学がすごい言われています。

o1プレビューモデルとo1miniモデル

具体的に2つのモデルについて見ていこうと思います。まずはOpenAIo1プレビューというモデルですね。こちらを見ていきます。最初に、OpenAIo1のプレビューというところなので、OpenAIo1というモデルがあって、今回出たのはそれのプレビュー版ですよというので、o1よりも性能が少し低いモデルという感じです。

先ほど説明したように、回答を生成する前に考えるプロセスが入るので、これまで解けなかった、より複雑なコーディングとか、数学の問題とか、そういったところに強いモデルがOpenAIo1のモデルの特徴になっています。

モデルの評価結果が色々と書いてあって、例えば国際数学オリンピックの試験において、これまでの最新モデルであるGPT4omniだったら13の問題しか正解してなかったんですけども、今回発表されたOpenAIo1モデルを使うと83%を正解するというところで、めちゃめちゃ数学的な能力が上がってるというのが分かります。

あとは、コーディングの能力も上がってるというところで、コードフォースというコンペティションの中でも上位89%に位置してますというところが書かれています。現在はWebブラウジングとか、ファイルのアップロード機能とか、画像に関しての取り扱いはできない状態です。なので、日常的なチャットで使うというよりは、何か難しい問題を解かせるとか、難しいコーディングをさせるとか、そういった場合に使えそうです。

あとは、安全性に関してもかなり性能が上がってますよという話だったりとか、OpenAIo1がいろんなところで活躍してますよというので、様々な領域の専門家のインタビュー動画が紹介されています。

例えばコーディングに関してはRevinという全て自動でソフトウェアを作ってくれるようなサービスが話題になってるんですけども、OpenAIo1を使ってこんなことができますよということで、ツイートの感情分析を行うアプリケーションの話がされていました。

めちゃくちゃ驚くってわけじゃないんですけども、APIとかを自動で使って機械学習を使いながら感情分析ができると。あとは、エラーとかが出ても、自分で考えて勝手に修復してくれるというところで、今回のOpenAIのo1がかなり使えるというところかなと思います。そしてもう1つ、OpenAIのO1miniというモデルが登場しました。名前の通り、o1のモデルよりも安くて早いモデルがo1miniの特徴になっています。

o1の利用制限

o1miniの紹介の前に1つ重要なポイントがあります。それがOpenAIのo1は、非常に計算コストが高いというので、利用回数の制限がめちゃくちゃ厳しくなってます。

ChatGPTのブラウザから利用できるんですけれども、o1のプレビューに関しては1週間で30回、o1miniに関しては1週間で50回しか使えないと書かれています。これデイリーじゃなくて、ウィークリーなので、1週間というところがポイントですね。1日換算すると、o1のプレビューに関しては4回か5回しか使えないと。o1のminiに関しても7回ぐらいしか使えないというところで、なかなか気軽に使えないなという感じがしますね。

この利用回数は、増加させていくという話と、ChatGPT自体に自動的にどのモデルを使えばいいのかっていうのを選択させてモデルを利用させるというところも検討してるみたいです。つまり、今回のOpenAIのo1っていうのは、難しい論理的な推論が必要になるタスクに関しては非常に強いので、そういった入力がユーザーから与えられたら、自動的にo1を使うようにして、そうじゃない場合はGPT4omniを使ったりとか、そういったことを自動でやってくれるようなシステム開発しているみたいです。

APIに関してはTier5のユーザーということで、ほとんどの人はTier5にならないと思うので、まだ気軽には使えないという状態みたいです。ちょっとこちらの方見てみると、Tier5がどんな感じかというと、大体14万円くらいOpenAIのAPIを使ってたらTier5になるようです。

o1モデルはどんな場面で力を発揮できるのか

あとは、コーディングのタスクが得意というところでもう少し具体的なデモも紹介されていました。これプロンプト入れてから21秒考えてからコードを生成しています。この引用のマークダウンで出てるところが思考のプロセスの要約になっています。プログラム作ってという風に言われて、どういう風に作ればいいのかというのを考えて、その思考を最初にまず出してると。その後にコーディングをしてくというのがOpenAIo1の特徴になっています。

ゲームを手軽に作れますよというところがデモされてました。ゲームくらいだったらGPT3.5とかでも作れるのかなっていうな感じもしますが、色々と実験してみないと違いが分かりにくいところではありますね。

もう1つのモデルとして、OpenAIo1miniというモデルが登場しました。o1のminiは、o1よりも安くて、文章の生成速度が早いモデルというところなんですけども、気になるのは、これまでのGPT4omniと比較してO1のminiは強いのかというところかと思います。

様々な側面で評価されてるんですけども、GPT4omniと比べて、o1のminiの方が精度が高いというのが分かります。一部においては、o1のプレビューよりもominiの方が高くなってるというところで、ちょっとo1のminiとo1プレビューの使い分けが少し分かりにくい結果かもしれません。

よく言語モデルがリリースされた時に使われてる評価指標として、mmlUというものがあるんですけども、それを見ると、GPT4omniの方がo1miniよりも高くて、プレビューとo1miniに関しては、GPT4omniを超えてるというのが分かります。o1に関しては、92.3ということで、これまでのモデルよりもかなり性能が良いというのが分かります。

ただo1に関しては、まだ出てなくて、現在出てるのは、プレビューということになってます。OpenAIは最近頻繁に新しい機能を出してこないので、このo1のモデルがいつ出てくるのかというのは注目のポイントとなりますね。

もう1つ知っておいた方が良いポイントとしては、これまでのGPT4omniと比較して、o1のプレビューと、o1のminiがどのタスクにおいて、強いのかというところになります。

何かを書かせたりとか、編集させたりとか、そういった場合はこれまでのGPT4omniの方が好ましいと、評価されています。一方で、プログラミングとか、データ分析とか、数学的な計算を行うタスクに関してはo1シリーズの方がかなり良いという結果になってます。特に数学的な計算を行うタスクに関しては、o1プレビューだと勝率が72%ということで、GPT4omniと比較してかなり良いのかなという感じがしますね。

あとは、モデルの出力速度の比較が行われていました。1番左が、GPT4OMで、真ん中が、o1のmini、1番右がo1のプレビューになってます。同じプロンプトを入れた時に、どれぐらいの秒数かというので、GPT4omniには3秒、O1のminiは9秒で、o1のプレビューは32秒という感じで、GPT4omniの10倍近く出力まで時間がかかっています。

普段使いする場合は、このo1のminiが有力候補かなと思うんですけども、o1のminiも、現在は1週間で50回しか使えないというところで、なかなか使いどころが難しいのかなというところが現状かと思います。o1のminiに関しても、安全性に関して配慮してますよというところが書かれています。

o1をAPI利用した場合のコスト

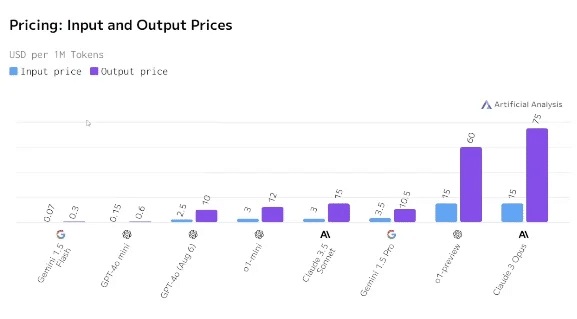

もう1つ気になるのは、APIから利用した時にどれぐらいコストがかかるのかというところかと思います。これアーティフィシャルアナリシスという会社の比較結果になっていて、青色が入力で、紫が出力にかかる料金になっています。GPT4omniシリーズはこれぐらいの料金なんですけども、今回のo1のminiは、GPT4omniよりも少し高いという値段設定になっていて、GPT3.5よりも少し安いという感じになってます。

o1のプレビューに関してはかなり料金が高い。ただ、少し前に主流であったGPT3のOpusよりも安くなってるというのが分かります。なので、料金体系だけ見ると、o1のモデルはめちゃくちゃ高いわけじゃないというのが分かるかと思います。

一方でOpenAIの公式ドキュメントの方を見てみると、今回、入力をしてから考えるステップというのが挟んで、回答が出力されるんですけども、この考えるステップに関してもアウトプットトークンとして料金が発生してくるというみたいです。料金体系は安いんですけども、出力するトークン数が考えるステップを挟むので、多くなってしまうと。そうすると、料金もかなり高いのかなと思います。

ドキュメントの方を見てみると、OpenAIの推奨としては、最低でも2万5000トークンくらいはリーズニングステップで出力されるという風に書いてるので、2万5000トークンが毎回課金されてしまうと、結構使いにくいのかなという感じはします。

本当に精度が求められるような、そういったタスクに関しては使えるかもしれないんですけども、なかなか普段の使い方としてAPI使って何かやるってのは少しコストが高いかもしれないなという感もします。

画像の入力とか、ファンクションコーリングとか、早いレスポンスが求められるような、そういったアプリケーションに関しては、GPT4omniとか、GPT4omniのminiとか、そういったモデルの方が引き続き、正しい選択ですよという風に書かれています。なので、今回のOpenAIo1は、すごいモデルなんですけども、タスクによっては、GPT4omniとかomniのminiの方が適してる場合があるというところは注意が必要かなと思います。

挙動として、この思考時間というのが追加されてるというのが今回新しいところというところです。これに関しては、公式ドキュメントを見ると言語モデルが使ってる思考のステップを要約したものがこちらに表示されてるということでした。この文章を使ってるというよりは、もっと細かく思考をして、その上で回答を生成してるという感じかと思います。

OpenAIの公式のページ見てみると、ユーザーには表示されていない思考のプロセスが公開されていました。これまでのGPT4omniを使うと、ユーザーが入力して、それに対して回答を生成するという感じで、これぐらいで出力が終わります。一方で、今回のOpenAIo1プレビューだと、ユーザーが入力した後に、めちゃくちゃ思考してるんですよね。これちょっと長すぎてびっくりするんですけども、ずっと思考して、思考のステップが終わってやっと回答が生成されるという感じみたいです。

APIを使うと、この思考プロセスの分が全部課金されてしまうと考えると、結構恐ろしく高くなるんじゃないかというところが正直ありますね。

o1のために課金は必要か

o1のモデルを色々紹介してきたんですけども、皆さんどういう風に感じたでしょうか。このシンキングプロセスがすごい新しいというところで、もうちょっと利用回数の制限が緩くなったら、みんな使いやすいのかなと感じます。

あとは、プレビュー版じゃなくてo1のモデルがいつ出るのかというところが楽しみです。ChatGPT解約したけども、また契約した方がいいのかなと悩んでる人もいると思うんですが、個人的な見解としては、o1のモデルがすべてのタスクにおいて強いというわけじゃないので、ほとんどの人にとっては利用回数の制限が厳しいというところを考えると、Claudeの3.5で十分なのかなと個人的には思います。