なぜひとはUIを操作できるのか

なぜひとはディスプレイに表示されたボタンを押せるのだろうか?

パソコンを毎日使う現代人にとっては、当然のことすぎてもはや疑問に思われないかもしれない。

しかしデジタルな世界の変化するUIを、私たち生身のヒトが使いこなしているのは、本当に当然のことなのだろうか。

なぜひとは眼で見たものがわかるのか

眼で見たものをわかるという旅は、眼が光を感じるところからはじまる。眼に入った光は、硝子体を通って網膜に像を結ぶ。像のなかに明るさが急激に変化する境目があれば、そこを輪郭として形が浮かび上がる。その形は図になり、図以外の部分は地になる。視覚系は無意識的な推論により、図を何らかのオブジェクト(見え)として認知する。

つぎに、目の前のオブジェクトと頭のなかの記憶とを照合して、見えが何であるかを同定する。つまり、言語ラベルによってカテゴリー化する。

こうして、視覚からのボトムアップな知覚と、知識によるトップダウンな情報処理によって目に映るものが何なのかわかる。

また、網膜像は二次元の像だが、私たちは三次元空間の立体を感じ取ることができる。これは、急速眼球運動や輻輳(注目するものに焦点を合わせようと、両眼の視線が寄ること)が、奥行きの手がかりになっていると考えられる。

しかし、私たちが実在している三次元の空間に限らず、二次元の平面についても見たものがわかるのはなぜだろう?

なぜひとは平面に描かれたものがわかるのか

眼球運動や両眼の間の距離を使わず、片目を閉じたときにでも奥行きを生じさせる手がかりを単眼的手がかりという。単眼的手がかりは生後の経験から学習され、絵画や写真においても奥行きを感じさせる。このことから単眼的手がかりは絵画的手がかりともよばれる。

絵画的手がかりには、線遠近法や大気遠近法、きめの勾配、重なり合い、陰影といったものがある。

たとえば重なり合いとは、形の輪郭が中断されずにつづいて見えるものを手前に、他の面で隠されているものを後方にあると感じることである。陰影とは、太陽の光や照明がふつう上方からくるとして凸凹を感じることである。

また、見えの大きさから距離感を無意識的に算出する大きさの恒常性も、平面におけるオブジェクト認知を手伝う。

なぜひとは平面のボタンがわかるのか

しかし、パソコンのディスプレイに表示されるGUIは、遠近法で描かれた絵画とは違う。たとえばmacOS MontereyでFinderを開くと、そこで見られる奥行きの手がかりは重なり合いと陰影くらいだ。

しかも、Finderウィンドウをもうひとつ開いて重ねると、手前と後ろに重なっているだけで、見えの大きさは変わらない。三次元の空間では、ふつう後方にあるものは小さく見えるが、デスクトップには遠近法もない。

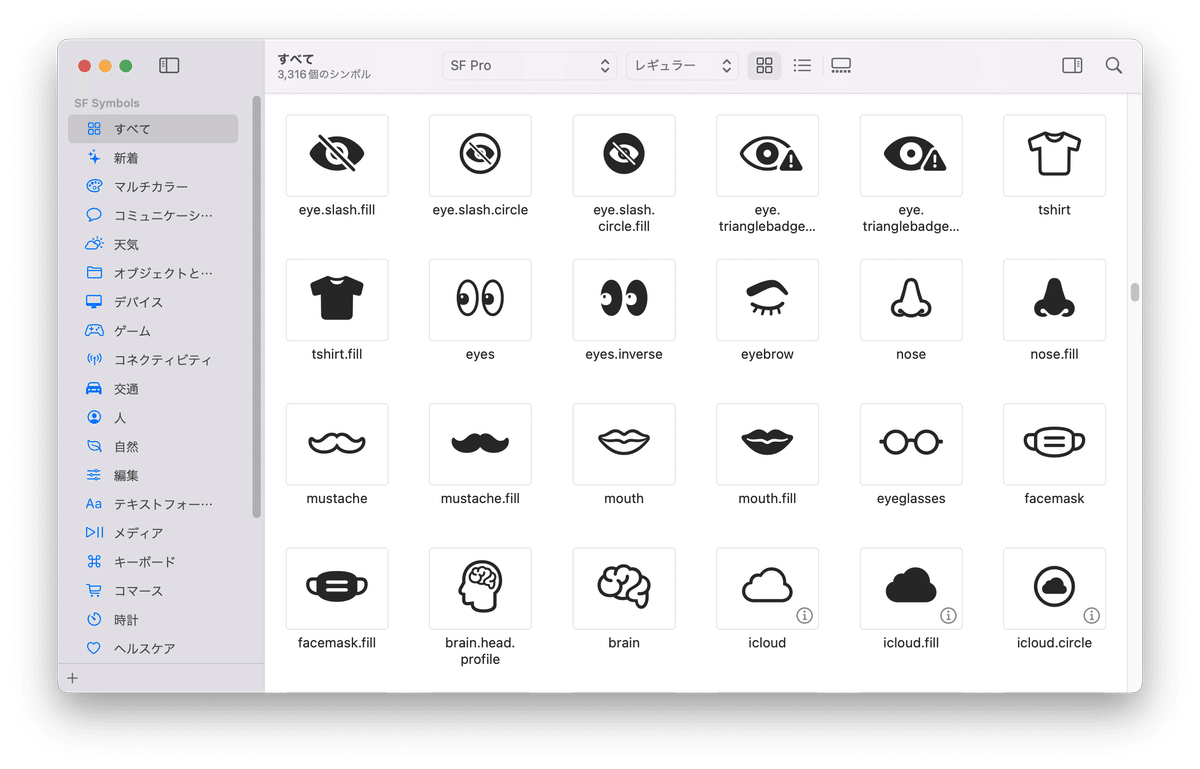

それに、ボタンの見た目もAquaと比べてすっかりフラットになった。Finderのツールバーにはラインスタイルのアイコンがそのままポンと置かれているだけだ。

しかし私たちは、新奇なアイコンでもボタンだと認識できる。このように、フラットなアイコンをボタンと認識できるのは、無意識的に知識によるカテゴリー化を行っているからだろう。

なぜひとは平面のボタンを押せるのか

GUIのボタンを、どのようにしてボタンとして認識できるのかはわかった。しかし、それをクリックできるのはなぜだろう?

だって、絵画や写真に手で触れてもそのなかの世界には入り込めない。それから、紙にボールペンでメモを取るときは、ペン先で紙との摩擦を感じ取って字が書けていることがわかる。

それなのになぜ、私たちはマウスのボタンをカチッとして、ディスプレイのなかの世界に介入することができるのだろう?

ところで、あなたは自分がはじめて絵を描いたときのことを覚えているだろうか。はじめて自転車をこいだときのことでもいい。

最初は思い通りに手や体を動かせず、繰り返し挑戦することで上手に使いこなせるようになったのではないだろうか。

これは、道具を使うことによって新たな身体感覚が入力され、試行の反復でもって脳の体性感覚地図を書き換えることができたためだ。

たとえば、ボールペンを持つと私たちの指の感覚はペン先にまで延長する。包丁を握れば切先まで、車を運転すればバンパーやタイヤ周りまで、身体感覚はダイナミックに調整される。

では、はじめてマウスを握ったときはどうだっただろう。マウスも、最初は思い通りに動かすことは難しかったはずだ。しかも、マウスの先端はポインターで、ディスプレイ上にある。それでも、マウスやペンタブレットでさえ、繰り返し使ううちに思い通りに操作できるようになる。しかもボタンをクリックすれば、押したという感覚すらある。

これは、視覚的フィードバックによって、身体感覚がディスプレイ上にまで伸びているためだといえるのではないだろうか。

そういうわけで、私たちUIを操作できるのは、「UIを操作することで私たちの身体感覚や脳地図が再調整され、脳内での身体のあり様が、ディスプレイに表示されたボタンを押せるように変化するから」といえるのではないだろうか。

反対にいえば、UIを思うように操作できないひとは、眼で見た形をカテゴリー化するには知識が不十分だったり、まだUIを操作する回数が少なくて脳地図を書き換えられていないのかもしれない。

そして、操作しにくいUIは、ひとの身体感覚にフィットしていないのかもしれない。私たちは、たいていはどんなペンでも字が書けるのだから。

参考文献

アリソン・L・バース;道具で伸び縮みする身体(デイヴィッド・J・リンデン;40人の神経科学者に脳のいちばん面白いところを聞いてみた;河出書房新社(2019))

渡邊恵太,樋口文人,稲見昌彦,五十嵐健夫;複数ダミーカーソル中における自分自身のカーソル特定;情報処理学会 インタラクション 2013(2013)[PDF]

この記事は、2022年9月4日に開催された『デザイン読書日和』で配布したものの再録です。

この記事が気に入ったらサポートをしてみませんか?