企業のアクセシビリティへの取組 その1(Apple,Amazon,Sony)

1,Apple

Appleのセッションは超満員だった。前のセッションの終了と同時に入ったので、私は何とか座れたが、かなりの人数が床に座り込んで聞いていた。

しかし数年見ないうちに、Appleのアクセシビリティ機能は劇的に進化している。ドアにiPhoneを向けると、そのドアに書かれている文字を読み上げてくれるDetection Modeをデモしていたが、全盲のミュージシャンが、ライブ演奏のために訪れたホールで、着たいジャケットの色を選び、開けるべきドアを選んでホールへ向かうデモ映像が流れていて、かっこよかった。

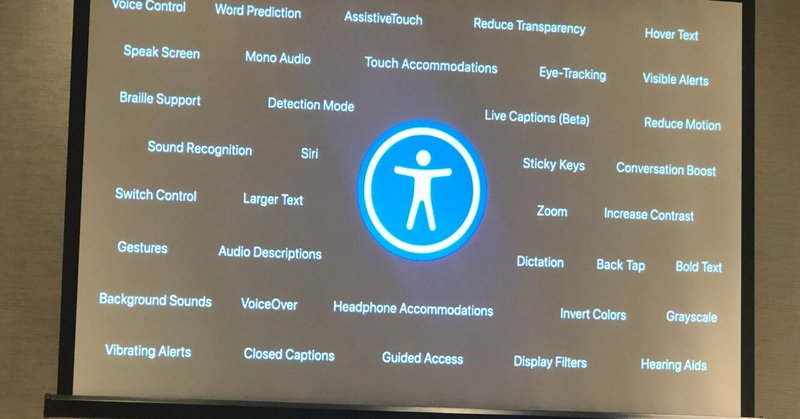

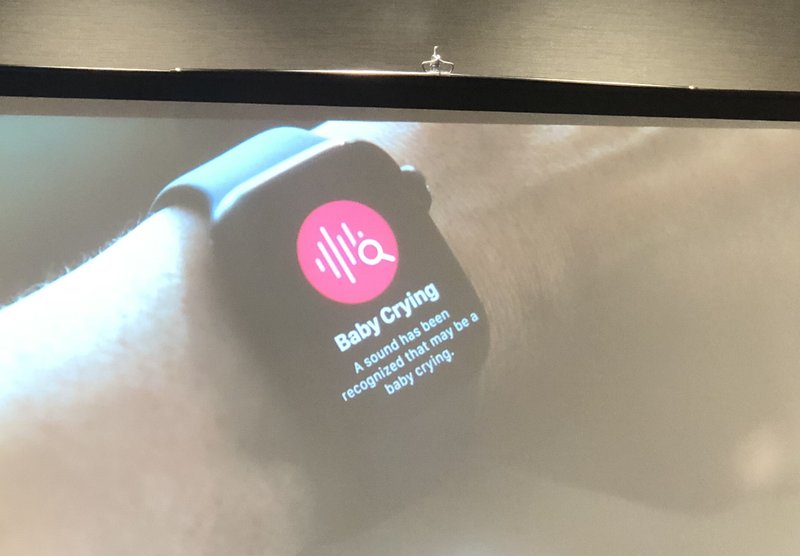

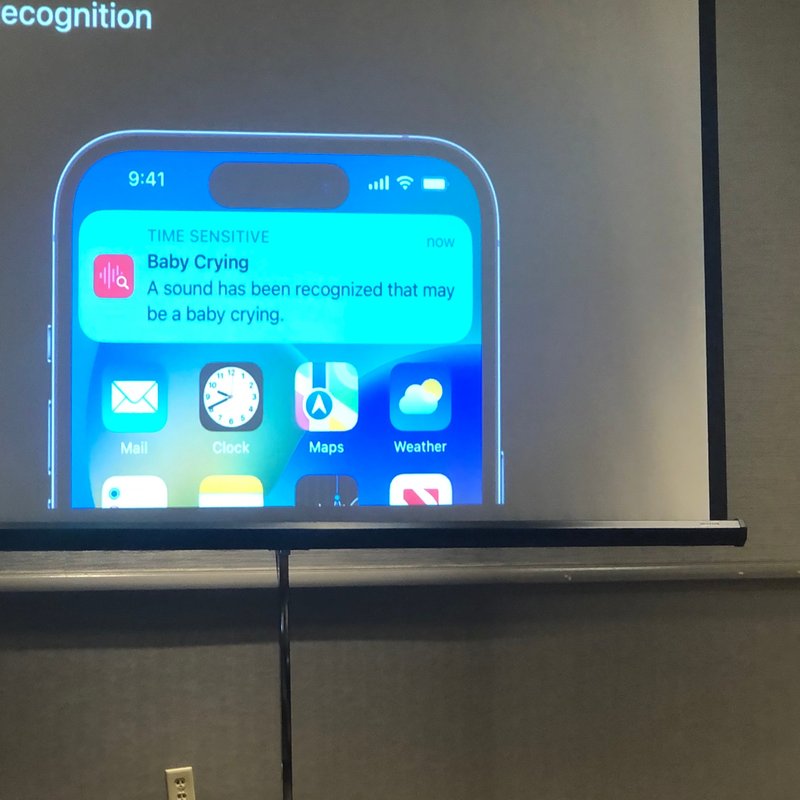

GoogleGlassやOcam MyEyeで行ってきたような周辺の情報を認識する技術は、どんどん進んでいる。特別なものを使わなくても、一般のiPhoneやiPadがとってもUDになったので、それだけでできることが劇的に増えているのだ。まだベータ版だが、Live Captioning(リアルタイム字幕)も出せるという。AppleWatchで「赤ちゃんが泣いている」といった、自分が聞きたい音の認識を個々に登録することもできる。ノイズキャンセルや集中モードなどで知覚過敏の発達障害にも対応している。視覚・聴覚・肢体不自由・認知など、実に多くの障害をカバーしているのだ。点字ピンディスプレイなど支援技術の利用も、Bluetooth等で接続が標準化されているので、それほど難しくない。OSの基本機能をきちんと理解すれば、かなりのことが可能になるはずである。これまでGreggなどが何十年もかけて、OS本体をUDにすることを進めてきたが、その成果だなあと認識した。

いろいろ楽しい機能があり、使ってみたいものだと思う。でも、これって、日本で教えてくれるところはあるんだろうか?ここまで高度化したアクセシビリティ機能を、例えば日本の高齢者が、使えるようにする仕組みはあるのだろうか?携帯ショップで聞くのははばかられる。Appleストアで、こういう機能を教えてくれるのかな?この分野に関して、電話サポートは米国内と北京にしかない。日本語のサイトもあるし、ネット上には日本での支援コミュニティも存在はするようだが、活発には見えない。そもそもシニアはここへたどり着く前の段階にいるかもしれない。アクセシビリティ機能に、アクセスできていないかもしれないのだ。せっかくの機能なのだから、もう少し、一般の高齢者や障害者が、自分で使えるようになるための、地域コミュニティ内の仕組みが日本にも必要だと思えた。

2,Amazon

Amazonのセッションにはたくさん参加した。初日のJoshのラジオトークから、ハッカソンまで、毎日たくさんのセッションがあった。

しかし、Amazonは、伝説の?アクセシビリティエンジニアだったPeter Kornが活躍していた時代から、今でもどんどん進化している(追加情報:彼はまだAmazonで現役なのだそうだ!)。Joshは、子どものころ、硫酸を顔にかけられて失明した人だが、若い頃からコンピュータサイエンスに才能を発揮していた。以前は視覚障害の支援技術研究で有名な、サンフランシスコのSmith Kettle社に居た。私もトーキングサインなどの見学で何度か訪れたことがある。CSUNの常連で今年も発表していた。ここからAmazonに引き抜かれたのだ。W3CでWebアクセシビリティのリーダーだった車いすユーザーのShadiも、今はアマゾンに移っている。優秀な障害のあるエンジニアは、欧米では引く手あまたなのだ。Joshのセッションは、今回、3つほど参加した。彼らの話を聞いていると、アクセシブル&ユーザブル という言葉が、お神酒徳利のように、ペアで使われているのがわかる。なんだか日本では、HCDのメンバーはユーザビリティの専門だけど、アクセシビリティチームとは別世界といったふうに過ごしている気がする。CSUNで、企業や行政の担当者が、この二つを不可分のものとして扱っていることが、とても羨ましい。

Amazon社内のハッカソンの紹介では、Joshがメインで話してくれた。Amazonの中で、リアルなユーザーニーズをどのように把握して解決するか、部門横断のハッカソンチームを作って成果を競い合うのだが、チームのどこかに障害当事者を入れるのだという。そうなると、ニーズ把握、アイデア出し、企画、プロトタイピング、実装などのあらゆる場面で、データやコミュニケーションのUDが必要となる。チームメンバーは、知らず知らずのうちに、UDを前提とした情報作成や提示が当たり前になっていくのだ。そしてもちろん、アウトプットはアクセシブルなものとなる。それが当たり前という文化が根付いていく。何より、参加者がとても楽しそうだ。それぞれ、役割があるのだが、どこかに障害者がいるということは、全社に対して研修効果が大きいことがうかがわれる。アクセシビリティのバーを上げる人、ジャッジ、参加者、オーガナイザーなど、何にでもなれそうだ。

私も日本国内でさまざまなアイデアソンやハッカソンに参加してきたが、社内で普段からやっているところはそんなに多くない。ましてや当事者がごろごろ社内にいて、複数のプロジェクトを一緒に進めるというのは、日本ではないかも。ちょっと羨ましかった。

3,Sony

SONYは昨年のCSUNで華々しくUD宣言をして、喝さいを浴びていたが、日本でもUDを前提とした製品開発の方針をプレスリリースして話題になっていた。今年も複数のセッションを持ち、デモブース同様、なかなか人気だった。

アクセシブルな未来のためにイノベーションを起こすという理念は素晴らしい。アクセシビリティとユーザビリティを進めるのは社会的責任、という言い方は、ちょっと他のCSUN参加のIT企業からするとほほえましくはあるが、日本の企業としては、先進的だと思われる。ヒアリングエイドの自動調整や、Xperiaのアクセシビリティ強化など、さまざまな取り組みが紹介されていた。音声関連はやはり強いし、視覚障害者が写真を撮る機能なども強化されているようだ。

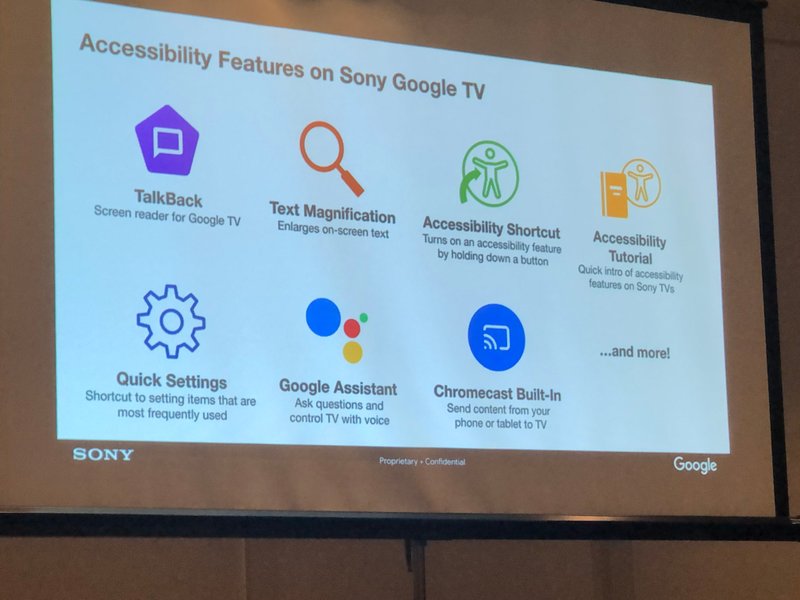

別のソニーのセッションでは、Googleと共同で、どうすればGoogleTVをもっとアクセシブルにできるかを語っていた。テレビはもはやPCそのものになり、アンドロイド端末としてのデジタルアクセシビリティが要求されるものとなってきたのだ。だから、画面はTalkBackで音声読上げが出来たり、拡大や色変更や動作の時間調整ができるものとなってきている。かつて三菱電機のTVが、EPG(電子番組表)を音声で読み上げてくれたときの感激を思い出す。TVもどんどん進化してUDになっていっているのだ。で、セッションでは、TalkBackをどう使うかに関し、ユーザーと対話を進めてどんどん仕様を変えて行っていることなどが報告されていた。

これ自身はとても評価できる。だが、自分でもリモコンでアクセシビリティの設定をするのはかなり難しいと思ってきた。だから、私はこの話を聞きながら、少し考えてしまうこともあった。完全に個人的に使うTVならいいが、TVは家族で共有することもある。おじいちゃんと孫とでは、設定や好みが異なる場合も出てくるだろう。テレビ本体をアクセシブルにすること、デジタルの画面で音声読上げができることは、嬉しくはあるのだが、別のアプローチもある気がする。たとえば、手許のリモコンとして自分のスマホが使えたら?ATを含め、使い慣れた環境が、コントローラーになる。番組表や設定画面などのための音声フィードバックはスマホで聞く。テレビ自体の音声とはバッティングしない。イヤホンを使うことも可能だ。そのスマホからの指示であれば、その人用にカスタマイズした状態に設定できる。もちろん、複数の家族からのスマホからの指示が干渉しないような配慮は必要だが、難しいことではないだろう。

これまでも、家電やデジタル機器本体をUDにすることにがんばってきたが、本体はコンテンツをUDにすること、APIを提供することに徹底し、ユーザー側の端末を個人向けにカスタマイズして、そこから指示を出すというほうがシステムとしてはすっきりするのではないか。。。などと考えてしまう。AIスピーカーが家電や家の環境をコントロールできるように、手許のスマホからTVが制御出来て、番組が聞けたり、リアルタイム字幕が自分の見たいフォントやカラーリングで見えたりほうが、本人も家族も幸せなんじゃないか、などと思った。ま、これも、私の妄想である。

この記事が気に入ったらサポートをしてみませんか?