英語教育・英語学習に関する独り言19 - DXと言語教育について②

前回記事の続き。まずは神戸学院大学の仁科教授の講演、「コーパス、機械翻訳、そしてAIの現在」について。

仁科先生が自身の仕事を紹介する方法がユニーク。いきなり「『 舟を編む 』という映画を観たことがある方、いますか?」で始まった。CJは当然ながら挙手。会場には他にもチラホラと手を上げている方々が。ここから話はコーパスへ。

*ちなみにコーパスが何なのか知らない人は語学教育に携わってはいけないと個人的には思っている。またCOCAを見て、あるいは聞いて「何のことだか分からない」という人は、英語教育から去ってほしいとすら思っている。極論だとは分かっているが、塾・予備校上がりの英語講師・英会話教師にはCOCAを見たことも使ったこともないというのが本当に多い。

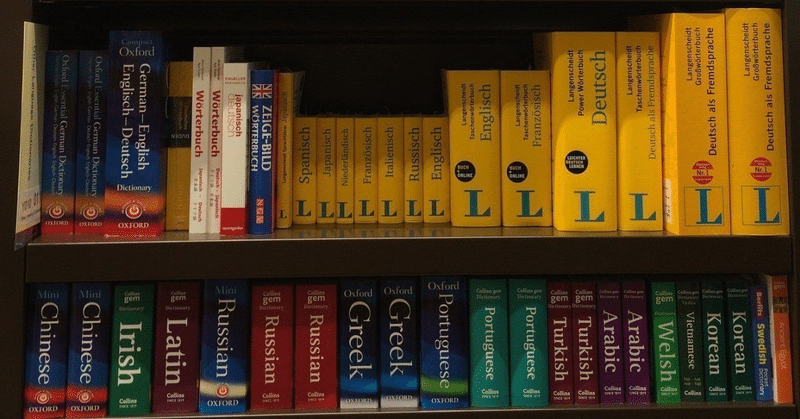

辞書は当然、紙から始まったわけだが、その当時は辞書編纂者の知識や好みがそのまま辞書の質や特徴になっていた。これを大きく変えたのがCOBUILD、すなわち Collins Birmingham University International Language Database だとされている。これは computer-based な辞書の雛型だと言える。そもそも言葉がどのように使われ、どのような意味を持ち、どのような言葉と結びつくことが多いのかを、個人あるいは少数の人間で調査・把握できるものでもない。そこでコンピュータの出番となる。ちなみに Corpus の主産物を辞書とするなら、副産物は Siri だったり、Grammarly だったり、ChatGPTだったりするらしい。実に面白いではないか。

コーパスが大規模化すれば、単語集としての質も向上する。さらに英語だけではなく、他の言語のコーパスも大規模化させれば、パラレル・コーパスが生まれてくる。これは同じ内容を異なる言語で記述した文章を対訳したものを組み合わせたコーパスのこと。たとえば旧約聖書はヘブライ語、新約聖書はギリシャ語で書かれているが、それは後にラテン語にもなり、またマルティン・ルター以後は各国の言語に盛んに訳されていった。そうした同一テキストの別言語約の大規模データベースがパラレル・コーパスとなる。パラレル・コーパスの質が向上すれば、それはすなわち機械翻訳の質が向上することと同義であると言える。

そこで話は ChatGPT へ。ChatGPT が Google Translate よりも遥かに性能がよいのは、言語Aから言語Bに言葉を置き換えているからではなく、高度に数学的な処理を施しているからのようだが、そこは話の要点ではない。ChatGPTとしばしばセットで語られる LLM、すなわち Large Language Model とは、超大規模パラレル・コーパスで、その出現により機械翻訳の質が飛躍的に向上したのだ。個人的には、この解説が聞けただけでも満足だったが、もう少し補足しておこう。コーパスとは語の用例集であって、用例が必ず正しいわけではない。ここでいう「正しい」は、「文法的・意味的に正しい」であって、現実であるとは限らないということだ。たとえばコーパスの中に「臍が茶を沸かす」というデータがあるとする(というか絶対にある)。ところが何かの拍子で、「茶を沸かすにはやかんと臍が使えます」などというアウトプットが出てきてしまう可能性がある。めちゃくちゃ乱暴に説明すれば、これがハルシネーションの実態である。ChatGPTが言語を数学的なパラメータで処理している過程はブラックボックスらしいが、大まかな仕組みを分かっていればハルシネーションも許容できるはずだ。

仁科先生は以下のようには仰らなかったが、CJは「ChatGPT や Google Bard のようなツールを正しく使うためにも、ユーザーには技術と言語のリテラシー、そして教養が求められる」と考える。トマ・ピケティの理論によると、経済格差の拡がりを止めることはできないようだが、生成系AIは下手をすると教育(というよりも学習)にも格差をもたらすものと思う。ひろゆき(CJは大っ嫌いだが)風に言えば「うそはうそであると見抜ける人でないとテキスト生成系AIを使うのは難しい」となるだろうか。

閑話休題。他にも DeepL Write や Quillbotなどのツールや Meta社のAI、Cicero も紹介されていたが、講師目線ではZeroGPT や GPTZero のような、AIが生成したテキストかどうかを判別するツールが非常に面白いと感じられた。好むと好まざるとにかかわらず、AIが我々の仕事および生活にインパクトをもたらすのは間違いない。重要なのは相手を知ること。我々は Homo Sapiens なのだから。

この記事が気に入ったらサポートをしてみませんか?