画像生成AIと一緒に過ごした約一年を振り返る 2 StableDiffusionの公開(2022/8~2022/10)

この記事では、2022/7から2023/10にかけて筆者が画像生成AIとどのように関わってきたかを実際の生成画像や一般的なニュースを交えながら振り返っていきます。今回はStableDiffusionが公開されてからnovelAIが公開される直前までの間の話をします。

前回の記事はこちら。

StableDiffusionの公開

midjourneyに触れてから一ヶ月ぐらい経った頃、StableDiffusionが公開された。

こういう記事が読まれた。StableDiffusionの公開はchatGPTが公開される遠因になったり色々な社会的影響をもたらしたと思うが、それよりもこの記事では当時のStableDiffusionの使用感などについて書いていこうと思う。

今(2023年10月)でもStableDiffusionは誰でも環境構築できるとはいえない程度に敷居の高いソフトウェアだと思うが、公開当初はインストール方法を日本語でわかりやすくまとめた記事もなかったし、丸一日ぐらいかけてなんとかインストールした(ただし、かけた時間の多くは何かをダウンロードしたりインストールしたりするための待ち時間だった)

StableDiffusion WebUIもなかったので、最初はコマンドプロンプトにプロンプト(画像を生成するための)を直打ちして生成していた。ただし、2週間後ぐらいにWebUIに移行することでこういう状況は終わった。

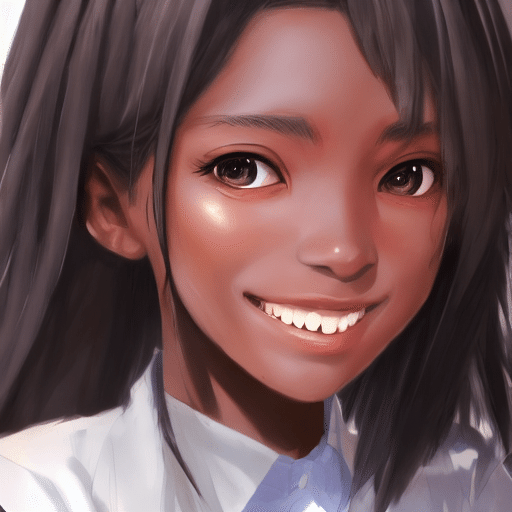

当時良いと思った点としてはまず、生成できる画像の画風の幅が広い事だった。midjourneyでは写真や日本のアニメ風のイラストなどを生成することができなかったが、stablediffusionではできるようになった(しかも、waifu diffusionやnovel AIなどが出てくるよりも前のデフォルトのモデルでの話!)。主観ではこの時初めて「かわいい女の子の顔のイラスト」が生成できるようになった。

ローカルで生成できるので放置していても時間をかければ大量の画像が生成でき、生成した画像ファイルの管理が楽なのも良かった。

当時はグラボとしてGTX 1060を使っていたし、生成のアルゴリズムの最適化が進んでいなかった(たぶん)ので、512*512ピクセルの画像を8枚生成するのに5分ぐらいはかかった気がする(よく覚えていない)。midjourneyも遅かったが、novelAIはサーバーが混んでいない時は早かった

AI生成画像をフルに使ったノベルゲーム「バーチャル地球を救え!」

stablediffusionを使い始めてから数日後、アラスカ4世(筆者)はAI生成画像を使ってノベルゲームを作ろうと思い立った。早期に公開して話題を作り、有名になりたいと思っていたもののうまく行かなかった。ただ、ゲームは無事完成した。以下のリンク先からプレイすることができます。

『バーチャル地球を救え!』というゲームで、15分ほどでクリアできます。

上記のリンク先の記事に詳しい顛末は書いてあるが、当時の私は誰かに先を越されるよりも早く作品を完成させて公開する事に執着しており、着手してから一週間ほどで完成、公開に漕ぎ着けた。その分、クオリティは犠牲になっても仕方がないと考えていた。

画像を生成するのにかなり時間がかかるので、パソコンにプロンプトを入力して生成を始めたら同時進行でシナリオの執筆やスクリプトの編集などの他の作業を行い、画像が出来上がるのを待つというスタイルで作っていった。「AIが生成した画像だけで作ったゲーム」というコンセプトなので可能な限り画像は編集せず、加筆修正などは全く行わなかった。

ヒロインの立ち絵はどうしても必要だったので手間をかけながら生成したものの、それ以外は全て一枚絵を使った。そのほうが楽だったから。

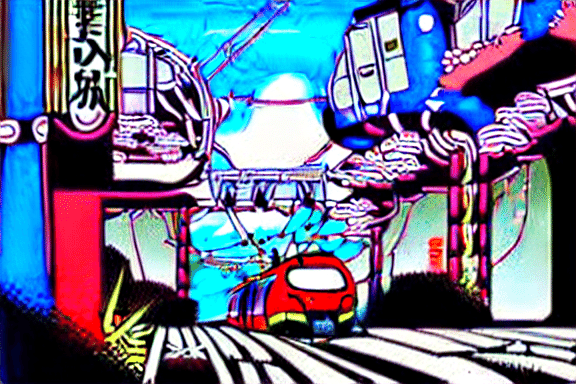

実験的な表現として以下のリンク先の動画のように、AIに雑に生成させた色々な主題の画像を短時間で大量に表示させるというものを試してみた。

これは、生成AIがなかった時代に普通に作ったらかなりの手間がかかっていたと思う。

色々試してみたものの結局、話題性のある作品を作る事には失敗した。

Waifu Diffusionなどの派生モデル

ノベルゲームを作ることに集中している間に、Waifu Diffusionなどの新しいモデルデータが登場した(前後関係が間違っているかも)。この時はまだWebUIを使っていなかったし、CUIを使いつつモデルデータを差し替える方法も知らなかったので、Waifu Diffusionを利用するためだけにgooglecolabというサービスを使う羽目になった。

当時のwaifu diffusionはStableDiffusionのデフォルトモデルのデータの名残が強く残っているモデルデータだったので、萌え絵に特化しているわけではなく画風の幅がある程度あった代わりに、品質が安定しなかった。

WebUIといろいろな実験、pixivへの投稿

コマンドプロンプトやgooglecolabを使って画像を生成するのは不便だったので、NMKDというGUIツールを短期間使った後StableDiffusionWebUIを導入した。このツールは便利なので2023年10月現在でも使い続けている。

WebUIは便利だった。導入することでできる事がかなり増えた。たとえばi2iをするためには従来だったら参照する画像のパスをコピーしてコマンドプロンプトに貼り付けたりしなければならず、面倒で使う気になれなかったが、WebUIがあれば参照画像をドラッグ&ドロップするだけでいいので簡単だし、実際に使うようになった。

普通のイラストを生成する事に飽き始めていたこともあり、とにかく色々な事を試した。

当時の大きな不満として、AIが手を描いてくれなかったり、手を描こうとした結果絵が破綻したり、複雑なポーズを取らせようとすると絵は破綻したりする問題があった。

色々な事を考えながら、9月29日ごろから絵を少しずつpixivに投稿しはじめるようになった。少なくとも結果論としては、これはとても良いタイミングだった。なぜなら、この数日後にNovelAIの画像生成サービスが公開されたからだ。

この記事に続きます。