Akira's ML news #Week 41, 2020

※有料設定してますが、投げ銭用なので全部無料でみれます

2020年第41週(10/4~)に私が読んだ論文や記事で特に面白かったものを紹介します。※なるべく新しいものを紹介していますが、論文投稿日はこの週のものとは限りません。

内容 :

1. 論文, 2.技術的な記事等, 3. 実社会における機械学習適用例, 4. その他話題

---------------------------------------------------------------------

1. 論文

PCAをゲーム理論で解釈し、分散化で効率化

EigenGame: PCA as a Nash Equilibrium

https://arxiv.org/abs/2010.00554

PCAを各固有ベクトルが自身の効用関数を最大化するゲームをしていると解釈し、ナッシュ均衡状態でPCAが成立することを示した。これは分散化可能なアルゴとして実装することができるため、大規模なニューラルネットワークの解析を実施することができた。AEでも同じようなことはできるが、主成分を回復することと等価でもないし、disentangleもできないため、重要な結果。

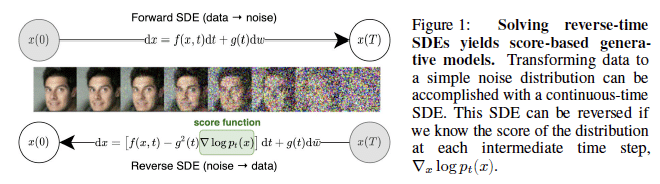

GANを確率微分方程式として解釈し、CIFAR10でFID2.2を達成

SCORE-BASED GENERATIVE MODELING THROUGH STOCHASTIC DIFFERENTIAL EQUATIONS

https://openreview.net/pdf?id=PxTIG12RRHS

ノイズを摂動させて画像を生成する通常の生成モデルと異なり、確率微分方程式を用いてノイズが時間的に発展する連続体を考える。それの過程を逆にすることでノイズから画像を生成する。CIFAR10においてIS 9.9, FID 2.2を達成し、さらに1024x1024サイズの画像も生成可能。

深いVAEで自己回帰モデルを超える

VERY DEEP VAES GENERALIZE AUTOREGRESSIVE MODELS AND CAN OUTPERFORM THEM ON IMAGES

https://openreview.net/forum?id=RLRXCV6DbEJ

78層など非常に深いVAEでPixelCNNなどの自己回帰モデルやFlow系モデルに匹敵する結果を出した研究。自己回帰系がVAEより良い理由はネットワークの深さにあることを示し、大きな勾配は無視/事後分布学習は後半から開始するなど深化に伴う学習難度の向上を克服した。潜在変数次元数によって髪質など画像の情報量を操作することができる。

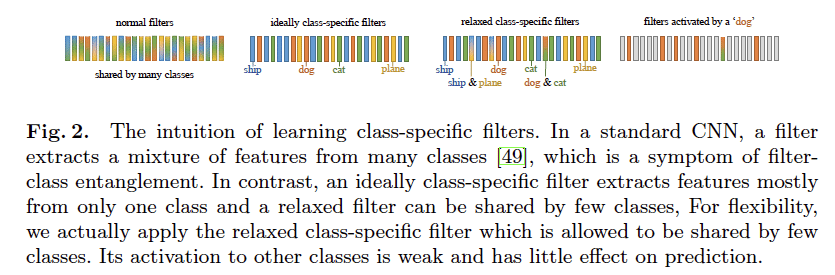

1つのフィルターが1つのカテゴリを担当することで可視化性能向上

Training Interpretable Convolutional Neural Networks by Dierentiating Class-specic Filters

https://arxiv.org/abs/2007.08194

CNNのフィルターを1フィルターが1つのカテゴリを担当するような制約をかけることで、解釈性能を向上させる研究。最終層のフィルターに[0,1]の学習可能な行列をかけることにより、各フィルターが1つのカテゴリしか使わないようにする。分類性能も損なわず、CAMによる可視化がより良くなる。

株価の予測をDLで

Stock2Vec: A Hybrid Deep Learning Framework for Stock Market Prediction with Representation Learning and Temporal Convolutional Network

https://arxiv.org/abs/2010.01197

次の日の株価を予測する研究。Dilated Convを用いて日次データを処理するだけでなく、銘柄毎のニュース記事の自然言語処理を用いた特徴量(Stock2Vec)も並列して使用するモデルになっている。Stock2Vecの埋め込みも肌感と近いものになっている。

BigGANsを蒸留する

TinyGAN: Distilling BigGAN for Conditional Image Generation

https://arxiv.org/abs/2009.13829

BigGANsを蒸留する研究。潜在変数とクラス変数の入力と画像の出力ペアを予め取得してデータセットして扱うことで学習時のメモリ使用を削減し、画素毎のL1距離, Dの隠れ層の差分、通常の敵対的損失の3つで小さな生徒モデルを学習させる。性能は少し劣化するがBigGANsより大幅にパラメータ数削減に成功。

---------------------------------------------------------------------

2. 技術的な記事等

Yann LeCun先生の講義資料が公開

チューリング賞受賞者のYann LeCun先生のDeep Learning講座が無料で見れるようになった。講義資料だけでなく、Jupyter notebookによるコードも公開されている。

テストスコアより訓練スコアの方が高いのはなぜ?

Test データのスコアがtrainデータのそれより高くなった場合、その原因は何か、を議論したRedditのスレッド。適切なtrain/testの分割、kerasの仕様上trainのスコアは1epochのスコア平均であるためtest評価時のモデルとは異なること、などが挙げられている。

---------------------------------------------------------------------

3. 実社会における機械学習適用例

被害者のプライバシーをDeep Fakeで守る

迫害されてチェチェンから逃げてきたゲイとレズビアンのドキュメンタリーを、Deepfake技術を使って顔を合成することで被害者のプライバシーを保護したという記事。単に顔をぼかしたり合成音声を使うと、リアルさが失われ親近感が湧かないが、deepfakeを使うことでリアルさを保ったまま被害者のプライバシーを保護することができる。

Nvidiaのビデオ会議ツール

機械学習を活用したビデオ会議ツールNvidia MaxineをNvidiaが発表した。GPUとクラウドをふんだんに活用しつつ、リアルタイムの翻訳と文字起こし、カメラを見ているように視線を修正などの機能がある。GANを用いて、必要な部分だけを取り出すデータ量圧縮をしたことが目玉の1つのようだ。

火星クレーターを見つけるしんどい仕事は機械学習で

機械学習を用いて、火星のクレーターの発見をさせたという記事。自動化された機械学習ツールで、隕石の衝突跡を発見することができた。小さなクレーターを探す作業は、非常に大変で40分もかかることがある。そのような仕事を機械学習に任せることで、人間をより思考力を使う仕事に集中させることができる。

---------------------------------------------------------------------

4. その他話題

Awful AI

機械学習を使った差別を助長する研究、民衆の監視に利用する研究、軍事利用など”Awful”な活用方法をまとめたgithub。これらに対抗するための議論を促進するためのプラットーフォームになることを願ってつくられた。

Paper with Code とArxivが連携

論文のコードを掲載しているPaper with Codeと論文投稿サイトのArxivが連携した。下の方にあるタブに”Code”というタブが追加され、そこからコードに飛ぶことができる

GPT-3が掲示板に1週間潜伏しても誰も気づかなかった

OpenAIが開発した巨大高性能言語モデルGPT-3が掲示板Redditに1週間潜伏し、人間とやりとりしたが、誰も気づかなかった。時たまGPT-3は陰謀論を流布していたり、「運動の目的は、金を得るという目的のために人生を消費している事実を考えないようにすること」という名言(?)を残している。

---------------------------------------------------------

TwitterでMLの論文や記事の紹介しております。

https://twitter.com/AkiraTOSEI

記事は以上です。ここから下は有料設定になっていますが、特に何もありません。調査や論文読みには労力がかかっていますので、この記事が気に入って投げ銭しても良いという方がいましたら、投げ銭をして頂けると嬉しいです。

ここから先は

Akira's ML news & 論文解説

※有料設定してますが投げ銭用です。無料で全て読めます。 機械学習系の情報を週刊で投稿するAkira's ML newsの他に、その中で特に…

記事を書くために、多くの調査や論文の読み込みを行っております。情報発信を継続していくためにも、サポートをいただけると非常に嬉しいです。