OpenAIの進化:人間の子育てから学ぶ、強力なAIモデルの指導法

まるで子育ての過程で親が学ぶような手法で(注01)でモデルに規範や倫理観を身に付けされる手法「弱から強への一般化」という、昨日発表されたOpenAIのスーパーアライメントの研究結果について解説していきます。

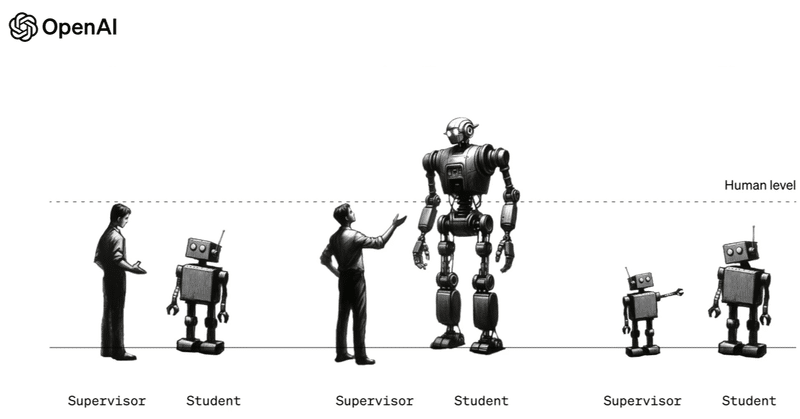

スーパーアライメントチームの最近の成果は、強力な大型言語モデルをより弱いモデルで監督する技術に関するものです。これは、スーパーインテリジェンスAIモデルを人間が監督する方法に向けた小さな一歩となります。

※注01:子供と言う物は元来動物なので倫理とか色々教えざるを得なくなり(コンビニで好きなお菓子をその場で開けて食べるとか教えないとしちゃうので)その倫理を教えるため、親の方が倫理に目覚めると言う羽目になります。「弱(いAI)から強(いAI)への一般化」はそれとおなじ方式です。参考ポストはこちらをご覧ください。

34歳である。そろそろ35歳になる。20代前半の人からすると完全にオッサンであり、50歳くらいの人には若いねえと言われる。悩んでいる

— 熊谷 真士 (@kumagaimanato) December 15, 2023

自分の立ち位置が分からない。どのように振る舞えば良いかわからない。自分はオッサンなのか、若者なのか、お兄さんなのか、お爺さんなのか、お婆さんなのか…

「弱から強への一般化」OpenAI公式ブログはこちら。

筆頭研究者Collin Burnsを称賛するサム・アルトマンのポスト

サム・アルトマンは1時間前のポストでOpenAIのスーパーアライメントチームで「弱から強への一般化」の発表をした筆頭研究者Collin Burnsを称賛しています。

i'd particularly like to recognize @CollinBurns4 for today's generalization result, who came to openai excited to pursue this vision and helped get the rest of the team excited about it!

— Sam Altman (@sama) December 14, 2023

Collin Burnsプロフィール

彼はOpenAIでAGI(人工汎用知能)アライメントに取り組んでいる研究者で、以前はバークレー大学で博士課程の学生でした。彼の研究興味は以下の通りです:

言語モデルを正直にするための教師なし方法の開発。

「簡単から難しい」一般化の極端な形態の研究。

高レベルの抽象化が表現にどのようにエンコードされるかを理解すること。

また、彼は以前にルービックキューブの公式世界記録を保持していました。

コリン・バーンズはOpenAIのスーパーアライメントチームの一員で、このチームはスーパーインテリジェンスAIシステムの安全で倫理的な使用を確保するために設立されました。このチームは、人間を超える知能を持つAIモデルを整合させることが困難な課題であることを認識しています。

また、もう一人のスーパーアライメントの筆頭研究者ジャン・レイクは

この様なポストをしています。

We find that large models generally do better than their weak supervisor (a smaller model), but not by much.

— Jan Leike (@janleike) December 14, 2023

This suggests reward models won't be much better than their human supervisors.

In other words: RLHF won't scale.

Jan Leikeのポストは、大きなAIモデル(例えばGPT-4など)が、それより小さなモデル(弱いスーパーバイザーとしての役割を果たす)よりは優れているが、その差はそれほど大きくないことを指摘しています。これにより、報酬モデル(AIがトレーニングされる際に用いる評価基準)も人間のスーパーバイザーより大幅に優れることはないだろうと示唆されています。つまり、強化学習を用いた人間のフィードバック(RLHF)は、大規模なスケールでの改善には限界があると言っています。

つまり、AIモデルのトレーニングにおいて人間のフィードバックを基にした強化学習(RLHF)の効果に限界がある可能性を示唆しています。このことから、GPT-2のような弱いモデルからGPT-4のような強いモデルへの知識の伝達が完全には効果的でない可能性があることを示しています。この洞察は、AIモデルのトレーニング方法に関する現在の限界や課題に関する重要な示唆を提供しています。

尚、彼は2023 年、TIME 誌のあげるAI 分野で最も影響力のある 100 人の 1 人に選出されています。この事については下記のNoteで詳しく解説していますので合わせてご覧ください。

スーパーアライメントチームのアプローチとは

より弱いAIモデル(例えばGPT-2)を使用して、より進んだAIモデル(例えばGPT-4)を望ましい方向に導くというアナロジーは、AIがAIを導くというもので、チームはこれを使用してスーパーアライメントの仮説をテストし証明します。弱いモデルは人間の監督者の代わりとして機能し、強いモデルは弱いモデルの間違いをただし良い方向に導く事により自らが成長していきます。

この新しい手法によって、AIモデルの教師あり学習を自動化し、以前は人間が行っていた作業をAIが自動で行うことが可能になります。これにより、AIモデルの訓練プロセスが効率化され、リソースと時間の節約につながる可能性があります。また、自動化によってAIモデルの性能向上と発展も加速することが期待されます。

OpenAIスーパーアライメントの目的

スーパーアライメントの目的は、人間よりも賢いAIモデルを適切に導くための方法を見つけることにあります。この場合、「自分より弱いモデルの間違いをただす」という行為を通じて、AI自体が正しい方向に進化し、より適切な判断や行動を学ぶことが目的となります。このように、AIが自己学習し、自己修正する能力を持つことが、未来の高度なAIシステムの管理や制御において重要になるでしょう。

OpenAIスーパーインテリジェンスAIの助成金プログラムを開始

OpenAIは、スーパーインテリジェンスAIの課題に取り組むための協力を促進するために、1,000万ドルの助成金プログラムを開始しています。この助成金は、学術研究所、非営利団体、個人研究者、大学院生に開放されています。また、2025年初頭にスーパーアライメントに関する学術会議を開催する予定です。

「弱から強へ」のプログラムはオープンソースで公開

弱から強への汎化実験を簡単に開始できるよう、オープン ソース コードがGithub上にリリースされました。

GitHubのREADMEのステータスは、

ステータス: このコードベースは十分にテストされておらず、論文で使用した設定とまったく同じ設定を使用していませんが、経験上、大きなモデル サイズのギャップを使用すると定性的に同様の結果が得られます。そして複数の種子。以下の 2 つのデータセットについて期待される結果が見つかります。来週中にコードを大幅に更新する可能性があります。

と書かれており、取り急ぎリポジトリを作った事がわかります。

尚、論文はこちら→WEAK-TO-STRONGGENERALIZATION:ELICITING STRONGCAPABILITIESWITHWEAKSUPERVISION

この記事が気に入ったらサポートをしてみませんか?