【論文瞬読】 LLMの新たな可能性:Symbol-to-Languageで記号推論の壁を越える

こんにちは!株式会社AI Nest です。

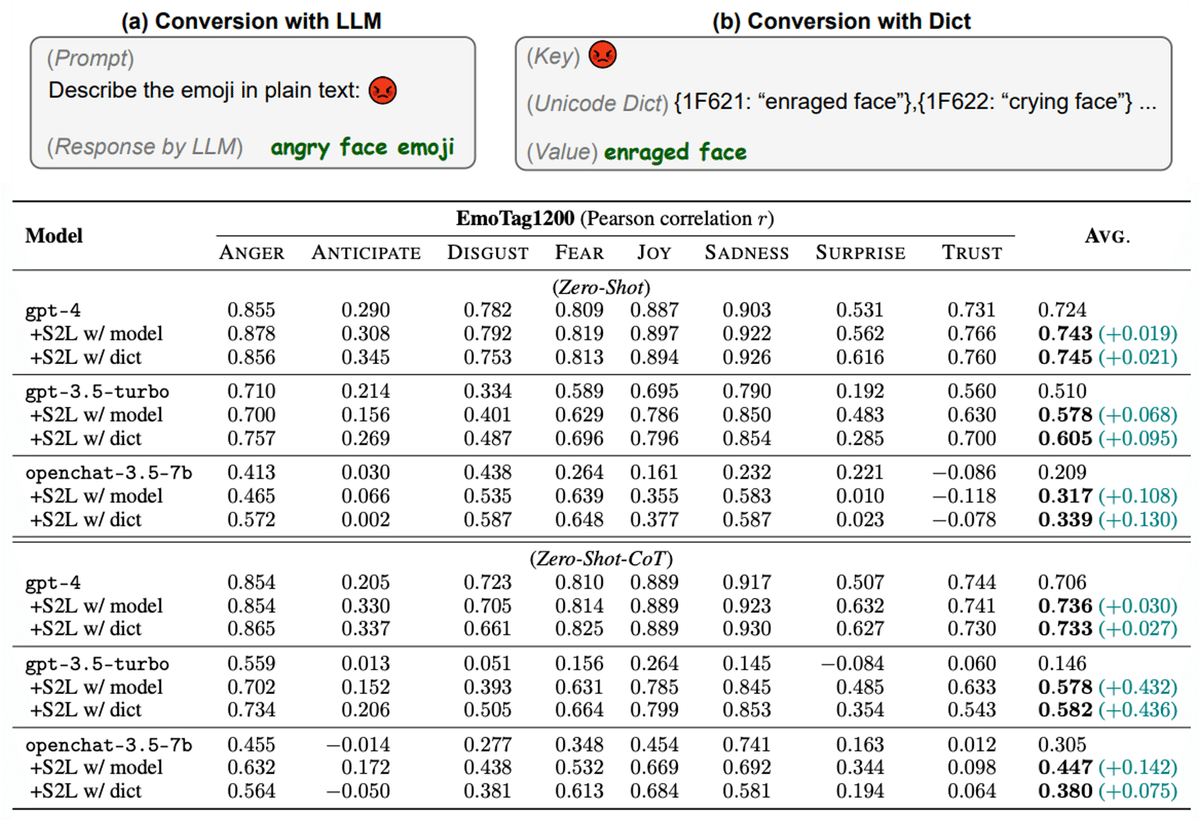

今日は、自然言語処理の分野で注目を集めている論文「Speak It Out: Solving Symbol-Related Problems with Symbol-to-Language Conversion for Language Models」を紹介します。この論文は、大規模言語モデル(LLM)の記号推論能力を向上させる新しい手法「Symbol-to-Language (S2L)」を提案しています。

タイトル:Speak It Out: Solving Symbol-Related Problems with Symbol-to-Language Conversion for Language Models

URL:https://arxiv.org/abs/2401.11725

所属:Institute for AI Industry Research (AIR), Tsinghua University, Beijing, China Dept. of Comp. Sci. & Tech., Institute for AI, Tsinghua University, Beijing, China 01.AI Shanghai Artificial Intelligence Laboratory, Shanghai, China

著者:Yile Wang, Sijie Cheng, Zixin Sun, Peng Li, Yang Liu

コード, データ:https://github.com/THUNLP-MT/symbol2language

🤔 LLMの記号推論能力の問題点

LLMは自然言語の理解では優れた性能を示しますが、数値や分子式、絵文字など、自然言語ではない記号の推論には課題があります。これは、記号表現と自然言語の違いに起因すると考えられています。

💡Symbol-to-Language (S2L)の提案

この論文では、記号を自然言語表現に変換するS2Lという手法を提案しています。S2Lは以下のステップで構成されます

記号を自然言語表現に変換 (LLMやツールを使用)

変換した自然言語表現を元の問題に統合(直接置換または連結)

LLMに入力として与え、問題を解かせる

🧪 実験結果

研究チームは、抽象的推論から感情分析まで8つの記号関連タスクでS2Lを評価しました。その結果、GPT-4やChatGPT、オープンソースのOpenChatなど、様々なLLMで一貫した性能向上が確認されました。しかも、Fine-tuningは不要というのが嬉しいポイントです!

※ 各タスクにおける適用例・概要図と結果は付録に添付

🎉 S2Lの可能性と課題

S2Lは、LLMの自然言語理解能力を活かしつつ、苦手とする記号周りの処理を補うという点で、非常に興味深いアプローチです。一方で、全ての非自然言語表現が自然言語に変換できるわけではなく、特に2次元の視覚的問題などへの適用は難しそうです。また、外部ツールが使えない場合にLLMが不適切な説明を生成してしまうリスクもあります。

🔮 今後の展望

今後は、より多様な記号関連タスクへのS2Lの適用可能性を探ると同時に、LLMによる変換の精度向上や、変換が難しいケースへの対処法の開発なども進めていく必要がありそうです。また、S2LとChain-of-Thoughtプロンプティングなど、他のLLM推論能力向上手法との組み合わせも興味深い研究テーマになりそうです。

📝 まとめ

この論文は、LLMの能力を引き出す新しいアプローチを提示しており、今後のLLM研究に大きなインパクトを与える可能性を秘めています。記号推論という、これまであまり注目されていなかった分野に光を当てた点でも意義深い論文だと思います。皆さんも、是非この論文を読んでみてください!

添付