【論文瞬読】長文コンテキスト理解におけるRAGとLLMの比較とハイブリッドアプローチSELF-ROUTEの提案

こんにちは、皆さん!株式会社AI Nestです。

今日は、自然言語処理における長文コンテキストの理解に関する最新の研究について紹介したいと思います。長文コンテキストを効率的に処理することは、質問応答やテキスト要約など、様々なタスクにおいて重要な課題となっています。近年、Retrieval Augmented Generation (RAG)やLarge Language Models (LLMs)といった手法が注目を集めていますが、皆さんはこれらの手法についてどのくらいご存知でしょうか?

タイトル:Retrieval Augmented Generation or Long-Context LLMs? A Comprehensive Study and Hybrid Approach

URL:https://www.arxiv.org/abs/2407.16833

所属:Google DeepMind, University of Michigan

著者:Zhuowan Li, Cheng Li, Mingyang Zhang, Qiaozhu Mei, Michael Bendersky

今回取り上げるのは、「Retrieval Augmented Generation or Long-Context LLMs? A Comprehensive Study and Hybrid Approach」という論文です。この論文では、RAGとLLMの性能を様々なデータセットで比較し、両者の長所を活かすハイブリッドアプローチSELF-ROUTEを提案しています。この記事を通して、長文コンテキスト理解に関する最新の研究動向を皆さんに知っていただければ幸いです。

RAGとLLMの概要

まず、RAGとLLMについて簡単に説明しますね。RAGは、関連情報を検索し、LLMに提示することで、LLMが効率的に長文コンテキストを処理できるようにする手法です。具体的には、入力されたクエリに対して、関連する情報を大規模なコーパスから検索し、その情報をLLMに提示します。これにより、LLMは長文コンテキストを直接処理する必要がなくなり、計算コストを大幅に削減できるんです。

一方、LLMは、GPT-4やGemini-1.5など、長文コンテキストを直接理解する能力に優れた大規模言語モデルのことを指します。これらのモデルは、膨大な量のテキストデータを用いて事前学習されており、長文コンテキストを直接処理することができます。しかし、その分、計算コストが高くなるという問題があります。

論文の主な知見

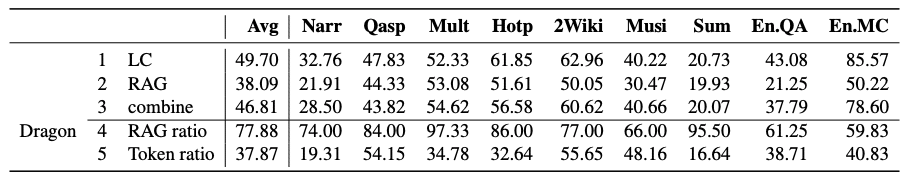

著者らは、RAGとLLMの性能を様々なデータセットで比較しました。その結果、十分なリソースが与えられればLLMの方がRAGよりも平均的に高い性能を示すことが明らかになりました。これは、LLMが長文コンテキストを直接処理できるためだと考えられます。しかし、RAGは計算コストが大幅に低いという利点があります。さらに興味深いことに、RAGとLLMの予測結果は多くの場合で一致していたんです。

この観察は、RAGとLLMの長所を活かすハイブリッドアプローチを開発する上で重要な示唆を与えてくれました。著者らは、RAGとLLMの予測結果が一致する場合は、計算コストの低いRAGを使用し、一致しない場合はLLMを使用するという、シンプルかつ効果的なアプローチを提案しています。

SELF-ROUTE: ハイブリッドアプローチ

著者らが提案したハイブリッドアプローチがSELF-ROUTEです。SELF-ROUTEは、LLM自身の判断でクエリをRAGかLLMにルーティングすることで、LLMに匹敵する性能を大幅に低いコストで実現できるんです。具体的には、以下の2つのステップからなります。

RAG-and-Routeステップ: クエリと検索された情報をLLMに提示し、クエリに答えられるかどうかを判断してもらいます。答えられる場合は、RAGを使用して回答を生成します。

長文コンテキスト予測ステップ: RAG-and-Routeステップでクエリに答えられないと判断された場合、LLMに完全なコンテキストを提示して回答を生成してもらいます。

この方法により、大部分のクエリはRAG-and-Routeステップで処理できるため、計算コストを大幅に削減できるんです。著者らの実験では、Gemini-1.5-Proを使用した場合、82%のクエリがRAG-and-Routeステップで処理可能であることが示されました。

また、著者らはRAGが劣る理由として、複数ステップの推論が必要なクエリ、一般的すぎるクエリ、長くて複雑なクエリ、暗示的なクエリなどを挙げており、今後のRAG改善の方向性を示唆しています。これらの知見は、RAGの研究者にとって重要な示唆になるでしょう。

データセットと評価の網羅性

本論文の知見は、LongBenchや∞Benchなどの実データセットと、PassKeyなどのシンセティックなデータセットの両方を用いて評価されており、一定の網羅性があります。実データセットでは、NarrativeQAやQasperなど、様々なドメインのデータが使用されています。一方、シンセティックなデータセットでは、特定のタスクに特化したデータが使用されています。

ただし、著者らは、シンセティックなデータセットの作成方法によって結果が左右される可能性があるため、実データセットに基づく評価の方が望ましいと述べています。例えば、PassKeyデータセットでは、RAGがLLMよりも高い性能を示しましたが、クエリを少し変更するだけでRAGの性能が大幅に低下することが示されました。このように、シンセティックなデータセットには、データ作成時のアーティファクトが含まれている可能性があるため、注意が必要です。

個人的な感想と今後の展望

個人的には、この論文はRAGとLLMの性能比較とハイブリッドアプローチの提案により、長文コンテキストの理解に関する重要な知見を提供していると思います。特に、SELF-ROUTEは、計算コストを大幅に削減しつつ、LLMに匹敵する性能を実現できる点で優れていると感じました。また、RAGが劣る理由の分析は、今後のRAG改善に向けた重要な示唆を与えてくれています。

今後は、RAGの性能改善やLLMの計算コスト削減などに関する研究が、この分野をさらに発展させていくことが期待されます。例えば、Chain-of-Thoughtプロンプティングを導入することで、RAGにおける複数ステップ推論の問題に対処できるかもしれません。また、LLMの計算コストを削減するために、プロンプト圧縮やモデル蒸留などの手法が有望だと考えられます。

おわりに

長文コンテキストの理解は、自然言語処理における重要な課題であり、今後もさらなる研究が必要とされています。皆さんも、この分野の最新の研究動向に注目してみてくださいね。RAGやLLMに関する理解を深めることで、より効率的かつ効果的な長文コンテキスト処理システムを開発できるようになるかもしれません。

今回は、「Retrieval Augmented Generation or Long-Context LLMs? A Comprehensive Study and Hybrid Approach」という論文を紹介しました。この記事が、皆さんにとって長文コンテキスト理解に関する理解を深める一助となれば幸いです。それでは、次回もお楽しみに!