【論文瞬読】TriSumが切り開く要約AIの未来 - LLMの能力をローカルモデルに

こんにちは!株式会社AI Nestです。

今日は、自然言語処理の分野で注目を集めている新しい研究、「TriSum: Learning Summarization Ability from Large Language Models with Structured Rationale」についてご紹介します。

タイトル:TriSum: Learning Summarization Ability from Large Language Models with Structured Rationale

URL:https://arxiv.org/abs/2403.10351

所属:University of Illinois at Urbana-Champaign, GE HealthCare

著者:Pengcheng Jiang , Cao Xiao, Zifeng Wang, Parminder Bhatia, Jimeng Sun, and Jiawei Han

TrimSumとは?

近年、GPT-3やPaLMなどの大規模言語モデル(LLM)が登場し、文書要約などのタスクで驚くべき性能を示しています。しかし、これらのモデルは膨大なリソースを必要とし、プライバシーの懸念もあるため、誰もが気軽に使えるわけではありません。

そこで登場したのが「TriSum」です。TriSumは、LLMの要約能力をより小さなローカルモデルに転移させるための画期的なアプローチなんです。

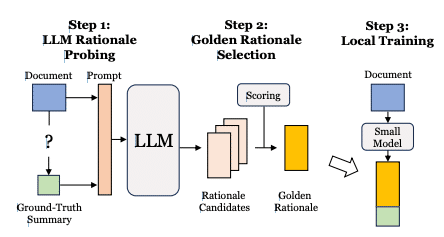

TriSumの特徴は、以下の3つのステップにあります:

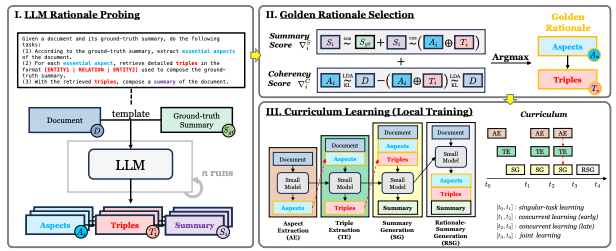

LLMから訓練データのaspect-triple rationaleを引き出す

要約とコヒーレンススコアに基づいて高品質のrationaleを選択する

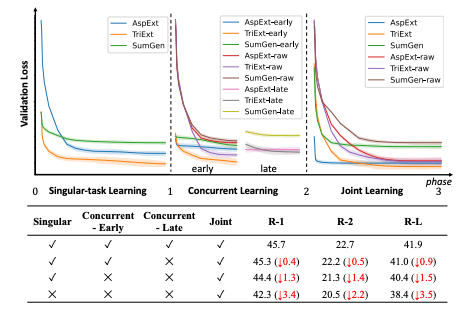

カリキュラム学習アプローチでローカルモデルを訓練する

Aspect-triple rationaleの重要性

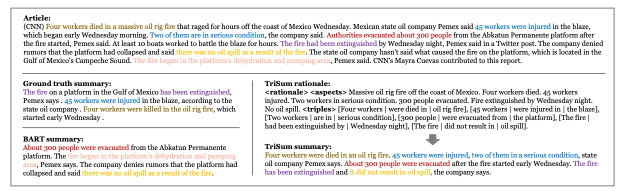

特に注目したいのは、「Aspect-triple rationale」という概念です。これは、LLMが文書を要約する際の思考プロセスを解釈可能な形で表現したものなんです。これにより、要約の生成過程がブラックボックス化せず、ユーザーがモデルの動作を理解しやすくなります。

そして、golden rationale selectionによって高品質のrationaleを選択し、curriculum learningでローカルモデルを段階的に訓練することで、効果的な知識転移を実現しているんです。

実験結果

実験結果も素晴らしいですよ。CNN/DailyMailやXSumなどの複数のデータセットで、TriSumがState-of-the-artモデルを上回る性能を示したんです。これは、TriSumの有効性を裏付ける強い結果だと言えますね。

課題と将来の展望・まとめ

もちろん、課題もあります。LLMのバイアスや不正確さが転移されるリスクや、Rationaleが元テキストのすべてのニュアンスを捉えきれない可能性などは、今後の研究で検討すべき点でしょう。

でも、全体としては、LLMの能力を活用しつつ、より実用的で解釈可能な要約モデルを構築するための新しいアプローチとして、TriSumは非常に有望だと思います。

自然言語処理の研究は日進月歩で進んでいます。TriSumのようなアプローチが、より身近で使いやすいAI技術の実現につながることを期待しています。みなさんも、ぜひこの論文をチェックしてみてくださいね!