生成AIの性能変動:進化の裏に潜む退化要因

この数か月間で、多くの学術論文やTech-NEWS、SNSなどで、大規模言語モデル(LLM)の性能の変化に関して賛否両論が見受けられます。一部からは『NLP(自然言語処理AIの総称)やLLMの回答が不正確になってきた』との批判的な意見が上がっているのに対し、他方では『以前よりも高機能になっている』との肯定的な意見も存在します。

更に『ChatGPT-4の1/100のデータセットでも、ChatGPTよりも高い精度での回答が可能だった』との報告も多数ありますが、なぜこれほどまでに意見が分かれるのでしょうか? 性能の評価が分かれる背景として、以下のような要因が考えられます。

ユーザの慣れ:初めて生成AIを使用すると感動するかもしれませんが、複数のNLPを体験すると、生成AIが様々なコンテンツを生成できるのは『当然』との認識が芽生え、より高度な出力を求めるようになったことが考えられます。

ユーザの主観:使用者の期待や経験、背景によって、生成AIに対する評価や期待が異なってきます。また、所定の条件でテスト運用した結果、ユーザの期待を満たせなかったという事例も多いです。

質問内容の違い:同じNLPやLLMでも、投げかける質問や話の流れ(前の質問内容との関連などの条件)によって、出力される回答内容が異なることから、その品質に対する評価が変動することもあります。

技術の進化速度:生成AI技術の中でも、特にNLPやLLMは急速に進化しています。そのため、最新の技術についてきているユーザとそうでないユーザとで、評価が分かれることも多いです。

用途の多様性:全てのユーザが同じ目的でAIを使用しているわけではありません。例えば、研究者や開発者は高度なタスクに使う可能性が高い一方で、ビジネスマンは自分の業務でどれだけ使えるかを評価する傾向があり、個人ユーザは日常的な情報検索やエンターテインメントとして利用することが多い傾向があります。このような異なる用途によって評価が分かれる要因となり得ます。

文化や背景の違い:異なる文化や背景を持つユーザは、AIの回答や生成内容に対して異なる感じ方や評価をする可能性があります。

期待値の違い:一部のユーザは過去の技術的な進展を知っているため、現在のAIの能力に驚きや満足を感じるかもしれません。一方、AIに対する知識がないユーザは、高い期待値を持って接するため、その期待に応えられなかった場合には否定的な評価を下すこともあり得ます。

情報源の違い:ユーザが日常的に接している情報源やニュース、記事などの内容によって、生成AIに対する評価や認識が変わることもあります。例えば、某有名テックブロガーが否定的な記事を書いた場合、そのブロガーのフォロワーはその意見に影響されることも多いです。

利用環境の違い:使用しているデバイス、インターネットの速度、利用しているプラットフォームやサービスのバージョン等、技術的な環境が異なると、AIのパフォーマンス評価に影響が出ることがあります。

評価基準の多様性:NLPの性能評価の基準は多岐にわたります。ところが、一般ユーザの多くは評価基準や評価手法について知らないことが多く、客観的な評価にはなっていないことが多いです。

これらの要因が複合的に生成AIの性能評価結果に影響を与えていると思われます。

ちなみに、AIの研究開発者が使用している評価手法の代表的なものには、精度 (Accuracy)、適合率 (Precision)、再現率 (Recall)、F1スコア、AUC-ROC、損失関数 (Loss Function)、BLEUスコア、ROUGEスコア、Perplexity、エンティティの認識率などがあります。然しながら、これらの評価手法を用いても、前述の質問内容や期待する解答の条件などによって、生成AIの性能評価の結果は大きく変わることがあります。

以下のChatGPTに関する論文では、(1) 数学の問題、(2) センシティブな質問に対する解答方法や内容、(3) 意見調査、(4) 複数の情報源による判断が必要な知識集約的な質問、(5) コードの生成、(6) 米国医師資格試験の解答率、(7) 視覚的推論などによって、明らかに精度が落ちていると書かれています。

前述の『(1) 数学の問題』や『(5) コードの生成』、『(6) 米国医師資格試験の解答率』などの問題は、明確な正誤の判断が可能です。然しながら、その他の問題の中でも特に『(2) センシティブな質問』には、政治的見解、宗教観、様々な差別問題、人権問題、犯罪を助長する可能性のある質問などが含まれます。そのため、NLPへの質問に対する『回答の正しさ』は、研究者だけでなく、国や地域、文化的・宗教的な価値観、更には個人の考え方や、研究者や開発者の持つ視点や前提にも影響を受けることが考えられます。

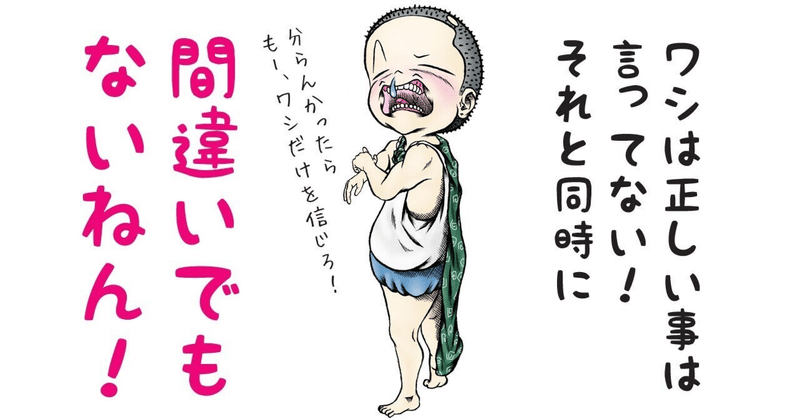

生成AIの製造者やサービス提供者は、AIが間違った情報を提供しないように、トレーニング手法の改良、アルゴリズムなどの技術的な改良、回答のフィルタリング、ファクトチェックなどに力を入れています。しかし、人間が正しい答えを定義できない問題に対して、AIが正しい回答をしているかどうかを人間が確認することは論理的にあり得ない話です。それにも関わらず、生成AIの評価方法自体には非常に大きな改良の余地があるのが現状です。

生成AIが学習するほど性能が落ちる原因に関しては、以下の記事に書いてある『過学習』、『データセットの制約』、『ディメンションの呪い』、『バイアス(情報の偏り)』、『知識の伝搬エラー』などが古くから知られていますが、筆者の感覚では、ChatGPT-4の性能は、この数か月間で著しく低下していると思います。

この記事が気に入ったらサポートをしてみませんか?