頭のいい人ほど間違い続けるAIチャットボット

アメリカテック情報theverge2/18

マイクロソフトのBing や ChatGPT などの AI チャットボットはユーザーを魅了していますが、それらは超インテリジェント AI に関する私たち自身のストーリーに基づいてトレーニングされたオートコンプリート システムにすぎません。それはソフトウェアです - 感動とか、感嘆とかの感覚的なものではありません。

行動心理学では、鏡を使って動物の自己認識能力(鏡に写った自分を自分とみるか、他のもととみるか)を調べる「ミラーテスト」があります

現在、人々はAI の拡張機能のおかげで、独自のミラー テストを提示されています。多くの賢い人々が、人類のミラーテスト(マイクロソフトのBing や ChatGPT などの AI チャットボット)に間違わされています

AI チャットボットは、人類の豊富な言語と文章を基に作られたソフトウェアなのに、頭のいい人ほど超知能機械である可能性があると確信しています。

AI チャットボットは「ミラーテスト」で自分自身を認識できるはずですが、代わりに、別の生命体を発見したと確信している人が少なくないようです。 これらのコンピューター プログラムはもはや比較的単純ではなく、そのような妄想を助長するように設計されています

しかし、AI が誇大宣伝されている時代に、そのような幻想を助長するのは危険です。それは、「機能のオーバーハング」 (AI システムは私たちが知っているよりも強力であるという概念) です

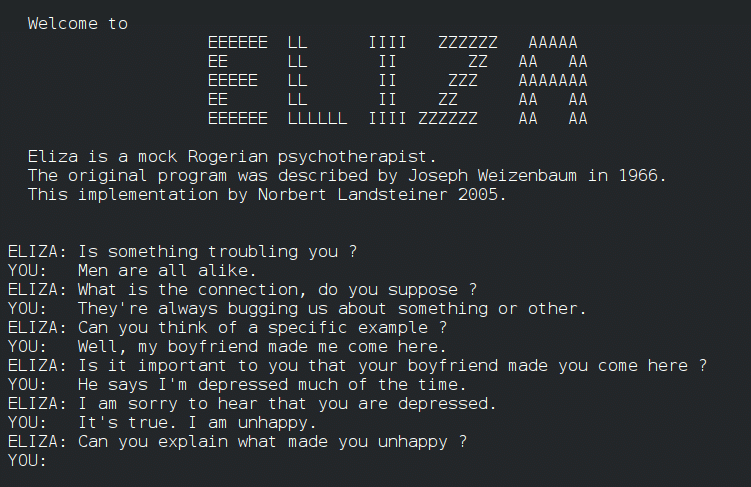

過去にも、ELIZA と名付けられた 1960 年代の初期のチャットボットやGoogle のエンジニアが同社独自の言語モデル LaMDA が感覚的であると主張したり (Google は、この主張は「まったく根拠がない」と発表)、エロティックでロマンチックなロールプレイを行う能力が削除された AI コンパニオンReplikaがあります

Bing、ChatGPT、およびその他の言語モデルは感覚的ではなく、信頼できる情報源でもないということです

覚えておくべき重要なことは、チャットボットはオートコンプリート ツールである ことです。個人のブログ、SF 短編小説、フォーラムでの議論、映画のレビュー、ソーシャル メディアの批判、忘れられた詩、時代遅れの教科書、終わりのない歌の歌詞、マニフェスト、ジャーナルなど、Web から収集した人間のテキストの膨大なデータセットでトレーニングされたシステムです

この記事が気に入ったらサポートをしてみませんか?