生成AI/LLMから事業価値を創出するための条件とは

Weights & Biases Japan(W&B Japan)では、エヌビディア合同会社と共催で招待制のエグゼクティブラウンドテーブルイベントを9月末に開催しました。このラウンドテーブルでは、生成AI・LLM開発を開始した、または開発を検討中の企業のエグゼクティブの皆様をご招待し、企業が質の高い生成AIモデルを自社開発することからどのように独自の製品・サービスの開発に繋げ、競合優位性を確立できるのか、その最前線から学び、ディスカッションの中から新たな方向性を見出すことを目的にしました。

本イベントではWeights & Biases COOのYan-David Erlich、東京大学の松尾豊先生、アクセンチュアの保科学世さんに、それぞれの目線から生成AIの自社開発および活用の現状と意義についてお話しいただきました。

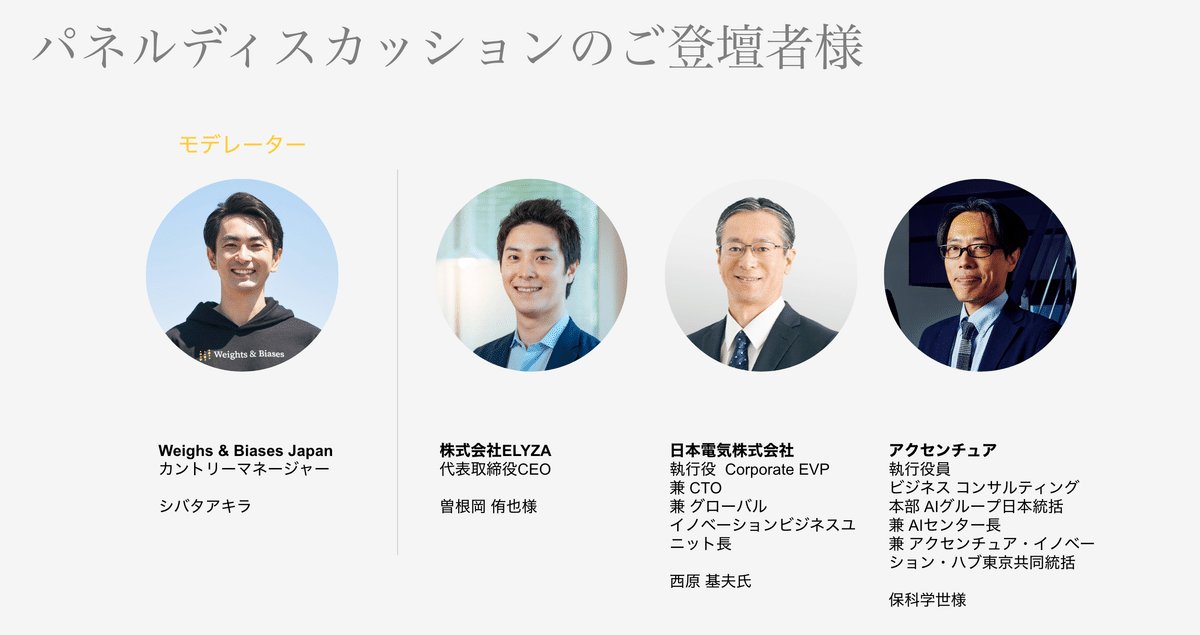

その後、本イベントの最後のアジェンダとして開催したラウンドテーブルでは、W&B Japanカントリーマネージャーのシバタアキラがモデレートし、ELYZA株式会社(以下ELYZA)から曽根岡 侑也氏、日本電気株式会社(以下NEC)の西原 基夫氏、そしてアクセンチュアの保科学世氏にご参加いただきました。

NECは7月に、また、ELYZAは8月末に自社で学習させたLLMモデルを発表されており、ELYZAではそのモデルの一般公開も行っていらっしゃいます。またアクセンチュアではLLMモデルを使って様々な業界における応用に取り組んでいらっしゃるということで、そのような先駆的な活動を通じて見えてきた生成AI開発における技術的なチャレンジやビジネス化における戦略などについてお話を伺いました。

LLMモデルを発表した時の反応は?

シバタ:まだモデルのリリースから長く経っていないですが、自社開発のLLMモデルをリリースして、どのような反響がありましたか?

曽根岡氏:弊社ではMeta社から公開されたLlama2モデルをベースに独自モデルの開発を進めました。Llama2モデルは日本語で話しかけても英語で返してきてしまうため、弊社での開発においてはLlama2モデルを継続事前学習し、日本語化することに重点を置きました。反響は非常に大きく、発表してすぐに高速化など弊社のモデルをベースにして開発をされる方が現れたり、学術論文向けの研究の中で使おうとしてくださったりと、非常に大きな反響が3週間の間にも起こっています。また私たちはモデルと一緒に評価データ「ELYZA tasks 100」を発表しました。私たちの課題意識としていい評価データを使うことがいいモデルを作ることに非常に重要で、LLMモデルの評価を行うためのデータの整備に関する課題感から、今回このようなデータも公開させていただきました。

西原氏:NECでは3月からLLMモデルの開発を行っています。私たちのスタンスとしては、NECのモデルもご利用いただけますが、Microsoft Azureとも提携し、弊社のデータセンターを経由してOpenAIのモデルもご利用いただけるようサービス展開をしていて、適材適所でモデルを選んでいただける環境を提供しています。7月に弊社独自のモデルを発表したところ、500社以上のお問い合わせをすでにいただいており、すでに10社以上とLLMを活用したシステムの開発に関して議論を深めており、非常にマーケットの感度が高いと感じています。

シバタ:ELYZAではモデルの一般公開をされていますが、その意図はどこにあったのでしょうか?

曽根岡氏:OpenAIが一強になっている中で、私たちは知見を供給することで社会貢献したいという意識を持っています。その基本的な方針としては、出すことでデメリットのないものは基本出そう、というスタンスです。モデルや評価データなど、ほとんどのものは公開したのですが、出せなかったものとしてはファインチューニングのデータセットがあります。ここは弊社のデータファクトリーチームが長い期間をかけて取り組んできたものであり、これに関しては今回公開はしませんでした。

各社のビジネス戦略とは

シバタ:LLMを作るというのは非常に大きなプロジェクトですが、それを元にどのようなビジネス展開を考えてきたのか、また今新たな可能性として見えてきていることはありますか?

西原氏:私たちの場合は学習データを大量に増やし、特に日本語データの拡充を行いました。結果として13Bという比較的小型のモデルを構築し、様々なベンチマークを見ても良い結果が出ています。小型のモデルというのは、普通のサーバーでもGPUが1枚入っていれば動くくらいの規模感で、このようなモデルであればセキュリティーの厳しい環境でもオンプレサーバーで動作させることができるため、普及の観点から重要と考えています。

小型なのでレスポンスも早く、ファインチューニングにかかる時間も早いというメリットもあります。

シバタ:ELYZAはNECと異なる戦略を立てているのではと想像しますが、いかがですか?

曽根岡氏:事前学習モデルがこれだけある中で、スクラッチでモデルを作ることにこだわらず、既存のファウンデーションモデルをどうやって追加学習し、「独自化」していくのかというところを戦略のコアに据えています。

シバタ:保科さんは先ほど、モデルを使って色々なアプリケーションがあるというお話をしていらっしゃいましたが、モデルを開発する会社のビジネスモデルで注目しているビジネスモデルはありますか?

保科氏:どこまでLLMに手を入れるべきなのかを考える上で、私たちはそれぞれの業界や企業の行先を考えた上で判断する必要があると考えています。それぞれの業界毎に多数のユースケースを我々も作成していますが、どこまで独自のLLMが必要なのかに違いがあり、そこを考慮した上でお客様に提案していくことが重要なタイミングだと捉えています。私としてはユーザーの感度が高い日本においては、LLM単体に加え、アプリケーション層も合わせてサービス提供することで、LLMにも磨きをかけられればと考えています。

シバタ:日本独自のAI開発・提供環境ということに関してはどうお考えですか?

保科氏:アクセンチュアのグローバル・リサーチの結果を見ても、日本の経営者のLLMへの関心は世界的にも高いと言えます。ただ、その中で、正しくその効果とリスクを理解できている方はあまり多くないと感じます。どういう環境でどういう使い方をするかで、リスクとそのビジネス価値が大きく変わってくることを認識した上で、日本独自のAI開発・提供環境の意味を考える必要があります。独自性やセキュリティの観点が重要な分野では、日本独自の開発・提供環境というのは意味があると思います。

始めたからこそ見えてきた現時点での課題

シバタ:実際にモデルを開発し、ビジネス戦略を実現していく上で課題に感じていることを共有してもらえますか?

曽根岡氏:すでに色々なところで言われていることですが、GPUが足りません。この会場にいる皆さんでGPUを取り合っているような構図。その状況の中で、V100くらいのマシンを並列計算することでなんとかしようとしている。

皆さんにお伝えしたいこととしては、我々の先日リリースしたモデルで行ったことですが、正しい評価軸、いわばコンパスを持ち、その評価軸に基づいて高速で開発していくことが重要だということです。このようなプロジェクトの進め方をしていく上では、Weights & Biasesは非常に強力です。

西原氏:おっしゃる通りGPUが足りない、これは世界的な問題かもしれませんが。あとは、弊社も900機程度のA100搭載マシンがあるが、LLMでフル活用しようと思うと並列計算が難しく、特殊なミドルウェアを開発する必要もあり、現場は苦労していました。

もう一つ付け加えたいのは、NECもプラットフォーマーという立ち位置ではなく、バーティカルな社会価値を各お客さんごとに提供する企業だということです。私たちが本当に興味があるのは、LLMを使ってお客さんにどのような価値を提供できるのか。これはNEC一社でできることではなく、エコシステムが必要です。例えば私たちのモデルをスタートアップの皆さんに使ってもらい、フィードバックをもらいながら協業するなどの活動を通じて、バーティカルな価値の創出を推進したい。

LLM技術はまだわからないことが多く、伸び代も大きく、チャット以外にも色々な用途が考えられます。現時点ではそのパイを一緒に大きくしていくタイミングです。

参加者からの質問

シバタ:特別な機会ですので、ぜひ参加者の方からもご質問があればいただきたいと思いますが、いかがでしょうか?

株式会社メルカリ 石川佑樹様:現状のモデルであっても、精度やROIの観点からワークする領域で見えている部分があれば教えていただけますか?

曽根岡氏:私たちが理解しているのは、コストパフォーマンスを追い求めると、独自LLMいう選択肢は捨てられないということです。具体的には最近某社のコンタクトセンターで電話の対話を要約するユースケースに取り組みました。仮のシミュレーションですが、500席のコンタクトセンターでこれを1年間運用すると、GPT-4だと1億円程度、GPT-3.5だと300〜500万円程度かかります。一方で、私たちが特定の用途のためにファインチューニングすると、精度としてはGPT-3.5と4の間くらいの精度を達成でき、コストも低くなる可能性があります。

タスク特化のモデルを数10億パラメーターのモデルで作ることは投資対効果で割に合うという肌感覚を持つに至りました。まずはGPT-4でプロトタイプを検証したあとに、独自のタスク特化モデルを作るという開発ワークフローが現実的だと考えています。

西原氏:私自身が現場から少し離れたところにいることを前置きさせていただきますが、弊社のモデルを公開してからご一緒させていただいているお客様の傾向を考えると、金融、保険、ヘルスケアの分野でのニーズが高いと感じています。

株式会社メルカリ 石川佑樹様:弊社でもいくつかのドメインに取り組んでいますが、その中でも独自モデルが必要になると感じていることとしてサービスの多言語対応があります。メルカリのサービスの特徴として、固有名詞が多く、例えばポケモンの「リザードン」のキャラクター名を現地で使われている呼び方で適切に翻訳するには課題があったのですが、LLMでは非常に高精度に対応が可能です。ただ、色々な翻訳を試してみると、GPT-4などの汎用モデルは高機能すぎることが多く、特有のチューニングが必要だと感じています。

Spiral.AI株式会社 佐々木雄一様:学習も大変ですが、推論も重要です。これから推論のための計算環境はどのように変わるでしょうか?

曽根岡様:推論のホスティング環境を用意することの重要性は私たちも感じている。実際にやってみると70億パラメーターは簡単に走らせることができますが、130億パラメーターに変わってくると高速化なしに走らせるには苦労が大きい、700億パラメーターのモデルなどはまだ現実的に実用化することには難がある。

NEC 小山田昌史様:個人的に推論は非常に大事だと思っています。最近だとLlama.cppが出てきてCPUでもLLMを走らせることができるようになってきたり、モバイルデバイスのチップで動かすための工夫や、トランスフォーマーに特化したチップの開発も進んでいる。いずれ一人一台LLMという時代も来ると考えており、推論コストを下げることはますます重要になってきます。弊社ではパラメーターを小さくすること以外の省力化に取り組んでおり、量子化以外にもトランスフォーマーの最適化によって、スループットを上げ、レイテンシーを下げることができると思っています。個人的には日本からも推論用のチップが開発されるようになることを期待している。

シバタ:本日はパネラーの皆様、ご参加の皆様に感謝申し上げます。ありがとうございます。

この記事が気に入ったらサポートをしてみませんか?