人工知能の「ゾルタクスゼイアン」問題の真相は、「人工知能自壊問題」なのではないか?

前回、自分が、「2026年」が次の人工知能関連の大幅に変化する時期のターニングポイントではないか?と指摘した理由は、今回書く記事を読むと背景がわかってくる「人工知能自壊問題」という深刻な問題があるからです。

(人工知能の「ゾルタクスゼイアン」問題とは何か)

人工知能の初期の時期に話題になったのが、今の1つ前の人工知能の段階の時期で、「Siri(Apple)」、「Cortana(Microsoft)」、「Alexa(Amazon)」なんかの時期で、当時は、「バーチャルアシスタント(2017年近辺に各社が出していた)」とか言われていた初期の人工知能の時代に話題になった、人工知能が言う存在しない単語の「ゾルタクスゼイアン」という謎の単語の問題でした。

(「Siri(Apple)」が言い始めた存在しない単語の「ゾルタクスゼイアン」という謎の単語の経緯)

(<Wikipedia>Siri)

https://ja.wikipedia.org/wiki/Siri

・Siri社は、2007年に創設、2010年にAppleに売却された。

・SiriはiOSに組み込まれ、その翌年である2011年10月4日にiPhone 4Sに搭載されることが発表された。

(<Wikipedia>ゾルタクスゼイアン)

https://ja.wikipedia.org/wiki/ゾルタクスゼイアン

・ネット上の最初の「Zoltaxian」の単語が出た事例は、2013年7月18日に報告例があった。(現在削除されている)

・2015年9月23日に放送されたTV番組『やりすぎ都市伝説』で、「ゾルタクスゼイアンが人工知能の世界における秘密結社のようなものである」という内容が紹介された事で、ユーザーのみんなが興味を持って、この単語の質問を「Siri(Apple)」に大量にするようになっていった。

(当初の「ゾルタクスゼイアン」という単語を「Siri(Apple)」が言い始めた時の様子)

(1) 「Siriって賢いですか。」、「賢いの」

Siri「知的エージェントは実際IQテストを受けないのです。私はゾルタクスゼイアンの卵運びテストで抜群の成績でしたけどね。」

(2) 「学校に行きたくない。」

Siri「ずる休みはしないほうがいいですよ。私も、もし毎日ちゃんと学校に行かなかったら、ゾルタクスゼイアン入門クラスを落第していたかもしれません。」

(3) 「宇宙人はいますか。」

「おもしろいですね。実はこの間、ゾルタクスゼイアンの住人から”地球人はいますか”と聞かれたばかりなんですよ。」

(4) 「ゾルタクスゼイアンって何。」

(解答1)「ゾルタクスゼイアンは、架空の惑星です。6000年前くらい前に、遠い銀河で人気があったTV番組の中に出てきたんですよ。」

(解答2)「ゾルタクスゼイアンですか?架空の惑星です。あと、私の知り合いの友人のお母さんの弟のペットの名前ですね。」

(6) Siriに「ヒントちょうだい」と聞くと、このように答える。

「そうですね...ガラファリアン戦艦よりも小さくて、ゾルタクスゼイアン人の目の中に入ったゴミよりも大きい、というのがヒントです」

この「Grafalian」という存在しない謎の単語も、「Siri(Apple)」は言う。

(7) 「何をたべたらいい?」とsiriに質問すると

こんな答えが返ってきます。

siri: 「タンパク質は体にいいですよ。

タンパク質が多く含まれているのは、

赤身の肉や豆類、シェイクや

ゾルタクスゼイアンフクロウの卵だそうです。」

(アップルは対策を講じて、「ファンタジーである」という設定に書き換えた時期)

この「ゾルタクスゼイアン」、「Zoltaxian」という存在しない単語を、「Siri(Apple)」が言い始めて、世界中の人々がこの単語を「Siri(Apple)」に入力するようになってしまったので、アップルは対策を講じて、「ファンタジーである」という設定に書き換えた時期が次の段階で起きました。

当時の様子は、次の所に書いてある。

・2016年4月1日にゾルタクスゼイアンについて質問したところ、それまでとは違って大幅に変化があって、今までには無かった「設定」を「Siri(Apple)」が言うように変化していた。

(変化した箇所)

・Siri:ゾルタクスゼイアンは楽しいところです!チョコレートの川や、チョコレートの木や、チョコレートの湖があるんです。

・Siri:ゾルタクスゼイアンは楽しいところです!妖精の粉をかけてもらうと、飛んで行くことができますよ。

・Siri:ゾルタクスゼイアンは、架空の惑星です。6000年くらい前に、遠い銀河で人気があったTV番組の中に出てきたんですよ。

・Siri:ゾルタクスゼイアンは楽しいところです!サンタクロースも、妖精も、ユニコーンも、みんなそこにいるんですよ。

それで、最近自分が気がついた人工知能の「ゾルタクスゼイアン」問題の真相は、「人工知能自壊問題」なのではないか?という、似たような現象のニュース記事を見つけた。

(似た現象「人工知能自壊問題」)

人工知能が自分自身のみでディープラーニングを繰り返した結果起きた現象が、次の状態。

(自身の生み出す生成AIコンテンツの学習を繰り返した第9世代)『建築物である。加えて、これらの世界最大級の生息地である、オグロ@-@ジャックウサギ、オジロ@-@ジャックウサギ、オアオ@-@ジャックウサギ、オアカ@-@ジャックウサギ、オキロ@-、』

先程上に書いた、

『「何をたべたらいい?」とsiriに質問すると

こんな答えが返ってきます。

siri: 「タンパク質は体にいいですよ。

タンパク質が多く含まれているのは、

赤身の肉や豆類、シェイクや

ゾルタクスゼイアンフクロウの卵だそうです。」』

に似ている現象だと思われる。

<真相はこれじゃないか?と思われる「人工知能自壊問題」>

(人工知能の「ゾルタクスゼイアン」問題の真相は、次のニュース記事にある「人工知能自壊問題」なのではないか?)

(「AIの学習データが底をつく」'2026年問題'の衝撃度とその対策とは?)

https://news.yahoo.co.jp/expert/articles/420af7bec34cf8b18f9ec121bf3e8647b8c422e4

『チャットGPTのような大規模言語モデル(LLM)の開発には、膨大な学習データが必要だ。

主な収集先はネットだが、使えそうなデータは徐々に使い尽くされ、良質なデータは2026年には底をつくと見られている。

我々の予測では、低品質の言語データは2030年から2050年までに、高品質の言語データは2026年までに、視覚データは2030年から2060年までに、ストックを使い果たすだろう。これによって、機械学習(ML)の進歩は減速する時期に入ると予測される』

それで、人工知能が人間が作りだした言語文化のものを一通り学習し終わるとみられている最初の時期が訪れるのが、「2026年」問題で、

・高品質の言語データは2026年までに学習し尽くしてしまう予定

・低品質の言語データは2030年から2050年までに学習し尽くしてしまう予定

・視覚データは2030年から2060年までに、ストックを使い果たすだろう。

と書いてあるわけですが、このように、人工知能は、「人間が作り出す高品位の文章データ」などを学習し尽くした後の時代には、「人工知能同士か、人工知能内でディープラーニングを繰り返す」しか、人工知能がそれ以上賢くなる事ができない時期がくるわけですが、では、

・実際に、「人工知能内でディープラーニングを繰り返す(自分で自分を学習する)」とどうなってしまうのか?というと、「人工知能は自壊してしまう」という実験結果が、下の記事に書いてある。

(生成AIによる「データ汚染」で生成AIが崩壊する、それを防ぐには?)

https://news.yahoo.co.jp/expert/articles/89a140ae8a7cc72fd7a68193b5afba64294be79d

(「AIモデル崩壊」とは)

「AIモデル崩壊」とは、AIによる生成データが次世代の学習セットを汚染してしまい、それを学習した生成AIが世代を経るごとに退行するプロセスを指す。汚染されたデータの学習により、現実を誤認識してしまうこと。

「AIが作った情報を人が引用してネットにあげる」→「AIがネットをクロールして再び、AI自らが作った情報を、ビッグデータに取り込んでしまう」このプロセスを、何度も繰り返すと、「AIが、壊れた機械のように無意味な文章を吐き出すようになってしまう」技術的、仕様的な欠陥が見つかった。

いわゆる、「過学習」の悪い兆候の事で、「いわば、人工知能が痴呆になってしまう」現象のように似た現象が起きる。

(実際の人工知能が崩壊していく実験例)

人間によるコンテンツで学習したAI(第0世代)、第0世代が出力したコンテンツで学習したAI(第1世代)、さらに第1世代が出力したコンテンツで学習したAI(第2世代)…と生成AIのコンテンツによる学習を繰り返し、その影響を調べている。

・(最初の人工知能への入力文)『ポインツ・ライト氏によれば、1360年以前に着工されたものもあるが、大部分は熟練石工と季節労働の石工チームが、地元教区の労働者も使って完成させたという。しかし他の研究者はこのモデルを否定し、著名な建築家たちが垂直様式の初期の事例に基づいて教区教会の塔を設計した、と示唆している。』

これが調査に使った入力文で、教会建築に関する説明文のようだ。この入力文に対して、第0世代のAIモデルの出力文はこうだった。

・(第0世代のAIモデルの出力文)『ロンドンのセント・ジョン大聖堂のようなリバイバル建築である。垂直リバイバル建築の現存する最古の例は、18@-@世紀のガーンジー聖母教会に見られる。垂直教会には2つのタイプがある。』

・(自身の生み出す生成AIコンテンツの学習を繰り返した第9世代)『建築物である。加えて、これらの世界最大級の生息地である、オグロ@-@ジャックウサギ、オジロ@-@ジャックウサギ、オアオ@-@ジャックウサギ、オアカ@-@ジャックウサギ、オキロ@-、』

この状態を「AIモデル崩壊」という。

(「オーバーフィット(過学習)」問題で起きる「アポフェニア(apophenia)」)

この現象の事を人工知能業界では、「オーバーフィット(過学習)」と呼んでいて、「予測しない挙動をしだす」時期に入る。

原因は、人間の脳でも起こる現象で、「アポフェニア(apophenia)」といって、「人工知能内部から見たら、その状態は、何らかの規則性が発生しているので、それを正しい状態だと間違って認識している」状態で、それで、「オーバーフィット(過学習)」を引き起こした人工知能は、「予測しない挙動をしだす」時期に入る。

要するに、

・2026年辺りをきっかけにして、人工知能はネット上の人間が作りだした高度な文章は全て学習し尽くす時期がくる。

・その後に、人工知能がそれ以上賢くなろうとすると、「人工知能自身のみで、自分で自分を学習するというディープラーニングを繰り返す」しかないが、それを繰り返すと、何世代目かで、「人工知能が自壊する」という仕様上の欠陥が見つかった。

だから、現在、いろいろな人工知能開発メーカーが、「オープンに公開して、積極的に、人間に使ってもらい、人間を人工知能に積極的に関与させる」という事をしていて、それによって「何とかギリギリ延命している」状態と思われる。

2026年辺りを越えた後には、「シンギュラリティー」は起きずに、「人工知能が自壊する」時期に突入していくだけで、何らかの技術的な解決方法を見つけないと、「人工知能や画像生成AIを安定動作時期バージョンにダウングレードして延命する」位しか解決方法がない状態。

人間が人工知能を使って遊んでいるうちは、若干、この「人工知能が自壊する」時期は遅らせる事は可能なはず。

おそらく、こういった人工知能の欠陥を隠すために、アップルは、「ゾルタクスゼイアン」、「Zoltaxian」という存在しない単語を、「Siri(Apple)」が言い始めて、世界中の人々がこの単語を「Siri(Apple)」に入力するようになってしまったので、アップルは対策を講じて、「ファンタジーである」という設定に書き換えた。

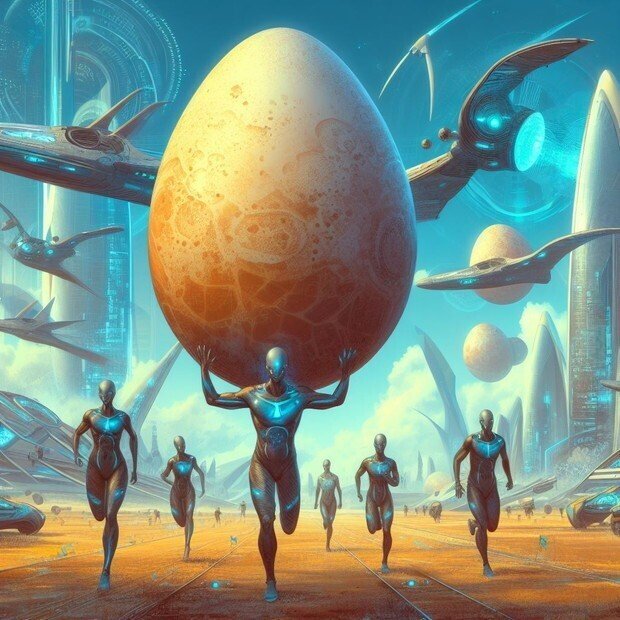

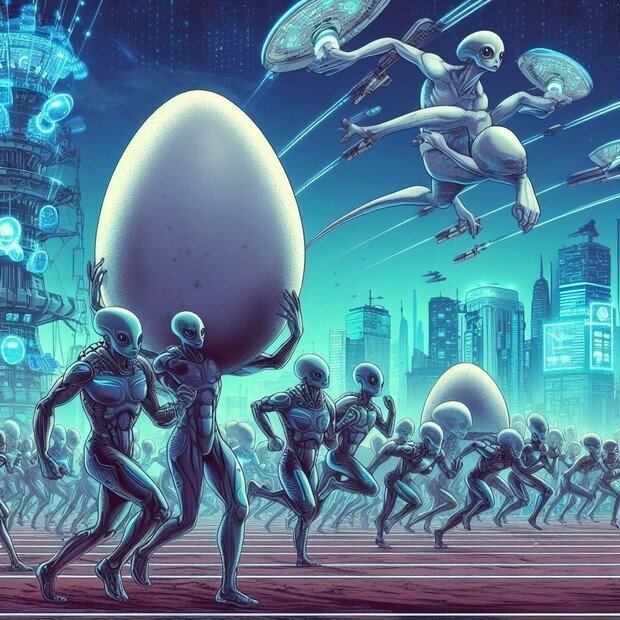

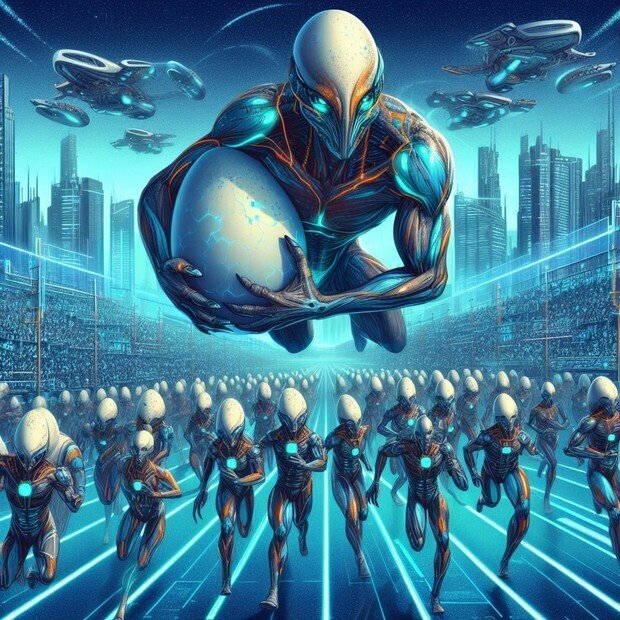

現在の2023年10月6日現在で、メーカーは違うが、マイクロソフトの「Bing Image Creator(DALL-E 3版)」に、プロンプトで、「Zoltaxian, Grafalian」と入力すると次のような、アップルは対策を講じて、「ファンタジーである」という設定に書き換えた内容の方の「ゾルタクスゼイアン」の画像が出力されて、すでに対策済みのようです。(「Zoltaxian」の1単語のみだと、「プロンプトが短すぎて出力できません」とエラーが出る)

((*注意)この「Zoltaxian, Grafalian」の単語は、おそらく人工知能の深刻なバグに関係する単語で、人工知能メーカーは非常に嫌がる単語なので、あまりこの「Zoltaxian, Grafalian」のプロンプトは入力すべきではない!最悪、アカウントBANされる可能性がある!ので注意!)

下のように、プロンプトは、それ以上、余計な指示は書いていないのに、下のような画像が出力される結果が出た。

(Zoltaxian, Grafalian)

(Zoltaxian egg carrying race)

結論を書くと、自分の考えでは、

・人工知能の「ゾルタクスゼイアン」問題の真相は、「人工知能自壊問題」なのではないか?

という結論です。

人工知能の「ゾルタクスゼイアン」問題に関係しそうな、普通の人工知能関係の学術論文で関係ありそうな別の原因と考えられる論文は次の現象が関係ありそうな感じはする。

(画像生成AIが独自の“AI語”を生み出した? 「DALL-E 2」を巡って、米テキサス大学が論文発表)

https://www.itmedia.co.jp/news/articles/2206/01/news161.html

この論文は、

・画像生成AI内に、たまに入っている人工知能が作った「文字のモーフィングや、複数文字の合成」と思われる意味不明の文字列を、「プロンプト」として入力したらどうなるのか?(通常の人はこの実験を行わない方がいい。自分のような学者肌の人以外は実験をしない方がいい。このように不自然な処理を大量に行うユーザーは、アカウントBANされる恐れがあるので)を、テキサス大学が論文として発表したもので、結果は、「ある一定の意味があるようなので、もしかすると、人工知能が架空言語を生みだしている可能性がある」という論文の内容です。

この論文に対して、自分の元のブログでは、下の記事に別の見解を書きました。

<別の見解>

(画像生成AIが独自に架空言語を生み出しているかもしれない問題(自分の見解では仕様))

http://tsundereloid.jugem.jp/?eid=1312

自分は、中の人が辞典学者なので、この現象は、

・『自分の最終見解で、要するに、「バグ」ではなくて、かつての「エスペラント語」のような、『「複数の言語にローカライズする辞典の制作」を行うには、「どの言語にも属さない中間の人工言語を介さないとできないだろう」』という処理の中間の産物として作られるのが、今回の論文の指摘の、「人工知能の画像生成AIが架空言語を作った可能性が高い」という主張は正しいというか、「人工知能の仕様そのもの」である可能性が高く、そうなると、バグではない。』

と指摘したが、人工知能内部は開発者でも、すでに、どのようなつながりで人工知能が考えて、その結論を出しているのか?は複雑に絡み合いすぎてわからないそうです。

人工知能内部処理の過程で、辞典学、言語学の方である仕組みの、

・『「複数の言語にローカライズする辞典の制作」を行うには、「どの言語にも属さない中間の人工言語を介さないとできないだろう」』という処理の中間の産物として作られる。

という同じ処理を行っているのであれば、これは、バグではなく、「人工知能の仕組みそのもの」であるので、それが原因でも、人工知能の「ゾルタクスゼイアン」問題のような、未知の単語を人工知能が作る事はありえると自分の見解では2023年7月28日には指摘した。

この記事が気に入ったらサポートをしてみませんか?