ChatGPTをはじめとしたAIサービスのセキュリティ課題と対策

追記:2024/03/08

OpenAIは正式に多段階認証を導入しました!

設定→一般→多段階認証で設定出来ます。

表示されるQRコードは、「Google Authenticator」や「Microsoft Authenticator」等で使用可能です。

もともとMicrosoftアカウントで多段階認証を導入している際には、ログイン時に2度、認証を要求されることになります。

🌟この多段階認証はあくまで、不正アクセスを低減する効果があるものです。

例えば、紐付けた端末を第三者に奪われたり、Google Authenticatorであればアカウント同期の機能によって、これが意図せず漏れる可能性もあります。

また、バックアップキーも含めて全てを紛失した場合、完全にログインできなくなる可能性もあることを意識した方が良いでしょう。

それでも、メリットははるかに上回る認識です。ぜひぜひ設定しましょう!

AI技術が日々進化する中、ChatGPTをはじめとするAIサービスのセキュリティリスクへの注目が高まっています。

本記事では、ChatGPTのセキュリティ面を詳しく見てみるとともに、さらに他の同様サービスとの簡単な比較や、実際のインシデントも確認し、リスク管理の重要性と具体的な対策方法を考えてみます。

AI技術の利用が進む現代において、このようなセキュリティ意識の向上は不可欠です。

もともと、以下の記事を今日読みまして少し疑問に思ったので、その疑問を個人的に解消する目的も兼ねます。

ChatGPTを使用するためにOpenAIのアカウントを作るべきでは無いのか

結論から言えばその通りです。ただし、一部誤解があります。

確かに現時点でOpenAIのアカウントには、第三者による成りすましログインを防ぐ対策は不十分です。

具体的に、「ChatGPT無料版(Free)」、「Plus」には2FA(二要素認証)の設定はありません。

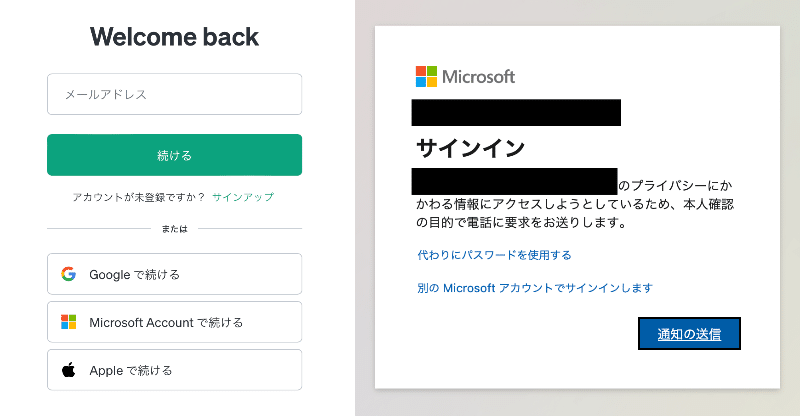

しかし、Microsoftアカウントを使用したログインであればこの限りではありません。予め設定をしておくことで、Microsoftアカウントでログイン時に以下のような認証が求められます。これは無料のユーザーも同様です。

これにより、第三者が勝手にログインすることは基本防げます。

大事なのは予めMicrosoftアカウントの設定でこれを有効にすることです。

自分は確かに上記の懸念から、OpenAIで作成できるアカウントではなく、Microsoftのアカウント経由で主にChatGPTを使用しています。

さらにセキュリティを高めよう!

学習に使用させないために

ChatGPTは無料版(Free)およびPlusにおいては、学習のために中の人がそのログを見ることがあります。また、それらの情報はChatGPTの血肉となり、モデルの形成に役立てられます。

これらを許可したくない場合、以下主に3つの選択肢があります。

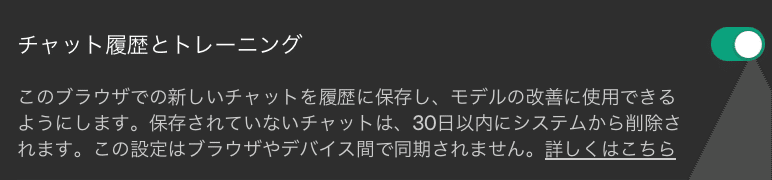

チャット履歴とトレーニングをオフにする

これが一番手頃です。設定から、チャット履歴とトレーニングの設定をオフにします。すると、学習に使用されることは無くなります。

ただし、注意が必要で具体的な基準は公開されていませんが、おそらく「フラグ(適切では無い可能性があります、的な赤いメッセージが付加される場合)」が立った場合にのみ、中身は確認されるようです。

ただし、これをオフにすると会話履歴は保存されなくなるので、恐ろしく不便になります。そもそもとして、不適切な使い方をすれば人間のレビュアーによって確認され、最悪アカウントbanされるので、オフにしなくても良いかなとは思います。

機密性が高い情報はそもそも連携すべきではないですし、後述するプランを変更したり、APIを活用すれば大丈夫です。

プランを変更しよう

ChatGPTには様々プランが用意されており、個人の利用を目的とした「無料プラン(Free)」、「Plus」がおなじみですが、ほか企業向けに「Team」や「Enterprise」があります。

この企業向けのプランであれば入力内容は学習に使用されないため、多少は安心ですね。

ただし、こちらも不正な利用を取り締まるため、OpenAIのサーバに最大30日間保存されます。後述しますが、個人的にこれが気になりますね。どれくらいの人が、どの権限で、どこまで確認できるのでしょうか。公開されている資料だけだと分かりません。

また、どうしても値段が高くなるのと、個人では契約出来ないため、そこは注意が必要です。

APIを使おう

OpenAIには、外部でサービスを提供する人向けのAPIが公開されています。

使えば使った分請求される、従量課金のシステムですが、こちらも入力内容は機械学習に使用されないため、独自のクライアントを作成してAPI経由でChatGPTを使用する、といった使い方も検討できるかもしれません。

あまり使わない場合、また、GPT3.5程度で良い場合、コストは結構抑えられるかもしれません。ただ、そこまでするなら「Enterprise」を契約してしまった方が楽かもしれませんね。

保存されている情報は本当に大丈夫なのか

情報流出は、どれほど信用できる機関が認証を出していたとしても、起きるときは起きます。直近起きた大規模な事件だと以下のものがありますね。

また、ChatGPTもかつて他人の履歴を見ることができる問題もありました。

ちなみにAmazonもやらかしています。

間違ってもパスワードを「passwordフォルダ」に入れないようにしましょう。

個人的にはこのタイミングでLINEのやりとり全てを、独自のAI構築のための学習に使用します!と言っても許される気がしています。(皮肉です)

なので、基本的に情報流出は起きる、と思っておいた方が良いと思っています。

そのために、流出しても良いような情報しか連携すべきではありませんし、また、提供側は保持した情報は暗号化するなど対策はすべきです。(OpenAIはやっているかな?)

また、流出させた企業にはかなり厳しめの罰則を設けるべきでしょう。おおむね企業からすれば厳しい措置ばかりだと思いますが、流出された方からすれば総じて軽いです。

場合によってはおとがめ無しです。良くないですね。

また、トレーニングされた中の人()がどこまで信用できるか問題もあります。

テスラは派手にやっています。

OpenAIは流石に大丈夫だと思います🙄

しかし、これを逆手にとって、毎朝カメラに向かって罵詈雑言を投げかけたり、そういう楽しみ方はできるかもしれませんね。ある種、面白ければ必ず見てくれるようなので、YouTuberみたいに人気の監視対象を目指すのも面白いかもしれません。目指せ令和のウィンストン・スミス!

他の類似のサービス

Gemini(Google)

GoogleのAIであるGeminiですが、はっきりと中の人が見るとプライバシーポリシーに書いてあります。ぎょっとしますが、やっていることはOpenAIと同じです。

その他サービス

例えばAIを駆使したバーチャル彼女、彼氏も同様のリスクがあります。というか、一番危険だと思います。

OpenAIが提供するAPIを介してやりとりをする場合でも、それを実装する側、具体的なサービスを提供する側はいくらでもログを取れる仕組みを埋め込むことができます。

これは、自分が実際にサービスを作ってみて特に思いました。(自分のはエラーログすらとっていないので、ChatGPTのコードレビューで怒られましたが、そのままです。)

なので、ここは特に強く意識すべきだと思います。今後様々なサービスに似たような仕組みは構築されると思いますが、本当にこれを使って良いのか、どこまで情報を提供して良いのか、というのはよくよく意識しないと、極めて危険なことになります。

まとめ

某ホームスクリーンもそうですが、個人的にはちょっと愉快なテレスクリーン程度にしか見なしていません。我々が思う以上に、身近なサービスは結構情報をぶっこ抜いています。そして漏らされています。

集めるのは良いけど、漏らすなよ!と思いますが、漏らします。そういうものです。なので、各々がどこまで情報を連携して、必要に応じて消したりできるのか、そういうことも意識して便利なサービスは使うべきです。

さて、セキュリティに対する意識を高めたり、お勉強するためにはIPAの教材が役立ちます。当たり前のことも多いですが、基本に立ち返って見直すこともまた大切です。

この記事が気に入ったらサポートをしてみませんか?