本に人生を救われた私が、本をAIに読み込ませてから出版社と実験した3か月

こんにちは、トキワです。(Twitter:etokiwa999)。

今回はこの3か月のプロトタイピングについて書こうと思いますが、まずどれだけ私が本を好きか書きます笑。

本がなければ自殺していた

以前別のnoteでも書きましたが、知能検査で昔2E(ギフテッド&学習障がい)の可能性が高かったことが分かっています。

家にはお金がなく、塾には行けず、空いてる時間はカードゲームを転売して生活していました。それが小学校高学年から中学校ぐらいまで。

加えて大人になって初めて知ったのは、住んでた地域が比較的所得の低い地域で、公立学校に通ってましたが、今思えば小学校は格差が激しく、中学校はそれなりの子どもたちが集まっていました。

そんなところにいて私はまったく同級生と話が合わず、いじめにもあい、その結果、ほぼ不登校になりました。

そこで結果的に自然と必要になったのが本でした。

学校に行くときは図書室にこもり、学校をさぼっていたときはブックオフで立ち読みしました。もちろんマンガも読みましたが、主に小説を読んでました。

自己肯定感が低く、精神的に不安定だったのですが、小説は読むことで気持ちが落ち着くので、本は精神安定剤でした。

大学のときも話の合う同級生はおらず、やっと親のネガティブ攻撃(口撃)から離れて一人暮らしができて、1日中本を読むことができるようになり、でも文字を読むのが遅いので、1日3時間の睡眠時間でやっと年間100冊読むことできました。

この時は小説ではなく政治や経済、心理や生物など広く社会全般のことを知り、なぜ自分が社会問題の当事者にいたのか少し理解し始めたところでした。

つまり私は小学校~高校ぐらいまで精神的に落ち着かせるために、大学生のときは自分のルーツを知るために、本に完全に依存していました。本がなければ自殺していたと思います。

もうここまでくると本は本ではなく、本は著者との会話ツールなのです。1文読んでは「ふむふむ、なんで?」を繰り返していくのです。だから共感するときもあるし、怒って反論するときもありました。

それだけ本に私が助けられたので、本に対する思いは並々ならず、本でちゃんとお金が稼げたり、本と会話ができるようになったりなんかしたときには、もう興奮ものです。

そこにまさにその「本と会話できるかもしれない」テクノロジーがやってくるのです。というわけで本題です笑。

ChatGPTx独自データの紹介

私自身もChatGPTに最初に触ったときは、自分の専門性がどれだけ浸食されるのか気になったので、社会問題のことをどれだけ解像度高くわかるか質問してみた結果、「これはダメだ」と思いました。

「ChatGPTは専門領域では使えない」これは今でも同じ考えですが、目的を変えれば面白そうと考え始めます。そのきっかけが以下のツイートでした。

1. Embed a book into GPT-3 / ChatGPT.

— Aaron Ng (@localghost) February 21, 2023

2. Talk directly to the book to learn.

Learn from a book through conversation, questions, and in the order you want. pic.twitter.com/ITbcu3qPwI

本のデータを読み込ませて会話するという動画です。動画なのでもちろん誇張や編集などあるとは思いますが、ここから独自データを使ったChatGPTが可能、ということが分かります。

独自データを使う方法は大きく分けて4つです。

(1)プロンプトに含ませて一緒にAIに質問する

(2)Fine Tuning(ファインチューニング)

(3)Embedding

(4)ChatGPT Plugins

概要は以下にまとまってますが、簡単に説明します。

(1)プロンプトに含ませて一緒にAIに質問する

これは何も難しくありません。例えば以下の質問文(プロンプト)をAIに投げるとします。

明日の天気は何ですか?明日の天気は雨です。

これはとても単純化した例ですが、このように質問すれば「明日は雨です」とAIから返ってきます。つまり「質問文+欲しい回答」をセットにするわけです。

ただこの問題点は質問文(プロンプト)の文字数に制限があると、本のような10万字ものデータを入れることができない、というところです。

ただこの問題点はclaudeというテクノロジーによって解決されました。Slack上で簡単に使うことができてとても便利です。

(2)Fine Tuning(ファインチューニング)

簡単にいうと重みづけです。AIはすでに色んなデータを学習していて、そこから回答していますが、その学習データを別途新しく追加することで、「比較的」新しいのデータを基に回答してくれるようになります。

例えば以下はミルクボーイのネタをファインチューニングさせた結果です。

私も拙著「悪者図鑑」をファインチューニングさせてみましたが、あまり上手く行きませんでした。本の内容とは関係ありそうでなさそうなことまで含めて回答してしまいました。

おそらくファインチューニング用に準備するデータをうまく作る必要があります。

ChatGPTに「悪者図鑑」を読み込ませた結果

— トキワエイスケ (@etokiwa999) March 5, 2023

1、ファインチューニングというオリジナルのデータを読み込ませて、ChatGPTの参照するデータセットに重みづけする方法

2、結果何回か試したけど、ちょっと微妙な感じ

(1)日本語の表現がおかしい

(2)本の範囲を抜けて答えを出す(これはこれですごいけど) pic.twitter.com/WOFnnOpEcU

(3)Embedding

これを説明するのはちょっと難しいですが、独自データを数学の「ベクトル」に変換することでAIにとって扱いやすいデータにすることができます。

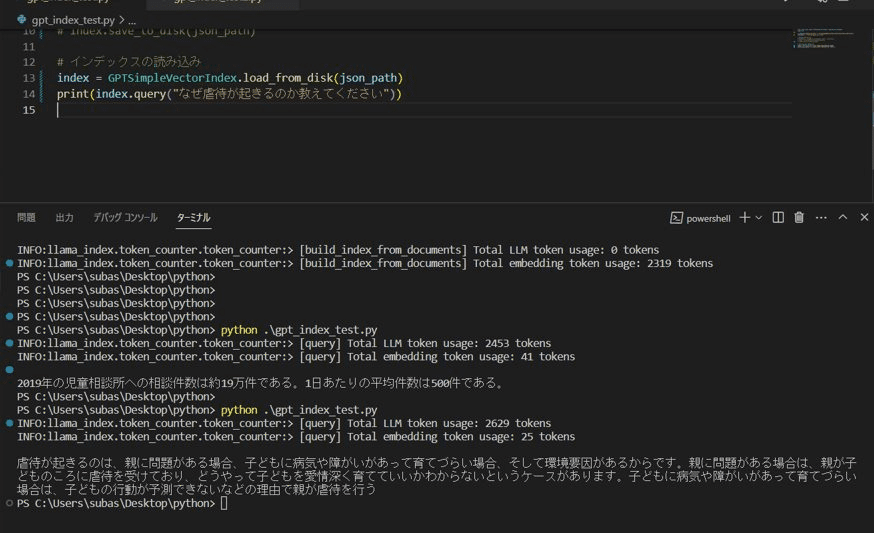

テクノロジーとしてはLangChainやLlama Indexというのを使いますが、今まで試した中ではこの方法が一番精度高く回答できました。

ちょっと初心者には分かりづらいですが、以下のオープンソースとPineconeというツールを使うことで簡単に個人でもできます。

(4)ChatGPT Plugins

これらの方法を基にいくつかのツールが生まれました。

Docsbot、Chatbase、Chat with any PDF、Kindle GPT、などですが、本家OpenAIが3月中旬にChatGPT Pluginsを発表しました。名前の通り、ChatGPTに別の機能(プラグイン)を追加することができます。

6月1日現在はChatGPT Plus(有料版)を使っているユーザーの一部の人向けに提供されています。一部のユーザーが色んなプラグインを紹介しており、以下は一例です。

この中でChatWithPDFやAskYourPDFといったプラグインを使うことで独自データを読み込ませることができるようです。まだ私自身は使ってないので精度の高さは不明です。

ーーーーーーーー

これらのテクノロジーとツールを使って、拙著「悪者図鑑」や「ミクロ経済学」の本、松岡正剛さんの「千夜千冊」のWebサイトなどから欲しい回答を得られることができました。ここでだいたい4月頭ぐらい。

出版社との有料実証実験のプロセス

ここから色々紹介いただいて3社の出版社とミーティング&ヒアリングしました。

1社は拙著「悪者図鑑」を出版した自由国民社様、2社目は某有名科学雑誌、3社目は弊社エンジェル投資家・山本真司さんからの紹介でした。

山本さんからご紹介いただいた出版社様にご準備いただき、ゴールデンウイーク中に書籍データをいただき、5月中はずっと実験をしていました。

出版社のニーズとしては2つあります。(1)書籍の売上貢献のためのプロモーション、(2)書籍という商品開発の工数削減です。

今回の実験では1番に焦点をあて、本の要約をし、その要約をWeb記事として10記事ほど作成しました。

上記であげたツールだけではなく、各ツールやAPIを組み合わせてエンジニアと一緒に開発・改造したりもしました。

工夫した点はたくさんありますが、特に面白かったのが3点あります。

(1)2000字~3000字の文章を作る

残念ながらChatGPT関連の技術(LLM)は英語向けに作られていて、日本語の場合は1回で回答できる文字数(≒トークン)が少なくなってしまいます。

例えば以下はその計算の例です。このため1回で2000字~3000字のデータを取得するのは困難です。

そこで工夫した点としては、1回書籍データから目次を作り、その目次ごとに文章を作成し、1記事全体で2000~3000字を超えるようにしました。

さらっと書いてますが、ここにも色んな工夫があります。

(2)いかに人間らしく書くか

ChatGPTが文章を書くとどうしても硬い表現になってしまったり、AI文章判定で「AIが書いた」とすぐばれて、SEOのために使うWeb記事としては使いづらくなります。(ちなみにAI文章判定については以下を参照してください)

この工夫はいくつかあります。例えば、文末をだ・である調(常体)にする、経験や具体例を入れる、著者の自己紹介を入れたりして著者目線が見えるようにする、などです。

これらの工夫をすることでAI文章判定からも「(AIかどうか)unclear(分からない)」という判定をたたき出せました。

(3)本の内容を使って本の中にない時事ネタを解説させる

これもなかなかに面白いチャレンジでした。

今回の書籍データはビジネス書だったので、「女性管理職へのアドバイス」や「企業と若手のミスマッチの予防法」などをテーマにして、記事を書きました。

これをやった時に編集者はまだ仕事として残るなと確信しました。ここの工夫点としては、まずそもそも「女性管理職の問題とは何か」解像度を上げることと、それに対する解決策は本のどこにあたるのか明確にすることです。

ここで実際に作成した記事を紹介することはできませんが、同じ方法で作ったのが以下の記事です。拙著「悪者図鑑」を基に作成しました。

ーーーーー

他にも多くの工夫を行い、多くの学びを得た実証実験でした。毎回のAIへの質問文(プロンプト)の文字数は400字にもなり、1記事作成するための試行回数は50回にもなり、本当に色んな試行錯誤を行いました。

プロンプトの例は以下です。ただ作る文章によって改良する必要はあります。

記事の最終章の文章を作成してね。文字数は1000字ね。主語は「私」ね。文体(文末)は、だ・である調(常体)でお願い。日本語でお願い。タイトルは「~~~~~~~~~~すること」で、内容はAAAAAA、BBBBBBB、CCCCCCCC、DDDDDDDだ。この記事は1章目の「~~~~~~~~~」と、2章目の「ーーーーーーーーーーーーーーー」の次に書かれて、記事の最後の文章という位置づけになるから、文章の始まりは「最後に伝えたいことは」で始めてほしい。具体的な事例や経験を引用してほしい。連載のテーマは「================」だ。

ビジネスとして今後のさらなる展開はありうるか

正直まだ分かりません笑。実験を行った出版社様から追加の依頼がくるか、他の出版社から問い合わせが来るか。

ただ例えば自費出版や紙雑誌などは、SEO関係なかったりするので、最低限読みやすくするだけなら、さらなる可能性があるでしょう。

出版社からすると例えばライターの人材不足であったり、ライターの費用(1.5万円で3000字)と工数(3-4日待つ)がかかったりします。また自費出版なんかはライターと編集者が何十回とインタビューをしても、ほぼ毎回同じ内容の答えが返ってきたりもします。

また実験してて思ったのは、色んな工夫やツールの使い分けをしたので、別途新しいITツールを作ったほうがより効率的に自動化できるとも感じました。

本は好きですが、一度学校相手にビジネスが上手くいかなかった反省もあり、出版業界が新しいものにお金を払って乗ってくるかも謎です。

ただそもそもなぜ今回出版にビジネスとして着目したかというと、既存の生成AIツールはすべてネット上のデータを扱っているためで、出版データはネット上に存在しません。さらに著作権でも守られています。

以下がそれを分かりやすくしたマトリクスになりますが、Web2.0のプレイヤーたちがこれからどんどん自社サービスかもしくはChatGPT Pluginsに連携するでしょう。食べログは予想通りやってきましたし、法律や医療といった客観データはとても相性がいいです。

文章作成の短期的な流れと未来のSF展開

今後は文章は「辞書型」にしたほうが良いと思っています。例えば、

意見A

理由

事例1

事例2

キーワードA

理由

のような構造です。このような構造のほうが無駄な情報が入らずAIにとっても扱いやすくなる気がします。しかもここから「誰向けにどんなテイストで」文章を書くかは簡単に調節できます。

まるでこれは「秘伝のタレ」です。そのタレにどんなアレンジを加えてどんなお客さんに提供するか、すべて自由です。

そこからさらなる展開としては、社会で起きた現象に対して、自動的に応答し、TwitterやYoutube、LINE公式、メルマガなどのコンテンツを自動作成して配信、というバーチャルインフルエンサーが作れるようになります。

ChatGPTだけでもバーチャルインフルエンサーは作れるのですが、意見が平均的で、表現もつまらないため、情報が「つる」っとしたものになってしまい、あまり面白くありません。

人間のインフルエンサーは何か尖った意見を持っていたり、面白い造語などの表現を持っているからいいわけです。だから人間のインフルエンサーの情報を「秘伝のタレ」として辞書型で保存しておくのがいいのです。

今後、おそらくゲームの世界がより柔軟になっていき、「リセットできる人生」そのものになる可能性が高いですが、そこにもバーチャルインフルエンサーを登場させることができます。

学校がつまらなくてゲームに引きこもっているギフテッド(アドバンスラーナー)の子どもに何でも知ってるAI博士と出会えたらたくさん質問して知的好奇心を満たすこともできます!なので科学雑誌のデータとかかなり熱いわけです笑。

むずかしい表現だって芸人風とか「小学生向け」とかで分かりやすく伝えることも可能です。

またかなり安くバーチャルインフルエンサーを提供できるとなると、日本人のインフルエンサーをインドの貧困層に提供する、なんてこともできます。翻訳→発音もそこまで難しくありません。

人間のインフルエンサーはひたすら辞書を作り、バーチャルインフルエンサーはひたすら色んな場所で活動する、そんな世界は遠くないでしょう。

ただそこに行くにはどこからビジネス展開していくか、というステップが必要です。今回は出版社を入口にしてみましたが、グロービスなど専門的な情報を持っている会社は全員有利です。

そしてさらに面白いのはデータさえあれば故人の召喚が可能かもしれない、ということです。少し前にAIの美空ひばりが話題になりました。もちろんその精度をさらに改善することもできますが、過去の文豪や経営者を召喚することも可能かもしれません。

私自身、過去の著者を召喚できれば友達がもっとできて幸せになれると確信しています笑。

この記事が参加している募集

この記事が気に入ったらサポートをしてみませんか?