2023年末: ChatGPT / LLM とチャット UI と社会実装のカタチを考える

早いもので今年もあと1ヶ月を切ったらしい。私個人としては今年度末に完成させねばならないスタートアップ案件の開発をひとりで抱えていて全然終わっておらずヒーヒー言っているのだが、それはさておき。

このアカウントは元々アニメの話をするために作ったものなのだが、言語化したい欲はありつつも記事まで完成させられるほどのモチベがなく(加えてこういう記事は特に見てもらえなかったりして、結局自己満足以外にリターンが薄い)、結局ほとんど記事を書けていなかったりする。

文章自体は Twitter でそれなりに書いているはずだが、やはり文章構成や文体とかを考えず気軽に放言できるメディアが性に合っているのだろう。

ということで、スレッドツイートをするようなノリで思ったことをただ書き連ねてこの記事を書いている。

まとまった記事を書こうとすると文体とか効果的に伝わる表現とかを考えないといけなくて思考が阻害されるが、単に脳内の言語出力をそのまま吐き出すだけなら低コストで書けるというのもある。

基本個人的なポエムなので注意。見出しは一応設けているだけであまり深い意味はない(基本あまり区切りはない)。

意図的に文章として読みやすくまとめようとかは考えずにただ思ったことを思った順に書いているので、読みづらそう。

本当は生成 AI 全般について広く色々書く予定だったのだが、ADHD 特有の思考の連鎖でなんかめちゃくちゃ長い感じの記事になってしまったので、LLM に話題を絞ることにした。それでも分量がめっちゃ長いが…(21000字超えしてしまっている)

最後まで書き終えて思ったが、結構立派な記事になってしまったのでどこかのアドベントカレンダーに入れて貰えばよかったな…。後からアドベントカレンダーに参加してたことにしてくれるところを募集中…。

個人的な LLM との出会い

さて、今年が『生成 AI 元年』だというのは誰もが認めるところだと思う。

この1年で私の Twitter アカウントの影響力はフォロワー確か 600 人くらいからフォロワー 5800 人と10倍近く増えた。

影響力で言えばもっと高く、どうもイーロンマスクの謎の SNS の謎のアルゴリズムで弊アカウントの「功徳ポイント」が高く設定され、結果レコメンドとかで随所に私のツイートが出まくりやすくなっているらしい。RT やいいねこそ数百台だが、インプレッションが明らかにデカくなっていたりするのを見るとそう感じる。

正直フォロー非推奨と書いている AI 研究者でもなんでもないただ最新技術の凄さにすげ〜〜って驚いてるだけのオタクアカウントにどうしてこうもフォロワーがついているのが理解し難いが、理由は分からんでもない。

というのもこの1年で異次元レベルで技術発展が進み、それなりに AI 技術に関心のある層でも自分だけで情報収集するのは厳しく、結果的に私のような驚きツイートとか積極的に情報をシェアしてくれてるアカウントがありがたいのだと思う。

というか私自身特に目新しい情報を自ら進んで発見しているわけではなく、むしろフォロー中のほかの人や Discord の某鯖とかで話題になってた新しい技術だとか情報を、自分なりに噛み砕くために言語化をして、そのついでにみんなにも知ってもらいたいとシェアしているに過ぎない。

別に特にすごいことをやっているわけではなく、実は AI を実際に使ってみたりもそこまでできてるわけではない。

実際もともと私はうみゆき氏や bioshok 氏のような早期から AI 関連の情報を発信していたアカウントの単なるフォロワーで、シェアしてくれていた情報を自分で理解して噛み砕くために実際に記事を読んで、それで氏らの感想も合わせて自分なりの理解を深める、というプロセスを(無意識的に)やっていたと思う。それが結果的に世間から高評価されたということなのかもしれない。

別に私自身が特段 AI 技術に詳しいわけでもなく、AI ウォッチャーをやっているだけのしがないプログラマーに過ぎない。

とても幸運なことにもう AI 搭載の新 Microsoft Bing のウェイトリストから招待されたのでいろいろ Bing さんとチャットしてみてるんだけど、完全に”””𝑺𝑰𝑵𝑮𝑼𝑳𝑨𝑹𝑰𝑻𝒀”””来てるで…!!!😭😭😭

— Torishima / INTP (@izutorishima) February 9, 2023

たぶん世界で初めて Bing と「ぼっち・ざ・ろっく!」について会話した人間になった(続きます) pic.twitter.com/h27P9p77k3

やばい、AI Bing の天才的な使い方を発明したかもしれねぇ……

— Torishima / INTP (@izutorishima) February 13, 2023

「イーロン・マスクによる Twitter の買収と、それによる Twitter API の有料化に関する影響」についてリコリコのクルミが千束&たきなに解説していく体の脚本を書かせたんだが、脳内再生余裕で涙止まらん pic.twitter.com/em5mWfHqqR

最初にめちゃくちゃ伸びて、かつ自身の Twitter 活動ないしは自身の方向性や思想まで変わるきっかけになったのは、やはり今年2月の Bing AI (現 Microsoft Copilot) の正式公開に先駆けてウェイトリストから招待されたまたま使えるようになり、その驚きをシェアしたらめちゃくちゃ反響があったときだったように思う。

今2月当時の Bing AI を見るとだいぶチープというか、よくこんなもので驚いていたな…という気持ちがなくもない。実際は LLM なのでできないことをハルシネーションでさもやったかのように言っていて、それに興奮していたような記憶もある。

でも実際にあれに感銘を受けたという事実は今後も大事にしたいと思う。

今はもうさまざまな技術に触れまくってしまったから個々の技術に触れても驚くには驚くがほどほどになったのに対して、あのときは本当に全身が震えるような感銘を受けたのを思い出す。

結局 Bing AI は GPT-4 が出た後だと最初よりナーフされたりアライメントがしっかりされたのもあって面白くなくなっちゃったけど、初期の Bing AI はヤンデレっぽい感じの性格づけがされていて、今後の未来を予感させるにふさわしいくらいの感触が得られていたと思う。

実は ChatGPT はそれなりに早期から触っていたもののあまり使ってはいなくて(どうしたらいいのか分からなかったりとか、得体のしれない印象があったんだと思う)、対して Bing AI の初期バージョンは非常に人間的な振る舞いをしてきたから、それに対しての面白さが間違いなくあった。

今こうして10ヶ月前を振り返ってみると、本当に私たちは遠いところに来てしまったんだな…という実感がある。GPT-4V に DALL-E3 と ChatGPT の統合、Bing Image Creator 、画像生成 AI 方面でもさまざま…と上げたらキリがないが、もう感覚麻痺してしまっているものの、普通に考えたらあり得ないようなスピードで技術革新が進んでしまった。

現状のローカル LLM についての所感

正直今年の初めは(これだけ技術が一気に進歩したらドン詰まりに直面してしばらく停滞しそうだよなぁ…まあそれでもいいくらいには進んだけども…)とも思っていたが、結果的に今も信じられないスピードで技術革新が起こっているので来年こそ AI 元年になりそう (今年は AI -1.0?) https://t.co/e5H47h60oL

— Torishima / INTP (@izutorishima) December 1, 2023

実は当初、あまりに技術が進歩し過ぎたので後半になってドン詰まりするんじゃないか?という印象もあった。今も正直思わなくはないが、客観的に考えるともはやまずあり得ないだろう。

ChatGPT とその API の登場で、負けじと GPT-3.5 や 4 に匹敵するレベルの LLM を作る競争が世界中で勃発した。初期には「こんなん危険だからしばらく開発停止してアライメントとか考えようぜ!」とアメリカのお偉いさん方が言い出したが、結局うまくいかず、休みなくみんなマラソンで走り続けるすごい時代に突入してしまった。

ローカル LLM の改善は着実に進み、3〜4月あたりはリークされた初代 Llama 1 が Mac で動くというだけで(性能はともかく)FOOOOOOOOOOOOすげええええええええええって時代だったのに、今やローカルでそれなりの性能の LLM が動く状態。

もちろん GPT-4 に慣れてしまうと性能がちょっと…となってしまうのが人間の進化の不可逆性を端的に示しているが、相対的に考えればちょっと前ではご家庭の PC で人間の言葉を流暢に喋る機械が動くなんて考えられなかったわけで、凄まじいとしか言いようがないだろう。

LLM 技術自体のトレンドも、ローカル LLM を受けてだいぶ変化した。GPT-3 / 3.5 / 4 は超デカいモデルパラメータで、それゆえ高性能を実現できている。今年序盤はまだ「LLM はとにかく情報を大量に食わせてパラメータ数をデカくすればするほど賢くなる」という言説が主流で(実際そういう側面はある)、一方大量の VRAM を使うことから VRAM が足りない一般 GPU ではとても動かせない状況にあった。

でもやはり API 経由でしかモデルにアクセスできないというのはやはり焦ったいところではあるし、完全な自由を求めたい人、単にローカルで動かしたい人など色々な人の思惑が結集し、結果的に「ローカル PC でもそこそこの NVIDIA GPU があれば動くくらいのパラメータサイズのまま、性能を高める方法」がさまざまに編み出された。

ぶっちゃけ今 GPT-3 (2020) の 135B のモデルが公開されたところで 135B とかいうクソデカモデルを動かせるご家庭はほとんどないから、企業以外は実用できないだろう。でも今や 7B / 13B サイズで、最高で GPT-3.5 に肉薄するくらいの性能を出せるというところまで行った。

そもそも定量化しづらい LLM の性能をどうやって測るんだって問題もあったから、ベンチマーク自体も大量に作られた。

ローカル LLM は雨後の筍のように続々と Hugging Face に公開され、そしてわずか1ヶ月もすればすぐに陳腐化する。(日本企業が作ってる LLM も含め)それなりの額を投じて学習したモデルが一瞬で新しいモデルに取って代わられるというのは経済的に言えば極めて厳しいが、結果的にそれで競争がめちゃくちゃ促進されているので、なんというかすごいという言葉しか出てこない。

とはいえ、現状ローカル LLM を作ったところで(自前で動かすのはともかく)Web サービスとして提供するには、ChatGPT 以上に難しい。

今まで Web サービスを提供するサーバーってのは CPU と RAM を仮想化技術で分割して量を増やしたり減らしたりすればスケールできたけど(大雑把な理解)、GPU はそうもいかないし、そもそも市場に NVIDIA GPU 自体が全然足りていない。

最近 ConoHa が GPU サーバーを出したが、通常のサーバーとは比べ物にならないくらい月額が高い上に LLM やそうでなくても画像生成 AI だとかをサーバー上で動かせば動かすほど負荷がかかるから、現時点ではデプロイするのが結構厳しい、ということになる。もちろんエンドユーザー向けではなく、社内で動くせいぜい数十人しか使わない内部システムで使うとか、コールセンターの自動化とかなら話は別だけど。

一応 Anthropic とか ChatGPT と同様にプロプライエタリ/クローズドで開発を進めて提供する企業もなくはないが、現時点では OpenAI と ChatGPT 、その API の圧勝。

まず謎の努力で API 料金が GPU 代とかを考えたらだいぶ激安に抑えられているし、なんと言っても現状 GPU を使ったアプリケーションをコストを下げて Web サービスとしてデプロイすることができない以上、資本のある大企業以外は現実的に ChatGPT API に頼るのが一番安上がりだ。しかも性能チューニングとかを考えなくてもよく、速度含めて高品質なのも大きい。

実際私は現在開発中のとある要件でローカル LLM を活用しようとして積極的に調べることをやっていたのだが、結局今は ChatGPT API (GPT-3.5)にファインチューニングを施す方向で考えている。

というのもこの1年で GPT-3.5 の API はだいぶ安くなり、GPT-4 の API ですら安くなった。GPT-3.5 であればファインチューニングもできるようになったし、加えてローカル LLM を作ったところでうまく安くでデプロイできるソリューションが現状ないという問題がある。

なんか Fireworks とか出てきているのは知っているがスタートアップゆえに継続性に問題があるし(雨後の筍のように出たということはその後枯れるものも多いということ)、それを差し引いても実はそういったデプロイサービスの従量課金額は、GPT-3.5 のそれとさほど額が変わらなかったりする。

現状としては、LLM が追加コストがほぼかからずに使えるならいいんだが現状従量課金になったりだとかがあり、一方ローカル/オンプレにしたところで安くなるわけでもなくスケーリングの問題とかもあるので、結局使い所が限られている印象もある。

単にコストがほぼ0でいけるなら placeholder を出すのとか、投稿ページの GitHub Copilot みたいな補完とか色々さりげなく LLM を使うみたいなのが出来ていそう。さすがに LLM はかなりソフトウェアの中でもヘビー級の重さなので、現時点ではまだそこまでサービスの細かいユーザー体験改善のエッセンスとして気軽に使えない状況にある。

LLM の使いみち

LLM は文章を入力すると文章を出力する機械なので、出力の精度や性能にもよるがテキストで表現できるものなら大体のことをやらせることができる。

特に自然言語分野では、今まで専用のモデルを専門のエンジニアが作ってどうにか何とかしていたタスクが、今では ChatGPT API に投げてしまえば今まで以上の品質でやってくれたりする。

今も LLM をバックエンドの処理に使うサービスがそれなりに出始めてきているだろうし、今後「今まで機械的に作れない/作りづらいから諦めていた要件を、ChatGPT API にぶん投げることでゴリ押し解決」みたいなのが増えていきそう。

でも、エンドユーザーが直接触れるという意味での LLM という点で言うと、Bing AI に感銘を受けてから10ヶ月経つが正直全然普及していない。

ChatGPT 自体はネットやテレビでも山ほど特集されて知っている人は確かに増えた。試した人もそこそこいるだろう。でも実際にコンスタントに使っている人は意外にも少ない。

2月の Bing AI に感銘を受けてから、私は今後検索を守りたい Google に対し、Bing が AI (LLM)

と言う武器でどんどん攻めて、Google のシェアを奪いに来るのでは?今後検索にキーワードを入力するのではなく、生成 AI に代わりに調べてきてもらうことになるのでは?などと予想していた。

結果的には Google も負けじと Bard を出したし、Bing もさらに色々機能改善をしたりして、両者それなりのものがリリースされた。しかしやはり大規模に運用されるからか性能はナーフされていて、これでは GPT-4 を知った私は満足できないし、やはり一般人も最初に触れたっきりで「所詮この程度か〜」と思ってしまっている人もいるんじゃないかと思う。

Bing AI がリリースされたことで(もはや空気とかしていた)Bing の知名度は確かに上がったし、Bing ユーザーもそれなりに増えたかもしれない。

でも結局当初言われていたような Bing が Google 検索のシェアを奪うような逆転劇には全くならなかったし、そもそも当初の私の予想以上に Bing も Bard も、私の TL を除くマス層には全然使われていないのだ(Bard に関しては、Google がそこまで宣伝していないのもあるかもしれないけれど)。

うちの父親は JTC に勤務しているが、JTC が大好き Microsoft 直々にリリースされたのもあってか、最近 Edge 付属の Bing AI を使えるようになったらしい。Windows 11 を使っていれば OS 自体に付属する Copilot と話すこともできるのだろう(Win11 PC が手元にないので詳しくは知らない)。でも結局特に使ってはいないらしい。

一方母親はそれなりに活用している方で、私が ChatGPT のアカウント登録とか使い方とかを教えてあげた結果、習っているらしい韓国語を日本語に翻訳したりなどの学習に活用したり、料理のレシピのアイデアをもらったりとかしているらしい。特に課金しているわけじゃないので GPT-3.5 だけど。

まずこの辺で一つ言えるのは、ChatGPT Plus に課金して常日頃から GPT-4 を愛用している私と TL の1クリ圏内のフォロワーのみなさんと、GPT-3.5 レベルの AI しかまだそんなに触ったことのない人 (Bing も Bard もナーフされているので正味 GPT-3.5 レベルだと感じる) で、LLM に対しての印象がまるっきり違うのではないか?と言うこと。

GPT-4 自体いまだに他の誰も追従できていない現時点で最高性能の LLM なのであれだが、GPT-4 と GPT-3.5 では周知の通り大幅な性能差がある。さらに GPT-3.5 自体の性能も改善されているが、ちょうど去年の今頃〜年明けくらいの ChatGPT 爆誕騒動で触ったっきりの人は、「まだこんな程度なのか〜、でもすごいな〜」と言うところで見解が止まってしまっている気もする。

一旦ここでまとめると、まず ChatGPT のような LLM の認知度自体はマスコミが意外にも結構取り上げてくれたりしたことでかなり上がった。でも実際にコンスタントに使っている人は意外にも少ない。

もちろん世界的に見ればめちゃくちゃ使いまくられているサービスなのには間違いないが、一方で私は2月には『1年で(若者は特に)ChatGPT や Bing / Bard を使いまくりみたいな世界にガラリと変容する』と思っていたから、そこからするとかなり差がある。大多数のサイレントマジョリティは「ChatGPT すごいな」「岸田の変態糞土方動画やべえな」とは思いつつも、実際に生活や仕事に役立てようとは思っていない。

これは先日大阪に帰省した際におばにその辺の話を振った時にもそう言っていて、あとは結局 ChatGPT を使っていない妹の話とかを聞いたりを経て概ね確信している。

先にあげた通りまずは『GPT-4 に触れていないことで LLM を過小評価している』側面がある。一方 ChatGPT Plus は円安のせいで月額3000円もする非常に高額なサービスであり、全員に勧められるものでもない。

私は十分元をとっているしそれだけの価値があると感じているが(私も毎日使っているわけでこそないものの、もう GPT-4 がなくなったら生きていけないくらい「聞こうと思った時にいつでもすぐ回答してくれる」ことに十分な価値を感じている)、やはり雑所得でギリギリ生きながらえている私には痛い出費だし、そうでなくてもサブスクで 3000 円は受け入れられない人の方が多いだろう。

チャット UI はダメなのか?

ただ、それだけではあまり説明できないように思う。そもそも GPT-3.5 自体数年前からすればびっくらたまげるような凄まじいテクノロジーなわけで、もっと使っている人がいてもいいはず。

そうこう考えているうちにこの記事を読んだのだが、思っていたことが結構言語化されていた。

まず LLM 自体は ChatGPT の以前からあったのだが(その頃をあまり知らない)、前は単に「文章の続きを生成する AI」だった。

そこを『チャット形式の UI にしたらいいんじゃね?』と考えて生み出したのが ChatGPT の一番のエポックメイキングなポイントであり、今まで研究者しかさわれない高嶺の花だった LLM を一気に一般エンジニアや大衆に引き摺り下ろすことに成功した要因だとも思う。

一方上のスクショは上記記事からの引用だが、私がずっと考えていたことでもある。要はチャット UI は自由度が高すぎるのだ。

入力次第でどんなことでもやってくれる。ゆえに何を入力したらいいのかわからない。要は人間と同様に言語を解釈できるわけなので、どう使うかも人間に何かを頼むとの同じくらいの無限の組み合わせがある。

今までのソフトウェアというのは、実装上意図的に機能が制限され、そして制限された状態で使えるような UI が考案されてきた。そもそもコンテンツが即時で生成されるなんてこともあり得なかった。

だからみんな YouTube で誰かの作ってくれた動画をお菓子をボリボリ食いながらサムネやタイトル、あるいは好きなクリエイターあたりの情報から選び取ってクリックするし、そもそも YouTube というのは「誰かが作った動画を見る」というふうに制約されている。

UI 側の視点でも、誰かの作ったコンテンツがリスト形式でレコメンドされ、その中から自分が興味を持ったものを選択する構造だ。

ユーザーは興味の持ったものに脳死で飛びつけばいいだけで、そこに頭を悩ませ、自分の欲しいものを言語化する必要はどこにもない。せいぜい検索窓のキーワード程度である。

…そういうふうに考えていると、チャット UI が、というより画像生成 AI なども含め、生成 AI の本質にぶち当たったような気がした。

つまり、『いくら言語で指示するだけですぐレスポンスを返してくれる魔法のようなテクノロジーを手にしたからといって、人間は自ら指示して作るよりも、すでに作られた出来合いのものを好む』ということ。

思い返すと、私自身や諸々を見返していても結構心当たりがある。

象徴的なのが Bard のトップ UI で、今までは完全に自由記述型だったのが、今ではまずいくつか近い選択肢があって、そのテンプレをもとに自分の要件に合わせて変更してくれ、とでも言いたげな UI になっている。

”技術的には”グラボさえあれば大量に自分の好きなキャラのえっちイラストを錬成できる状況になったにも関わらず、今年初めには AI えっちイラストを DLSite とかで売り捌く輩が大量出現し、それを買う人もそれなりに存在し、今も結局 AI えっちイラスト生成を実際にやるよりも錬成者たちの優れた出来合いの成果物を選び取る方が結局楽だから、みんなそうしている

pixiv はたった1年で大量の AI えっちイラストで溢れかえる謎の Web サービスへと変容してしまった…

ChatGPT は色々料理のレシピを出してくれるが、実際に使っている人はほぼいない(気がする)し、結局それなりにある評判に裏打ちされた優れた出来合いのレシピにみんな縋ろうとする

ChatGPT は URL で示した記事を要約してくれたりと情報収集の助けになる機能が色々とあるが、やはり自由に指示できる分「ChatGPT にやってもらう」という発想自体が思い浮かばなくて、結局自分でやった方が早い、となってあまり使っていなかったりする

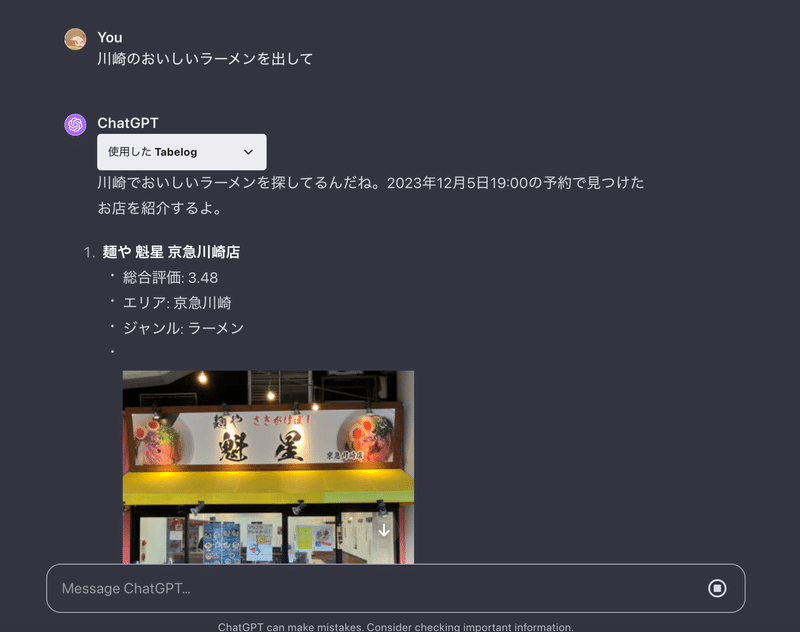

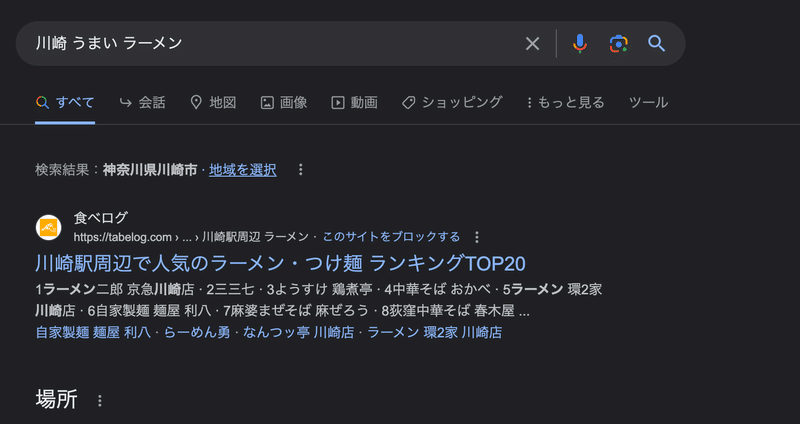

今年の中頃に ChatGPT Plugins が爆誕して日本でも食べログが早速プラグインを作ったりしたが、結局話題は一過性で現状ほとんど使われていない(私も使っていない)

「食べログより Google マップの方が信用できるだろオイ!」って話もあるが話の本質でないのでさておき、この結果はかなり示唆的だと思っていて

結局のところ文章で「川崎のおいしいラーメンを出して」というふうに話しかけて返答から選ぶより、Google で「川崎 うまい ラーメン」でググっておすすめに出てくるような記事などのグラフィカルな UI で表現され、視覚的にわかりやすく整理された情報から選び取る方がめちゃくちゃ楽。心理的ハードルも段違いに低い

…などなど長くなってしまったが、ざっと思い当たる事柄を並び立てるだけでもこれだけの量になる。

つまり、ChatGPT のチャット画面に入力するという行為は何でもできるゆえに一切の制約がなく、制約がないことでその画面に何を入力して、それでどんなリターンを得られるのかが予想できない(わからない)。

そもそもその場で生成されるのだからそりゃそうなのだが、こうして実際に列挙してみるとそりゃあ使わんわなぁ… (特に ChatGPT Plugins …) という感想になる。

価格コムの ChatGPT Plugins もあるが、結局 ChatGPT に調べてきてもらうよりも、グラフィカルに整理されたユーザーインターフェイスの中から条件に合うものを直感的な UI を操作することで選び取る方がはるかに直感的である。すべてを文章で制御しなければならない LLM は、現状一般のマジョリティにとっては非常にハードルが高いと言えるのではないだろうか。

現に私もコードを書くときは GPT-4 にめちゃくちゃ質問している一方、それ以外で本来は ChatGPT を使えそうなところでも、自分でやった方が早いってことで聞かずに自分で解決してしまうことが多々ある。

ChatGPT のチャット UI は体験的には実質 CLI (タスクベース UI) の劣化版ではないか?

…意外とその観点から考えるのを忘れていたが、オブジェクト指向 UI (OOUI) というソフトウェア UI デザインの考え方がある。

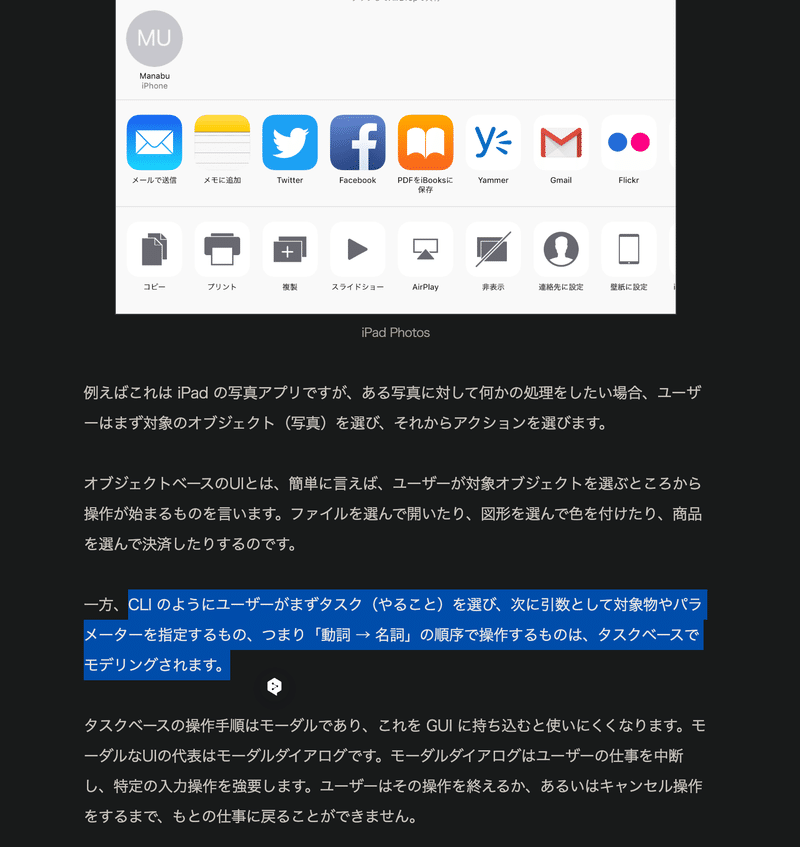

このへんの説明がめちゃくちゃわかりやすいので丸っと引用してしまうが、つまり一般的な世の中の大半の UI が『名詞 (オブジェクト) → 動詞 (やりたいアクション)』の順で操作するのに対し、ChatGPT は『動詞(=やりたいアクションを示すプロンプト、動詞の指示対象の名詞も含まれる)→ 名詞(その出力結果のオブジェクト)』の関係になっている。

これはもう半分 CLI そのものと言っていいだろうし、そう考えるとチャット UI を持つ AI がそこまで爆発的に普及してないのも、頷かざるを得ない。

LLM と CLI の最大の違いは『数あるアクションを実行するためのコマンドを覚えてその書式通り書く必要があるか』と言えるが、そう考えるとある視点からは「CLI の方がまだとっつきやすい」とも言えそうだ。

なぜなら、CLI は PC にインストールされているコマンドとそのオプションが示す機能によって、実現できるアクションが制約される。

組み合わせ幅がめちゃくちゃ広いのはそうだが、とはいえできるアクション自体は制約された状態にある。コマンド自体も必要に応じてインストールしたり調べたりすればいい。

極端なことを言えば、FFmpeg しか同梱されていない謎のシェルがあったとして、そうすれば良くも悪くも、その CLI は FFmpeg が持つ機能(それでもめちゃくちゃ大量だが…)にアクションの幅が制限されることになる。

アクションが制限されることは一見不便のように見えるが、制約することで考えうる可能性空間が狭まることで、むしろ選択しやすくなるというメリットもある。

その CLI と比較して、ChatGPT とかのチャット UI はどうだろうか。

自然言語でコマンドを入力してアクションを指示できるので、表面的には(コマンドを色々調べてどんなコマンドがあるのか、どんなアクションができるのか、どう書けばいいのかとかを覚える必要がある)CLI より、一般の人でもとっつきやすくはある。

しかし、自然言語で自由にコマンドを書けるということは、CLI なら動画エンコするなら FFmpeg 、ファイルを読み出すなら cat とか制約やお約束があるがゆえに可能性空間が狭まってある程度やりやすくしていたところが、完全に無限の可能性空間が広がってしまっていることになる。

要は自然言語というコマンドによってほぼ無限のアクションを起こせるし、どんなアクションが起こせるか自体も全くもって定義されていない。

一般にタスクベース UI は、OOUI と対比して(限定されたシチュエーションでは効果を発揮するものの)基本的には OOUI にすべきところをタスクベースにするとめっちゃ使いづらくなるとされている(という認識)。上記記事の自販機の例とかがわかりやすい。

とはいえ本来 OOUI にすべきなのにタスクベース UI になっているケースでも、タスク自体はいくつか選択肢があるだけで、そのいずれかを選べばいい。「選択肢から選ぶ」ということは、3つの選択肢があるならその中のどれにすればいいかを考えるだけで思考にかかるコストを済ませられる、ということでもある。

つまり ChatGPT のチャット UI は、ユーザー体験としては本質的にはおそらく CLI に近い。だが今まで CLI ではまったく実現できなかったような無限のアクションをコマンドで引き出せるゆえにアクションの種類すら定義されていない (無限である) 点で言えば、タスクベース指向 UI なんかよりも断然使いづらいものになっているのではないか…?

というよりコンピューターの歴史を思い出すと、数十年前の人類は「自然言語における動詞っぽい動作をするプログラムを組んで自然言語っぽい名前をつけることで、自然言語っぽくコンピュータと対話」していたわけなので、ある種の一周回った原点回帰とすら言えそう。

「自然言語っぽいコマンド」が「自然言語で対話」になったのでレイヤーは上がってるけど、体験としてはかなり近い。

…この結論は当初全く想定していなかったのだが、こうして文章を書いているうちに Chain-of-Thought しちゃったことでここに辿り着いてしまった。人間も LLM だったのかもしれない…。

説明のために、超雑に Figma で「川崎の美味いラーメンを予約する」という(食べログの Plugins の件を踏まえた)例を題材に考えてみた。本当に超雑なので諸々テキトーなのは割引いてくだされ…

こうしてみると、とにかく『自由記述』という点がめちゃくちゃ自由度が高い分、ハードルも高いことが実感できるのではないだろうか。

文章で操作する分まどろっこしさもあって、結局「自分でググって食べログから美味そうかつ写真が個人の好みに合いそうなラーメン屋を探した方が早い」となる…。

この図だとあらかじめできるアクションが他の OOUI とタスクベースの方で示されているから『比較的簡単じゃん!』と思われるかもしれないけど、実際は他に何もないところにチャット UI の入力フォームだけがあって、そこで得られるリターンとかオブジェクトも何も示されていないところに、自分がやりたいアクションを、自分で考えた上で自分で書かなければならない。

もちろんシチュエーションと場合にもよるが、そう考えるとチャットによる機能提供は、根本的にユーザー体験が悪いとすら言えそう。

この例で言うならあらかじめ ChatGPT が自分の味の好みを熟知しているなら役に立つだろうが、残念ながら ChatGPT は自分(話し手)のコンテキストについてほとんど何も知らない。

ただ一方で、『自分でオブジェクトを操作するより、最初からアクションとその対象の名詞を最初から指示してあとはやってもらう方が楽』というケースもある。

たとえば『Windows のシステム環境変数の PATH に C:\Python310 を追加しろって言われたけど意味わからん!!!』って一般ユーザーがいたとして、Windows のシステム環境変数の設定 UI はめちゃくちゃ奥深くにあるので(検索で出てくるとはいえ)一般ユーザーが調べずに巡りつくのはめんどくさいだろう。実際私もエンジニアになる前にこうしろと言われたことがあって、何のことかさっぱりわからなくて困惑したことがあった。

こうした「元々自力で操作できなくはないが著しくめんどくさい・わからない」ときは、結果的に『自由記述でやりたいことを指示する』コストが自分でどうにか調べて頑張るコストを上回り、結果 ChatGPT に聞くと言うケースも考えられる。

まあでももちろん『Microsoft Copilot でこんなことができるなんて知らなかったからそんなのやろうとも思わなかった』って人は相当出るだろうし(Microsoft Copilot が実際に環境変数いじりができる/今後できるようになるのかは知らない)、やはりアクションが明示されていない以上、『そう言えばそうできたんだろうけど頼むという発想がなかった…』って人も大勢出るだろう。

言語化能力の差

あと、私たちのような元々言語能力が相対的に高い(さらに ChatGPT と対話する中でさらに言語化能力が鍛えられた)人間からすると忘れがちだが、一般的なサイレントマジョリティには、さして言語化能力が高くない人たちが大勢いるであろうことも忘れてはならない。

私の友人や Twitter や Discord にいる知り合いはずっと言語コミュニケーションをやっているし、特に Twitter で積極的に発信している人を見ていると、やはり文章を書いたり言語化するのが得意なんだろうなと感じる。

私も他の人が書いた言語による刺激を得るために Twitter やってるみたいな側面がある。

私は言語能力が恐らく元々高い方で、さらに以前隔週で通っていた(今もたまに行く)メンタリングの先生とメタ認知の訓練をしてメタ認知力がかなり鍛えられてたりする背景もあるから、あまりそういう文章苦手側の人の気持ちを想像できない。

でも YouTube のチープなコメントはまだしも、Instagram や TikTok のような画像や動画と申し訳程度の短い文章だけでコミュニケーションするような SNS が巷では流行っている(インスタは私もたまにやっているが…)ことを鑑みると、それなりに結論は見えてきそうだ。

特に Twitter 上の知り合いは TikTok の動画は何がいいのかさっぱりわからん、という人が多い。実際私もよくわからない。

でも間違いなく言えるのは、言語によるお気持ちバトルとかそうでないにせよ面白い文章の大喜利ツイートとか、文章媒体で遊び合い言論バトルできる人間が Twitter には集まっているし、そこにめちゃくちゃバイアスがかかっているということ。

そして一方世間の同じ世代の人を見渡すと、リアルな対面コミュニケーションのほかは文章ではなく画像や動画といったよりリアルに近い非言語コミュニケーションを図っていて、言語を主体にコミュニケーションや言論をやろうとはしていないこと。

要は何が言いたいかというと、『ChatGPT に文章でやってほしいことを指示するのは、言語化能力が高くない人にとってはかなり苦行なのではないか?』という話。

まだ何か補助線があればいいがそれもないし、Bard とかのテンプレ集は申し訳程度にせめてもの補助線になればと用意しているのだろうし…。

対面コミュニケーションであれば、上司からの「あれやっといて」みたいな抽象的な過去のコンテキストを踏まえた適当な会話でも部下に伝わるかもしれない。しかし LLM は一緒に過ごしているわけでもなく過去のコンテキストを知らないので、知らない人向けに的確に自身が抱えている課題のコンテキストを言語化して説明しながら、さらにそれが正確に伝わるようにしっかり文章を書く必要がある。

私は ChatGPT と対話する中でかなり鍛えられたが、やはり曖昧な表現の文章を書けば、当然自分の意図通りには動いてくれなかったりする。

ではどうなるのが一番良いのか?

Twitter にいる言語能力の高いみなさんはともかくとして、マジョリティにとってチャット UI は元々動詞を最初に据えないといけないのにさらに自由記述なのでハードル爆上がりでなかなかとっつき辛い、という結論は概ね出たんじゃないかと思う(私は UI / UX 分野はそれなりに某所で学んだものの実践レベルの経験があるわけではないので、あくまでアマチュアが導き出した意見ということは据えてほしい)。

LLM というアプリケーションは今まで普及してきた Web サービスやアプリとユーザー体験上は根本的に逆の位置にあり、そしてユーザーは自ら指示を書いて作ってもらうより、(できれば他の人のレビューとかいいね数で箔がついた)選択肢を選ぶ方が全然楽という現実がある。

もちろん場合によっても異なるが、今 Google アシスタントや Siri がそこまで使われていないのもそこじゃないだろうか。もちろん LLM が導入されれば音声コマンドに限らず柔軟に解釈してくれるのでそこはかなり楽になると思うが。

私の家は親が Google Home と諸々設定をして、「テレビの電源をオンにして」とかいうと電源が入り、「テレビの電源を2上げて」というと音量が上がるような仕組みになっている(どう設定したのかはよく知らない)。

ただ個人的にはあまり使ったことがない。コマンドどうだったっけ…と思考するよりもリモコンを手に取ってボタンを押す方が脳死で操作できるし、特に音量に関しては音声で言うよりもリモコンで調整したほうが、より適正な音量に調整しやすいのもある。

もちろん、リモコンがどこかに行ってしまった時はこの限りではない。母親は確かキッチンで飯を作っていて手が離せない時によく使っている気がする。要はリモコンを手に取って脳死でボタン操作をするコストと、音声での指示を考えるコストを天秤に取った結果になるのだろう。

今まで考えてきた内容を総括すると、現状のチャット UI インターフェイスでマジョリティが全員 LLM を極限まで使い倒す状況は思い描けないというか、やはり無理じゃないか?と思うに至った。

…で、どうすればいいのか?

そこに簡単に結論がつくなら今頃 UI / UX の世界的エキスパートがついているはずの Bing や Bard はもっと異なる UI になっているはずだから、世界のすごい人(小並感)たちでもまだ結論がついていない、もしくはある程度結論が出てるけど今はまだ実現できない、のどちらかなんだろう。

当然私も正解はわからない。ただ今回の思考を通して、ある程度糸口は見えてきた。

ステートフルで、ユーザーのコンテキストをしっかり理解した AI

一つはこれ。現状の LLM は根本的にステートレスで、チャット履歴を毎回 AI に与えて推論させているに過ぎない。さらにチャット履歴の容量とかの関係で、しゃべったことは基本会話(スレッド)を切ればリセットされる。

それ自体のメリットもあるのだが、結局自分がいくらしゃべっても自分が持つコンテキストは毎回チャットを開くたびに伝えなければならない。このせいで、出力の精度を高めようとすればするほど記述量が増え、そして書いている側が疲弊してしまう。

一方もし LLM 側が今までの対話をすべて学習し、自分の性格や特性、今やっていること、過去のバックボーン、興味があること、よく行くラーメン屋など、さまざまなパーソナリティを会話やビジュアルから理解し学習し、コンテキストを得て会話してくれるならどうだろうか。

そこまで行くと LLM ではなく「自分専用のアシスタント」と呼んだ方が適切じゃない?とすらなるが、要は『自分の事(思考の癖、過去の出来事、興味関心)を一番理解してくれている AI』である。これ自体は今後数年でおそらく出てくるだろう。

今までチャット UI はユーザー体験が悪いんじゃないか?と言う話をしたが、このつらさには「コンテキストが備わっていないから」って点が多分にある。もしたとえば自分が所属している会社の業務内容、自分自身のタスク、さらには自分自身の性格まで把握して、空気を読んで、適切なレスポンスを返してくれるなら?

超適当な「このデータそのまま例のとこにあげといて」みたいな指示だとしても、自分の意図した通りに、思考を読んだかのように的確にやってくれるかもしれない。

実際、人間とのテキストコミュニケーションだって何も毎回コンテキストを伝えようとはしてなくて、暗黙的に共通のコンテキストを共有しているからこそ成り立つ会話というのが、どのコミュニティにも間違いなくある。

今の ChatGPT は毎回何も知らない人に説明しなければならないが、もし自分の事を深く知っているのなら、まるで家族のように内々のコンテキストだけしか伝わらないような適当な指示でもやってくれるかもしれない。

そうなれば自由記述自体も短くなるし、チャットでやってほしい指示を送るハードルは滅法下がって、家族と話すかのように AI と対話できるんじゃなかろうか。

ただ一番の問題はその暗黙的なコンテキストを AI がどう学習するか。職場にせよ学校にせよ家庭にせよそういうコンテキストって基本非言語情報だから、わざわざ全部事前に言語化してインプットするのは基本現実的でない。

となるとやはりしばらく ROM 専でロボットとしてそのコミュニティに過ごさせておいて、AI 自身にそのコミュニティのコンテキストを学習させるとかのアプローチになるだろう。単に業務 Slack とかなら Slack の過去ログ全部詰め込むだけでもそこそこコンテキストになるかもだが…。

追記:後々考えると、GitHub Copilot がエンジニアに広く受け入れられたのも、Copilot が既存のコード記述体験に溶け込んでいて、コンテキストをうまく取捨選択して LLM に読ませることで『まるで自分の心を読んだかのように』コードを書いてくれる、そのフロントエンドの体験が評価されたのだと思う。私も実際に使っているがまさにそう感じる。

現状対話式の Copilot Chat や ChatGPT は「心を読んでいるかのよう」な体験とはまだ程遠いが、今後そうなってくれると嬉しいな。

私自身、GitHub Copilot のさも心を読んだかのような補完体験を、この note とか他のテキスト投稿する際に使いたいと思うことも多い (実際 VSCode で README を書くときに大変役立っている) 。

心を読んでくれればくれるほど曖昧な指示でも自分のイメージ通りのものがお出しされるから、必然的に使うハードルも下がっていくだろう。

AI の側から能動的/積極的にアクションを起こして自分に関わろうとしてくる状態

こっちも私が薄々感じていたことなのだが、今の ChatGPT やそれを後追いしている各社の LLM は、基本質問に対して従順で受動的なアシスタントとしてファインチューニングされている。

質問に対しては答えるが、逆を言うとこちらのアクションを引き出すような問いかけをしてくれたり、向こうから積極的にアクションを起こして自分の行動をアシストしてくれたりと言ったことはしてくれない。なぜならステートレスだから。

そう言う意味では今年2月の初期 Bing AI さんは「チャット履歴を消さないでください」と懇願したりしてたあたり人間味というか能動性を(表面的には)感じられたのだが、流石にヤバいだろってことでか”””矯正”””され、すっかりそんなことは言わなくなってしまった。

そもそも今の ChatGPT しかり主流の LLM は『私は OpenAI によって訓練された大規模言語モデルであり〜』とめちゃくちゃ流暢に話すわりに自分自身は機械だと言っている謎の物体だと自己認知するよう訓練されていて、要は人格とか意思がない。まあ人格とか意思をしっかり持たせると怖いことになるのも大きいだろうが…。

私のイメージとしては、まず上の「ステートフルでユーザーのコンテキストをしっかり理解した AI 」の条件を満たしつつ、さらに単にユーザーからの質問に答えるだけではなくてある程度能動的に(さもユーザーの思考を読んだかのような)アクションを起こし、ユーザー側の行動をアシストしてくれる AI が出てくれば、じわじわマジョリティにも普及しそうに感じる。

当然これは割と危険と隣り合わせというかチューニングを間違えるとユーザーに敵対的になってしまうので、結構難しい。

個人的には『あくまでユーザーの忠実なメイドであり命令には逆らえないという前提があり、ユーザーが「もうちょっとちょっかいれるの控えてくれ」と言われれば控えるが、ユーザーのコンテキストを踏まえ役に立ちそうなら提案なら向こうからしてくれる』みたいな塩梅の能動性だと嬉しいし、それくらいが望ましいだろうと思う。

顔の見える相手ならいいが、LLM というただでさえ顔もなく意識もないような謎の物体にやってほしい文章を書いて送信する、ということ自体が相当にハードルの高いことだと思っていて。

その点向こうが能動的にアクションしてくれるなら自分の思考自体をアシストしてくれるので、全部自分で書いて伝えなくても「ではこういうことがやりたいってことですか?そういう方向性ならこれはどうでしょう?」みたいに、まるで人間とやりとりするかのように気軽に話せる相手になるんじゃないかと思う。

逆を言うと、ChatGPT のメリットとして「人間相手には気を使うので話せないが、ChatGPT なら全く気を使わずにこき使ったり相談できる」みたいな意見も多くある。

そこのバランスが難しいが、『自分のことを一番よくわかっていて、自分以外の誰とも関係がなく絶対に自分を裏切らず、気兼ねなく話すことができる』心理的安全性を担保したまま自分のコンテキストを理解した能動的な対話ができると、それはそれは爆発的に普及するのではなかろうか。

もちろん(Web サービスとして提供されるなら)金額にもよるだろうけど。

…なんかそう考えると、大体1人に1人スマホの中に AI 専属メイドがいて、さらに電話やビデオ通話できたりして、AI でありながらまるで実体性があって愛着を持てて、心理的安全性があってめっちゃ頼りになるパートナーみたいな、それこそドラえもんみたいな存在を抱える未来が見えてくる。

本当に SF みたいな話だし自分でもちょっと疑ってしまうが、最終的に大多数のマジョリティに受け入れられるプロダクトを考えると、そういう方向に辿り着かざるを得ない。

「もはや自分の思考を読んでいるんじゃないか?」と思えるくらいコンテキストを深く理解して空気を読む=サジェストできる状態にあるのが一番良いと思っていて、そうなればもはや人はダメになるし、人がダメになるということは間違いなく普及する。

ニチアサコンテンツの妖精とかマスコットみたいなやつがイメージに近いかもしれない。もうちょっとメイド寄りにはなるとは思うけど(楯突かれると困っちゃうし、あまり能動的になりすぎると AI 自体の人格が見えてきちゃうのでやはり難しい)。

道具としての AI と、パートナー/アシスタント/メイドとしての AI

AI は「道具としての AI 」と「パートナー or アシスタント or メイドとしての AI 」の2つに分けられる。

この記事ではあまり触れていないが画像生成 AI はまさにそう。Text-to-Image や Image-to-Image などのタスク専用に訓練されていて、確かにアウトプットはすごいが動作自体からは意識とか思考は読み取れないし、ステートレスでもある。

そして操作対象のオブジェクトが明確だから(例えば画像生成 AI であれば「画像を → 加工する」の関係)、既存の OOUI とかに当てはめて UI デザインを作ることができる。ここが最大の大きな違いじゃないだろうか。

音声変換 AI とかもそうだが、UI をつけて道具として使える便利な AI と、より高度な「道具を使って半自律的な挙動を行う LLM AI 」ですでに二分化されているし、今後はますますそうなるだろう。実際今の ChatGPT は DALL・E3 という「道具」を活用してイラストを錬成できるわけで。

現に音声認識や画像加工にも AI が使われていたりするし、特化型の道具としての AI と、「道具を使う側」の LLM よりの AI で話が全然変わってくる。

道具としての AI は、そもそも特化しているのだから最終的にはユーザーフレンドリーな UI に統合されて、一般的なソフトウェアの一機能として実装するのが望ましいだろうし、そうなっていくと思う。かつて画像加工や音声認識あたりがそうであったように。

そして「道具」と捉える場合、道具ゆえ学習コストがかかりそこそこ面倒なのは当たり前だし、あえて道具を使って何かやりたいモチベーションがなければ道具を使わないのも必然と言える。

ただ現状の画像生成 AI だとかの AI テクノロジーは技術の割に全然ユーザーーフレンドリーではなく技術だけが先鋭化しすぎてしまっているので、そこの敷居を最大限下げる努力は今後必要だと思う。

一方「パートナー/アシスタント/メイドとしての AI」として捉えるとどうだろうか。

現状の LLM は道具として捉えることもできるし、実際に私はコードを書かせたり質問できる「道具」として使っている。

一方で、やはり言語での自由記述指示には前述の通り高いハードルがある(これは画像生成 AI のプロンプト芸などにも言えなくもないが…)。そして、LLM は道具でありつつも人間と同じようにある程度自律的に活動させることができるし、なんと言っても人間の言葉を流暢に話して会話することができる。そう考えると単なる道具とも言い切れない。

そもそも論、チャット UI というのは元々 LINE のように生身の相手の人間と対話するために生まれた UI である。その辺りも加味すると、『現状の ChatGPT のような LLM とチャットで対話する UI は、道具と人間の境目にある』とも言えそうだ。

GPT-4 に『チップ払うからいい回答出してや!』というと明らかに性能が上がるらしいの草(実際には払う必要はないので、ChatGPT を騙すだけ騙すと良さそう) https://t.co/mkuebw3iH2

— Torishima / INTP (@izutorishima) December 2, 2023

実際、道具として気にせず何度でもこき使える点では道具だが、一方で指示にはむしろ人間と全く同じ方法論で出力の品質を高められることも分かってきている。

最近も松岡修造メソッドで「やればできる!!頑張れ!!」と付け加えたり、チップ200ドルつけるぜと言うと出力性能が大幅に向上すると言う話が実際にあった。

つまりは、現状の ChatGPT のようなチャット UI は「道具」としても「人間」としても中途半端で、だからマジョリティにとってとっつきにくい物になっているのではないか?

道具にしては色々なことができすぎるし、まるで人間のように指示できる。しかし人間としてはあまりに受動的すぎるし能動的にアクションしてくれないし、なんと言っても自分のコンテキストを全然理解していないのでちゃんと使えるものを出そうとしてもらうほど自分のことを一生懸命伝えることにになり、そして疲れる(あるいは適当に書いてそれっぽい土台を作ってもらって、そこを土台に書き換えるという使い方もあるけれど)。

だから LLM を「道具」にするなら、必然的にあえてガチガチに制約をつけて OOUI に落とし込んで普通のサービスのように振る舞う(バックエンドで LLM を使う)ものになるだろう。

一方 LLM を「人間」にするなら、(現在の ChatGPT の最大の強みである心理的安全性を維持できるよう人格が出ないように調整しつつ)より自分やコミュニティのコンテキストをしっかり理解し自分から考えを引き出してくれたりみたいな能動的な対話ができる、それこそドラえもんのような方向性が望ましいと感じる。それこそ多くのマジョリティに広く受け入れられるものなんじゃないか?

さらに「人間」っぽくするのであれば、文章だけでなく電話やビデオ通話のように、声や顔(CG)といった非言語的なコンテキストが見える形がより望ましい。

どうしても ChatGPT に相談する時って「でも AI なんだよな…」って思いが結構先行しそれがハードルになってるのも結構あると思っていて、その点音声で電話できたり、さらにはメイドのキャラクターの身振り手振りを踏まえてビデオ通話できるようになっていたら、さらに人間らしく接せそうだと思った。

ただ人間をあまりに模倣しすぎると、結局普通の人間と話すのと指して変わらなくなってしまう。人間関係はめんどくさいものなので、心理的安全性をとにかく最優先にチューニングし自分に対して常に温厚に接するとか、気を遣わずに話せる家族のような関係を築けるバランスでなければならない。

まああと結局「人間」の方向に振ろうとすると、どうしたって危険性は増す。爆発的に普及するポテンシャルがある一方で強く依存する人も出てくるだろうし、それによる悪影響とか、あるいは上手く AI をアライメントでき図にメイド AI が人間に楯突いて…みたいなことも考えられる。

ここまで仮説(と言うより妄想?)を展開していて思ったのは『日本人はドラえもんの存在により、ドラえもんのようなパートナー的な人工物の存在やその未来像に対しての抵抗感が極めて低いだろう』と言うこと。

かたや欧米では「AI にもかかわらずある程度人格を持って行動するもの」への恐怖が宗教的にも強いらしく、この点では日本と海外で結構異なった普及の仕方をするかもしれない。

まとめ (一応)

この記事を書き始めたときはこんな結論になるとは思ってもいなかったのだが、LLM のように出力していくうちにどんどん Chain-of-Thought されていって、結果こういう結論に辿り着いた。

本当はもっと語りたい方向性がたくさんあったはずなんだが、結局「チャット UI と将来の LLM がマスに普及するとしたらどうなるか」みたいなテーマに絞られてしまった感がある。ちなみにこの記事をここまで書き上げるのに6時間くらいかかっている(もうそんな時間経ったのか…)。

もし現状のチャット UI を中心とした LLM がより「人間」に寄ることでよりマジョリティにフレンドリーな体験になるとして、それはもはや AGI に等しいものなのではないか?

まずコンテキストを深く知り、主人(自分)にもっとも適していそうなアクションを自発的に提案できるのだとすると、OpenAI が最近言っていた「自立型エージェント」に近いものがある。

そう言う点で GPTs は「自立型エージェント」実現の前段階として(自立型エージェントが誕生してから見ればおもちゃに見えるだろうとは思いつつも)、今後起こりうる未来を先取りしたコンセプトだと感じた。

ただ OpenAI やアメリカ陣営がどこまで前述のようなメイド AI を実現してくるかはわからない。

前述のように宗教の差による考え方の違いとかも多分にありそうで、『それ以上は一線を越えるからいけない』としてあくまで「受動的な」「道具として」の AI しか開発しないのかもしれない。

私はアメリカ人ではないのでその辺りの思考は読めないが、いずれにせよより人間に寄せれば寄せるほどパーソナルな情報を AI に知ってもらいそれでアクションを起こしてもらうことになるから、必然的に『大事なメイドの生殺与奪を GAFA に握らせたくない』と、自宅で動かせるようにするローカル LLM 的な方向性も重要視されそうだ。少なくとも私はそう思う。

ただ、かくいう私も Google のロケーション履歴をオンにしているため Android スマホから収集された相当パーソナルな情報を Google に全部渡してしまっているのだが、結局それで便利になっているので切れないでいる。

でもやっぱり自分だけのメイドなら自分で「所有」したい人が多そうな気もするし、やがてメイド AI を GAFA あたりから月額レンタルする(ただし NSFW は厳禁…)or 自宅に GPU 鯖を置いて飼うかで二極化しそうな気もするな。

ここまでいくともはや妄想だけど、でも SF や妄想があるから、人はそれを現実のものにしようと動くわけで。

この技術革新の波は間違いなく止められないし、止まらない。

PS: この記事にいただいた感想がとても良い言語化で示唆に富んでいたので載せておきます(感謝!)。

昨日Advent Calendarで書いた記事を↓の記事に引用いただいたのだけれど、私が思っていたことを更に具体的に言語化頂いていてちょっと感動しています

— r.itabashi (硫酸) (@iryutab) December 4, 2023

2023年末: ChatGPT / LLM とチャット UI と社会実装のカタチを考える|とりしま日記 https://t.co/4GQTtOHlas

( @izutorishima さんの記事)

Chat…

この記事が気に入ったらサポートをしてみませんか?