メタバース時代の触覚UXを六本木のミュージックバーで実証実験した学生の話。 #CEDEC2021

本エントリの内容は、2021年8月24〜26日開催の開発者会議CEDEC2021での発表「VibeShare:コロナ禍の音楽ライブを「触覚」で双方向化する」に関する話題です。XRメタバース時代の研究開発を担当するGREE VR Studio Laboratory(以下ラボ)の山崎勇祐と白井暁彦がお送りします。

オンラインライブに触覚とバーチャルギフトを活かす

本エントリではラボが開発する熱狂共有技術「VibeShare」の機能を活用し、オンラインライブの出演者が観客の存在をオンラインでも実感できる双方向化技術と、3日間の実証実験 (Proof of Concept & Proof of Value; PoC, PoV) を通して得られたユーザー体験(UX)の評価について紹介します。

VibeShare

VibeShareには触覚やエモート、投票機能、タイムシフトや番組分析、ゲームプレイなど様々な機能があります。

詳しい紹介はまたの機会に執筆したいと思います。ご興味ある方はこちらのサイトをご訪問ください(https://vr.gree.net/lab/vibeshare/)。

実験で注目した要素「映像」「触覚」「音効」

今回は音楽ライブにおける観客の存在感を出演者に届けるにあたって、主に3つの要素を実装して出演者との双方向性を高める機能を実験しました。

・映像:観客から送られてくるエモート👏🍹💰🌸を会場の壁面に投影

・触覚:観客からのおひねりエモート「💰」に応じて振動

・音効:観客からの拍手エモート「👏」に応じて、拍手音を場内で再生

詳細を紹介していきます。

映像については、観客が送ったエモートおよびエモートの集計グラフをOBSでリアルタイムに合成し、場内に併設したプロジェクターから会場の壁面に投影しました。

触覚については、💰が出演者に送られるたび、その連打回数に応じた振動を出演者に伝えることで、観客からのギフト(バーチャルおひねり:この実験ではアメリカのチップ文化をベースにGRATと名付けました)を演奏中でも即座に感じられるようにしました。

振動触覚を提示する装置には、

・演奏中に十分な強度で振動を伝えられる点

・装着が容易で演奏の邪魔になりにくい点

からネックレス型触覚デバイスのHapbeat-Duoを使用しました。Hapbeat-Duoは音声信号で駆動できるため、3.5㎜ミニステレオプラグが接続できるスマートフォン端末でVibeShareブラウザを開くだけでエモートの受信装置として利用できます。汎用的な装置構成となっているので、激しいパフォーマンスや故障、断線、電池切れといった不具合への対応がしやすいのが特徴です。また将来的には現地オフラインでの観客への特別なインタラクション提供も考えています(現地の観客が、オンラインの観客の存在感を感じる、など)。

音効については、会場に指向性モニタースピーカーを配置して👏が送られた時に拍手音を再生しました。拍手音量の調整は会場内の音響担当者が行っており、演奏中はミュートしていました(が、場合によっては演奏中に拍手音が鳴っていても良いと感じました)。拍手音は事前に同会場で収録した5種類×強さ3段階の計15種類の拍手音を、拍手エモートの量に応じて再生しました。

実証実験ライブ in

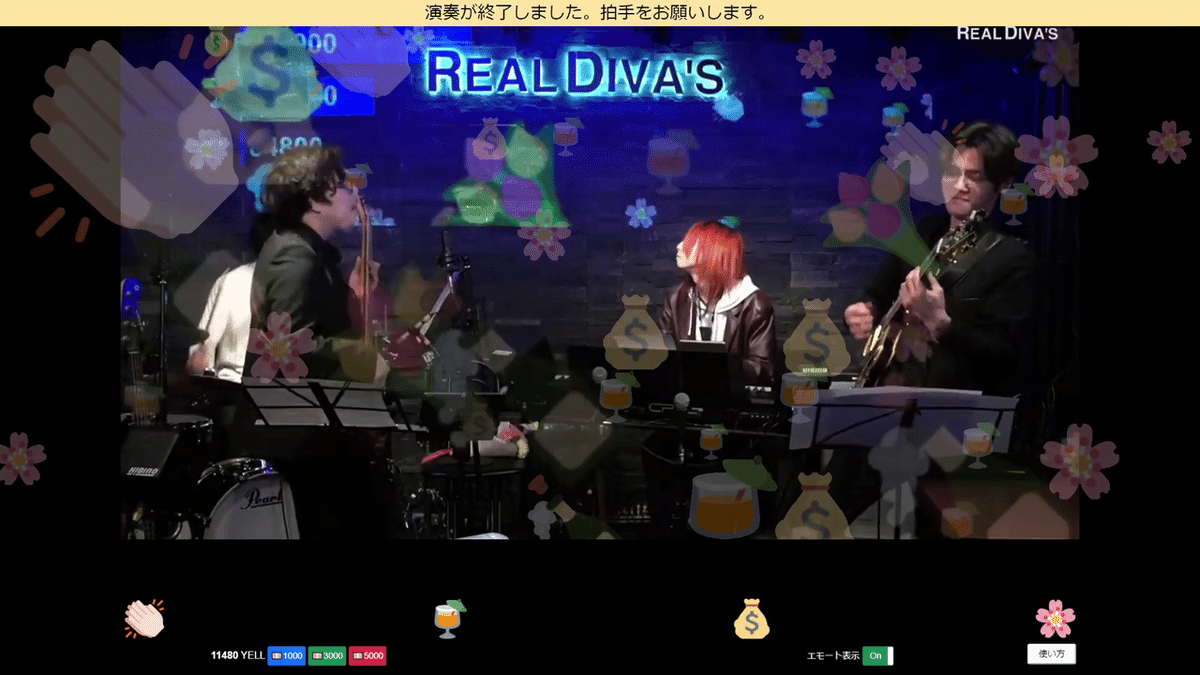

Live Music Food & Bar『REALDIVA’S』

実証実験は、ヒビノエンタテインメント株式会社(以下、ヒビノさん)とのご協力により、六本木の Live Music Food & Bar『REALDIVA’S』でのオンラインスペシャルライブを使った公開実験で行いました。2021年3月24〜26日の3日間を「春フェス スペシャルライブ」という形で Day1, Day2, Day3をそれぞれ異なる出演者さんにご協力いただいて実施しております。

ハードウェア構成としては会場内には観客から送られてきた Emoji や YouTube Live のコメント欄を表示するためのプロジェクター、「👏」(拍手エモート。以下文中のEmoji表記は該当するエモートを意味します)が送られた時に拍手音サウンドエフェクト(SE)を鳴らすためのモニタースピーカーを設置。さらにおそらく世界初の新しい試みとして、出演者・演奏者側に触覚デバイス「Hapbeat Duo」を装着してもらっています。視聴者からのエモート「💰」が送られたときに、Hapbeatが固有の振動刺激を発生させます。駆動用の信号は出演者さんのお手持ちのスマホの音声出力で利用できます。

実証実験の様子は、ぜひ以下の動画(3日目)をご覧ください。演奏している寿司ドミナントさんの胸のHapbeatと、各楽曲が終わった時の拍手喝采、満足そうな顔をみていただけると、おおよそ何が起こっているかを把握することができると思います。

タイムライン分析機能

3日のライブ総計では、19〜21時に関係者を除いた参加者は1日目が18人、2日目が20人、3日目が31人で、合計108,031回のエモートが送られました。

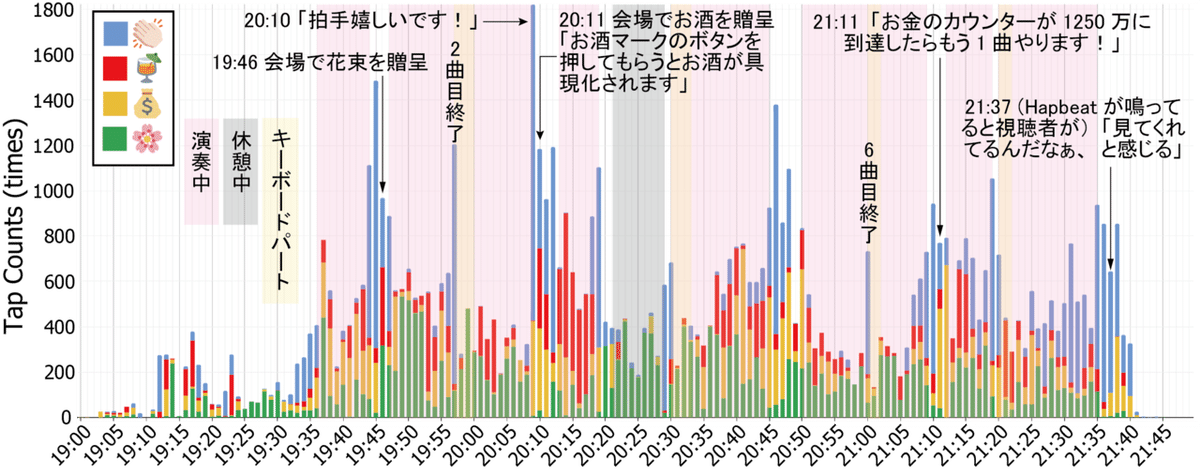

こちらは実証実験 Day3 の観客から送られたエモートを時系列順に集計したものとなります(横軸は時刻)。

配信時間全体160分でのタップされた回数は全体で71,323回、1分あたり445回、観客一人あたり20回/min というタップ頻度となりました。対する YouTube コメントは番組累計で216件で、観客にとって文字コメントよりもはるかに参加しやすかったことが伺えます。

タイムラインで特徴的な点は、演奏終了時と、その後3分程度「👏」が集中して送られていること、公演中に出演者が拍手について「拍手うれしいです…」と複数回言及していたことから、「👏」エモートと拍手音が実際ライブと同様の双方向化の役割を果たせていることが分かりました。

また、主催側や演奏者側で特定のギフトを喚起させる発言を行なった直後の時間帯(🌸19:46-19:47、🍹20:11-20:12)において、対応したEmojiの割合が増えていることから、出演者-観客でのコールアンドレスポンスと同様のコミュニケーションが成立していることが読み取れます。

このようにして、VibeShareによるタイムライン分析は実際の音楽ライブにおける番組分析よりも、より定量的・定性的に番組改善のためのデータが得られることがわかります。

主観アンケート結果

もちろん主観データも取得しています。番組終了後、観客の属性や番組の感想に関するアンケートを行ったところ、全期間における総数は22件のうち男性11人、女性11人であり、年代は20代1人、30代3人、40代8人、50代6人、60代3人、不明1人でした

結果から、22人中19人が「楽しめた」と回答しており、性別年代問わず既存の観客に違和感なく受け入れられていたことが確認できました。

また半数が「出演者との一体感がある」、3分の1程度が「他の観客との一体感がある」「一緒に番組を作っている感じがした」「出演者に感情を伝えられた」と答えていたことから、本システムは観客にとってのオンラインライブの体験価値を向上させたとともに、音楽ライブに重要な要素である「一体感」の向上についても、寄与することができたと思います。

触覚UX

以上でおおよその分析は終わりなのですが、最後に今回の表題でもある触覚についてお話させてください。

今回触覚のUXとして、演奏中でもリアルタイムに観客から投げられたバーチャルギフトが体感できる、を考案し、実装しました。その結論について、以下のシーン(11:15-11:23)をご覧ください。

💰エモートが投げられて、首からぶら下げているHapbeatが大きく振動、ドラマーの方がそれによって笑顔になる、という、まさに狙っていたUXを実現することができました。さらに、終了後に触覚の感想についてヒアリングすると、「演奏中でも振動は感じられた」「振動は演奏の邪魔にならなかった。むしろ(観客の存在を感じられて)嬉しかった」と仰っていただきました。実験開始前は振動が突然来ると演奏の邪魔にならないか不安でしょうがなかったので、このようなポジティブなフィードバックをいただけたことで安心したともに、触覚技術はライブ出演者に有用であることを確認できて、非常に有意義でした。

今回はまだHapbeatが無線化できておらず取り回しが悪かったり、特に女性出演者の場合、触覚デバイスが衣装に合うように外観を調整できるようにした方がよいなど、色々と実用上の課題が判明したのも良かったです。

さらに技術詳細

VibeShare::Vote—Emojiによる感情表現

音楽ライブに対する観客の反応はビデオ会議等と異なり言語化しづらいこと、拍手や歓声も含め、匿名かつ反応速度が短いほど好ましいという特徴から、Emojiで感情を表現できるVibeShare::Voteを開発しました。

VibeShare::VoteはVibeShareが持つイベント向けユーザー投票機能です。視聴者はEmojiで表現されたボタン(😀😱👍👏など)によって感情をエモートとして投票でき、管理者ページで送られたエモートをリアルタイムに集計することができます。こちらは大学の講義などでも実験しており、聴衆が(何か積極的なコメントは発言しないけれど)何に反応したのか、何を考えているのか、何が面白かったのか、といった分析に役立ちます。

REALITYのバーチャルギフトの知見を活かして新たなUXの設計に

さらに今回はEmojiボタンを連打できる「バーチャルおひねり」を設計しました。Emojiを一度タップしてから一定時間内に再度タップされた場合は連打判定となり、その回数が保持されるとともに、UIのEmojiボタンが大きくなります。連打が終了するとEmojiの種類とともに連打回数がサーバーに送られ、Emoji、拍手、振動触覚の種類の決定、Emojiの大きさの制御やEmojiの進化(例:「🌸」→「💐」)に利用されます。

これは、シンプルなUIで、ユーザーのエモート表現意欲を向上させ、高速に大量のリクエストを処理可能とする実装となっています。先程のデータにもあったように、ひとりのユーザが1分間に20タップするとして、これが数千〜数万といったユーザになったり、何時間も連打し続けたり、もしくは連打することが目的になってしまうようなことがあったとすると、送信リクエストや描画リクエストは重く、結果として配信画面は見えなくなってしまいます。そのような状況を回避して快適かつ没入感を高めるUXが開発できました。

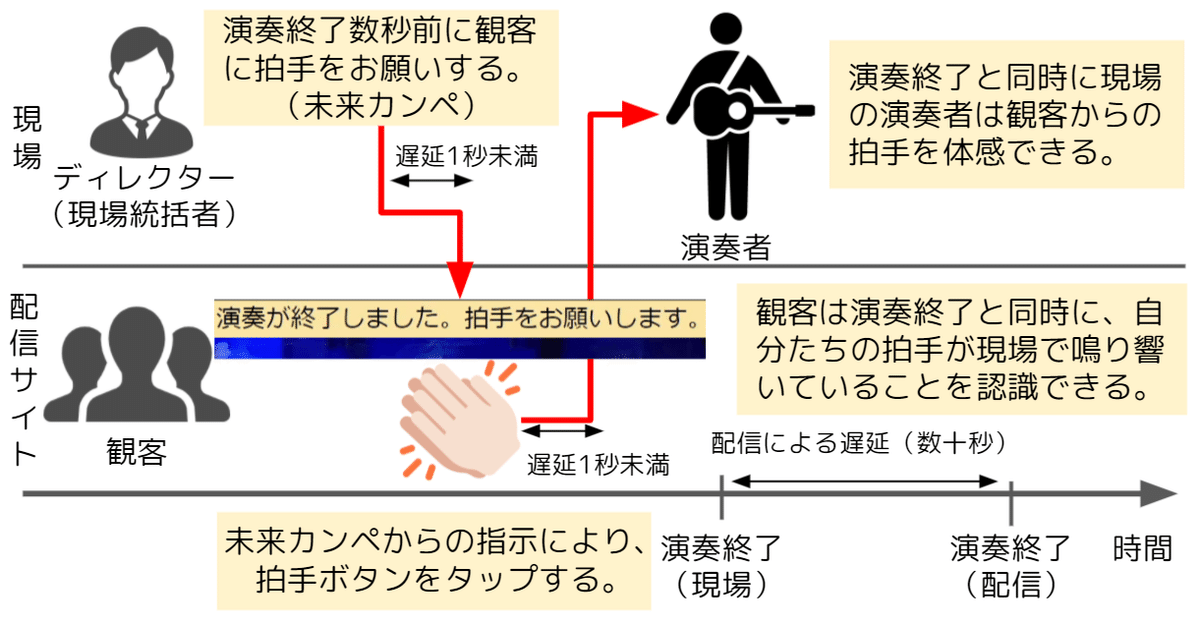

遅延を超える協調技術-未来カンペ機能

「各楽曲が終わった後の満足な顔」と表現しましたが、ライブや音響を担当する方は、実際にはこれを実現することがとても大変であることに気がついていると思います。YouTube等で配信されるライブストリーミングは視聴者とスタジオの実時間には30秒以上の差があるからです。

つまり実際に音を聞いている配信者が「あ、楽曲が終わる…拍手👏👏👏」と思っても、その時には「時すでに遅し」です。アーティストさんたちは虚無の空間に向かって演奏を終えて心の中にぽっかりと大きな穴が空いている状態です。もちろん音効さんが拍手などのSEを鳴らすことはできますが、欲しいのは音効さんのSEではなく「お客さんの拍手👏」なのです(複数のアーティストへのヒアリングより)。

そこで、ラボでは様々な実験と試作の末に「未来からきたディレクター」が『拍手してください』という指示を出せばいいのでは?という発想で以下のような「未来カンペ機能」を実験的に実装しました。

ユーザが観ている配信画面の上部に「演奏が終了しました。拍手をお願いします」と表示されています。画面中の演奏者はまだ演奏をしていますが、多くのユーザは何をすればいいのか即座に悟ってくれたようで、「👏」を送っています。タイムラインを見ると1曲目、2曲目、3曲目…と拍手が使われるタイミングと量が明確になっていることがわかります。

オンラインの観客からの拍手を音効として再生する場合、タイミングの制御が重要です。視聴者にとって、演奏を阻害せず、かつ出演者の演奏に対して適切な想いを伝えられるタイミングは多くの場合、楽曲の終了時になります。演奏終了のタイミングで観客が遅延や違和感なく拍手を出演者に伝えられることで一体感が実現できることが確認できました。さらに「未来カンペ機能」は、配信ディレクターのダッシュボード(WebによるUI)から臨機応変に自由なメッセージを視聴者に向けて発信する機能として完成しました。自然なコミュニケーションを伝えるディレクター機能「未来カンペ」を設計、実装しました。この機能はYouTubeの配信よりも20秒近く早く未来に送ることができるため、出演者への自然な拍手を遅延無く発生させることができるだけでなく、細かい機微の必要な状況説明を未来から送ることができます。一方、視聴者は(従来であれば「どうせ録画なのでは」という気持ちで見ていたりもするところ)「ライブに主体的に参加している」という感覚が高まります。特に拍手に次ぐ拍手や、「🍹」「🍾」「💐」といった個々の特色あるギフトを通したコミュニケーションなど、出演者の表情やライブの一体感といった雰囲気作りに大きな貢献がありました。

会場となったミュージックバー「REAL DIVA'S」さんもこの機能を使いこなしており、たくさんの「💐」が届いたら実際の花束を送ったり、といった演出に使われておりました。ありがたいことです。

CEDEC2021での発表を終えて

こちらにCEDEC2021での発表『VibeShare: コロナ禍の音楽ライブを「触覚」で双方向化する』の発表動画を共有します(10分 - https://youtu.be/PYjqzAwMlts)。

インタラクティブセッションでの採択だったので発表時間は10分と短かったのですが、発表の後にZoomを使って聴講者のみなさんとの交流がありました。会場には他大学の博士の学生さんがいらっしゃったようで、後ほど白井先生経由でご挨拶いただきました。昨年のCEDECはインタラクティブセッションに採択されていたのに、セッション自体が消滅してしまったので、オンライン・ハイブリッドのデモを作り続けていることが結実して本当によかったな…と思いました。

なお最後の方に最新のデモである「VibeShare::Maptop」についても紹介することができました。こちらはXRメタバース時代のUXや価値を誰もが体感できるような研究で、森ビル「キッズワークショップ2021」において実証実験を行っています。こちらについてはまたの機会に紹介したいと思います。

おわりに

今回は触覚ライブエンタメの未来的なUX開発を、実際に稼働しているミュージックバー「REAL DIVA'S」さんのオンラインライブで実証実験するという、貴重な機会をいただくことができました。そのおかげで VibeShare のテーマである、『配信者と視聴者のあいだにある非言語エモーションを共有する』を、実際のオンラインライブ出演者とご参加いただいた視聴者さんとともに共有・確認することができました。

触覚の応用研究はどうしても、新しい体験が得られる素晴らしい装置を開発した、という方向になりがちです。作っていて楽しいですし、学会などのデモで体験者の良い反応が得られるので、その気持ちは凄くよく分かります。一方で、その触覚技術を商用に応用しようと試みた取り組みが非常に少ないのが残念であるとも感じています。

その点、企業内研究所である GREE VR Studio Laboratory では、本エントリのような「まだ実用化に至っていないが、将来必要となる技術をどう実用化できるよう開発していくか?」というまさにReseachからDevelopmentへの道筋におけるPoCやPoVを実践することができます。何か大学の研究で「この研究は面白いけど、どうすれば実用化できるのだろう...?」という悩みをお持ちの方は、ぜひ GREE VR Studio Laboratory までご相談ください。

最後に、実証実験にご協力いただいたヒビノ株式会社様に、この場を借りてお礼申し上げます。ご協力いただいたそれぞれの演奏者さん、小野ひとみさん、MoMo.さん、渡辺かおるさん、寿司ドミナントさん、ヒビノ関係者の皆さん、ご視聴いただいたみなさん、キャンパスクリエイトさん本当にありがとうございました。

また、2021年9月12〜14日に開催される第26回バーチャルリアリティ学会大会(日本VR学会)では、「VibeShare::Performer---Emoji・触覚・音効によるオンライン音楽ライブの双方向化」と題して口頭発表およびデモを行いますので、学術研究分野の方はぜひ見に来てください!このnoteをみて質問を持っていただけた人も歓迎です!

まとめ:Director白井より

「REALITYはバーチャルライブ配信アプリだけかと思ったらこんな研究もしているのか…」と興味を持っていただけたら幸いです。コロナ禍の六本木での実証実験は大変ではありましたが、バーチャルだけでなく、リアルな音楽の現場に若いラボメンバーを関わらせるのはなかなかに学びのある機会でした。なにより、ヒビノさんの音響技術は素晴らしい。YouTube番組の音質も一見の(一聴)価値ありですし、現場のモニタースピーカーや音響さん音効さんのお仕事、艶のあるミュージックバーでの音楽に命の輝きを奏でるお仕事のみなさんに一段とリスペクトがつのる日々でした。同時期に東京都「Upgrade with Tokyo」ピッチコンテストにおいて提言もさせていただきましたが、バーチャルライブ技術がリアルな音楽や芸術・芸能のお仕事の一助になればと考え技術の発信を続けております。

CEDECの発表に対するご感想も歓迎です。Twitter@VRStudioLabにメンションいただくか #CEDEC2021 ハッシュタグをつけていただければ幸いです。

また山崎さんのような長期のインターンはREALITYの中でも珍しい人材です。「触覚のエンタテイメント利用」という挑戦からXRメタバース時代のXR-UXの設計、開発に関わる垂直な研究開発をものすごいスピードで行っています。また産学連携や企業間コラボレーション、オープンイノベーション、学生インターンも随時ご相談受け付けております。まだ名前がついていない分野の研究を推進する気概がある方、いっしょに掘り下げてみませんか!