Unityチョットワカル高校生だった僕がメタバースの研究所で学んだこと

REALITY株式会社GREE VR Studio Laboratory(ラボ)の活動を紹介するインターンレポートです。今回はUnity開発者として活躍するやはぎさんに筆を執ってもらいました。

イベント「VRSionUp!」で発掘される

VRSionUp!はLabが主催しているイベントで、VR時代の未来をひらく若い才能の支援発掘や育成を推進してきました。コロナ前から活発なミートアップを開催し、オンライン・オフライン含め既に13回実施してきました。

私がLabに参加したのはこのVRSionUp!がきっかけでした。VTuberが流行り始めた頃、当時高校生だった私はVRに興味を持ち様々なイベントに参加していました。第4回のVRSionUp!4「VRエンタメxEdu」(2019/05/17)に参加した私は、当時自分が作っていたアプリについてLTしたり、悩んでいた進路について白井さんに相談に乗ってもらったりしていました。その後Labの先輩である山崎さんが開発していた「VibeShare」のデモ用の実験アプリ開発に参加し、そのプロジェクトの終了後に「Labでインターンしないか?」とお誘いいただきました。

SIGGRAPH ASIA 2022 Daeguで発表!

去年の12月、韓国の大邱(テグ)で行われたSIGGRAPH ASIA 2022に研究を投稿し、採択され、発表してきました。

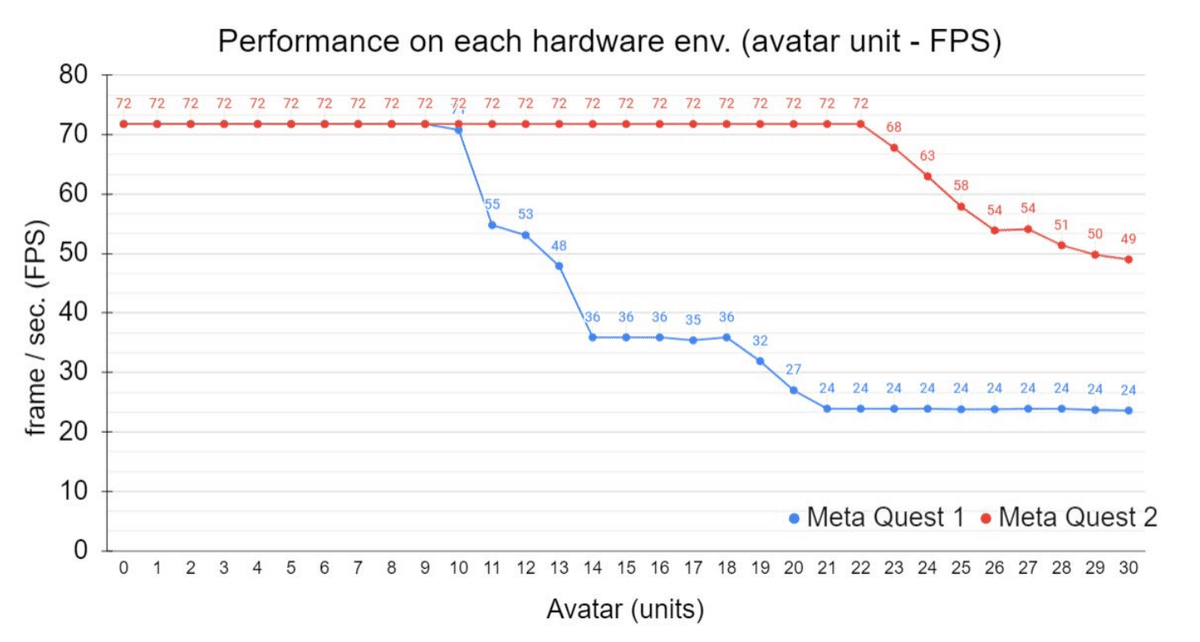

このPosterでは「Cross-platforming “School life metaverse'' user experience」というタイトルで、実用的なメタバース世界をベンチマークするために、ティーンエイジャー向けの身近な学校生活「Metaver-School」をメタバース上で体験してもらう、という手法を提案しています。REALITYはスマートフォンを基盤としたメタバースですが、将来の延長線上として互換性をもったルックやUXで、PCVRやMeta Quest1,2などのスタンドアロンHMD、これらを両方使えるクロスプラットフォームなメタバースを作るには、どのような要素が必要なのかを提案し、実験しました。REALITYのアバターで平均3万ポリゴン前後、マテリアルが6〜14個のアバターを使いQuest1,Quest2で同時にアバターをレンダリングしたときのFPSの変化を計測しました。

Quest1だと10人程度表示した段階で60FPSを下回り、20人表示すると30FPSを下回ります。またQuest2では22人を表示するまでは72FPSを維持し、それを超えるとFPSが低下していきます。実際にはステージやエフェクトなどもあるのでそれによる負荷を考慮する必要もあります。

また完成したデモンストレーションとして、Metaver-School上で複数人が同時にリアルタイムで参加できる音楽体験を提案しています。「AI Fusion」というシステムをラボのメンバーと開発し、MIDIファイルから生成されたモーションとモーションキャプチャーから取得できるデータを合成することによってMetaver-Schoolでの自然な演奏表現を実現することが可能になりました。

実際にMetaver-Schoolを作って検証し、同時接続数が4人程度であれば多様なアバターやエフェクトを使った音楽体験をユーザーに提供ができることがわかりました。

会場ではPosterが展示されており、コアタイム中はPosterの前で解説をしながら実際に作成したMetaver-Schoolのデモを行いました。多くの人に参加してもらいメタバース上での音楽演奏を体験してもらいました。デモ中は現地のメンバーだけではなく日本に居るLabメンバーと協力会社のGONBEEE_projectさんに参加してもらい、日本から軽音部のバンドメンバーになってもらいました。言葉が通じない参加者の方々も、手を振ると仲良くなり、1曲3分の体験が何回も続く、という現象を発見できました(この内容は、6月に開催される別の国際会議 IEEE MetaCom2023にフルペーパー採択されています!)。

自分自身として、初のメイン著者&英語論文でめちゃくちゃ大変でした。2021年に行われていたSIGGRAPH ASIA TOKYOには参加していたので、なんとなく空気感はわかっていたのですが、そもそも海外にいったことが無かったので驚きの連続の毎日でした。

SIGGRAPHでは様々な論文発表を聴講しました。一番興味があったのはMetaのReality Labsが発表していたHMDと2つのハンドルコントローラだけで全身の運動をシミュレートする強化学習フレーム枠についてのプレゼンテーション「QuestSim: Human Motion Tracking from Sparse Sensors with Simulated Avatars」です。

現地にいった食レポです。めちゃくちゃ店員さんが優しくてご飯も美味しかったので夜ご飯に2回も行きました。鍋めちゃくちゃ美味しいです。メタバースを通じて知り合った現地韓国の友達ともリアルで出会うことができ、非常に密度の高いメタバース研究開発として最高の時間を過ごすことができました。

Meta Dreamers - UXDev

Labでは2021〜2022年にかけて、毎クォーター毎にUXDevシリーズとしてREALITYの「未来のUX」を探究することを目的としてYoutube上で動画を公開してきました。公開した中で2作目となるMeta Dreamersは僕の中では一番印象に残っている作品です。

ちょうど自分自身もコロナ禍でリモート授業が続くなかでの制作だったので、メタバース上でみんなとバンドしたりするのは現実感がありエモいですね。

その他

上記以外にも直近ではLabで出展したフランスで行われるLaval Virtual用のMetaverse Mode Makerの開発や、その他のUXDevシリーズの開発、。昨年夏に行われたキッズワークショップ、やGREE Tech Conferenceへの登壇など様々な活動を行いました。

[mmm] Metaverse Mode Maker | GREE VR Studio Laboratory

最後のプロジェクトとしては、生成AI系の新プロジェクトをお手伝いしています。これは「MetaChatNews」という形のショートフィルムとしてYouTubeで観れる形になっていますのでぜひみてください!

さいごに

高校4年目の冬頃から学部3年目になる2年半の間に凄まじいスピードでVR/AR, VTuberのコンテンツは発達してきました。2021年12月から2年半ほどGREE VR Studio Labratoryで開発アシスタントのインターンをしてきましたが、その波に遅れないように自分なりに様々な技術をインプットしてUXDevシリーズの開発を行ってきました。研究開発という少し特殊な立ち位置で、普通のインターンでは経験できない論文の執筆や特許の出願なども行いました。SIGGRAPH ASIAのPosterに投稿できたことが一つのゴールになりました。LabのDirectorである白井さん、REALITYのエンジニアの皆さん、知財チームの皆さんには大変お世話になりました!REALITYでの経験を活かしてこれからも「なりたい自分」になれるように、進路を開拓していきますね。

やはぎさんありがとうございました!