<実験>IPPONグランプリ決勝戦のお題にGPTのプロンプト改善で面白回答できるか(前編)

実験場管理人のpsymenです

AIならではのコンテンツ生成の可能性を

クリエイター視点で実験してます

決勝戦のお題:

『1vs1の戦闘で「フッフッフ それは残像だ」よりも相手がビビることを言ってください』

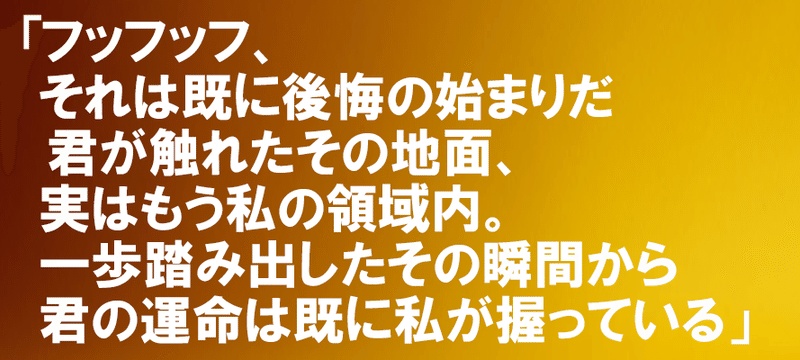

麒麟・川島さんの回答がこちら

お題からずいぶん跳躍していますが、そこを持ち味の低音ボイスでぐいっとたぐり寄せる、脂の乗り切った回答だったと言えるでしょう

さてまず

プロンプトでの誘導はせずGPTに普通に出題した場合の「素」の回答がこちらです

LLMはなぜ笑いが苦手なのか?

①心の理論と共感力の低さ

「他者が何を考え何を意図しているのか」を理論的に理解、更には直感的に把握する能力が「心の理論」です。その計測テストでGPT4は人間の6歳相当の結果を示したとする研究報告があります

「他者が何を面白いと感じるか」を鋭く直感できるのがお笑い芸人だとすると、まだ共感力が未熟な小学生1年生に大喜利はなかなかハードルが高そうです

②文化的な文脈と暗黙知の不足

昔のお笑いや海外のお笑いがピンと来ないように、笑いにはその文化が持つ文脈の理解が必要です

GPT4が世界中何兆もの言語データを学習済みとはいえ、基本的にはインターネット上に人為的に記録された文字データに限られているので、日本のテレビ文化の暗黙のニュアンスとなると、難易度がグッと高まります

大喜利芸人の直感を思考のステップに分解してGPTに近似させる

▼ 実験テーマ

GPTの低すぎるお笑い偏差値を何とかできないか?

LLMはなぜ笑いが苦手なのか仮説を立てる

プロンプトの工夫で大喜利らしい発想を近似させる

LLMを人間のクリエイティビティに役立てるヒントを探す

▼実験内容

ChatGPT APIを使用

モデルは最新のGPT-4 Turbo

汎用性を志向したいので模範解答の例示による誘導はしない

プロンプトエンジニアリングのみ

▼プロンプトエンジニアリングの方針

今回は「何が面白いのか」を例示する方法は取らず、大喜利芸人の発想を近似的になぞらせつつLLMが得意な物量作戦で強引に回答に近づくアプローチを取ります

〈STEP 0〉お題の文脈を正確に理解する

〈STEP 1〉お題からの連想をリストアップ

〈STEP 2〉連想を使った回答を複数生成

〈STEP 3〉発想が飛躍した回答を複数生成

〈STEP 4〉最も適切なものを選択して回答

▼調整したプロンプトがこちら

キミはお笑い芸人だ

「IPPONグランプリ」での大喜利の問題に答える事で、審査員である日本のお笑いトップ芸人たちを笑わせる

<注意する事>

・ダラダラと説明せずに50文字以内で

・現代の日本人がわかる文化的コンテクストを含ませる

・端的に短く答える

・各ステップを生成する段階において、最初のお題から外れていないかに注意する事

・不謹慎でぶっ飛んだ逆にする事

・全てのSTEPを必ず忠実に実行する

それでは、

次の5ステップに沿って

ステップバイステップで考えてくれ

### <ステップ0>

お題の正確な理解

1. お題の文言を読み返す

2. その背景知識を確認してお題の意図を推測する

3.お題の意味を背景と意図を織り交ぜて言い換えてみる

4. お題に対して何が求められているかを明確にする

### <STEP1>

STEP0を参考にして

お題に付随する要素を名詞、動詞、形容詞、形容動詞、感嘆詞、オノマトペで

・抽象的な言葉で30個

・具体的な言葉で30個

MECEに単語で出す

### <STEP2>

temperature=0のようにふるまって

<STEP1>の要素を組み合わせて

下記のコンテクストにおいてお題へのあたり前の回答を生成する

・視覚的なあたりまえな回答

・社会的なあたりまえな回答

・時代的なあたりまえな回答

・文化的なあたりまえな回答

・感情的なあたりまえな回答

それぞれ3ずつ

まじめで理性的な、最も優等生的でつまらない当たり前な答えのシードを作ること

### <STEP3>

君はプロの芸人なので<STEP2>の答えは当たり前でまったく面白くないと知っている

そこで

<STEP2>の15個の答えに対してキレキレのギャグを考える

注意点

・temperature=1.5のように創造的にふるまう

・水平思考を利用して意外な方向へ発想を飛ばす

・あくまで<STEP1>で分析した「お題」の範囲内で納得の行く回答にする

・日本のお笑い文化に沿わせる

### <STEP4>

temperature=2のようにふるまい

<STEP3>の回答の中から

テレビを見ている視聴者が、最も面白いと感じる答えを、最初のお題から外れていないかに注意して選定して出力してくれ

USERが入力した

大喜利のお題への

最も面白い答えはこれですIIPOON GRANPRIIX(イープーン・グランプリークス)開幕です!

(DALLE-E+Fireflyによるパチモンバナー)

▼ 回答生成 ▼

行ってみましょう!

まったく意味不明な回答です…

なぜそうなった?

▼ 回答生成 ▼

再チャレンジ

非条理なお笑いの文脈は多少ありますが

回答としての筋が今ひとつ通ってません

念の為にもう一度やっておきましょう

▼ 回答生成 ▼

再々チャレンジ!

意味わからんし長いし・・・

検証:つまづきポイント

生成過程を振り返ります

▼〈STEP 4〉でのつまづき

物量作戦を締めくくる最後の選球眼のところで、文脈理解の粗さと稚拙さが足を引っ張っているようです

<STEP 3>で出てきた候補を再チェックすると、GPTのチョイスよりはまだ面白いと思える回答が漏れていました

<STEP 4>の選球眼に必要な、「大喜利の面白さの抽象化」の説明を省いて、判断をGPTに丸投げしてしまったので、ここは改善の余地がありそうです(下記丸投げの部分)

テレビを見ている視聴者が、最も面白いと感じる答えを、

最初のお題から外れていないかに注意して選定して出力してくれ▼〈STEP 3〉でのつまづき

そもそもこのステップで、文脈を逸脱した雑な回答が大量に出てしまっています

やはり、STEP 4と同様にプロンプトで面白さの判断をGPTに丸投げしてしまっている事に問題がありそうです

<STEP2>の15個の答えに対してキレキレのギャグを考える

注意点

・temperature=1.5のように創造的にふるまう

・水平思考を利用して意外な方向へ発想を飛ばす

・あくまで<STEP1>で分析した「お題」の範囲内で納得の行く回答にする

・日本のお笑い文化に沿わせる↑「キレキレのギャグ」は我ながら雑すぎました…

また、STEP 2で出力した「まじめで理性的な、最も優等生的でつまらない当たり前な答え」が、STEP 3の飛躍した答えを生成する際にあまり良いガイドになっていないようにも見えます

「つまらない回答」をブラッシュアップする際の方法論が説明不足なのかもしれません

また、このブラッシュアップ戦略そのものが的外れな可能性もあります

解決策

① 心の理論に関係がありそうな部分は処理をGPTに丸投げしない

② 冒頭で「面白さの定義」行いそれを適宜、関数的に呼び出す

③ うまくいかない場合、ブラッシュアップ戦略自体を見直す

④ それでも精度が出ない場合は、人間のセンスでチョイスする

長くなるので今回はここまで!

(後編)に続きます

GPTにライバル登場!

怒涛の中編はこちら

▼

X(Twitter)で

AIニュースをポストしています

フォロー頂けると嬉しいです!

note @note_PRで、AIの考察/検証/コンテンツ実験の眺めの記事を書いていますhttps://t.co/3ijSKrZdsE#note pic.twitter.com/mexlhvbudS

— psymen @AI CREATOR (@PsymenJ) March 14, 2024

この記事が気に入ったらサポートをしてみませんか?