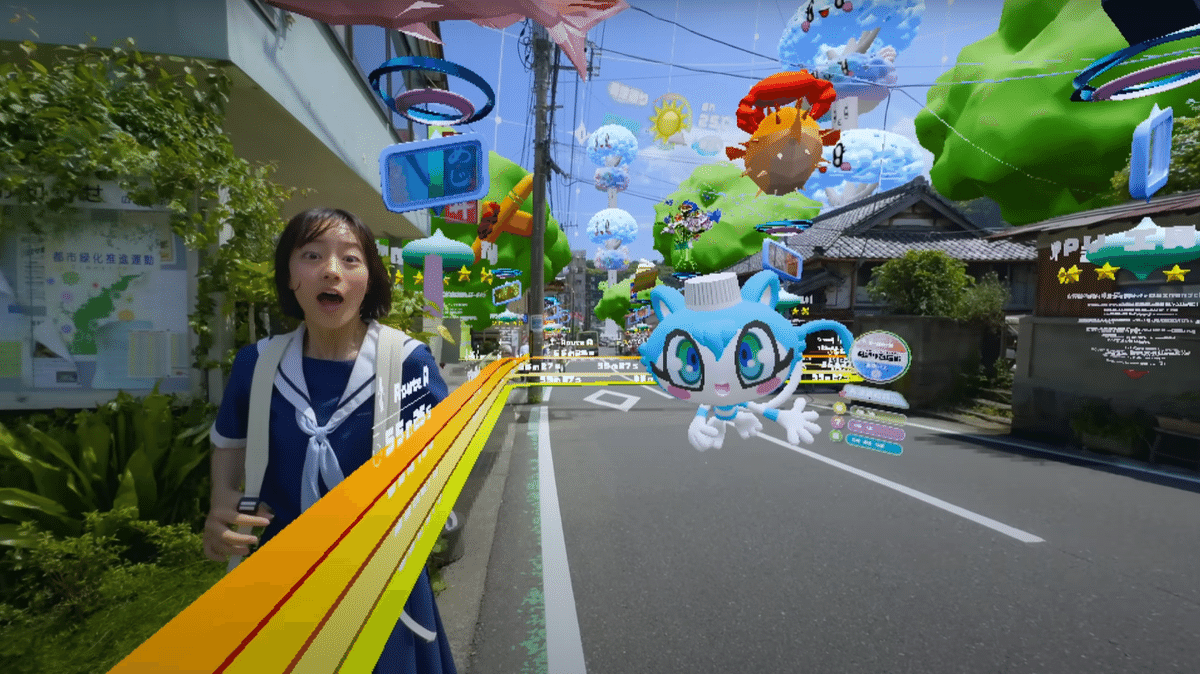

ポカリスエットのCM「潜在能力は君の中。」篇 が良かったのでAR的な視点で分析してみた

先日公開されてたポカリのCM、メチャ良い。

AR・MRの文脈でもこれだけの素材を組み合わせつつ走り抜けた例ってないのでは、と思います。(あったら教えてください)

事前情報

撮影にはQuest3とiPhoneを使われているそうです。Questでは一人称視点の動画がとれるかチェックしたんでしょうか。

2022年ぶり4度目の

— SHOW YANAGISAWA (@SHOWyanagisawa) July 12, 2024

ポカリCM監督しました☀️🎮☁️

Test by Meta Quest 3

Shot by iPhone

Outdoor AR App by Basqule Inc.🏃♂️

pic.twitter.com/MCYbDZLPFQ

システム制作はBasquleです。最近Apple Vision Proを使った無限チューチュートレインでも話題になった会社さんです。ARの技術を使ってることが確定。

ポカリスエットの新CM「潜在能力は君の中。」篇が公開。

— Bascule Inc. - Project Design Studio (@Bascule_Inc) July 12, 2024

バスキュールは「山道を全力で走る高校生を、ARを重ねながらワンカット撮影したい!」という柳沢監督の想いに応えて「全力疾走対応型ARシステム」を開発しました。pic.twitter.com/H1INomLhqN#潜在能力は君の中 #ポカリスエット #ポカリ潜在能力

そしてツリーを見ると色々な会社さんが関わっているそう。

今回は@BASSDRUM_orgさん、@fabrica_incさんという最強のAR開発チームを組成。バスキュールメンバーは@katapadがXRテックリード、@buccchiがそのサポート、@kampeiがクリエイティブの意向をチームに翻訳する役割を担いました。

— Bascule Inc. - Project Design Studio (@Bascule_Inc) July 12, 2024

「全力疾走対応型ARシステム」の技術ベースについて考える

一番気になるのは、どうやって位置合わせしてるかです。

アプリVPSで、ここまでの広範囲を位置合わせするのはGeospatial APIか、Immersalか、になるでしょう。組み合わせてるかもしれないですが。

他にパッと思いついたのが

ARKit Location Anchorsと、Lightship VPSですがどちらも難しそう。

それぞれ簡単に解説

Gospatial API:Googleが出しているVPS機能。ストリートビューのデータをベースにVPSで使えるように加工し、位置合わせをしている。事前スキャンが不要なので超便利だが、反面ストリートビューがないところ(公園の中や田舎道)では無力。Googleが出しているけどiPhoneでも普通に使える。

最近、Geospatial Creatorというのを出して機能拡張しておりARの作成が簡単になりつつある

Immersal:Immersalが出しているVPS。事前のスキャンが必要なものの、うまく使うと都市丸ごとをスキャンしたりできる。このCMレベルの広さだと事前スキャンが物凄く大変

ARKit Location Anchors:Appleが出しているVPSの機能。使えるのが一部の都市に限られる。精度は良さそう。iPhone専用。

Lightship VPS:Nianticが出しているVPS。幅広い端末で使える、かつ、事前にスキャンデータが公開されていればスキャンなしで使える。モニュメントなどの1スポットを対象とするため広範囲でのVPSは不可。

CMを見てみる

特に映像は素人なのでご容赦ください。

バスが通り過ぎる~裏手の階段まで

冒頭のバスが通り過ぎるところ地味に凄くないですか?ちゃんと表示がバスに追従しているように見える。人や物に対するオクルージョンが効いてないので、結果的にそう見えるというだけだと思うんですが、その発想があったかとおもいました。

リアルの看板がHAPPY工務店なのもちょっと面白い。バスの青波高校行ってどういう事だろうと思ったらポカリCMの舞台が青波高校で統一されてるんですね。

あとバスを逃したと分かるや即座に徒歩ルート出したり、「次何分?」って言った時にマスコットが時刻表っぽいのだしてて、多分パーソナライズされたAIなんだろうな~と思いました。

よく見るとこのAI、先々で裏道に行かないように頑張って誘導してる。

この辺で面白いのが視線を向けてからオブジェクトが表示されているところ。さっきのガイドAIがリアルタイム生成してるっぽさがあります。

技術的には、時間で表示を決めているのか、カメラを特定の位置に向けた時に表示させているのかは気になります。撮影なのでがっちり時間や角度を決めてると思います。どっちでもできそう。

万人が体験するような物だったらカメラを特定のオブジェクトに対して向けたら表示にすると思います。

広場のオブジェクトのごちゃごちゃ感がハイパーリアリティっぽくて面白いですよね。でもあんまり殺伐としてない。

通り道にはオブジェクトが無いので中心が遮られないのと、やっぱりモチーフがポップだったり丸かったりするのが大きいんでしょうかね。

この網の所はQuestの境界線っぽくて好き。多分ここから先がAIの案内出来ない領域=裏道なんだろうな。

Geospatial APIの担当もここまでだったりして……スローで再生すると微妙にぶれたりしてるのでやっぱりARなんだな、それも広域に出すVPSなんだなって思います。

裏道~水がかかりそうになるところ

ここからは先ほどのごちゃっと感が一気に薄れて、野生のARみたいなのと対面していきます。

茂みを抜けている最中にGeospatial APIの領域外に出てて、Immersalでの位置合わせに切り替わってますとかでも驚かないぜ。

ちなみに、ここから先はオクルージョンが効いているのもあり、iPhoneのLiDARがフル活用されていそうです。

今までは広いところしか映してないので遮蔽の描写が無かった+冒頭で人物や車もオクルージョンの対象になってなかったなぁと思い。途中でAR Occlusion Managerの切り替えをしているのかなぁ……

壁からぬっと出てくるのも面白いです。目を向けた瞬間にオブジェクトを出しています。(またはオブジェクトが出るタイミングに合わせてカメラを向けています。)

水がかかるところおもろいですよね。AIでよく見る物体識別みたいになってる。

ほぼ固有名詞レベルでめちゃくちゃ識別してますが、人物にはラベルがかかってないので、AR的な実世界の理解ではなく、ロードしたデータをラベリングするみたいな形で使ってそう。

よくみるとVPSの位置合わせ用の粒子みたいなのも表示していて、水がかかった事で、再起動みたいなことをしているっぽいです。

鏡~疲れるところ

鏡~!どうやってるんだ。本物っぽい。明らかに周囲のオクルージョンが効いています。

で、よく見たら2枚目の鏡で肩に何か白いものが載ってるので、(ただの光の反射な気もしますが)もしかしたら2人で撮影してたとかじゃなくて、どこかで肩にiPhone載せて走っていた?と思いました。

ひょっとしたら壁からぬっと出てくるのに触れようと立ち止まった時とか。そんな一瞬で違和感なく出来るんかな……

ただ、鏡だけ妙に画質が荒い気もするので、別取りのを合成してるとか、鏡っぽいモニターだったとかでも分からなくはない。ここまでARにしておいてそれをするかという話ですが……

ちなみに鏡はLiDARの光も反射するので、3Dスキャンの時などは要注意なのですが(鏡の向こうの世界が出来てしまう)、オクルージョンは出来るんだなぁと思いました。

そして言われて気づいたんですが、ここから先、一部がフォトグラメトリで生成されたメッシュになっています。

位置があまりにも綺麗にあうので、同じ場所をスキャンしたんじゃないかなぁと思いました。季節が違うとか、手入れする前のを撮っておいたとかそんな感じかと。

最後に3人称視点になってからはARの出番はなさそうです。一瞬花びらがARかと思いましたが違いそう。

以上、大変楽しいCMでした。間違ってたり見逃してたりする所があったらコメントください。

ポカリはメイキングも出ることがあるので、これも出てほしいなぁ。

この記事が気に入ったらサポートをしてみませんか?