DCEXPO2023講演「クリエイティブAIとAIDXが拓く新市場 - メタバース・放送・メディアアートのその先に」シンギュラリティについての考察補足

長い間お世話になったDCEXPOへの恩返しと思って作った講演

「クリエイティブAIとAIDXが拓く新市場 - メタバース・放送・メディアアートのその先に」AICU白井暁彦

おかげさまで満席御礼でした

どなたも最後の最後まで真剣にご聴講いただき感謝です

60分で150ページ越え資料公開しました!

ご感想いただければ幸いです

さっそくスライド公開しました!

講演資料公開しました!

— Dr.(Shirai)Hakase しらいはかせCEO 技術書典15え06 (@o_ob) November 15, 2023

ご聴講ご感想ありがとうございます

「クリエイティブAIとAIDXが拓く新市場 - メタバース・放送・メディアアートのその先に」#DCEXPO2023 #interbee2023 https://t.co/8io9eDzRgl pic.twitter.com/zotn9jLEwT

講演内容から抜粋・補足

PDF版ダウンロードはこちら

https://hubs.ly/Q028Z-Sn0

シンギュラリティについての考察補足

ちょうど昨日、デジハリ大で開催された「AI Bricolage Session -私たちはAIをどう捉えるのか-」終了後、三宅陽一郎先生と神田明神をお参りしながら、シンギュラリティが来ているのかどうかについて考えを交わさせたりさせていただきました。

いままでもシンギュラリティについては何度かポエムを書いてきましたが、今日はもう少し真面目に経済のモデルでアプローチしてみようと思います。

「シンギュラリティ」とは「特異点」、もともとは物理学や数学の用語。「通常の範囲を逸脱した地点」を意味していて、例えばブラックホールの中心には見かけの体積がゼロなのに質量が無限大となる特異点があるとされています。

三宅陽一郎先生の講演の中でも扱われていた「Gossen's First Law」(ゴッセンズ・ファースト・ロー)、第一法則は「ある財の消費量を1単位増加させたときの効用(満足度)の増加分は目減りしていく」という話。このへんはミクロ経済学などをかじると出てくる(専門ではないです)。

ぼくの今回の講演中でも軽く補完しているのですが、こういう「感覚の単位」というのは似たようなモデルがあります。知覚心理学や心理物理学でもこういう刺激に対する感覚の目減りは「ウェーバー・フェヒナーの法則」が代表的で、人間の感覚量は、受ける刺激の強さの「対数に比例する」というもので、人間の五感への中程度の刺激に対しては、良い近似となることが知られています。

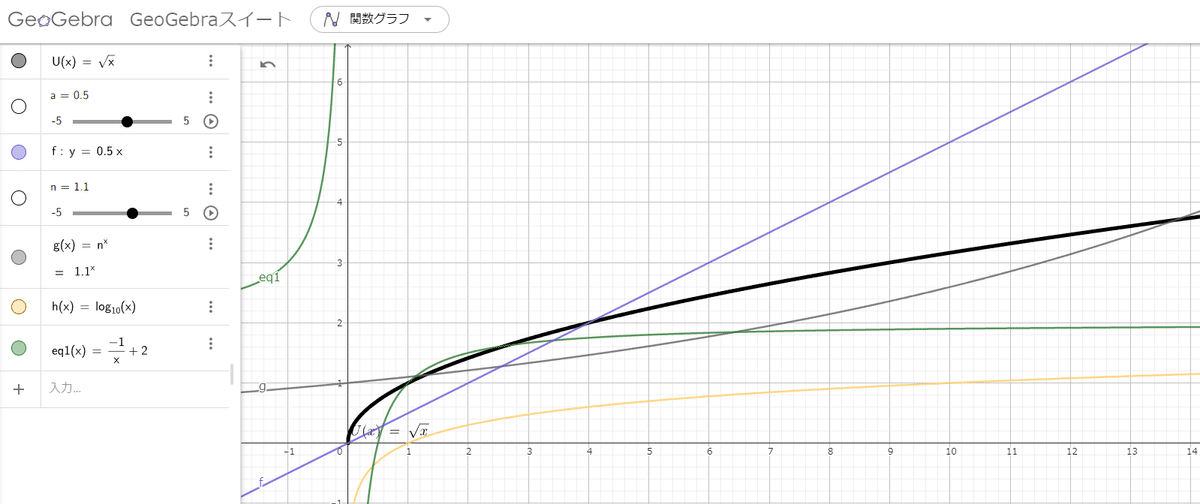

Δx/xなどで書いてもいいのですが、GeoGebraでは効用関数は√xで表現できます。比較のために y=ax や y =n^x を並べてみます。

図の中では y = 0.5x つまりこれは、1年で投じられる「労働力✖️資本」を控えめに0.5だけ積み上げていったリニアなモデルです。総投資額と置き換えて読んでもいいでしょう。図中では紫色の線で表現しています。

グレーの線はカーツワイルが提唱した「収穫加速の法則」(The Law of Accelerating Returns)、「技術は直線的(Linear)ではなく、指数関数的(Exponential)に進化する」というモデルに沿った描画です。指数関数的でわかりやすいところで1.3を設定しています。

たとえばこの係数を控えめに、y = 1.1^x とすると、こんなかんじに緩やかになり、より初期状態の混乱がわかりやすくなります。

拡大するとこんな感じです。

この場合は1年目は技術の進歩はほとんど変化なしです。総投資1に対して2倍の1.0の効果が得られています。2年目は総投資2に対して1.4の効果が得られていますが、3年目、総投資3に対して1.75、そろそろ投資対効果0.5程度のリニアをかろうじて上回る程度になり、4年目には総投資4に対して効果が2、つまり y = 0.5x に追いつかれます。技術の進歩が緩やかであればまだまだ効果が上回るように見えますが、これは「数字を増減させても指数関数的な進化は、初めは緩やかで変化が感じられないが、ある点(つまり特異点)を迎えると、一気に人知の及ばないところに行ってしまう」、というシンギュラリティのモデルそのものを体感させます。技術の進化が緩やかなうちは投資対効果は得られるが、技術の進化速度や経年成長が対数的になってくると効用はほぼない中で資本投下を続ける事になる、とも読めます。もともとの予測では「シンギュラリティが来るのは2045年」です。先の説明ではシンギュラリティの「特異点」はほぼ垂直のあたりであると解説していますが、このリニアモデルと指数モデルのクロスポイントは数年内にやってくるという感覚があります。大事なのは世間の「モデルの捉え方」です。

この辺は短い時間の講演では最大限配慮して「資本を投じても効果は低減していく(驚き屋)」と表現していますが、「驚き屋」とは、いわゆる「これはすごい」と驚いてみせることで大した事ない進化にも興奮気味に扱うTwitter構文のことです。ChatGPTの使いこなしを切り口にした情報商材系のアオリに使われることが多く、社内のインフルエンサーさんにも無自覚にこういう構文を使う方がいらっしゃいますが、その「驚き」はどんどん効果が目減りしていきます。

そもそも「技術に対する驚き」は懐疑的に見たほうがいいこともあります。例えば「3Dディスプレイ」や「ヘッドマウントディスプレイ」といったデバイス先行型のエンタテインメント機器ブームというのは旧来、驚きを絵にしてきた傾向がありますが、そもそも驚きたいからハードウェア・メディアを買うという構造には無理があります。びっくり箱というのは中がわからないからびっくり箱なので「驚くことがわかっているなら開けない」という方々も多くいらっしゃいます。ホラーゲームやローラーコースターが好きな人だけが買う、しかも多くの人は「2回は買わない」ということを認識しなければなりません。

HMDのようなコンシューマエンタテインメントなら時間消費が目的になるのですが、ChatGPTに代表される生成AIの驚きは「こんな事ができるのか!」という驚きや、それによって「これで仕事をスマートに終わらせることが出来るのでは」という期待によるものです。再度、限界効用逓減の法則に立ち戻ってみます。

効用関数のモデル、すなわち投じられた刺激や労働力・資本・経過年数は指数関数どころかリニアにも追いつくことができなくなるという運命があります。

今回の効用関数は√xで近似していますが、いちおう他のモデルも試してみています。

黄色は y = log(x)、緑は y = -1/x のモデルです(例えるなら"人減らし")。比較するリニアのモデルの傾きにもよりますが、投資に対して上回るのは緑、黄色は何年もかかって徐々には上がっていきます。緑は最初は投資に対して上回るのですが数年以内に成長が目減りして、その後は漸近線 y = 2 に沿って収束していきます。最初の数年だけ投資に対する効果は評価できるが、つまりこれは何年・何人投じても「絶対に目標には到達しない」という恐ろしいモデルです。…が、ITの世界にはときどきこういうプロジェクトはあるような感じもあります。技術負債のようなものでしょうか。

今回の講演では、あえて技術の進化である指数関数を横に並べて、総投資額にあたるリニアも並べて効用関数を置いています。

このモデル比較は、味わい深いです。

効用関数の逓減は、論文を読んでいるとOpenAIによる「Scaling Laws for Neural Language Models」のように、対数レベルでのパラメータ数、演算能力の増加でLLMの学習効率が上がる、といったLLM側の通説もありますが、一方ではユーザ側である人間の組織を含めた刺激や資本投下に対する効用の特性について考える機会を与えてくれます。

構成員がきちんと指数関数モデルで成長する技術を指数関数で学習することで、確実に差が広がっていきます。この図の例では効用関数のモデルを意識しつつ、組織の大小に関わらず、構成員が仮に前年度比1.3倍で学ぶ(この場合、生成AI技術の進化成長についていくだけの話)ということを繰り返すだけで、大きな差がついていきます。最初の1年目でギリギリ追いつけるかどうかの効用関数が、2,3,4年目はほぼ変わらずですが、その後は数倍の差がついていき、取り戻せない差になっていきます。

このモデルをどう自分事にして読むか

これを例えば「大学での学びの4年間」とか「生成AIに否定的な部署での4年間」というように当てはめてみてください。仮に大学のカリキュラムや組織の方針で「生成AIは怖い」「不要」「ChatGPTは禁止」と言われてしまったとして、そのせいにして生成AIに関する勉強をしなかったとしたら…?最初の1年目は特に差はなく、世間は驚きに対する認知はだんだん鈍っていくことでしょう。しかし、数年後、自分が学ばなかったことを「誰かのせいに」したとしても、取り戻せないような差がついてしまいます。当然、数年後にはもっと便利なツールが出てきているのかもしれませんが、そのスキルや理解の差を簡単に埋められる時代が来るのであれば、前年度比1.1倍もしくは1.01倍でもいいのできちんと技術の進化に対して丁寧に学ぶ姿勢や文化風土を維持するほうが良い効果が期待できることは明確です。

なので「つくるひとをつくる」ワークショップなどが重要であるというお話になります。これは各国でも共通で、手応えを感じています。

つまり、技術的特異点(シンギュラリティ)とは…

GenerativeAIはCreativeAIとは違う。効率化や人減らし(1/xモデル)ではなく、1.1倍でいいので「人を育てる」という視点を持ちましょう。

そんなさなかに発表された

Japanese Stable CLIP

ちょうどこの「シンギュラリティのモデル比較」や「StabilityAIのオープンなモデルの価値」の説明に取り組んでいたときです。

さすがnpakaさん夕方にはサンプルコードを書いていらっしゃいます

こんな風に、ちょっとでもいいのでコードを書いて、遊んでみる。

そんな習慣が「尊い業務外」であり、日々その習慣を作ることが投資に見合う実力であり、明日を乗り越えていく企業風土であるということを体感しています。

なおサムアルトマンは講演の中で「短いタイムラインでゆっくりと離陸する」と発言しています。これはChatGPTのシンギュラリティは指数関数ではあるがその係数は飛行機の離陸、つまり 係数が小さな値の指数関数か、 y = log (x) のようなモデルではないかなと(勝手に)推測しています。少なくともロケット打ち上げのようなモデルやステップ関数ではないということ。

まあこうやって経済のモデルというのはいつも検証が追いつかないのですが、たまにモデルと実際の体感を比べてみるというのは大事ですね。

皆さんの感想もお聞かせいただければ幸いです。

そして告知された「東京AI祭」

最新の話題の告知としてはこちらです「東京AI祭」。

今回の講演内でリリースさせていただきました「#東京AI祭」を生成AIの国際科学コミュニケーター的にお手伝いします!

資料アクセスしやすいようにしました

お気軽に覗いてみて下さい〜

https://hubs.ly/Q028N9230

3/23-24の渋谷駅前

画像生成&LLM大好きな人たちや興味ある方々に届け🥳

交遊録

World VTuber Showcaseを共同開催した思い出

現在はほんの少しの差にしか見えないけれど、楽しみを持ちながら自ら手を動かしてプレイヤーとなり、前年比1.1倍でも自分を成長させることが、この指数関数的なストリームラインの変化についていく大事な姿勢である。これはあとからリニアな投資を続けたとしても、絶対についていけない大きな隔たりを作り出す可能性がある。電車に乗り遅れて、次の電車に乗ったとしても、同じ駅にたどり着けるわけではない。おもちゃを楽しみながらいこう。

Although the difference now appears to be only a small one, the important attitude to keep up with this exponential change in streamlines is to have fun, become a player by working with your own hands, and develop yourself even by a factor of 1.1 over the previous year. This can create a huge gap that you will never be able to keep up with even if you continue to invest linearly later on. If you miss a train and take the next one, you will never get to the same station. Enjoy your toys.

30年前、工芸大学時代からの友人です

新作イラスト

singularity train

この記事が気に入ったらサポートをしてみませんか?