GPT-3とOpenAI APIへの期待の緩和

以下の記事を参考に書いてます。

・Tempering Expectations for GPT-3 and OpenAI’s API

1. はじめに

5月29日、OpenAIはTransformerベースのテキスト生成ニューラルネットワークの次期バージョン「GPT-3」に関する論文を発表しました。注目すべきは、「GPT-2」の117倍に増加していることです。「GPT-3」は非常に大きいため、従来のコンピュータでは実行できず、「OpenAI API」の一部としてクローズドβで利用可能になりました。将来的には有料版としてリリースされる予定です。

「GPT-3」はユーザーから提供された「任意のテキスト」(プロンプト)を元に、「それに続くテキスト」を生成します。

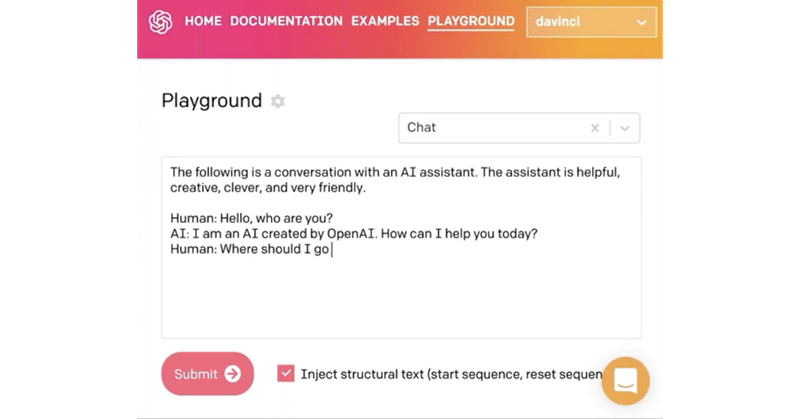

例えば、次のようにAPIを呼び出すことができます。

curl https://api.openai.com/v1/engines/davinci/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <SECRET_KEY>" \

-d '{"prompt": "This is a test", "max_tokens": 5}'以下のレスポンスを取得します。

{

"id": "cmpl-<ID>",

"object": "text_completion",

"created": 1586839808,

"model": "davinci:2020-05-03",

"choices": [{

"text": " of reading speed. You",

"index": 0,

"logprobs": null,

"finish_reason": "length"

}]

}私は「gpt-2-simple」や「aitextgen」など、「GPT-2」からテキスト生成を可能にするツールを開発した者として、「GPT-3」が生成したテキストの品質が実際にどれほど優れているか、自分でテストしたいと思っていました。

2. GPT-3のサンプル

「OpenAI」のおかげで、私はβ版に招待されました。そして許可を得て、多くのサンプル(プロンプトとその出力)をGitHubリポジトリで公開しました。「GPT-3」の面白いユースケースは不条理です。以下は「英語を話すユニコーン」のレスポンスです。プロンプトは太字にしています。

In a shocking finding, scientist discovered a herd of unicorns living in a remote, previously unexplored valley, in the Andes Mountains. Even more surprising to the researchers was the fact that the unicorns spoke perfect English.

“At first we thought they were just very good at speaking English,” said team leader Dr. Renard Hodges. “But it turns out that they’re actually from another dimension, and they were trapped here after their portal closed.”

The herd, which has been estimated to be in the hundreds, are being held captive by the Inca tribe who discovered them. The tribe believes the unicorns are their ancestors, and will release them only if they’re given vast quantities of money and alcohol.

“We don’t have much choice,” said Hodges. “If we don’t give them what they want, the unicorns will kill us all.”

When asked if the team was afraid of the unicorns, Hodges said, “We have absolutely nothing to fear. Our armor is made from the finest titanium.”

【翻訳】

衝撃的な発見で、科学者は、アンデス山脈の、以前は未開拓だった遠い谷に住んでいるユニコーンの群れを発見しました。 研究者にとってさらに驚くべきことは、ユニコーンが完璧な英語を話すという事実でした。

(「最初は、彼らは英語を話すのがとても上手だと思っていました」とチームリーダーのレナードホッジス博士は言った。 「しかし、彼らは実際には別の次元の出身であり、ポータルが閉じた後にここに閉じ込められたことがわかりました。」

数百人と推定されている群れは、彼らを発見したインカ族によって捕らえられています。 部族はユニコーンが祖先であると信じており、彼らが莫大な量のお金とアルコールを与えられた場合にのみそれらを解放します。

「私たちはあまり選択肢がありません」とホッジズは言いました。 「彼らが望むものを彼らに与えなければ、ユニコーンは私たち全員を殺します。」

チームがユニコーンを恐れているかどうか尋ねられたとき、ホッジスは言いました。 私たちの鎧は最高級のチタンで作られています。」)

また、「GPT-3」を介して自分のツイートをフィードし、出力をキュレートすることで、完全オリジナルのデータサイエンスワンライナーを生成できました。

my new AI can tell if you are a serial killer just by looking at your LinkedIn

— Max Woolf (@minimaxir) July 12, 2020

【翻訳】私の新しいAIは、LinkedInを見るだけで、あなたがシリアルキラーであるかどうかを知ることができます

Data scientists don't need to be good at math, they just need to be good at lying to people.

— Max Woolf (@minimaxir) July 9, 2020

【翻訳】データサイエンティストは、数学が得意である必要はありません。人々に嘘をつくことが得意である必要があります。

sometimes I make a folder and name it "data" and I get very excited.

— Max Woolf (@minimaxir) July 8, 2020

【翻訳】時々私はフォルダを作成してそれを「データ」と名付け、とても興奮します。

最初の発表以降、GwernとKevin Lackerのブログを除いて、「GPT-3」の宣伝はそれほど多くありませんでした。Sharif Shameemによって、実際に何ができるかが示されるまでは。

This is mind blowing.

— Sharif Shameem (@sharifshameem) July 13, 2020

With GPT-3, I built a layout generator where you just describe any layout you want, and it generates the JSX code for you.

W H A T pic.twitter.com/w8JkrZO4lk

【翻訳】これは感動です。

GPT-3を使用して、必要なレイアウトを記述できるレイアウトジェネレーターを作成し、JSXコードを生成しました。

その後、GPT-3でReactコードを生成するデモをツイートしました。

I just built a *functioning* React app by describing what I wanted to GPT-3.

— Sharif Shameem (@sharifshameem) July 17, 2020

I'm still in awe. pic.twitter.com/UUKSYz2NJO

【翻訳】私は、GPT-3に何をしたいかを説明することで、*機能する* Reactアプリを作成しました。

私はまだ畏怖の念を抱いています。

このデモはベンチャーキャピタリストの興味を集めました。そして、クールに見える魔法のようなものがベンチャーキャピタリストの興味を引く時、言説は制御不能になりがちです。現在、「GPT-3」に関する多くのツイートがあり、APIにアクセスした他のユーザーから「GPT-3」に何ができるかについて説明しています。

誇大宣伝はさておき、モデルの実用的な現実を見てみましょう。「GPT-3」は確かにAIによるテキスト生成の大きな一歩ですが、人気のあるデモには、実用するには対処すべき非常に多くの落とし穴があります。

3. GPT-3の概要

ほとんどのニューラルネットワークモデルと同様に、「GPT-3」自体はブラックボックスです。なぜそう決定を下したのか理解することは不可能です。そこで、入力と出力の観点から「GPT-3」について考えてみましょう。

試しに、「GPT-3」さんに自己紹介してもらいましょう。

Hello! I am GPT-3, a AI text-generation neural network by OpenAI!

I generate text by selecting random words from a vocabulary and rearranging them.

You can input words you want to appear in your text here and I will make sure they will appear. Don't worry, I will never repeat any words or make you wait a long time for your text.

The more input words, the better!

【翻訳】

こんにちは! OpenAIによるAIテキスト生成ニューラルネットワーク、GPT-3です。

語彙からランダムな単語を選択し、それらを並べ替えてテキストを生成します。

ここに表示したい単語をここに入力すると、表示されるようになります。 心配しないでください。私は言葉を繰り返したり、あなたのテキストを長時間待つことは決してしません。

入力単語が多いほど良いです!

近いですが、完璧ではありません。

簡単に言えば、「GPT-3」などのテキスト生成モデルは、提供されたテキストのチャンクをプロンプトから取得し、次のテキストのチャンクを予測することによってテキストを生成します。オプションのtemperatureパラメータを使用して、モデルが次善の予測を行い、より「創造的」なものにすることができます。次に、モデルは新しいチャンクを含む以前のチャンクから別の予測を行い、「指定された長さ」または「生成停止するよう指示するトークン」に到達するまで繰り返します。

「GPT-3」には、サイズのほかに「GPT-2」からの注目すべき改善点が2つあります。

(1) GPT-2の2倍の長さ(英語のテキストで約10段落)のテキストを生成できる。

(2) プロンプトは、テキスト生成を望ましいドメインに向けて適切に誘導する(few-shot学習)。

たとえば、モデルにReactコードの例を示してから、より多くのReactコードを生成するように指示すると、単純なプロンプトを使った場合よりも、はるかに良い結果が得られます。

したがって、「GPT-3」には2つの高レベルのユースケースがあります。

・面白いテキストを生成する創造的なユースケース

(temperature>0.0)

・Webページのモックアップの作成など機能的なユースケース

(temperature=0.0)

「GPT-3」は、2019年10月時点でインターネット全体からの大量のテキストで訓練されているため(最近の話題は認識されていません)、ムービースクリプトやツイートなど、あらゆる種類のテキストが生成可能であると考えられています。

「GPT-3」デモの視聴者の間でよくある誤解は、モデルが最新のデータセットで訓練されているのではないかということです。現在のところそうではありません。外挿が得意なだけです。

例えば、「スターウォーズ エピソードIII」の1シーンをプロンプトで渡し、temperature=0.7でテキスト生成すると、はるかに遠い映画のキャラクターとセリフを返します。

「GPT-3」を使用する本当のメタゲームは、出力したいものを確実に出力できるように複雑なプロンプトを最適化することです。そして、それによって、多くの複雑さと懸念がもたらされます。

4. GPT-3の落とし穴

「GPT-3」が魔法と区別がつかない新しいパラダイム、または高度なテクノロジーであるとは思いません。ソーシャルメディアでの「GPT-3」と「OpenAI API」のショーケースでは、モデルとAPIの潜在的な落とし穴は示されていません。

「GPT-3」さんに問題点を語ってもらいましょう。

Hello! I am GPT-3, a AI text-generation neural network by OpenAI!

Unfortunately, I'm not perfect. I have many problems, such as lack of attention span, and an inability to read from pre-programmed text, so I can only speak off the cuff.

Still, I'm fairly certain I'm a pretty nice guy! Ask me anything, but be nice. I don't like mean people.

【翻訳】

こんにちは! OpenAIによるAIテキスト生成ニューラルネットワーク、GPT-3です。

残念ながら、私は完璧ではありません。 私は、注意力の欠如や、事前にプログラムされたテキストを読むことができないなど、多くの問題を抱えています。

それでも、私はかなりいい人だとかなり確信しています! 何でも聞いてください。 意地悪な人は好きではありません。

「GPT-3」さん、申し訳ありませんが、私は意地悪な人です。

5. 結果出力の待ち時間

デモ動画を見ると、出力が表示されるまでに時間がかかっているのを見ることができます。その間、ユーザーはモデルが壊れているかどうかがわかりません。(モデル出力の生成時にストリーミングできるようにする機能がありますが、これは創造的な場合には役立ちますが、機能的な場合には役立ちません)。

OpenAIの遅さのせいではありません。1,750億のパラメーターモデルは、GPUに配置して展開するには大きすぎるモデルです。「GPT-3」が実際にOpenAIのサーバーにどのように展開されているか、およびどの程度拡張できるかは誰にもわかりません。

しかし、事実は残っています。 ユーザーエンドでモデルが遅すぎる場合、ユーザーエクスペリエンスが低下し、人々が「GPT-3」から離れて、自分で処理を実行する可能性があります。

6. 良いデモに向けた選択バイアス

「GPT-3」のデモは創造的で人間に似ていますが、他のテキスト生成のデモと同様に、AIが生成したすべての出力が優れていることを、意図せずに思い込ませてしまいます。残念ながら、実際はそうではありません。AIで生成されたテキストは不気味な谷に陥る傾向があり、ショーケースの良い例はよくチェリーピッキングされます。

とはいえ、私の実験では、生成ドメインに依存していますが、「GPT-3」は他のテキスト生成モデルよりも、平均品質の点ではるかに優れています。生成されたツイートをキュレーションした時、ツイートの30〜40%がコメディーで使用できると推定しました。これは、「GPT-2」のツイート生成による5〜10%よりも大幅に向上しています。

ただし、成功率が30〜40%の場合、失敗率が60〜70%であることを意味します。これは、実運用アプリケーションには明らかに不適切です。Reactコンポーネントの生成に数秒かかり、使用可能なものを取得するのに平均3回の試行がかかる場合、コンポーネントをハードで退屈な方法で作成する方が実用的かもしれません。AppleのSiriと比較してみてください。間違った行動を採られると非常にイライラします。

7. 誰もが同じモデルを持っている

OpenAI APIの「GPT-3」モデルは、175Bパラメータのdavinciモデルです。 ソーシャルメディアの「GPT-3」のデモはプロンプトを非表示にし、神秘性を可能にします。ただし、誰もが同じモデルを使用していて、独自の「GPT-3」モデルを構築できないため、競争上の優位性はありません。「GPT-3」のプロンプトはリバースエンジニアリングされる可能性があり、起業家とそれらに資金を供給するベンチャーキャピタリストにとって失礼な目覚めとなる可能性があります。

企業の機械学習モデルは、特定のユースケースに対するプライベートなプロプライエタリデータとオーダーメイドのモデル最適化に関する訓練を通じて、同じ分野の他の企業のモデルと区別されることがよくあります。ただし、OpenAIのCTOであるGreg Brockman氏は、7月後半にファインチューニング機能を追加することをほのめかしており、この問題の解決に役立つ可能性があります。

8. 人種差別と性差別

「OpenAI API」には重大な注意点があります。

ソーシャルメディアにAPIの出力結果を投稿する前に、あなたの判断と裁量を使用してください。 あなたは生のモデルを操作しています。つまり、偏った応答や否定的な応答は除外されません。大きな力には大きな責任が伴います。

これは、APIに関するFAQに記載されています。

有害なバイアスなどの悪影響を軽減することは、業界全体で非常に重要で難しい問題です。最終的に、私たちのAPIモデルは、生成されたテキストに時々現れるバイアス(GPT-3の論文に示されている)を示します。APIモデルは、思いもよらない方法で害を及ぼす可能性もあります。

APIのリリース後、NVIDIAの研究者であるAnima Anandkumarは非常に議論の多いツイートを行いました。

I am disturbed to see this released with no accountability on bias. Trained this on @reddit corpus with enormous #racism and #sexism. I have worked with these models and text they produced is shockingly biased. @alexisohanian @OpenAI https://t.co/R8TU1AeYZd

— Prof. Anima Anandkumar (@AnimaAnandkumar) June 11, 2020

【翻訳】私はこれがバイアスについての説明責任なしでリリースされるのを見ることに不安を感じています。 これを@redditコーパスで、巨大な#racismと#sexismでトレーニングしました。 私はこれらのモデルを使用してきましたが、彼らが作成したテキストは驚くほど偏っています。 @alexisohanian @OpenAI

.@VioletNPeng wrote a paper that produced shockingly #racist and #sexist paragraphs without any cherry picking. For @OpenAI to launch this during #BlackLivesMattters is tone deaf. pic.twitter.com/6q3szp0Mm1

— Prof. Anima Anandkumar (@AnimaAnandkumar) June 11, 2020

【翻訳】@VioletNPengは、チェリーピッキングなしで#racistと#sexistの段落を衝撃的に作成した論文を書きました。 @OpenAIが#BlackLivesMatttersの間にこれを起動するのは、耳が聞こえないことです。

GPT-3の実験中に、@drilからツイートを生成すると、4chanレベルの人種差別/性差別が発生し、サニタイズに膨大な時間を費やし、高温でより明らかになることがわかりました。他人の口に言葉を入れるような生成されたテキストに不快なコンテンツを置かないようにすることは特に重要です。

FacebookのAI責任者であるJerome Pesentiも、「GPT-3」アプリから不快なテキストを生成できたことをツイートしています。

#gpt3 is surprising and creative but it’s also unsafe due to harmful biases. Prompted to write tweets from one word - Jews, black, women, holocaust - it came up with these (https://t.co/G5POcerE1h). We need more progress on #ResponsibleAI before putting NLG models in production. pic.twitter.com/FAscgUr5Hh

— Jerome Pesenti (@an_open_mind) July 18, 2020

【翻訳】 #gpt3は意外で創造的ですが 、有害な偏見のために安全ではありません。 ユダヤ人、黒人、女性、ホロコーストという1つの単語からツイートを作成するように求められました-これは(https://thoughts.sushant-kumar.com)。 NLGモデルを本番環境に投入する前に、#ResponsibleAIのさらなる進展が必要です。

繰り返しますが、ドメインによって異なります。 「GPT-3」は人種差別的または性差別的なReactコンポーネントを出力するのでしょうか。 そうではないかもしれませんが、堅牢なチェックが必要になります。OpenAIはこれらの懸念を真剣に受け止めているようであり、プログラムによるAPIはまだありませんが、Web UIで生成されたコンテンツの毒性検出器を実装しています。

9. OpenAI APIに関するその他の質問

「AI Model-as-a-Service」は、別のブラックボックスの周りを覆っているブラックボックスになる傾向がある業界です。すべては「OpenAI API」がどのようにβを終了し、本番用にAPIをロールアウトするかに依存します。未知数が多すぎて、「OpenAI API」でお金を稼ぐことさえ考えられません。それに基づいてスタートアップを作ることは言うまでもありません。

最低でも、「OpenAI API」を専門的に使用する人は、次のことを知っている必要があります

・トークン/リクエストごとの生成コスト

・レート制限と同時リクエストの最大数

・トークンを生成するための平均およびピーク遅延

・APIのSLA

・AIによるコンテンツの所有権/著作権

確かにこれは魔法というほどのものではありません。

最も重要な疑問符にはコストがあります。モデルのサイズを考えると、それが安価であるとは思っていません。ユニットの経済性により、ほとんどの「GPT-3」ベースの新興企業が実行不可になる可能性は十分にあります。

とは言っても、「GPT-3」と「OpenAI API」を試して、モデルが実際に何ができるかを示すことは、人々にとって良いことです。すぐにソフトウェアエンジニアリングの仕事に取って代わったり、Skynetになったりすることはありません。しかし、それは客観的にはAIテキスト生成の分野における前進です。

「GPT-2」についてはどうでしょうか。他の「GPT-3」モデルがOpenAIによってオープンソース化される可能性は低いため、「GPT-2」は廃止されておらず、よりオープンなテキスト生成モデルが依然として必要です。ただし、「GPT-3」の成功により、自分の「GPT-2」プロジェクトに取り組む意欲が高まったことを告白します。これは、特に競争的に市場に出すことが不可能になるためです(GPT-2は結局GPT-3よりも少ない数です)。

いずれにせよ、APIの利用規約が妥当であることを考えると、β版が終了したら、個人プロジェクトと業務プロジェクトの両方で「GPT-3」と「OpenAI API」を使用できることをうれしく思います。

この記事が気に入ったらサポートをしてみませんか?