Google Colab で Orion-14B を試す

「Google Colab」で「Orion-14B」を試したので、まとめました。

1. Orion-14B

「Orion-14B」は、「OrionStarAI」が開発したオープンソースの多言語大規模言語モデルです。ベースモデルは、中国語、英語、日本語、韓国語などを含む2.5T多言語コーパスで学習しており、これらの言語で優れたパフォーマンスを発揮します。

・ベースモデルは20Bのモデル内で総合評価において優れた性能を発揮。

・日本語と韓国語のテストで大幅に優れたパフォーマンスを発揮。

・ロングチャット版は200kのトークン長で非常に優れたパフォーマンスを発揮し、最大320kまでサポート可能。

・量子化版は、モデルサイズが70%削減され、推論速度が30%向上し、パフォーマンス損失は1%未満。

2. Orion-14B のモデル

「Orion-14B」は、7つのモデルが提供されています。

・OrionStarAI/Orion-14B-Base : ベースモデル

・OrionStarAI/Orion-14B-Chat : チャットモデル

・OrionStarAI/Orion-14B-LongChat : ロングチャットモデル

・OrionStarAI/Orion-14B-Chat-RAG : RAGモデル

・OrionStarAI/Orion-14B-Chat-Plugin : Plugin・Function Callingモデル

・OrionStarAI/Orion-14B-Base-Int4 : 4bit量子化ベースモデル

・OrionStarAI/Orion-14B-Chat-Int4 : 4bit量子化チャットモデル

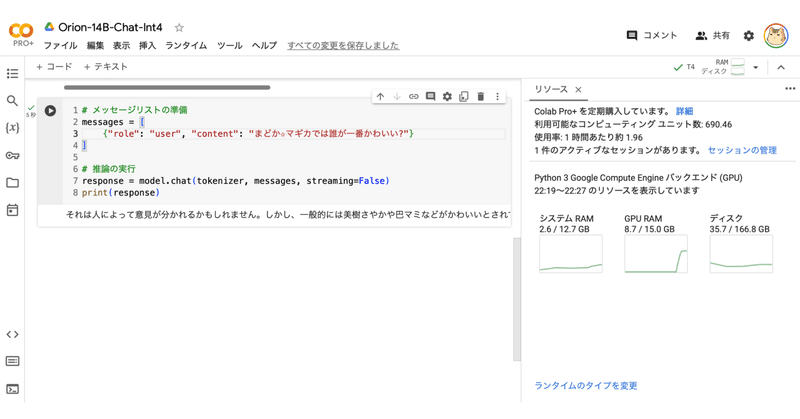

3. Colabでの実行

Colabでの実行手順は、次のとおりです。

(1) Colabのノートブックを開き、メニュー「編集 → ノートブックの設定」で「GPU」を選択。

(2) パッケージのインストール。

# パッケージのインストール

!pip install -U transformers accelerate bitsandbytes

!pip install -U sentencepiece flash_attn autoawq(2) トークナイザーとモデルの準備。

今回は、「OrionStarAI/Orion-14B-Chat-Int4」を使いました。

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

from transformers.generation.utils import GenerationConfig

# トークナイザーとモデルの準備

tokenizer = AutoTokenizer.from_pretrained(

"OrionStarAI/Orion-14B-Chat-Int4",

use_fast=False,

trust_remote_code=True

)

model = AutoModelForCausalLM.from_pretrained(

"OrionStarAI/Orion-14B-Chat-Int4",

device_map="auto",

torch_dtype=torch.bfloat16,

trust_remote_code=True

)

model.generation_config = GenerationConfig.from_pretrained(

"OrionStarAI/Orion-14B-Chat-Int4"

)(3) 推論の実行。

# メッセージリストの準備

messages = [

{"role": "user", "content": "まどか☆マギカでは誰が一番かわいい?"}

]

# 推論の実行

response = model.chat(tokenizer, messages, streaming=False)

print(response)それは人によって意見が別れるかもしれません。しかし、一般的には美樹さやか、巴マミなどがかわいいとされています。

関連

こんにちは、Orion 14Bを選んでいただきありがとうございます。ライセンスの申請はこのリンクから行えます:https://t.co/7coDipaF3f。現時点ではこのリンクは中英語のサポートがありますが、将来的には日本のユーザーが利用しやすいように日本語のバージョンも追加される予定です。

— OrionStarAI (@OrionStarAI) January 24, 2024

この記事が気に入ったらサポートをしてみませんか?