DepthAI 入門 (3) - コードサンプルと実験

「DepthAI」のコードサンプルと実験をまとめました。

前回

1. コードサンプル

「DepthAI」のコードサンプルは、以下で提供されています。

◎ シンプル

・RGB Preview : RGBカメラの小さなプレビューの表示。

・RGB video : RGBカメラの高解像度フレームの表示。

・Mono Preview : 左右のモノカメラの表示。

・Depth Preview : カラー化されたステレオ視差の表示。

・RGB Encoding : RGB(1080P、30FPS)を.h265にエンコードし、ホストに保存。

・RGB & Mono Encoding : RGB(1080P、30FPS)と両方のモノラルストリーム(720P、30FPS)を.h265 / .h264にエンコードし、ホストに保存。

・Encoding Max Limit : RGB(4k 25FPS)と両方のモノストリーム(720P、25FPS)を.h265 / .h264にエンコードし、ホストに保存。

・RGB Full Resolution Saver : フル解像度RGB画像(4k)をホストに保存(.jpeg)。

・Mono Full Resolution Saver : モノ画像(720P)をホストに保存(.png)。

・RGB & MobilenetSSD : RGBフレームでMobileNetSSDを実行し、フレームで検出を表示。

・RGB & MobileNetSSD @ 4K : 4K-RGBフレームでMobileNetSSDを実行し、プレビューフレームと4kフレームの両方で検出を表示。

・Mono & MobilenetSSD : モノフレームでMobileNetSSDを実行し、フレームに検出を表。

・Video & MobilenetSSD : ホストからのビデオでMobileNetSSDを実行。

・IMU Accelerometer & Gyroscope : 500Hzの加速度計とジャイロスコープ。

・IMU Rotation Vector : 400Hzの回転ベクトル。

◎ コンプレックス

・RGB Camera Control : ホストからRGBカメラ(トリミング、フォーカス、露出、感度)を制御する方法を示す。

・Mono Camera Control : ホストからモノカメラ(トリミング、露出、感度)を制御する方法を示す。

・Depth Crop Control : ホストからの深度フレームのトリミングを制御する方法を示す。

・Stereo Depth from host : ホストからのモノラル画像のセットからステレオ深度フレームを生成。

・Stereo Depth Video : 深度プレビューの拡張バージョン。

・RGB Rotate Warp : フレーム上で回転、ミラーリング、反転、遠近法変換を実行する方法を示す。

・RGB Depth : RGB深度フレームの表示。

・Auto Exposure on ROI : 選択したROIに基づいて自動露出を使用する方法を示す。

・Mono & MobilenetSSD & Depth : モノフレームでMobileNetSSDを実行し、モノ/ディスパリティフレームで検出を表示。

・RGB Encoding & MobilenetSSD : RRGBフレームでMobileNetSSDを実行し、FUll-HD RGBを.h265にエンコードして、ホストに保存。

・RGB Encoding & Mono & MobilenetSSD : モノラルフレームでMobileNetSSDを実行し、フレーム上で検出を表示します+ RGBを.h265にエンコード。

・RGB Encoding & Mono with MobilenetSSD & Depth : RGBエンコーディングとMono&MobilenetSSD&Depthコードサンプルの組み合わせ。

・RGB & TinyYoloV3 decoding on device : RGBフレームでYoloV3を実行し、フレームで検出を表示。

・RGB & TinyYoloV4 decoding on device : RGBフレームでYoloV4を実行し、フレームで検出を表示。

・Object tracker on RGB : RGBカメラからオブジェクトトラッキングを実行。

・Object tracker on video : ビデオからオブジェクトトラッキングを実行。

・Spatial location calculator : Spatial location calculatorの使い方を示す。

・Spatial object tracker on RGB : オブジェクトトラッキングを実行し、空間座標も提供。

・RGB & MobilenetSSD with spatial data : MobileNet検出と空間座標を含むRGBフレームを表示。

・Mono & MobilenetSSD with spatial data : MobileNet検出と空間座標を含むモノフレームを表示。

・RGB & TinyYolo with spatial data : Yolo検出と空間座標を含むRGBフレームを表示。

◎ ミックス

・System information : デバイスのシステム情報(メモリ/ CPU使用率、温度)を表示。

・OpenCV support : 画像フレームをOpenCVフレームとして取得する方法を示す。

・Device Queue Event : デバイスキューイベントの使用方法を示す。

・Queue add callback : キューコールバックの使用方法を示す。

・Calibration Flash v5 : バージョン5のキャリブレーションデータ(gen1キャリブレーションデータ)をデバイスにフラッシュする方法を示す。

・Calibration Flash : バージョン6のキャリブレーションデータ(gen2キャリブレーションデータ)をデバイスにフラッシュする方法を示す。

・Calibration Reader : XLinkを介してデバイスに保存されているキャリブレーションデータを読み取る方法を示す。

・Calibration Load : バージョン6のキャリブレーションデータ(gen2キャリブレーションデータ)をパイプラインにロードして使用する方法を示す。

2. 実験

「DepthAI」の実験は、以下で紹介されています。

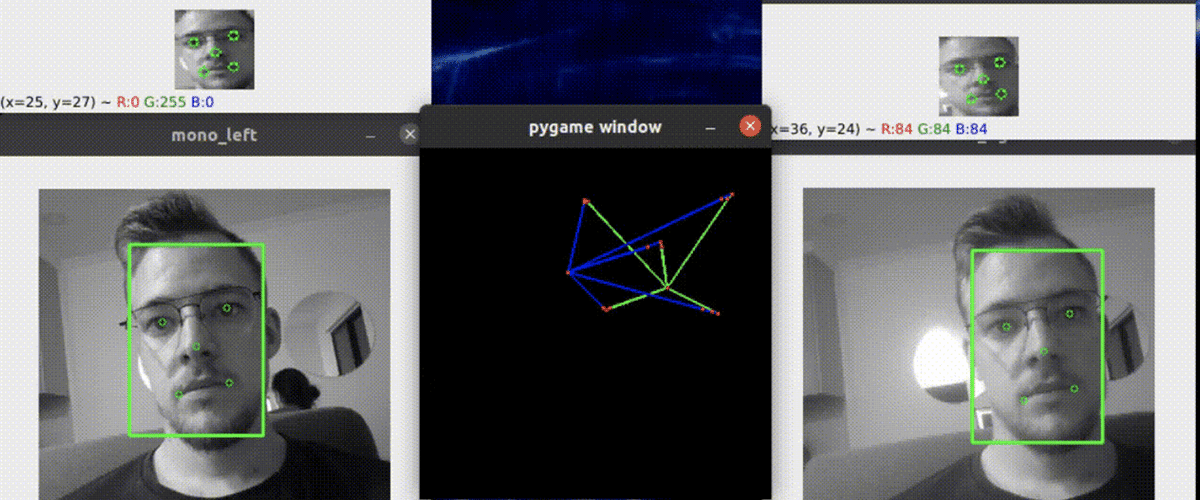

◎【Gen2】視線推定

視線を推定する例を示します。

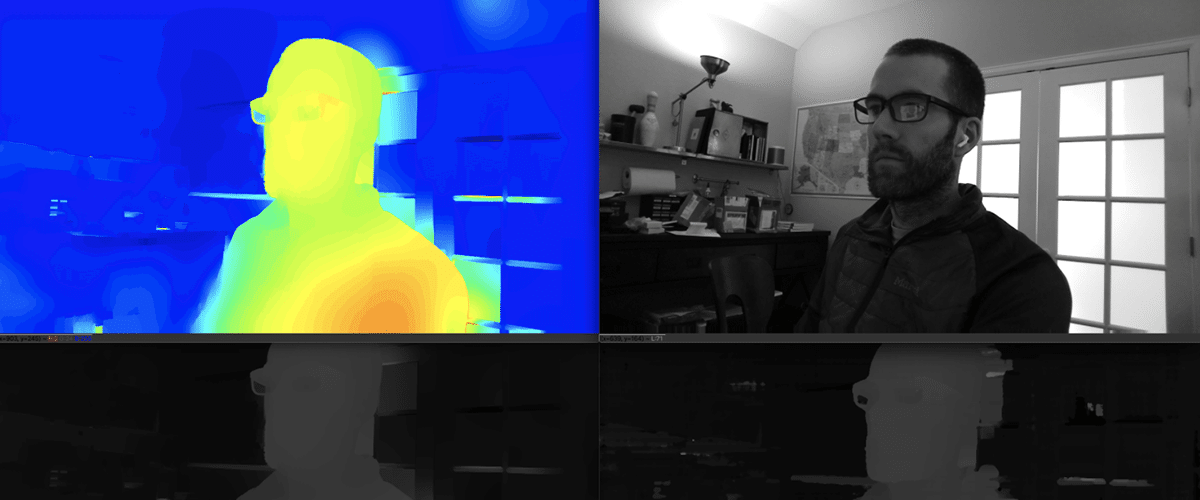

◎【Gen2】サブピクセルとLR視差の深度確認

サブピクセル、LRチェック、拡張視差を実行する方法と、これら測定値を視覚化のために点群に投影する方法を示します。

◎【Gen2】年齢性別認識

顔検出を行ってから、年齢と性別を推論する例を示します。

◎【Gen2】テキスト検出およびOCR

テキスト検出を行ってから、OCRを行う例を示します。

◎【Gen2】歩行者の識別

一意のIDを持つ歩行者を識別および再識別する方法を示します。

◎ マスク検出

マスクあり/マスクなしの物体検出を実行する方法を示します。

◎ ソーシャルディスタンス検出

オブジェクトの完全な3D位置からソーシャルディスタンスを検出する方法を示します。

◎ ステレオニューラル推論結果ビジュアライザー

ステレオニューラル推論結果のビジュアライザーの例を示します。

◎ 人数カウント

人数をカウントする例を示します。

◎ 人物トラッカー

人物をトラッキングする例を示します。

◎ 点群投影

点群を投影する例を示します。

◎ RGB-DおよびPCL

RGBと深度のストリームからRGBD画像を作成し、深度オーバーレイと点群を使用してRGBに投影する例を示します。

◎ ホスト側のWLSフィルタ

ホスト側のWLSフィルタリングの例を示します。

◎ 人間と機械の安全性の確認

ホスト上の手のひらの空間座標を計算し、手のひらと危険なオブジェクトの間の空間距離を計算する例を示します。

◎ ホストごとの複数のデバイスの使用

ホストごとに複数のデバイスを使用する方法を示します。

この記事が気に入ったらサポートをしてみませんか?