最近話題の マルチモーダルLLM まとめ

「GPT-4V」以降のマルチモーダルLLM (MLLM) についてまとめました。

前回

2023年

9月25日 GPT-4V

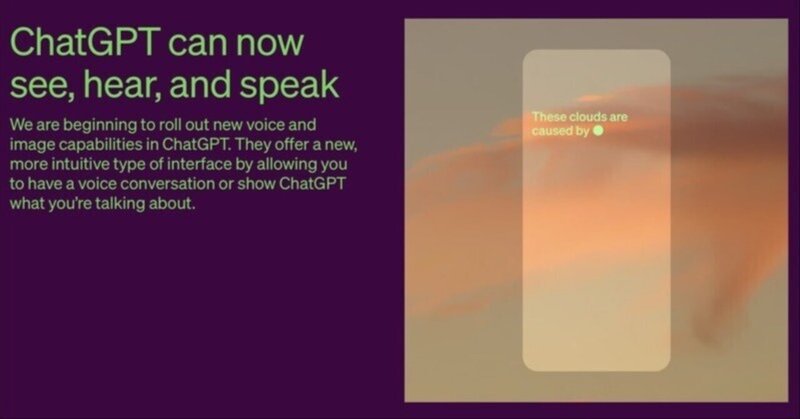

「GPT-4V」は、OpenAIが開発したマルチモーダルLLMです。

10月5日 LLaVA-1.5

ウィスコンシン大学とMicrosoftが開発したマルチモーダルLLMです。

10月11日 Ferret

「Ferret」は、Appleが開発したマルチモーダルLLMです。

10月14日 MiniGPT-v2

「MiniGPT-v2」は、キング・アブドラ科学技術大学(KAUST)とMetaが開発した様々な視覚言語タスクを統合インターフェイスで利用できるモデルです。

(1) Grounding: 画像 → 画像部分の説明+バウンディングボックス

(2) Refer: 画像+画像部分の指示 → バウンディングボックス

(3) Detection: 画像+画像部分の指示 → 画像部分の説明

(4) Identify: 画像+バウンディングボックス → 画像部分の説明

(5) VQA: 画像+質問 → 応答

(6) No Tag: タグなしのフリースタイル

10月14日 PaLI-3

「PaLI-3」は、Googleが開発したマルチモーダルLLMです。

10月15日 BaKLLaVA-1

「BaKLLaVA-1」は、「Skunkworks AI」が開発した「Mistral-7B」ベースのマルチモーダルLLMです。

11月13日 Japanese Stable VLM

関連

この記事が気に入ったらサポートをしてみませんか?