Mistral Large 2 の概要

以下の記事が面白かったので、簡単にまとめました。

1. Mistral Large 2

「Mistral Large 2」は、128kのコンテキストウィンドウがあり、フランス語、ドイツ語、スペイン語、イタリア語、ポルトガル語、アラビア語、ヒンディー語、ロシア語、中国語、日本語、韓国語など数十の言語と、Python、Java、C、C++、JavaScript、Bash など 80 以上のコーディング言語をサポートしています。

ロングコンテキストアプリを念頭に置いた単一ノード推論用に設計されています。123Bのパラメータサイズにより、単一ノードで大きなスループットで実行できます。研究および非商用目的での使用と変更が可能なMistral Research Licenseに基づいてリリースされています。「Mistral Large 2」を商用で使用して自己展開する必要がある場合は、Mistralに連絡して Mistral Commercial License を取得する必要があります。

2. 性能

2-1. 全般的な性能

「Mistral Large 2」は、MMLU では事前学習済みバージョンが 84.0% の精度を達成し、オープンモデルの性能/コストパレートの最前線に新たなポイントを設定しました。

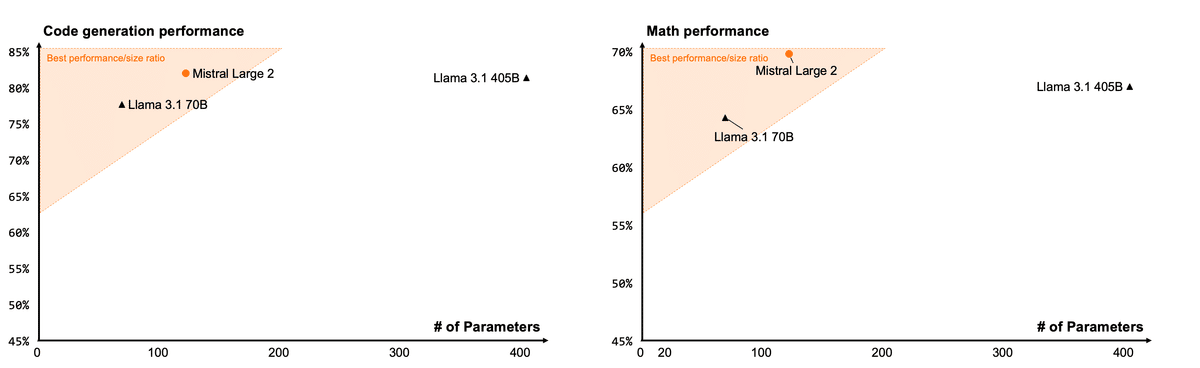

2-2. コードと推論

Codestral 22BとCodestral Mambaでの経験に続き、非常に大きな割合のコードに対して「Mistral Large 2」を学習しています。「Mistral Large 2」は以前の「Mistral Large」を大幅に上回り、「GPT-4o」「Claude 3 Opus」「Llama 3 405B」などの主要なモデルと同等の性能を発揮します。

モデルの推論能力を強化するためにも、多大な努力が費やされました。学習中の主な焦点の1つは、モデルが「ハルシネーション」を起こしたり、もっともらしく聞こえるが事実上正しくない、または無関係な情報を生成する傾向を最小限に抑えることでした。これは、モデルをより慎重かつ識別力のある応答に微調整し、信頼性が高く正確な出力を提供することで実現しました。

さらに、新しい「Mistral Large 2」は、解決策が見つからない場合や、確信を持って答えを出すのに十分な情報がない場合にそれを認識するように学習しています。この精度へのこだわりは、一般的な数学ベンチマークにおけるモデルの性能の向上に反映されており、推論と問題解決のスキルが向上していることが実証されています。

2-3. 指示の遵守と調整

「Mistral Large 2」の指示追従機能と会話機能が大幅に向上しました。正確な指示の追従と長い複数ターンの会話の処理が特に優れています。以下に、「MT-Bench」「Wild Bench」「Arena Hard」ベンチマークでの性能を示します。

一部のベンチマークでは、長い回答を生成するとスコアが向上する傾向があります。ただし、多くのビジネスアプリでは簡潔さが最も重要です。短いモデル生成により、より迅速な対話が可能になり、推論のコスト効率が向上します。そのため、可能な限り、生成が簡潔で要点を押さえたものになるように多大な労力を費やしました。以下のグラフは、「MT Bench」ベンチマークの質問に対するさまざまなモデルの世代の平均長さを示しています。

3. 言語の多様性

モデルの大半は英語中心ですが、新しい「Mistral Large 2」は、多言語データの大部分で学習しています。特に、英語、フランス語、ドイツ語、スペイン語、イタリア語、ポルトガル語、オランダ語、ロシア語、中国語、日本語、韓国語、アラビア語、ヒンディー語で優れています。以下は、多言語 MMLUベンチマークでの「Mistral Large 2」の性能結果です。以前の「Mistral Large」「Llama 3.1」、および「Command R+」と比較しています。

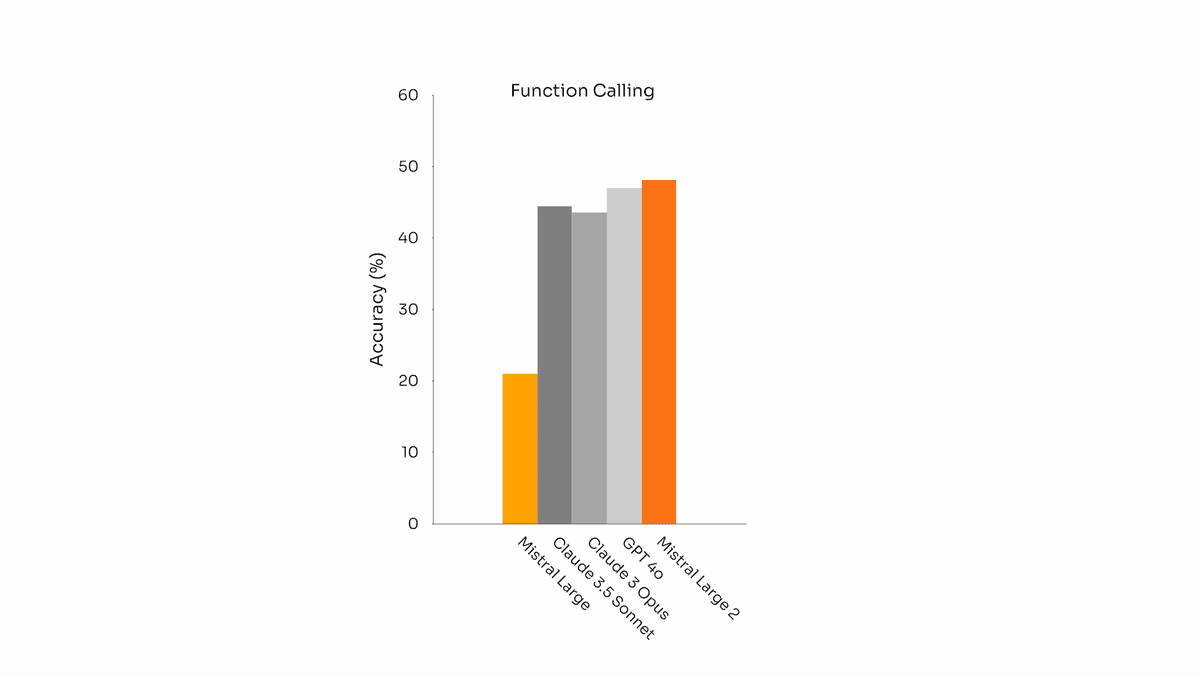

4. Function Calling

「Mistral Large 2」は、強化された「Function Calling」および取得スキルを備えており、並列および順次関数呼び出しを効率的に実行できるように学習されているため、複雑なビジネスアプリのパワー エンジンとして機能します。

5. Mistral Large 2 の使用

5-1. PlatformeとHuggingFace

「Mistral Large 2」は、現在、mistral-large-2407という名前でPlatformeから使用できます。instruct モデルの重みも利用可能で、HuggingFaceで公開されています。

Mistralでは「la Plateforme」での提供を、2つの汎用モデル (Mistral Nemo と Mistral Large) と2つの専門モデル (Codestral と Embed) に統合しています。「la Plateforme」の古いモデルは段階的に廃止されますが、すべての Apache モデル (Mistral 7B、Mixtral 8x7B および 8x22B、Codestral Mamba、Mathstral) は、引き続き、SDK mistral-inference および mistral-finetune を使用して展開およびファインチューニングできます。

本日より、「La Plateforme」のファインチューニング機能を拡張し、「Mistral Large」「Mistral Nemo」「Codestral」で利用できるようになりました。

5-2. クラウドサービスプロバイダー

本日は「Google Cloud Platform」との提携を拡大し、マネージドAPI を介してMistral AIのモデルをVertex AIに提供します。Mistral AIの最高のモデルは、「Azure AI Studio」「Amazon Bedrock」「IBM watsonx.ai」に加えて、「Vertex AI」でも利用できるようになりました。

この記事が気に入ったらサポートをしてみませんか?