☕️News: AppleがALSを持つ人々のために新しい音声機能を作成しました。

アップルは今年後半、iOS 17でのアクセシビリティアップデートの一環として、2つの新機能「Live Speech(ライブスピーチ)」と「Personal Voice(パーソナルボイス)」を正式に発表しました、

ALS(筋萎縮性側索硬化症)で生活している人々が直面するさまざまな課題の中に、その病気が彼らの話す能力に与える影響があります。

進行性の疾患によって喉や口の筋肉が弱まるため、話すことはますます難しくなり、はっきりと通常のペースで話す能力も低下します。ほとんどの患者はこれらの症状に対処しながら、最終的には話す能力を完全に失ってしまいます。

Appleは、ALSで生活している人々の個性的な声をデジタル化するために、Appleは最先端のAIを活用し、多くのリスニングを行いました。

ボイスバンキングとは?

自分自身のために話すことが問題になるとき、音声合成は重要なコミュニケーションツールです。家族や友人とのおしゃべりやカフェでのコーヒーの注文などに使用されます。ALSの人々は、自分自身の声のデジタル化バージョンを作成することで、このような事態に備えることができました。

これはボイスバンキングとして知られるプロセスです。ただし、ボイスバンキングはALSが話す能力にあまりにも大きな影響を与える前に行うのが最善ですが、これは困難で、時には費用がかかり、先延ばしにしてしまう誘惑がありました。

ALSに特化した非営利団体の理事であるPhilip Green氏は、FastCoに対して、ボイスバンキングには数週間かかったと話しました。4年前、Philip Greenが声をバンキングする際には、トレーニングの目的で1,500のフレーズを録音する必要がありました。この骨の折れる作業には数週間かかりました。

Philip Green氏は、ALSをサポートする非営利団体であるTeam Gleasonの理事会のメンバーであり、「正直なところ、自分の声を将来のために保存することは、通常の優先事項ではありません。他の考え事がたくさんあるものです。2年後や6ヶ月後、4年後に必要になるかもしれない自分自身の声のバージョンを保存することについては、あまり考えることはありません。しかし、私たちがやろうとしているのは、人々に気づいてもらうことです。診断を受けたらすぐに声のバンキングを始めてください。それは使わないことを願う保険のようなものです」と述べています。

ライブスピーチ

まずライブスピーチは、iPhoneやiPad、Macで、電話やFaceTimeでの通話中や対面での会話中に言いたいことを入力すると、それを音声に換えて伝えてくれる機能となります。また、よく使うフレーズを保存しておけば、家族や友人、同僚との会話ですぐに利用できるようになります。

本機能は言葉を音声で発することができない、または時の経過とともに言葉を失った全世界の何百万人もの人々をサポートするために設計されました。

パーソナルボイス

そしてパーソナルボイスは、ユーザーが自分そっくりの声を簡単かつ安全に作れる機能となっています。こちらはALS(筋萎縮性側索硬化症)の診断を受けた直後など、話す能力を失う恐れのあるユーザーのために設計さました。

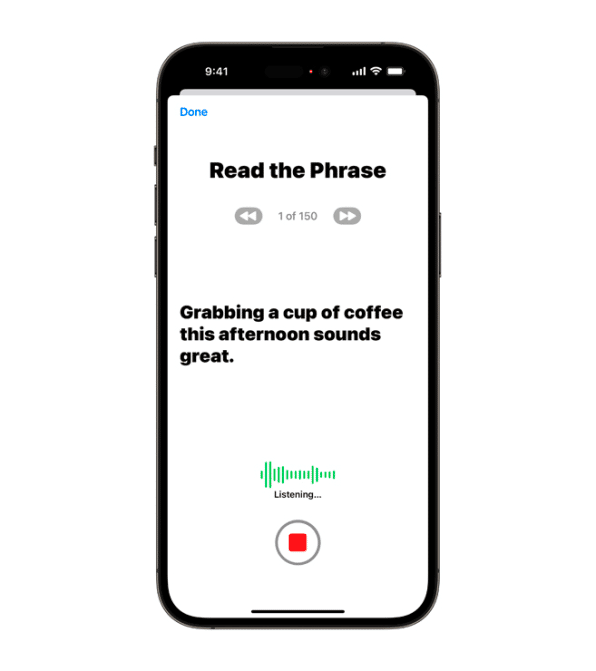

ユーザーはiPhoneやiPadで、ランダムに表示されるテキストプロンプトを読むことで15分間の音声を録音し、パーソナルボイスを作成できる。デバイス上の機械学習を使うため、クラウドサーバーなど外部にデータは渡されないのでユーザー情報を非公開かつ安全に保つことができます。

このパーソナルボイスは、シームレスにライブスピーチと統合されています。つまり電話やFaceTimeでの通話、対面での会話でも、iPhoneやiPadがユーザーそっくりの声で代わりにしゃべってくレルようになります。

ALSと診断された後、Salesforceのセールスエグゼクティブであるブルック・イービーさんは、自身の旅を共有し、ALSについて他の人々に教え、一般の人々がこの病気とそれに伴う意義についてより快適に話すことができるようにするために、InstagramやTikTokで活動を行いました。「コミュニティの中で話をすると、『もっと早くボイスバンクをしておけばよかった』とよく聞きます」と彼女は言います。「一部の人々は突然言葉を滑らせ始め、その後ではボイスバンクがほとんど遅すぎて、『いや、これは私らしくないし、ジェネリックなロボットの声を使ったほうがいいかもしれない』と思ってしまいます。」

ライブスピーチは、iPhoneやiPad、Macで、電話やFaceTimeでの通話中や対面での会話中に言いたいことを入力すると、それを音声に換えて伝えてくれる機能です。例えば、よく使うフレーズを保存しておけば、家族や友人、同僚との会話ですぐに利用できるようになります。

補完的・代替的コミュニケーションアプリでも使用可能

また、すべての処理はローカルで行われます。作成された音声はApple自身のアプリだけでなく、AssistiveWareなどの企業が提供する第三者の補完的・代替的コミュニケーションアプリでも使用することができます。

iPhone、iPad、またはMacで個人用の声を作成した後、ユーザーは自分自身の声で入力されたテキストをデジタル化された音声に変換することができます。

この機能は、同社のNeural Engineテクノロジーを活用しており、プロセッサ内の専用コンピューティングコアを人工知能向けに最適化しています。初期の処理は要求が高いため、ユーザーは夜間に充電しながらデバイスで実行しておくことが望ましいかもしれません。しかし、朝にはデジタル化された声が使用できる状態になっているはずです。

コ・デザイン

パーソナルボイスは、AIの最新の進歩とAppleのチップの計算能力の向上なしには実現できないものですが、それを実現するための技術はストーリーの一部に過ぎません。

Appleのグローバル・アクセシビリティ・ポリシーおよびイニシアチブのシニア・ディレクターであるサラ・ハーリンジャーは、ALSコミュニティのメンバーと緊密に協力して、純粋に実用的なものから文化的なものまで、彼らのニーズに応える方法でこの機能を実装したことを強調しています。

洞察を提供した人々の中には、ニューオーリンズ・セインツの元選手であるスティーブ・グリーソンと彼の妻ミシェルによって2011年にALSと診断された後に設立されたチーム・グリーソンのメンバーであるグリーン氏も含まれています。

ハーリンジャーは、「私たちの仕事において、コミュニティのためにデザインするのではなく、彼らと共にデザインすることが重要です。チーム・グリーソンのような個人と一緒に仕事をすることで、ALSと共に生活する人々の日常の経験についてより深い知識を得ることができます」とも述べています。

[参考記事]

この記事が気に入ったらサポートをしてみませんか?