HuggingGPTをGoogle Colabで動かしてみよう

HuggingGPTを下記のサイトを参考に、Google Colabで実行できるように修正しました。

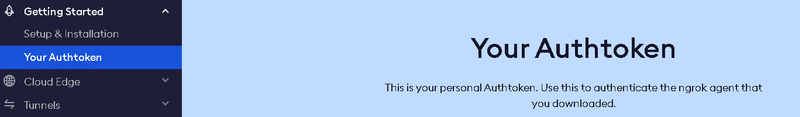

まずは、事前準備で、ngrokのアクセストークンを取得しましょう。Google Colabでhttp://127.0.0.1:7860にアクセスが出てきますが、そのままだとアクセスできないので、外部からアクセスするようにします。

次にGoogle Colabで実行するコードは、以下です。Google ColabではGPUのプレミアムを使用してください。メモリを20GB以上使用することになるからです。Your-tokenに、ngrokで取得したアクセストークンを記載してください。

!git lfs install

!git clone https://huggingface.co/spaces/microsoft/HuggingGPT

%cd /content/HuggingGPT/

!pip install -r requirements.txt

!pip install gradio

!pip install --upgrade pyngrok

import os

from pyngrok import ngrok, conf

# ngrokトークンを設定

conf.get_default().auth_token = "Your-token"

public_url = ngrok.connect(7860)

print(f"ngrok URL: {public_url}")最後に、ngrokのURLが出てきますので、次を実行した後に、クリックしてください。

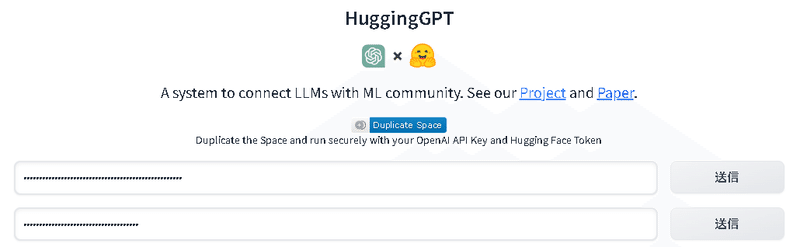

!python app.pyngrokで表示されたリンクをクリックすると、HuggingGPTの画面が出てきます。OpenAIのアクセスキーとHuggingFaceのアクセストークンをそれぞれ入力してください。入力したら送信をそれぞれ押下してください。

一番下のテキストボックスに質問を入力して、Sendを教えてみましょう。

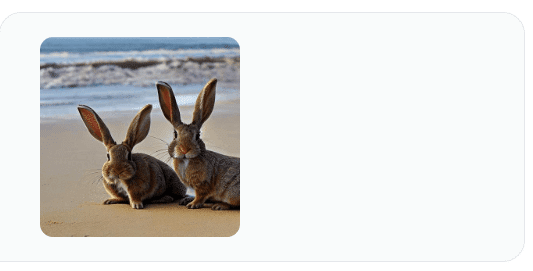

結果は、下記のように、ウサギの画像を用意しましたという回答です。また、使用したモデルとして、runwayml/stable-diffusion-v1.5や、ydshieh/vit-gpt2-coco-enで作成した画像の物体を記述してもらったり、ChatGPTを利用して、その結果からレスポンスを生成してもらいましたとのことです。テキストから画像、画像からテキストと双方向で確認しているように思います。

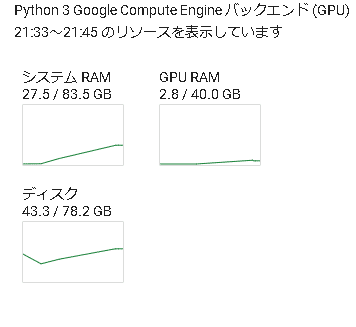

今回、Google Colabで使用したときのRAM、GUP、ディスクの使用量などです。結構RAMが使われている気がします。

この記事が気に入ったらサポートをしてみませんか?